DRL前沿之:Benchmarking Deep Reinforcement Learning for Continuous Control

1 前言

Deep Reinforcement Learning可以说是当前深度学习领域最前沿的研究方向,研究的目标即让机器人具备决策及运动控制能力。话说人类创造的机器灵活性还远远低于某些低等生物,比如蜜蜂。。DRL就是要干这个事,而是关键是使用神经网络来进行决策控制。

因此,考虑了一下,决定推出DRL前沿系列,第一时间推送了解到的DRL前沿,主要是介绍最新的研究成果,不讲解具体方法(考虑到博主本人也没办法那么快搞懂)。也因此,本文对于完全不了解这个领域,或者对这个领域感兴趣的童鞋都适合阅读。

下面进入正题。

2 Benchmarking Deep Reinforcement Learning for Continuous Control

文章出处:http://arxiv.org/abs/1604.06778

时间:2016年4月25日

开源软件地址:https://github.com/rllab/rllab

这篇文章不是什么创新算法的文章,但却是极其重要的一篇文章,看到文章的第一眼就能看出来。这篇文章针对DRL在连续控制领域的问题弄了一个Benchmark,而且,关键是作者把程序开源了,按照作者的原话就是

To encourage adoption by other researchers!

在这篇文章中,或者说这个开源软件包中,作者将主流及前沿的几个用于连续控制领域的算法都用python复现了,然后将算法应用在31种不同难度的连续控制问题上。

那么一共分了四类任务:

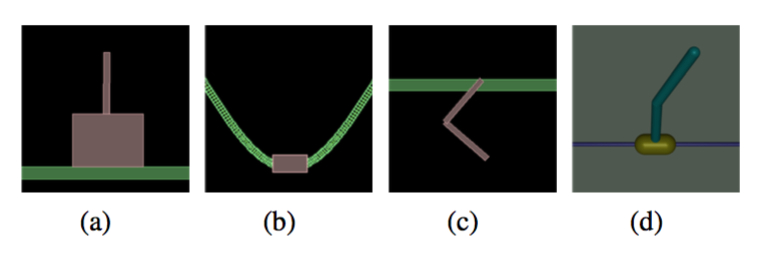

1)简单任务:让倒立摆保持平衡之类

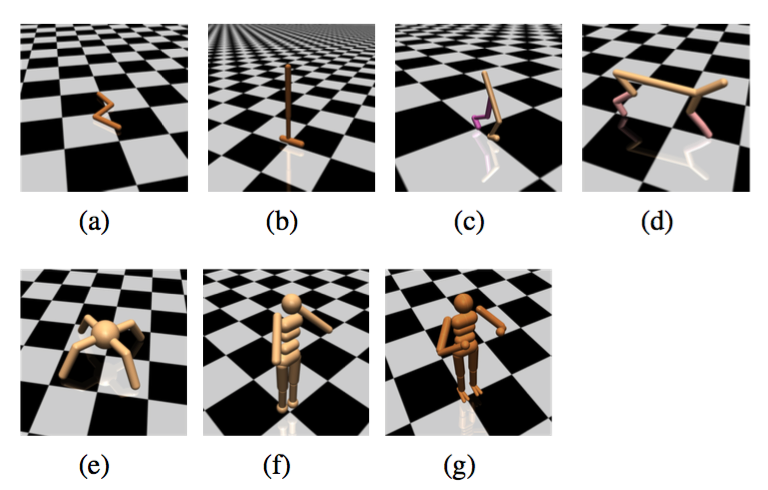

2)运动任务:让里面的虚拟生物往前跑,越快越好!

3)不完全可观察任务:即虚拟生物只能得到有限的感知信息,比如只知道每个关节的位置但不知道速度

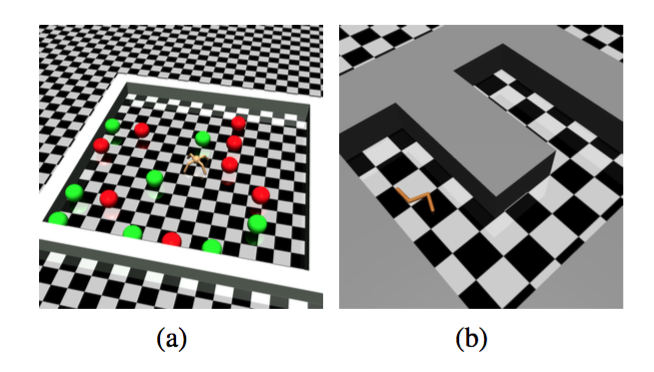

4)层次化任务:包含顶层决策+底层控制。比如下面的让虚拟蚂蚁找食物或者让虚拟蛇走迷宫。这种难度就很大了。

那么有了同样的测试环境,就可以对不同的算法进行对比。

对比出来的结果就是:

- TNPG和TRPO这两个方法(UC Berkerley的Schulman提出,现在属于OpenAI)最好,DDPG(DeepMind的David Silver团队提出的)次之。

- 层次任务目前没有一个算法能够完成,催生新的algorithm。

然后文章并没有对DeepMind的A3C算法http://arxiv.org/pdf/1602.01783进行测试,而这个是目前按DeepMind的文章最好的算法.

3 小结

UC Berkerley这次的开源相信对于学术界来说具有重要影响,很多研究者将受益于他们对于复现算法的公开。之后的研究恐怕也会在此Benchmark上进行测试。

DRL前沿之:Benchmarking Deep Reinforcement Learning for Continuous Control的更多相关文章

- (zhuan) Deep Reinforcement Learning Papers

Deep Reinforcement Learning Papers A list of recent papers regarding deep reinforcement learning. Th ...

- 深度强化学习(Deep Reinforcement Learning)入门:RL base & DQN-DDPG-A3C introduction

转自https://zhuanlan.zhihu.com/p/25239682 过去的一段时间在深度强化学习领域投入了不少精力,工作中也在应用DRL解决业务问题.子曰:温故而知新,在进一步深入研究和应 ...

- 论文笔记之:Dueling Network Architectures for Deep Reinforcement Learning

Dueling Network Architectures for Deep Reinforcement Learning ICML 2016 Best Paper 摘要:本文的贡献点主要是在 DQN ...

- getting started with building a ROS simulation platform for Deep Reinforcement Learning

Apparently, this ongoing work is to make a preparation for futural research on Deep Reinforcement Le ...

- (转) Deep Reinforcement Learning: Pong from Pixels

Andrej Karpathy blog About Hacker's guide to Neural Networks Deep Reinforcement Learning: Pong from ...

- 论文笔记之:Asynchronous Methods for Deep Reinforcement Learning

Asynchronous Methods for Deep Reinforcement Learning ICML 2016 深度强化学习最近被人发现貌似不太稳定,有人提出很多改善的方法,这些方法有很 ...

- Deep Reinforcement Learning

Reinforcement-Learning-Introduction-Adaptive-Computation http://incompleteideas.net/book/bookdraft20 ...

- [DQN] What is Deep Reinforcement Learning

已经成为DL中专门的一派,高大上的样子 Intro: MIT 6.S191 Lecture 6: Deep Reinforcement Learning Course: CS 294: Deep Re ...

- 论文笔记:Learning how to Active Learn: A Deep Reinforcement Learning Approach

Learning how to Active Learn: A Deep Reinforcement Learning Approach 2018-03-11 12:56:04 1. Introduc ...

随机推荐

- hdu-5810 Balls and Boxes(概率期望)

题目链接: Balls and Boxes Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/65536 K (Java/O ...

- Object Tracking Benchmark

Abstract 问题: 1)evaluation is often not suffcient 2)biased for certain types of algorthms 3)datasets ...

- FreeOpcUa compile

/********************************************************************************* * FreeOpcUa compi ...

- bind() 函数兼容

为了搞清这个陌生又熟悉的bind,google一下,发现javascript1.8.5版本中原生实现了此方法,目前IE9+,ff4+,chrome7+支持此方法,opera和safari不支持(MDN ...

- L3-018 森森美图 (30 分)

森森最近想让自己的朋友圈熠熠生辉,所以他决定自己写个美化照片的软件,并起名为森森美图.众所周知,在合照中美化自己的面部而不美化合照者的面部是让自己占据朋友圈高点的绝好方法,因此森森美图里当然得有这个功 ...

- linux下普通用户无法使用sudo命令问题

今天在新装的linux虚拟机中使用sudo命令时,报错如下 We trust you have received the usual lecture from the local System Adm ...

- Nolia 给CC添加过滤器

思路: 1.使用jqurey-tagput ,做得不好看,领导不满意 2.使用bootstrap select2这个控件, 思路: 1.添加css和js的文件 2.添加标签的时候,根据id拼接标签,a ...

- JS前端数据多条件筛选(商品搜索)

有时候也会需要在前端进行数据筛选,增强交互体验.当数据可用的筛选条件较多时,把逻辑写死会给后期维护带来很大麻烦.下面是我自己写的一个简单的筛选器,筛选条件可以根据数据包含的字段动态设置. 仿照京东的筛 ...

- Android中logcat和日志打印

一.logcat对日志过滤 1.# logcat --help # logcat --help Usage: logcat [options] [filterspecs] options inclu ...

- ubuntu14.04下安装ffmpeg

ubuntu14.04下安装ffmpeg 一.安装各种依赖包 1.yasm(libx264需要依赖yasm) sudo apt-get install yasm 2.libx264 sudo apt- ...