多层全连接神经网络实现minist手写数字分类

import torch

import numpy as np

import torch.nn as nn

from torch.autograd import Variable

import torch.optim as optim

from torch.utils.data import DataLoader

from torchvision import datasets, transforms

batch_size = 64

learning_rate = 1e-2

num_epoches = 20

data_tf = transforms.Compose([transforms.ToTensor(), transforms.Normalize([0.5],[0.5])])

#transform.Compose() 将各种预处理操作组合在一起

#transform.ToTensor() 将数据转化为Tensor类型,并自动标准化,Tensor的取值是(0,1)

#transform.Normalize()是标准化操作,类似正太分布的标准化,第一个值是均值,第二个值是方差

#如果图像是三个通道,则transform.Normalize([a,b,c],[d,e,f])

train_dataset = datasets.MNIST(root = './mnist_data', train = True, transform = data_tf, download = True) #用datasets加载数据集,传入预处理

test_dataset = datasets.MNIST(root = './mnist_data', train = False,transform = data_tf)

train_loader = DataLoader(train_dataset, batch_size = batch_size, shuffle = True) #利用DataLoader建立一个数据迭代器

test_loader = DataLoader(test_dataset, batch_size = batch_size, shuffle = False)

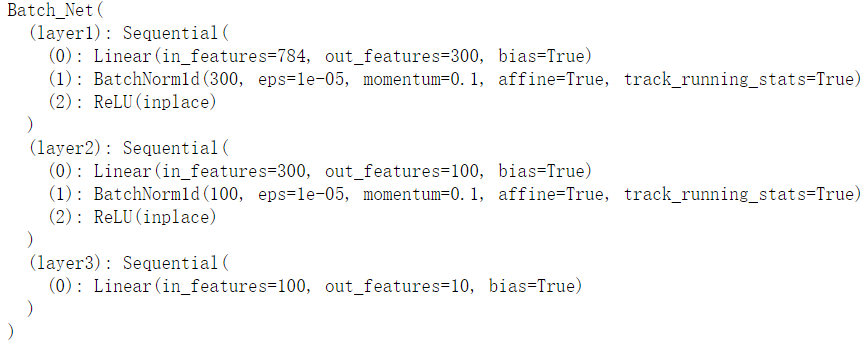

class Batch_Net(nn.Module):

def __init__(self, inputdim, hidden1, hidden2, outputdim):

super(Batch_Net, self).__init__()

self.layer1 = nn.Sequential(nn.Linear(inputdim, hidden1), nn.BatchNorm1d(hidden1), nn.ReLU(True))

self.layer2 = nn.Sequential(nn.Linear(hidden1, hidden2), nn.BatchNorm1d(hidden2), nn.ReLU(True))

self.layer3 = nn.Sequential(nn.Linear(hidden2, outputdim)) def forward(self, x):

x = self.layer1(x)

x = self.layer2(x)

x = self.layer3(x)

return x

model = Batch_Net(28*28, 300, 100, 10)

model

定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr = learning_rate)

训练模型

for epoch in range(num_epoches):

train_loss = 0

train_acc = 0

model.train() #这句话会自动调整batch_normalize和dropout值,很关键!

for img, label in train_loader:

img = img.view(img.size(0), -1) #将数据扁平化为一维

img = Variable(img)

label = Variable(label)

# 前向传播

out = model(img)

loss = criterion(out, label)

# 反向传播

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 记录误差

train_loss += loss.item()

# 计算分类的准确率

_, pred = out.max(1)

num_correct = (pred == label).sum().item()

acc = num_correct / img.shape[0]

train_acc += acc print('epoch:{},train_loss:{:.6f},acc:{:.6f}'.format(epoch+1, train_loss/len(train_loader), train_acc/len(train_loader)))

epoch:1,train_loss:0.002079,acc:0.999767

......

epoch:19,train_loss:0.001532,acc:0.999917

epoch:20,train_loss:0.001670,acc:0.999850

测试集

model.eval() #在评估模型时使用,固定BN 和 Dropout

eval_loss = 0

val_acc = 0

for img , label in test_loader:

img = img.view(img.size(0), -1)

img = Variable(img, volatile = True) #volatile=TRUE表示前向传播是不会保留缓存,因为测试集不需要反向传播

label = Variable(label, volatile = True)

out = model(img)

loss = criterion(out, label)

eval_loss += loss.item()

_,pred = torch.max(out, 1)

num_correct = (pred == label).sum().item()

print(num_correct)

eval_acc = num_correct / label.shape[0]

val_acc += eval_acc print('Test Loss:{:.6f}, Acc:{:.6f}'.format(eval_loss/len(test_loader), val_acc/len(test_loader)))

Test Loss:0.062413, Acc:0.981091

多层全连接神经网络实现minist手写数字分类的更多相关文章

- keras与卷积神经网络(CNN)实现识别minist手写数字

在本篇博文当中,笔者采用了卷积神经网络来对手写数字进行识别,采用的神经网络的结构是:输入图片——卷积层——池化层——卷积层——池化层——卷积层——池化层——Flatten层——全连接层(64个神经元) ...

- Tensorflow 多层全连接神经网络

本节涉及: 身份证问题 单层网络的模型 多层全连接神经网络 激活函数 tanh 身份证问题新模型的代码实现 模型的优化 一.身份证问题 身份证号码是18位的数字[此处暂不考虑字母的情况],身份证倒数第 ...

- python手写神经网络实现识别手写数字

写在开头:这个实验和matlab手写神经网络实现识别手写数字一样. 实验说明 一直想自己写一个神经网络来实现手写数字的识别,而不是套用别人的框架.恰巧前几天,有幸从同学那拿到5000张已经贴好标签的手 ...

- matlab手写神经网络实现识别手写数字

实验说明 一直想自己写一个神经网络来实现手写数字的识别,而不是套用别人的框架.恰巧前几天,有幸从同学那拿到5000张已经贴好标签的手写数字图片,于是我就尝试用matlab写一个网络. 实验数据:500 ...

- MNIST手写数字分类simple版(03-2)

simple版本nn模型 训练手写数字处理 MNIST_data数据 百度网盘链接:https://pan.baidu.com/s/19lhmrts-vz0-w5wv2A97gg 提取码:cgnx ...

- Tensorflow-线性回归与手写数字分类

线性回归 步骤 构造线性回归数据 定义输入层 设计神经网络中间层 定义神经网络输出层 计算二次代价函数,构建梯度下降 进行训练,获取预测值 画图展示 代码 import tensorflow as t ...

- 使用神经网络来识别手写数字【译】(三)- 用Python代码实现

实现我们分类数字的网络 好,让我们使用随机梯度下降和 MNIST训练数据来写一个程序来学习怎样识别手写数字. 我们用Python (2.7) 来实现.只有 74 行代码!我们需要的第一个东西是 MNI ...

- Pytorch1.0入门实战一:LeNet神经网络实现 MNIST手写数字识别

记得第一次接触手写数字识别数据集还在学习TensorFlow,各种sess.run(),头都绕晕了.自从接触pytorch以来,一直想写点什么.曾经在2017年5月,Andrej Karpathy发表 ...

- C#中调用Matlab人工神经网络算法实现手写数字识别

手写数字识别实现 设计技术参数:通过由数字构成的图像,自动实现几个不同数字的识别,设计识别方法,有较高的识别率 关键字:二值化 投影 矩阵 目标定位 Matlab 手写数字图像识别简介: 手写 ...

随机推荐

- 服务器配置好但Idea/Datagrip无法连接远程数据库的解决方案

服务器没有开放端口3306,在云服务控制台配置安全组即可.

- wpf prism加载独立模块实例

一.首先看看文件的组织架构 module1 module2生成dll某块.Shell来显示管理模块 二,看看关键bootstrapper类 using System;using System.Coll ...

- 编写优秀 CSS 代码的 8 个策略

编写基本的CSS和HTML是我们作为Web开发人员学习的首要事情之一.然而,我遇到的很多应用程序显然没有人花时间真正考虑前端开发的长久性和可维护性. 我认为这主要是因为许多开发人员对组织CSS / H ...

- Coursera机器学习笔记(一) - 监督学习vs无监督学习

转载 http://daniellaah.github.io/2016/Machine-Learning-Andrew-Ng-My-Notes-Week-1-Introduction.html 一. ...

- 可以提升幸福感的js小技巧(上)

1. 类型强制转换 1.1 string强制转换为数字 可以用 *1来转化为数字(实际上是调用 .valueOf方法) 然后使用 Number.isNaN来判断是否为 NaN,或者使用 a!==a 来 ...

- 面向新手的Web服务器搭建(一)——IIS的搭建

很多童鞋说自己是做移动开发的,想挂个简单的Web API,可是服务器又不会搭,这样一来测试就成了问题.看看网上的教程,发现略难懂,而且大多是一个转一个,没价值,所以干脆写几篇文章讲讲简单的Web服务器 ...

- Matlab 快速多通道积分图计算函数

所谓快速多通道积分图计算,其实就是 cumsum2D. 我写了一个比较快的版本(比 VLFeat 的快),用 mex 编译一下就能用了. 代码 #include <string.h> #i ...

- Big Data(八)MapReduce的搭建和初步使用

---恢复内容开始--- 回顾: 1.最终开发MR的计算程序 2.hadoop 2.x 出现了一个yarn:资源管理>>MR没有后台场服务 yarn模型:container 容器,里面会运 ...

- springboot 关于log4j日志配置

自动加载配置文件:(1)如果采用log4j输出日志,要对log4j加载配置文件的过程有所了解.log4j启动时,默认会寻找source folder下的log4j.xml配置文件,若没有,会寻找log ...

- bootstrap-table(2)问题集

参考;https://www.cnblogs.com/landeanfen/p/4993979.html 1.分页参数sidePagination 如果是服务端分页,返回的结果必须包含total.ro ...