Spark 个人实战系列(2)--Spark 服务脚本分析

前言:

spark最近非常的火热, 本文不讲spark原理, 而是研究spark集群搭建和服务的脚本是如何编写的, 管中窥豹, 希望从运行脚本的角度去理解spark集群. 研究的spark为1.0.1版. spark集群采用standalone模式搭建, 其基础架构为master-slave(worker模式, 单master+多slave(worker)节点构成.

脚本目录

start-all.sh 作用: 启动整个集群

stop-all.sh 作用: 关闭整个集群

start-master.sh 作用: 启动master节点

stop-master 作用: 关闭master节点

start-slaves.sh 作用: 启动整个集群的slave节点

start-slave.sh 作用: 启动单节点slave

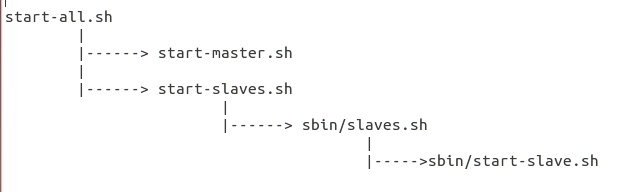

总体脚本的依赖关系图如下:

*) 分析脚本start-all.sh

# Load the Spark configuration

. "$sbin/spark-config.sh"

# Start Master

"$sbin"/start-master.sh $TACHYON_STR

# Start Workers

"$sbin"/start-slaves.sh $TACHYON_STR

评注:

# 1. 载入执行spark-config.sh

# 2. 启动Master节点

# 3. 启动各个slave(worker)节点

*) 先来研究下sbin/spark-config.sh脚本

export SPARK_PREFIX=`dirname "$this"`/..

export SPARK_HOME=${SPARK_PREFIX}

export SPARK_CONF_DIR="$SPARK_HOME/conf"

评注:

# spark-config.sh的作用是常用的环境变量SPARK_HOME, SPARK_CONF_DIR的导出

*) 脚本start-master.sh分析

. "$sbin/spark-config.sh"

. "$SPARK_PREFIX/bin/load-spark-env.sh" "$sbin"/spark-daemon.sh start org.apache.spark.deploy.master.Master 1 \

--ip $SPARK_MASTER_IP --port $SPARK_MASTER_PORT \

--webui-port $SPARK_MASTER_WEBUI_PORT

评注:

# source spark-config.sh, load-spark-env.sh之后

# 借助spark-daemon.sh脚本, 启动Master服务, 并传入相关的参数, Master绑定IP/Port, 以及webui的端口

*) 对load-spark-env.sh脚本进行解读

if [ -z "$SPARK_ENV_LOADED" ]; then

export SPARK_ENV_LOADED=1

# Returns the parent of the directory this script lives in.

parent_dir="$(cd `dirname $0`/..; pwd)"

use_conf_dir=${SPARK_CONF_DIR:-"$parent_dir/conf"}

if [ -f "${use_conf_dir}/spark-env.sh" ]; then

# Promote all variable declarations to environment (exported) variables

set -a

. "${use_conf_dir}/spark-env.sh"

set +a

fi

fi

评注:

# 很重要的一步是导入了conf/spark-env.sh, 把用户自定义的变量参数全部生效,替换默认值

*) 对start-slaves.sh的解析

# Launch the slaves

if [ "$SPARK_WORKER_INSTANCES" = "" ]; then

exec "$sbin/slaves.sh" cd "$SPARK_HOME" \; "$sbin/start-slave.sh" 1 spark://$SPARK_MASTER_IP:$SPARK_MASTER_PORT

else

if [ "$SPARK_WORKER_WEBUI_PORT" = "" ]; then

SPARK_WORKER_WEBUI_PORT=8081

fi

for ((i=0; i<$SPARK_WORKER_INSTANCES; i++)); do

"$sbin/slaves.sh" cd "$SPARK_HOME" \; "$sbin/start-slave.sh" $(( $i + 1 )) \

spark://$SPARK_MASTER_IP:$SPARK_MASTER_PORT \

--webui-port $(( $SPARK_WORKER_WEBUI_PORT + $i ))

done

fi

评注:

# $SPARK_WORKER_INSTANCES指定单机运行多个slave(worker)进程数

# 具体流程, 每个worker实例执行sbin/slaves.sh, 该脚本的执行参数是执行"sbin/start-slave.sh", 同时每个slave(worker)节点都指定了自己的WEB UI端口

*) sbin/slaves.sh

. "$SPARK_PREFIX/bin/load-spark-env.sh" if [ "$HOSTLIST" = "" ]; then

if [ "$SPARK_SLAVES" = "" ]; then

export HOSTLIST="${SPARK_CONF_DIR}/slaves"

else

export HOSTLIST="${SPARK_SLAVES}"

fi

fi # By default disable strict host key checking

if [ "$SPARK_SSH_OPTS" = "" ]; then

SPARK_SSH_OPTS="-o StrictHostKeyChecking=no"

fi for slave in `cat "$HOSTLIST"|sed "s/#.*$//;/^$/d"`; do

ssh $SPARK_SSH_OPTS $slave $"${@// /\\ }" \

2>&1 | sed "s/^/$slave: /" &

if [ "$SPARK_SLAVE_SLEEP" != "" ]; then

sleep $SPARK_SLAVE_SLEEP

fi

done

评注:

# sbin/slaves.sh脚本, 载入了conf/slaves文件(配置slaves节点), 详见上一篇

# 同时为每个slave节点执行

# sbin/start-slave.sh $(( $i + 1 )) spark://$SPARK_MASTER_IP:$SPARK_MASTER_PORT \

# --webui-port $(( $SPARK_WORKER_WEBUI_PORT + $i ))

*) sbin/start-slave.sh脚本解析

"$sbin"/spark-daemon.sh start org.apache.spark.deploy.worker.Worker "$@"

评注:

# 借助spark-daemon.sh, 运行org.apache.spark.deploy.worker.Worker即可

*) sbin/spark-daemon.sh脚本分析

spark-daemon.sh 脚本最后还是借助bin/spark-class来实现, 对jvm参数进行了设定

Spark 个人实战系列(2)--Spark 服务脚本分析的更多相关文章

- Spark入门实战系列--1.Spark及其生态圈简介

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .简介 1.1 Spark简介 年6月进入Apache成为孵化项目,8个月后成为Apache ...

- Spark入门实战系列--2.Spark编译与部署(上)--基础环境搭建

[注] 1.该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取: 2.Spark编译与部署将以CentOS 64位操作系统为基础,主要是考虑到实际应用 ...

- Spark入门实战系列--2.Spark编译与部署(下)--Spark编译安装

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .编译Spark .时间不一样,SBT是白天编译,Maven是深夜进行的,获取依赖包速度不同 ...

- Spark入门实战系列--3.Spark编程模型(上)--编程模型及SparkShell实战

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .Spark编程模型 1.1 术语定义 l应用程序(Application): 基于Spar ...

- Spark入门实战系列--4.Spark运行架构

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 1. Spark运行架构 1.1 术语定义 lApplication:Spark Appli ...

- Spark入门实战系列--9.Spark图计算GraphX介绍及实例

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .GraphX介绍 1.1 GraphX应用背景 Spark GraphX是一个分布式图处理 ...

- Spark入门实战系列--2.Spark编译与部署(中)--Hadoop编译安装

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .编译Hadooop 1.1 搭建环境 1.1.1 安装并设置maven 1. 下载mave ...

- Spark入门实战系列--3.Spark编程模型(下)--IDEA搭建及实战

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 . 安装IntelliJ IDEA IDEA 全称 IntelliJ IDEA,是java语 ...

- Spark入门实战系列--7.Spark Streaming(上)--实时流计算Spark Streaming原理介绍

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .Spark Streaming简介 1.1 概述 Spark Streaming 是Spa ...

- Spark入门实战系列--7.Spark Streaming(下)--实时流计算Spark Streaming实战

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .实例演示 1.1 流数据模拟器 1.1.1 流数据说明 在实例演示中模拟实际情况,需要源源 ...

随机推荐

- GZFramework代码生成器插件使用教程

代码生成器分两种 1.基于独立exe生成程序 直接运行软件目录下GZFrameworkCodeGenerate.exe文件即可 2.基于VS插件生成 目录中分为两部分:全局缓存和VS插件 1.添加全局 ...

- kali linux安装virtualbox虚拟机之爬坑经历

很多kali爱好者想把kali linux作为系统使用,但是有些win下的程序有时候也需要用到,此时需要虚拟机. kali系统在安装虚拟机的时候也会遇到一大堆坑,接下来是我的爬坑过程. 一波三折. 环 ...

- C#程序设计---->计算圆面积windows程序

值得说的就是添加一个回车事件, http://blog.csdn.net/nanwang314/article/details/6176604 private void textBox1_KeyDow ...

- D3.js 做一个简单的图表(条形图)

柱形图是一种最简单的可视化图标,主要有矩形.文字标签.坐标轴组成. 本文为简单起见,只绘制矩形的部分,用以讲解如何使用 D3 在 SVG 画布中绘图. 一. 画布是什么 前几章的处理对象都是 HTML ...

- springmvc的单文件上传

@RequestMapping("/up") public ModelAndView up(MultipartFile myfiles , HttpServletRequest r ...

- setColorFilter()滤镜

----------转载于:http://blog.sina.com.cn/s/blog_5da93c8f01012pkj.html 通过setColorFilter可以实现滤镜效果. 如: ...

- stm32cube--串口

1.printf函数重定向 ①以stm32f103rct6的usart1为例,打开cube,配置好RCC和USART1,生成mdk程序. ②打开工程,在main.c中 /* USER CODE BEG ...

- CSS实现垂直居中

Hack技术就可以啊!所以在这里我还要啰嗦两句,CSS中的确是有vertical-align属性,但是它只对(X)HTML元素中拥有valign特性的元素才生效,例如表格元素中的<td>. ...

- SQL Server显式事务与隐式事务

事务是单个的工作单元.如果某一事务成功,则在该事务中进行的所有数据修改均会提交,成为数据库中的永久组成部分.如果事务遇到错误且必须取消或回滚,则所有数据库修改均被清除. SQL Server中有一下几 ...

- Oracle新增客户端网络配置使用scott出现错误

错误一 测试提示用户密码过期 解决方法:使用sys用户登录数据库 sqlplus sys/密码 as sysdba; 修改scott用户密码 alter user scott identifie ...