搭建hadoop1.2集群

环境准备

我使用的是vmware workstation,首先安装ubuntu 12.04,安装完成后通过vmware的clone,clone出两个虚机,设置的IP分别是:

192.168.74.130 master

192.168.74.132 node1

192.168.74.133 node2

然后修改各个主机的/etc/hosts中的内容。

使用vi或者gedit,将上边的内容编缉进去。

创建用户

先创建hadoop用户组:

sudo addgroup hadoop

然后创建用户hadoop:

sudo adduser -ingroup hadoop hadoop

注:在centos 和 redhat下直接创建用户就行,会自动生成相关的用户组和相关文件,而ubuntu下直接创建用户,创建的用户没有根目录。

给hadoop用户添加权限,打开/etc/sudoers文件;

sudo gedit /etc/sudoers

按回车键后就会打开/etc/sudoers文件了,给hadoop用户赋予root用户同样的权限。

在root ALL=(ALL:ALL) ALL下添加hadoop ALL=(ALL:ALL) ALL,

hadoop ALL=(ALL:ALL) ALL

为本机(master)和子节点(node..)安装JDK环境。

其实网上挺多的,参考http://blog.csdn.net/klov001/article/details/8075237,这里不详细描述了。

修改本机(master)和子节点(node..)机器名

打开/etc/hostname文件;

sudo gedit /etc/hostname

分别改为master、node1和node2。

本机(master)和子节点(son..)安装ssh服务

主要为ubuntu安装,cents和redhat系统自带。

ubuntu下:

sudo apt-get install ssh openssh-server

建立ssh无密码登录环境

做这一步之前首先建议所有的机子全部转换为hadoop用户,以防出现权限问题的干扰。

ssh生成密钥有rsa和dsa两种生成方式,默认情况下采用rsa方式。

创建ssh-key,这里我们采用rsa方式;

ssh-keygen -t rsa -P ""

(注:回车后会在~/.ssh/下生成两个文件:id_rsa和id_rsa.pub这两个文件是成对出现的)

进入~/.ssh/目录下,将id_rsa.pub追加到authorized_keys授权文件中,开始是没有authorized_keys文件的;

cd ~/.ssh

cat id_rsa.pub >> authorized_keys

可以使用ssh 主机名测试一下是否成功。

为mater安装hadoop

在hadoop用户下建立hadoop文件夹,然后将hadoop-1.2.0.tar.gz上传到这个目录下。

tar -zxvf hadoop-1.2..tar.gz

解压缩。然后到hadoop目录下conf下找到hadoop-env.sh

配置JAVA_HOME为你上面配置的JAVA_HOME。

找到core-site.xml,配置信息如下:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/tmp/hadoop-${user.name}</value>

<description>A base for other temporarydirectories.</description>

</property> <property>

<name>fs.default.name</name>

<value>hdfs://master:9000</value>

<description>The name of the default file system. A URI whose

scheme and authority determine the FileSystem implementation. The

uri's scheme determines the config property (fs.SCHEME.impl) naming

the FileSystem implementation class. The uri's authority is used to

determine the host, port, etc. for a filesystem.

</description>

</property>

</configuration>

修改hdfs-site.xml:

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <!-- Put site-specific property overrides in this file. --> <configuration>

<property>

<name>dfs.replication</name>

<value></value>

<description>Default block replication.

The actual number of replications can be specified when the file iscreated.

The default is used if replication is not specified in create time.

</description>

</property>

</configuration>

修改mapred-site.xml:

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <!-- Put site-specific property overrides in this file. --> <configuration>

<property>

<name>mapred.job.tracker</name>

<value>master:</value>

<description>The host and port that the MapReduce job trackerruns

at. If "local", then jobs are run in-process as a singlemap

and reduce task.

</description>

</property>

</configuration>

修改masters:

master

修改slaves:

node1

node2

启动hadoop

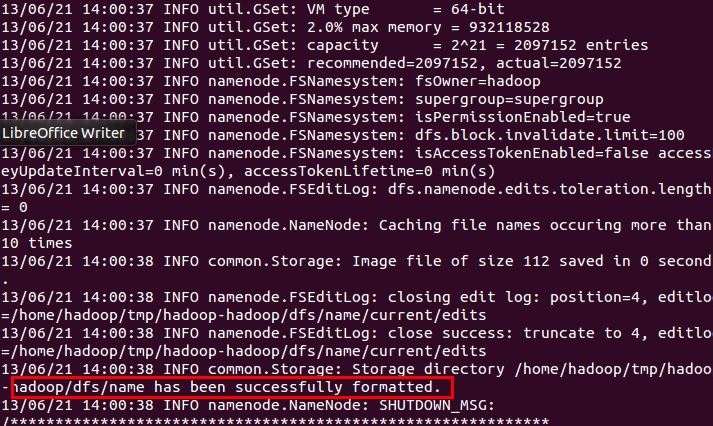

在master主机上的hadoop安装目录下的bin目录下,执行格式化

./hadoop namenode -format

正常情况下会出现如下提示:

说明格式化成功。

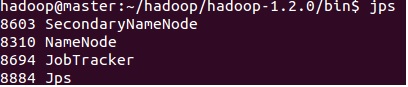

启动所有结点:

./start-all.sh

会按先后顺序启动,启动完成后,分别到主机和两个node上使用jps查看。

master上显示如下:

node1和node2上显示:

在操作的过程中遇到了DataNode不能启动的问题,经过查看node1的hadoop的日志,发现提示错误信息:

org.apache.hadoop.hdfs.server.datanode.DataNode: All directories in dfs.data.dir are invalid.

经过查找是因为权限的问题,于是

sudo chmod “你配置的data目录”

问题解决。

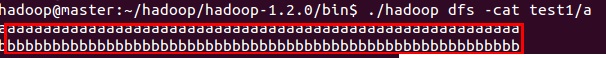

运行示例

在根目录下新建文件a,并且向a中随意添加字符串信息。

然后在hdfs上创建目录:

./hadoop dfs -mkdir test1

把刚才创建的文件a上传到test1下:

./hadoop dfs -put ~/a test1

然后查看文件中的内容:

./hadoop dfs -cat test1/a

显示结果如下:

搭建hadoop1.2集群的更多相关文章

- ZooKeeper环境搭建(单机/集群)(转)

前提: 配置文件主要是在$ZOOKEEPER_HOME/conf/zoo.cfg,刚解压时为zoo_sample.cfg,重命名zoo.cfg即可. 配置文件常用项参考:http://www.cnbl ...

- 使用docker搭建hadoop分布式集群

使用docker搭建部署hadoop分布式集群 在网上找了非常长时间都没有找到使用docker搭建hadoop分布式集群的文档,没办法,仅仅能自己写一个了. 一:环境准备: 1:首先要有一个Cento ...

- 从零开始搭建Docker Swarm集群

从零开始搭建Docker Swarm集群 检查节点Docker配置 1. 打开Docker配置文件(示例是centos 7)vim /etc/sysconfig/docker2. 添加-H tcp:/ ...

- Linux下搭建Lotus Domino集群

Linux下搭建Lotus Domino 集群 本文内容是Linux平台下Lotus Domino服务器部署案例(http://chenguang.blog.51cto.com/350944/1334 ...

- 超快速使用docker在本地搭建hadoop分布式集群

超快速使用docker在本地搭建hadoop分布式集群 超快速使用docker在本地搭建hadoop分布式集群 学习hadoop集群环境搭建是hadoop入门的必经之路.搭建分布式集群通常有两个办法: ...

- hadoop(二)搭建伪分布式集群

前言 前面只是大概介绍了一下Hadoop,现在就开始搭建集群了.我们下尝试一下搭建一个最简单的集群.之后为什么要这样搭建会慢慢的分享,先要看一下效果吧! 一.Hadoop的三种运行模式(启动模式) 1 ...

- 虚拟机搭建Zookeeper服务器集群完整笔记

虚拟机搭建Zookeeper服务器集群完整笔记 本笔记主要记录自己搭建Zookeeper服务器的全过程,默认已经安装部署好Centos7. 一.虚拟机下Centos无法联网解决方案 1.首先调整虚拟机 ...

- Storm环境搭建(分布式集群)

作为流计算的开篇,笔者首先给出storm的安装和部署,storm的第二篇,笔者将详细的介绍storm的工作原理.下边直接上干货,跟笔者的步伐一块儿安装storm. 原文链接:Storm环境搭建(分布式 ...

- 搭建zookeeper+kafka集群

搭建zookeeper+kafka集群 一.环境及准备 集群环境: 软件版本: 部署前操作: 关闭防火墙,关闭selinux(生产环境按需关闭或打开) 同步服务器时间,选择公网ntpd服务器或 ...

随机推荐

- rsync排除文件同步

排除扩展名为log的文件 rsync -ave ssh --exclude '*.log' root@192.168.168.188:/website/abc.com/* /website/abc.c ...

- 判断Window在哪个屏幕

最近在做窗口最大化时需要一个功能,如果是多个显示器的话,需要在当前显示器最大化,由于是根据屏幕长宽进行设置Window大小,没有使用WindowState.Maximized,window.Left不 ...

- C# 基础(8)--网络编程

套接字,客户端连接服务器,作为进程通讯机制,是基于描述IP地址和端口,是一个通讯链的句柄,其实质就是两个程序通讯用的. 非常类似于电话插座.双方通话的过程,是一方向电话机发出信号和对方从电话机接受信号 ...

- How to: Change Sales Rep/Team via Mass Update

/* from: https://netsuite.custhelp.com/app/answers/detail/a_id/30057/kw/reassign%20sales */ How to c ...

- new出对象的作用

new调用了构造函数以后 构造函数会返回一个对象的实例

- 我为什么要拒绝Ctrl+C和Ctrl+V?

工作中避免不了会去参考别人的思路和实现(代码),因此浏览博文和相关网站成了日常活动.在这一过程中,James看到很多博文都是满篇的代码,而没有相应的分析(文字描述或者流程图). 对于上述这种情况,Ja ...

- 《uml大战需求分析》阅读笔记05

<uml大战需求分析>阅读笔记05 这次我主要阅读了这本书的第九十章,通过看这章的知识了解了不少的知识开发某系统的重要前提是:这个系统有谁在用?这些人通过这个系统能做什么事? 一般搞清楚这 ...

- list对象属性排序

Collections.sort(list, new Comparator<ScRel>() { @Override public int compare(Object o1, Objec ...

- Web前端学习路线

第一阶段: HTML+CSS:HTML进阶.CSS进阶.div+css布局.HTML+css整站开发. JavaScript基础:Js基础教程.js内置对象常用方法.常见DOM树操作大全.ECMAsc ...

- 谈FME批量自动化数据转换方法

FME作为转换神器,支持几百种格式的互转,实现互操作化.从fme.exe执行方式入手,讨论Command命令式执行模板(.fmw/.fmwt)和脚本(.tcl/.py)实现自动化批量转换. 1.fme ...