Python爬虫_豆瓣电视剧

1 import requests

2 import json

3 import csv

4

5

6 class DoubantvSpider:

7 def __init__(self):

8 # self.proxies = {"http":"http://125.123.152.81:3000"}

9 self.url = "https://movie.douban.com/j/search_subjects?type=tv&tag=%E5%9B%BD%E4%BA%A7%E5%89%A7&sort=rank&page_limit=20&page_start={}" # 手机模式下国产剧请求网址

10 self.headers = {"User-Agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.111 Safari/537.36"}

11

12 # 发送请求,获得json,转化为字典

13 def parse_url(self, url):

14 res = requests.get(url, headers=self.headers)

15 return json.loads(res.content.decode())

16

17 # 保存数据

18 def save(self, dic):

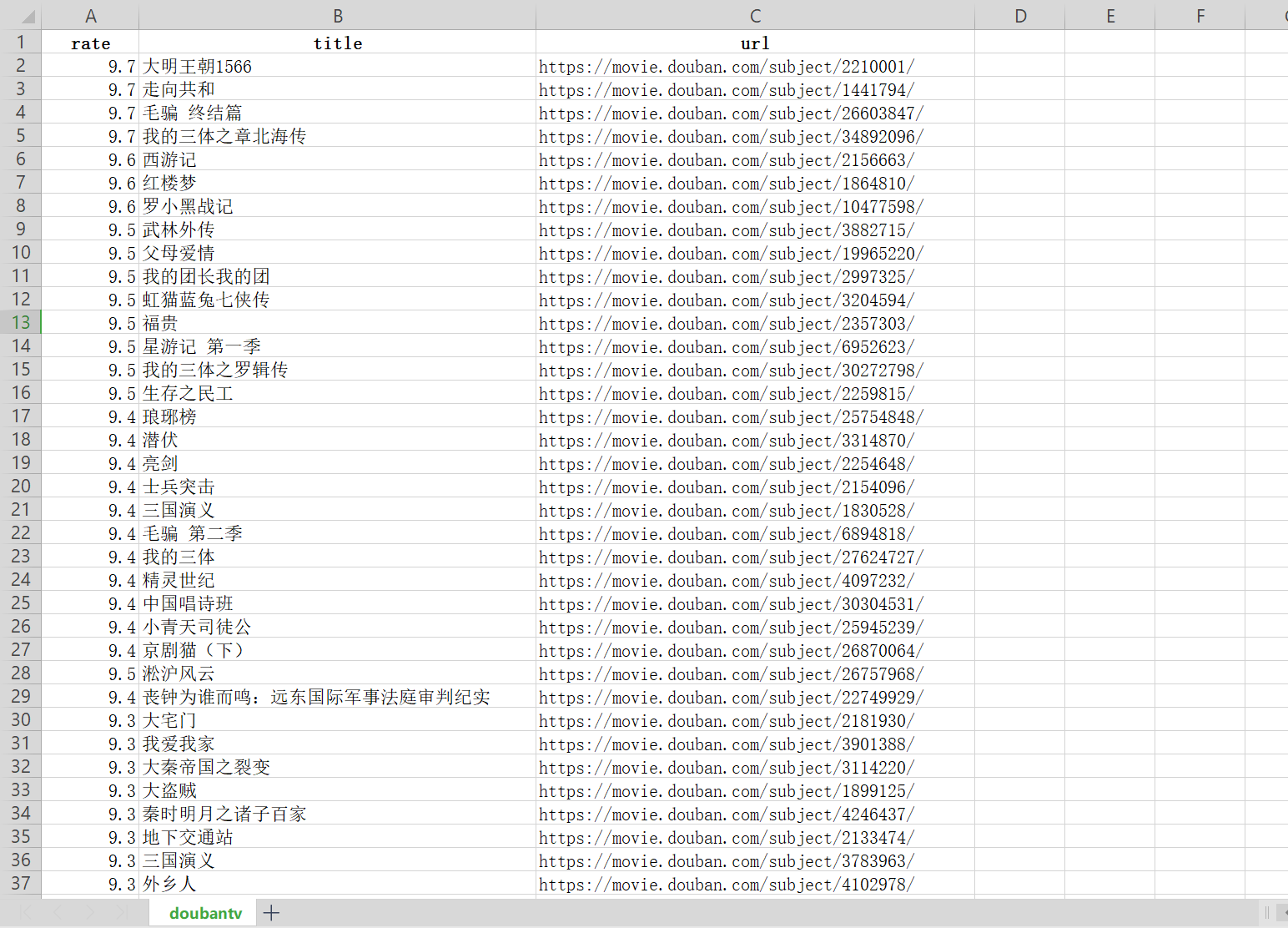

19 with open("doubantv.csv", "a", newline='', encoding="utf8") as f:

20 for data in dic["subjects"]:

21 writer = csv.writer(f, delimiter=',')

22 writer.writerow([data["rate"], data["title"], data["url"]])

23

24 # 实现主要逻辑

25 def run(self):

26 page_num = 0

27 while True:

28 # 构造url

29 url = self.url.format(page_num)

30 # 发送请求,获取响应

31 dic = self.parse_url(url)

32 # 因为动态加载,通过判断每页电视剧数量来确定是不是到了尾页

33 if len(dic["subjects"]) < 20:

34 break

35 self.save(dic)

36 page_num += 20

37 print("ok")

38

39

40 if __name__ == "__main__":

41 doubantv = DoubantvSpider()

42 doubantv.run()

Python爬虫_豆瓣电视剧的更多相关文章

- Springboot+JPA下实现简易爬虫:豆瓣电视剧数据

Springboot+JPA下实现简易爬虫:豆瓣电视剧数据 前言:今天听到产品那边讨论一些需求,好像其中一点是用户要求我们爬虫,在网页上抓取一些数据然后存到我们公司数据库中,众所周知,爬虫的实现对于p ...

- Python爬虫(四)——豆瓣数据模型训练与检测

前文参考: Python爬虫(一)——豆瓣下图书信息 Python爬虫(二)——豆瓣图书决策树构建 Python爬虫(三)——对豆瓣图书各模块评论数与评分图形化分析 数据的构建 在这张表中我们可以发现 ...

- 用Python爬虫对豆瓣《敦刻尔克》影评进行词云展示

最近很想看的一个电影,去知乎上看一下评论,刚好在学Python爬虫,就做个小实例. 代码基于第三方修改 原文链接 http://python.jobbole.com/88325/#comment-9 ...

- Python爬虫之豆瓣-新书速递-图书解析

1- 问题描述 抓取豆瓣“新书速递”[1]页面下图书信息(包括书名,作者,简介,url),将结果重定向到txt文本文件下. 2- 思路分析[2] Step1 读取HTML Step2 Xpath遍历元 ...

- Python爬虫(一)——豆瓣下图书信息

爬虫目的: 随着近年互联网的发展,网络上的信息飞速数量增长.在庞大的数据面前想要获得期望的信息往往如同大海捞针.通过合理的筛选,在百万甚至数亿计的数据中找到所需信息,无疑有着非常大的意义. 在豆瓣网下 ...

- python爬虫_入门_翻页

写出来的爬虫,肯定不能只在一个页面爬,只要要爬几个页面,甚至一个网站,这时候就需要用到翻页了 其实翻页很简单,还是这个页面http://bbs.fengniao.com/forum/10384633. ...

- python爬虫_入门

本来觉得没什么可写的,因为网上这玩意一搜一大把,不过爬虫毕竟是python的一个大亮点,不说说感觉对不起这玩意基础点来说,python2写爬虫重点需要两个模块,urllib和urllib2,其实还有r ...

- 【转】Python爬虫_示例2

爬虫项目:爬取并筛选拉钩网职位信息自动提交简历 一 目标站点分析 #一:实验前准备: 浏览器用Chrome 用Ctrl+Shift+Delete清除浏览器缓存的Cookie 打开network准备 ...

- 【转】Python爬虫_示例

爬虫项目:爬取汽车之家新闻资讯 # requests+Beautifulsoup爬取汽车之家新闻 import requests from bs4 import BeautifulSoup res ...

随机推荐

- Grafana部署监控docker服务

Grafana部署监控docker服务 一.使用InfluxDB+cAdvisor+Grafana配置Docker监控 1.1Docker监控组件 1.2cAdvisor: 1.3Docker监控安装 ...

- redis学习教程四《管理、备份、客户端连接》

redis学习教程四<管理.备份.客户端连接> 一:Redis服务器命令 Redis服务器命令 下表列出了与Redis服务器相关的一些基本命令. 序号 命令 说明 1 BGREWRITE ...

- linux学习之---在linux服务器上跑一段Java代码

经常在windows上进行开发,有时候,需要在Linux环境上跑一些程序测下代码,要怎么办才好嘞? 假设你对Java常用命令和linux常用命令已经基本熟悉,就可以直接按照以下步骤来啦,默认linux ...

- .net core Api 部署到Linux

一.环境介绍 1..net开发环境:asp.net core 3.1 2.Linux环境:CentOS Linux release 7.9.2009 (Core) 3.Swagger: Swashbu ...

- AC自动机——看似KMP在跑,其实fail在跳

先存代码 AC自动机(简单版) #include<bits/stdc++.h> #define maxn 1000007 using namespace std; int n,ans; i ...

- HDOJ 1348 基本二维凸包问题

这次写的凸包用的是Graham scan算法 就数据结构上只是简单地运用了一个栈 #include<stdio.h>#include<cmath>#include<alg ...

- Codeforces Round #649 (Div. 2)

Codeforces Round #649 (Div. 2) -- WKL \(\mathcal{A}\)题: \(\mathrm{XXXXX}\) Greedy implementation *12 ...

- cmd控制台Windows服务相关

1.创建服务 sc create ServerName binpath= "E:\MySql5.5\bin\mysqld.exe" 2.启动服务 sc start ServerNa ...

- 如何安装Gephi工具

gephi中文版是一款开源免费跨平台基于JVM的复杂网络分析软件,安装后需要安装Java jdk API,否则就会出现gephi打不开的情况 该工具主要用于各种网络和复杂系统,动态和分层图的交互可视化 ...

- CF1465-C. Peaceful Rooks

CF1465-C. Peaceful Rooks 预备小知识: Rook(国际象棋中的车). 国际象棋中的棋子.每人有2个,他只能直走,不能斜走,除王车易位外不能越子. -- 来自<百度百科&g ...