Flink的DataSource三部曲之二:内置connector

欢迎访问我的GitHub

https://github.com/zq2599/blog_demos

内容:所有原创文章分类汇总及配套源码,涉及Java、Docker、Kubernetes、DevOPS等;

本篇概览

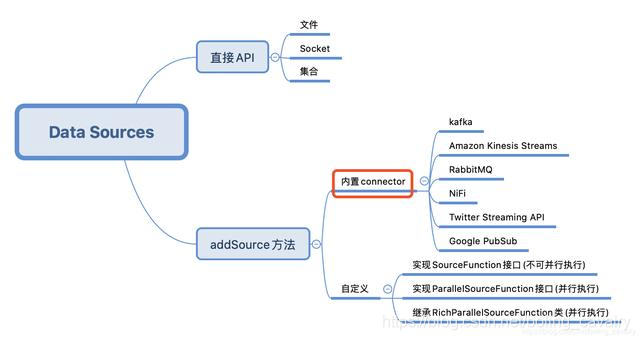

本文是《Flink的DataSource三部曲》系列的第二篇,上一篇《Flink的DataSource三部曲之一:直接API》学习了StreamExecutionEnvironment的API创建DataSource,今天要练习的是Flink内置的connector,即下图的红框位置,这些connector可以通过StreamExecutionEnvironment的addSource方法使用:

今天的实战选择Kafka作为数据源来操作,先尝试接收和处理String型的消息,再接收JSON类型的消息,将JSON反序列化成bean实例;

Flink的DataSource三部曲文章链接

源码下载

如果您不想写代码,整个系列的源码可在GitHub下载到,地址和链接信息如下表所示(https://github.com/zq2599/blog_demos):

| 名称 | 链接 | 备注 |

|---|---|---|

| 项目主页 | https://github.com/zq2599/blog_demos | 该项目在GitHub上的主页 |

| git仓库地址(https) | https://github.com/zq2599/blog_demos.git | 该项目源码的仓库地址,https协议 |

| git仓库地址(ssh) | git@github.com:zq2599/blog_demos.git | 该项目源码的仓库地址,ssh协议 |

这个git项目中有多个文件夹,本章的应用在flinkdatasourcedemo文件夹下,如下图红框所示:

环境和版本

本次实战的环境和版本如下:

- JDK:1.8.0_211

- Flink:1.9.2

- Maven:3.6.0

- 操作系统:macOS Catalina 10.15.3 (MacBook Pro 13-inch, 2018)

- IDEA:2018.3.5 (Ultimate Edition)

- Kafka:2.4.0

- Zookeeper:3.5.5

请确保上述内容都已经准备就绪,才能继续后面的实战;

Flink与Kafka版本匹配

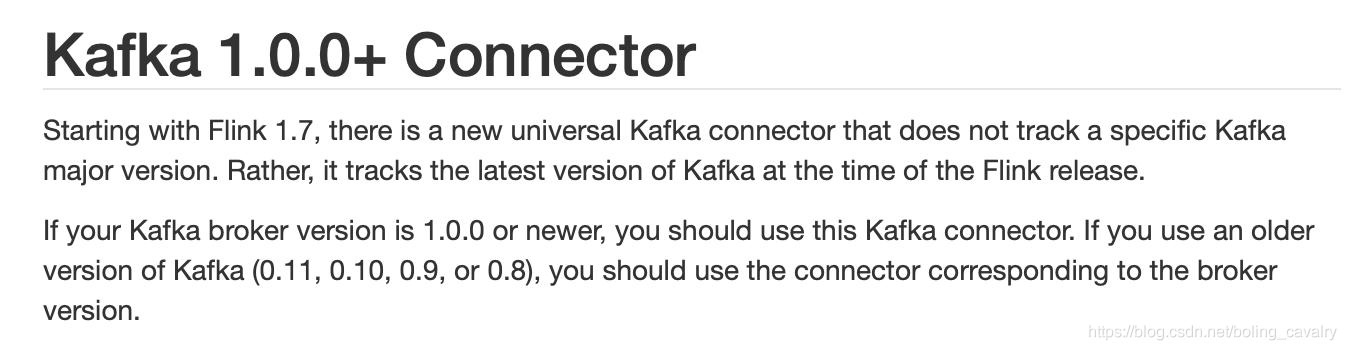

- Flink官方对匹配Kafka版本做了详细说明,地址是:https://ci.apache.org/projects/flink/flink-docs-stable/dev/connectors/kafka.html

- 要重点关注的是官方提到的通用版(universal Kafka connector ),这是从Flink1.7开始推出的,对于Kafka1.0.0或者更高版本都可以使用:

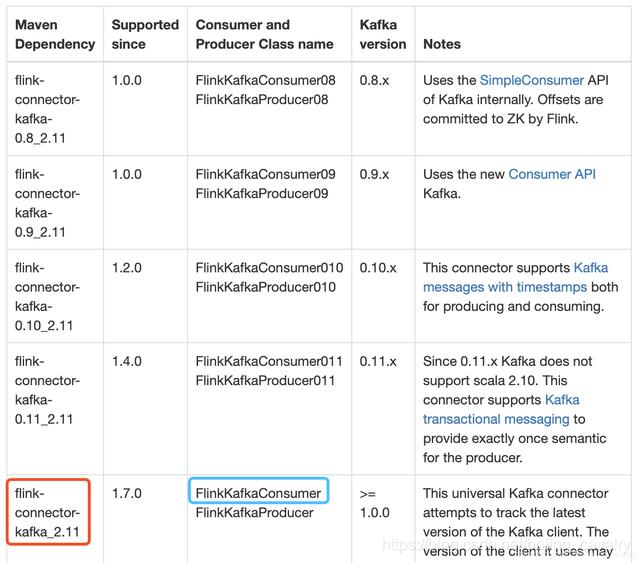

3. 下图红框中是我的工程中要依赖的库,蓝框中是连接Kafka用到的类,读者您可以根据自己的Kafka版本在表格中找到适合的库和类:

实战字符串消息处理

- 在kafka上创建名为test001的topic,参考命令:

./kafka-topics.sh \--create \--zookeeper 192.168.50.43:2181 \--replication-factor 1 \--partitions 2 \--topic test001

- 继续使用上一章创建的flinkdatasourcedemo工程,打开pom.xml文件增加以下依赖:

<dependency><groupId>org.apache.flink</groupId><artifactId>flink-connector-kafka_2.11</artifactId><version>1.10.0</version></dependency>

- 新增类Kafka240String.java,作用是连接broker,对收到的字符串消息做WordCount操作:

package com.bolingcavalry.connector;import com.bolingcavalry.Splitter;import org.apache.flink.api.common.serialization.SimpleStringSchema;import org.apache.flink.streaming.api.datastream.DataStream;import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;import org.apache.flink.streaming.api.windowing.time.Time;import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;import java.util.Properties;import static com.sun.tools.doclint.Entity.para;public class Kafka240String {public static void main(String[] args) throws Exception {StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();//设置并行度env.setParallelism(2);Properties properties = new Properties();//broker地址properties.setProperty("bootstrap.servers", "192.168.50.43:9092");//zookeeper地址properties.setProperty("zookeeper.connect", "192.168.50.43:2181");//消费者的groupIdproperties.setProperty("group.id", "flink-connector");//实例化Consumer类FlinkKafkaConsumer<String> flinkKafkaConsumer = new FlinkKafkaConsumer<>("test001",new SimpleStringSchema(),properties);//指定从最新位置开始消费,相当于放弃历史消息flinkKafkaConsumer.setStartFromLatest();//通过addSource方法得到DataSourceDataStream<String> dataStream = env.addSource(flinkKafkaConsumer);//从kafka取得字符串消息后,分割成单词,统计数量,窗口是5秒dataStream.flatMap(new Splitter()).keyBy(0).timeWindow(Time.seconds(5)).sum(1).print();env.execute("Connector DataSource demo : kafka");}}

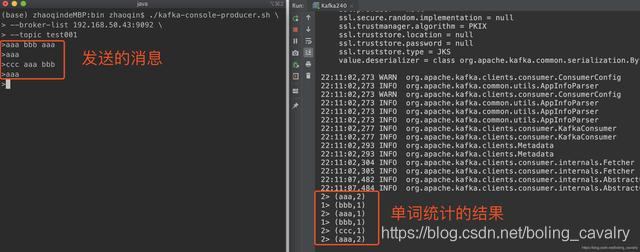

- 确保kafka的topic已经创建,将Kafka240运行起来,可见消费消息并进行单词统计的功能是正常的:

5. 接收kafka字符串消息的实战已经完成,接下来试试JSON格式的消息;

实战JSON消息处理

- 接下来要接受的JSON格式消息,可以被反序列化成bean实例,会用到JSON库,我选择的是gson;

- 在pom.xml增加gson依赖:

<dependency><groupId>com.google.code.gson</groupId><artifactId>gson</artifactId><version>2.8.5</version></dependency>

- 增加类Student.java,这是个普通的Bean,只有id和name两个字段:

package com.bolingcavalry;public class Student {private int id;private String name;public int getId() {return id;}public void setId(int id) {this.id = id;}public String getName() {return name;}public void setName(String name) {this.name = name;}}

- 增加类StudentSchema.java,该类是DeserializationSchema接口的实现,将JSON反序列化成Student实例时用到:

ackage com.bolingcavalry.connector;import com.bolingcavalry.Student;import com.google.gson.Gson;import org.apache.flink.api.common.serialization.DeserializationSchema;import org.apache.flink.api.common.serialization.SerializationSchema;import org.apache.flink.api.common.typeinfo.TypeInformation;import java.io.IOException;public class StudentSchema implements DeserializationSchema<Student>, SerializationSchema<Student> {private static final Gson gson = new Gson();/*** 反序列化,将byte数组转成Student实例* @param bytes* @return* @throws IOException*/@Overridepublic Student deserialize(byte[] bytes) throws IOException {return gson.fromJson(new String(bytes), Student.class);}@Overridepublic boolean isEndOfStream(Student student) {return false;}/*** 序列化,将Student实例转成byte数组* @param student* @return*/@Overridepublic byte[] serialize(Student student) {return new byte[0];}@Overridepublic TypeInformation<Student> getProducedType() {return TypeInformation.of(Student.class);}}

- 新增类Kafka240Bean.java,作用是连接broker,对收到的JSON消息转成Student实例,统计每个名字出现的数量,窗口依旧是5秒:

package com.bolingcavalry.connector;import com.bolingcavalry.Splitter;import com.bolingcavalry.Student;import org.apache.flink.api.common.functions.MapFunction;import org.apache.flink.api.common.serialization.SimpleStringSchema;import org.apache.flink.api.java.tuple.Tuple2;import org.apache.flink.streaming.api.datastream.DataStream;import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;import org.apache.flink.streaming.api.windowing.time.Time;import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;import java.util.Properties;public class Kafka240Bean {public static void main(String[] args) throws Exception {StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();//设置并行度env.setParallelism(2);Properties properties = new Properties();//broker地址properties.setProperty("bootstrap.servers", "192.168.50.43:9092");//zookeeper地址properties.setProperty("zookeeper.connect", "192.168.50.43:2181");//消费者的groupIdproperties.setProperty("group.id", "flink-connector");//实例化Consumer类FlinkKafkaConsumer<Student> flinkKafkaConsumer = new FlinkKafkaConsumer<>("test001",new StudentSchema(),properties);//指定从最新位置开始消费,相当于放弃历史消息flinkKafkaConsumer.setStartFromLatest();//通过addSource方法得到DataSourceDataStream<Student> dataStream = env.addSource(flinkKafkaConsumer);//从kafka取得的JSON被反序列化成Student实例,统计每个name的数量,窗口是5秒dataStream.map(new MapFunction<Student, Tuple2<String, Integer>>() {@Overridepublic Tuple2<String, Integer> map(Student student) throws Exception {return new Tuple2<>(student.getName(), 1);}}).keyBy(0).timeWindow(Time.seconds(5)).sum(1).print();env.execute("Connector DataSource demo : kafka bean");}}

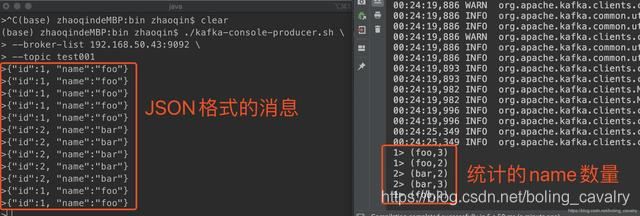

- 在测试的时候,要向kafka发送JSON格式字符串,flink这边就会给统计出每个name的数量:

至此,内置connector的实战就完成了,接下来的章节,我们将要一起实战自定义DataSource;

欢迎关注公众号:程序员欣宸

微信搜索「程序员欣宸」,我是欣宸,期待与您一同畅游Java世界...

https://github.com/zq2599/blog_demos

Flink的DataSource三部曲之二:内置connector的更多相关文章

- Flink的DataSource三部曲之一:直接API

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- Flink的DataSource三部曲之三:自定义

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- Flink on Yarn三部曲之二:部署和设置

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- ASP.NET Core 2.1 : 十二.内置日志、使用Nlog将日志输出到文件

应用离不开日志,虽然现在使用VS有强大的调试功能,开发过程中不复杂的情况懒得输出日志了(想起print和echo的有木有),但在一些复杂的过程中以及应用日常运行中的日志还是非常有用. ASP.NET ...

- 菜鸟日记之JSP二 内置对象的理解

·最近学习JSP了,对编程和网络又有了一些理解.无论是现实中人与人的交流,还是网络世界的接触,都是在相互表达自己的意思让别人知道,并理解对方的信息.然后我们知道的事情不断的变多,会又交杂出新的内容,不 ...

- 模拟Springboot二:内置tomcat

既然要将tomcat内置到项目中,并且能够成功的启动项目就要知道 tomcat 做了哪些事情 ,那么就必须先搞明白 一个 普通的web项目是如何被我们本地配置的tomcat启动并运行的 (1). 先 ...

- python之字典二 内置方法总结

Python字典包含了以下内置方法: clear()函数用于删除字典内所有元素 dict1 = {, 'Class': 'First'} print('the start len %d' % len( ...

- ASP 基础二 内置对象

一 Request 二 Response 三 Application 四 Session 五 Server <script language="vbscript" runat ...

- day0318装饰器和内置函数

一.装饰器 1.装饰器: 解释:装饰器的本事就是一个函数,不改动主代码的情况下,增加新功能.返回值也是一个函数对象. 2.装饰器工作过程 import time def func(): print(' ...

随机推荐

- 错误: 在类中找不到 main 方法, 请将 main 方法定义为:    public static void main(String[] args) 否则 JavaFX 应用程序类必须扩展javafx.application.Application 。

昨天在eclipse编写JAVA程序时,遇到一个问题: 错误: 在类中找不到 main 方法, 请将 main 方法定义为: public static void main(String[] a ...

- C# 读取路径的各种方式

//1.获取模块的完整路径. string path1 = System.Diagnostics.Process.GetCurrentProcess().MainModule.FileName; // ...

- Github 太狠了,居然把 "master" 干掉了!

前段时间栈长有看到 Github 和 master 分支变更的新闻,当时没有注意细节,直到今天我创建仓库时: 看了半天感觉有点不对劲啊... 怎么 master 不见了,之前默认主干分支名称都是叫 m ...

- 一文看懂YOLO v3

论文地址:https://pjreddie.com/media/files/papers/YOLOv3.pdf论文:YOLOv3: An Incremental Improvement YOLO系列的 ...

- shell-脚本的建立和执行

1. shell脚本的建立和执行 1) shell脚本的建立 在linux系统中,shell脚本(bash shell程序)通常是在编辑器(如vi/vim)中编写,由unix/linux命令.bas ...

- devops-持续集成管理之SonarQube

1. devops-持续集成管理之SonarQube 1) 代码质量七宗罪 编码规范:是否遵守了编码规范,遵循了最佳实践. 潜在的BUG:可能在最坏情况下出现问题的代码,以及存在安全漏洞的代码. 文 ...

- 手撸ORM浅谈ORM框架之基础篇

好奇害死猫 一直觉得ORM框架好用.功能强大集众多优点于一身,当然ORM并非完美无缺,任何事物优缺点并存!我曾一度认为以为使用了ORM框架根本不需要关注Sql语句如何执行的,更不用关心优化的问题!!! ...

- linq 整理(前序)

前言 对linq进行整理,分为前序.中序和后序. 前序就是一些简单的概念和模拟. 中序的话就是深挖一些思想. 后序对其进行解刨. 正文 语言集成查询 (LINQ) 是一系列直接将查询功能集成到 C# ...

- 拦截导弹简单版——线性dp

题目描述 某国为了防御敌国的导弹袭击,发展出一种导弹拦截系统.但是这种导弹拦截系统有一个缺陷:虽然它的第一发炮弹能够到达任意的高度,但是以后每一发炮弹都不能高于前一发的高度.某天,雷达捕捉到敌国的导弹 ...

- CVE-2009-0927-Adobe Reader缓冲区溢出漏洞分析

0x00概述: 此漏洞的成因是由于Adobe Reader在处理PDF文档中所包含的JavaScript脚本时的Collab对象的getlcon()方式不正确处理输入的参数,而产生的缓冲区溢出,成功利 ...