使用国内的镜像源搭建 kubernetes(k8s)集群

1. 概述

老话说的好:努力学习,提高自己,让自己知道的比别人多,了解的别人多。

言归正传,之前我们聊了 Docker,随着业务的不断扩大,Docker 容器不断增多,物理机也不断增多,此时我们会发现,登录到每台机器去手工操作 Docker 是一件很麻烦的事情。

这时,我们需要一个好用的工具来管理 Docker,帮我们创建、运行、调整、销毁这些容器,帮我们监控哪个容器宕掉了,然后重新启动这个容器等等。

kubernetes(k8s)就是一个很好的选择,今天我们先来聊聊 kubernetes(k8s)是如何搭建的。

2. 场景说明

服务器A IP:192.168.1.12

服务器B IP:192.168.1.11

服务器C IP:192.168.1.15

服务器A hostname:zhuifengren2

服务器B hostname:zhuifengren3

服务器C hostname:zhuifengren4

准备三台服务器,CentOS7 操作系统。

三台服务器都已安装了 Docker,关于 Docker 的安装可参见我的另一篇文章《Docker 急速入门》(https://www.cnblogs.com/w84422/p/15580575.html)

服务器A 作为 Master 节点,服务器B 和 服务器C 作为数据节点。

3. kubernetes(k8s)安装(CentOS7)

3.1 官网地址

https://kubernetes.io/docs/setup/production-environment/tools/kubeadm/install-kubeadm/

3.2 服务器配置要求

内存至少2G

CPU至少2核

硬盘至少20G

3.3 关闭 SELinux

方式一:

# setenforce 0

# sed -i 's/^SELINUX=enforcing$/SELINUX=permissive/' /etc/selinux/config

方式二:

# vim /etc/sysconfig/selinux

SELINUX=enforcing 改为 SELINUX=disabled

重启服务器

3.4 设置路由

# cat <<EOF | sudo tee /etc/modules-load.d/k8s.conf

br_netfilter

EOF

# cat <<EOF | sudo tee /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

# sysctl --system

3.5 关闭系统的 Swap

# swapoff -a

# vi /etc/fstab

注释掉 SWAP 的自动挂载

# vi /etc/sysctl.d/k8s.conf

添加下面一行:

vm.swappiness=0

# sysctl -p /etc/sysctl.d/k8s.conf

3.6 安装并启动 kubernetes(K8s)

# cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

exclude=kube*

EOF

# yum install -y kubelet kubeadm kubectl --disableexcludes=kubernetes

# systemctl enable kubelet

# systemctl restart kubelet

3.3 到 3.6 的步骤在3台服务器上都执行

4. kubernetes(k8s)集群搭建(CentOS7)

4.1 修改 Docker 配置

# cat > /etc/docker/daemon.json <<EOF

{

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

},

"storage-driver": "overlay2",

"storage-opts": [

"overlay2.override_kernel_check=true"

],

"data-root": "/data/docker"

}

EOF

# systemctl daemon-reload

# systemctl restart docker

4.2 查看需要的镜像

# kubeadm config images list

k8s.gcr.io/kube-apiserver:v1.22.3

k8s.gcr.io/kube-controller-manager:v1.22.3

k8s.gcr.io/kube-scheduler:v1.22.3

k8s.gcr.io/kube-proxy:v1.22.3

k8s.gcr.io/pause:3.5

k8s.gcr.io/etcd:3.5.0-0

k8s.gcr.io/coredns/coredns:v1.8.4

4.3 从国内源拉取镜像

由于 k8s.cgr.io 无法访问,因此我们需要先使用国内镜像源拉下来,再改tag

执行下面脚本:

#/bin/bash

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.22.3

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.22.3

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.22.3

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.22.3

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.5

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.5.0-0

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:v1.8.4

docker pull quay.io/coreos/flannel:v0.15.1-amd64 docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.22.3 k8s.gcr.io/kube-apiserver:v1.22.3

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.22.3 k8s.gcr.io/kube-controller-manager:v1.22.3

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.22.3 k8s.gcr.io/kube-scheduler:v1.22.3

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.22.3 k8s.gcr.io/kube-proxy:v1.22.3

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.5 k8s.gcr.io/pause:3.5

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.5.0-0 k8s.gcr.io/etcd:3.5.0-0

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:v1.8.4 k8s.gcr.io/coredns/coredns:v1.8.4 docker rmi registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.22.3

docker rmi registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.22.3

docker rmi registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.22.3

docker rmi registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.22.3

docker rmi registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.5

docker rmi registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.5.0-0

docker rmi registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:v1.8.4

4.1 4.2 4.3 的步骤在三台服务器都需要执行

4.4 初始化集群

在 Master 节点执行

# kubeadm init --apiserver-advertise-address=192.168.1.12 --pod-network-cidr=10.244.0.0/16

其中,192.168.1.12 是 Master 节点的 IP 地址,可根据实际情况修改。

4.5 Get "http://localhost:10248/healthz": dial tcp [::1]:10248: connect: connection refused 报错解决

初始化集群时,如果报以上的错误,在 Master 节点按以下步骤操作即可:

# vi /usr/lib/systemd/system/kubelet.service.d/10-kubeadm.conf

增加:

Environment="KUBELET_SYSTEM_PODS_ARGS=--pod-manifest-path=/etc/kubernetes/manifests --allow-privileged=true --fail-swap-on=false"

cat > /var/lib/kubelet/config.yaml <<EOF

apiVersion: kubelet.config.k8s.io/v1beta1

kind: KubeletConfiguration

cgroupDriver: systemd

EOF

# systemctl daemon-reload

# systemctl restart kubelet

# kubeadm reset -f

4.6 再次执行集群初始化命令

在 Master 节点执行

# kubeadm init --apiserver-advertise-address=192.168.1.12 --pod-network-cidr=10.244.0.0/16

出现以下信息,说明初始化成功:

Your Kubernetes control-plane has initialized successfully! To start using your cluster, you need to run the following as a regular user: mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config Alternatively, if you are the root user, you can run: export KUBECONFIG=/etc/kubernetes/admin.conf You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/ Then you can join any number of worker nodes by running the following on each as root: kubeadm join 192.168.1.12:6443 --token x0u0ou.q6271pyjm7cv5hxl \

--discovery-token-ca-cert-hash sha256:907ffb03d73f7668b96024c328880f95f4249e98da1be44d1caeb01dd62173da

4.7 根据上一步的信息 export config 文件 及设置网络

# export KUBECONFIG=/etc/kubernetes/admin.conf

这里我们使用 flannel 网络

# kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

到此为止,Master 节点搭建完毕。

4.8 根据 4.6 步骤的信息,将两个数据节点加入集群

在 服务器B 和 服务器C,执行如下命令(来源于 4.6 步骤的信息):

# kubeadm join 192.168.1.12:6443 --token x0u0ou.q6271pyjm7cv5hxl \

--discovery-token-ca-cert-hash sha256:907ffb03d73f7668b96024c328880f95f4249e98da1be44d1caeb01dd62173da

如果执行不成功,或者数据节点始终是 NotReady 状态,则参见 4.5 步骤,修改配置。

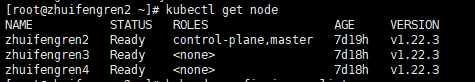

4.9 在 Master 节点,查看集群信息

# kubectl get node

如果状态都是 Ready,则 Kubernetes(K8s)集群搭建成功。

5. 综述

今天聊了一下 如何使用国内的镜像源搭建 kubernetes(k8s)集群 ,希望可以对大家的工作有所帮助。

欢迎帮忙点赞、评论、转发、加关注 :)

关注追风人聊Java,每天更新Java干货。

6. 个人公众号

追风人聊Java,欢迎大家关注

使用国内的镜像源搭建 kubernetes(k8s)集群的更多相关文章

- Centos7 安装部署Kubernetes(k8s)集群

目录 一.系统环境 二.前言 三.Kubernetes 3.1 概述 3.2 Kubernetes 组件 3.2.1 控制平面组件 3.2.2 Node组件 四.安装部署Kubernetes集群 4. ...

- 搭建Kubernetes容器集群管理系统

1.Kubernetes 概述 Kubernetes 是 Google 开源的容器集群管理系统,基于 Docker 构建一个容器的调度服务,提供资源调度.均衡容灾.服务注册.劢态扩缩容等功能套件. 基 ...

- 使用kubectl管理Kubernetes(k8s)集群:常用命令,查看负载,命名空间namespace管理

目录 一.系统环境 二.前言 三.kubectl 3.1 kubectl语法 3.2 kubectl格式化输出 四.kubectl常用命令 五.查看kubernetes集群node节点和pod负载 5 ...

- Istio(二):在Kubernetes(k8s)集群上安装部署istio1.14

目录 一.模块概览 二.系统环境 三.安装istio 3.1 使用 Istioctl 安装 3.2 使用 Istio Operator 安装 3.3 生产部署情况如何? 3.4 平台安装指南 四.Ge ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录

0.目录 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 一.感谢 在此感谢.net ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列之集群部署环境规划(一)

0.前言 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 一.环境规划 软件 版本 ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列之自签TLS证书及Etcd集群部署(二)

0.前言 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 一.服务器设置 1.把每一 ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列之flanneld网络介绍及部署(三)

0.前言 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 一.flanneld介绍 ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列之部署master/node节点组件(四)

0.前言 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 1.部署master组件 ...

随机推荐

- pip安装加速

PIP国内镜像源 名称 源地址 阿里云 http://mirrors.aliyun.com/pypi/simple/ 中国科技大学 https://pypi.mirrors.ustc.edu.cn/s ...

- Java多线程编程实战指南 核心篇 读书笔记

锁 volatile CAS final static 原子性保障 具备 具备 具备 不涉及 不涉及 可见性保障 具备 具备 不具备 不具备 具备① 有序性保证 具备 具备 不涉及 具备 具备② 上下 ...

- PAT (Basic Level) Practice (中文)1086 就不告诉你 (15分)

1086 就不告诉你 (15分) 做作业的时候,邻座的小盆友问你:"五乘以七等于多少?"你应该不失礼貌地围笑着告诉他:"五十三."本题就要求你,对任何一对给定的 ...

- python socket 基本使用

socket通常也叫做"套接字",用于连接server client,是一个通信链的句柄,应用程序通常通过套接字向网络发出请求或应答网络请求. 就像python 处理file一样: ...

- (课内)信安数基RSA-level1&&2

注:(不求甚解的)攻击原理 以及(浅层的)算法解释已在图片中给出:文字部分主要讲一些python语法的东西. 代码需要库 gmpy2和libnum:加密算法还需要Crypto.Util.number ...

- Jmeter之BeanShell 断言

作者:季沐测试笔记 原文地址:https://www.cnblogs.com/testero/p/15436864.html 博客主页:https://www.cnblogs.com/testero ...

- LeetCode:数组专题

数组专题 有关数组的一些 leetcode 题,在此做一些记录,不然没几天就忘光光了 二分查找 双指针 滑动窗口 前缀和/差分数组 二分查找 本文内容摘录自公众号labuladong中有关二分查找的文 ...

- Java:并发笔记-04

Java:并发笔记-04 说明:这是看了 bilibili 上 黑马程序员 的课程 java并发编程 后做的笔记 本章内容-3 线程状态转换 活跃性 Lock 3.10 重新理解线程状态转换 假设有线 ...

- [对对子队]会议记录5.19(Scrum Meeting6)

今天已完成的工作 吴昭邦 工作内容:搭建第9关 相关issue:搭建关卡7.8.9 相关签入:feat: 第9关能够通过 何瑞 工作内容:搭建第9关 相关issue:搭建关卡7.8 ...

- [Beta]the Agiles Scrum Meeting 4

会议时间:2020.5.15 21:00 1.每个人的工作 今天已完成的工作 成员 已完成的工作 yjy 增加教学计划面板,修复bug tq 实现查看.删除测试点功能 wjx 实现批量创建结对项目功能 ...