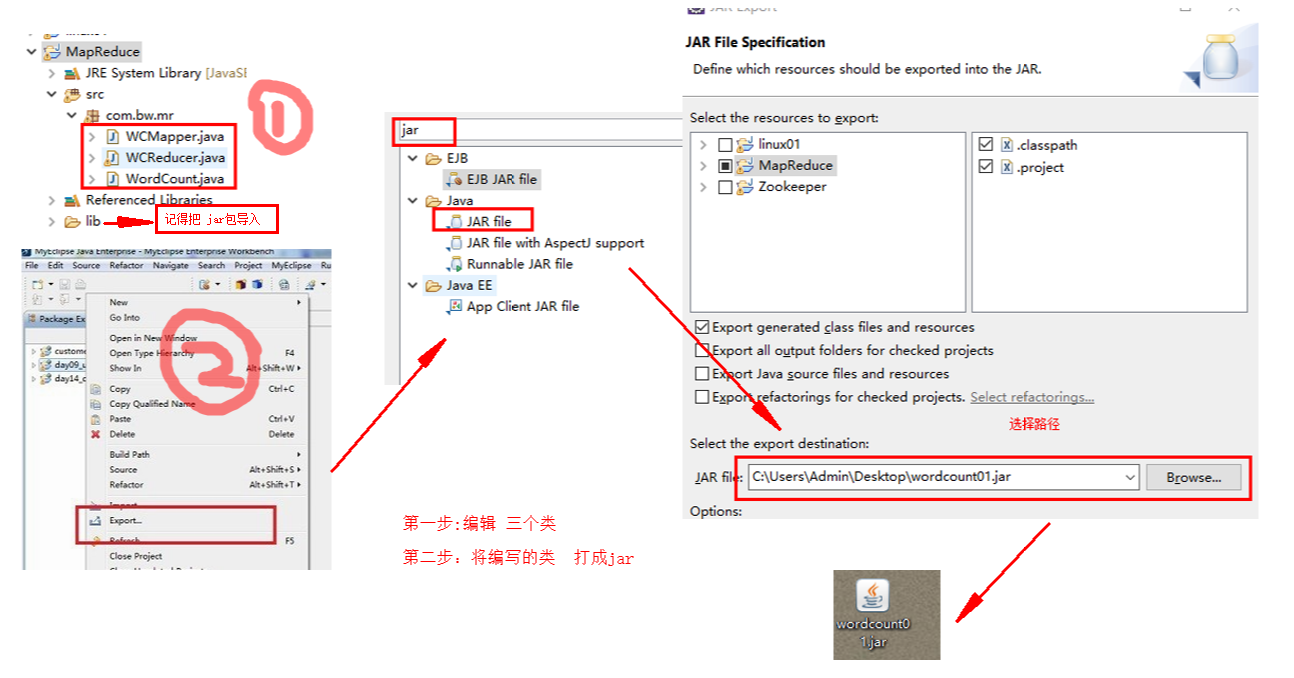

用eclipce编写 MR程序 MapReduce

package com.bw.mr; import java.io.IOException;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

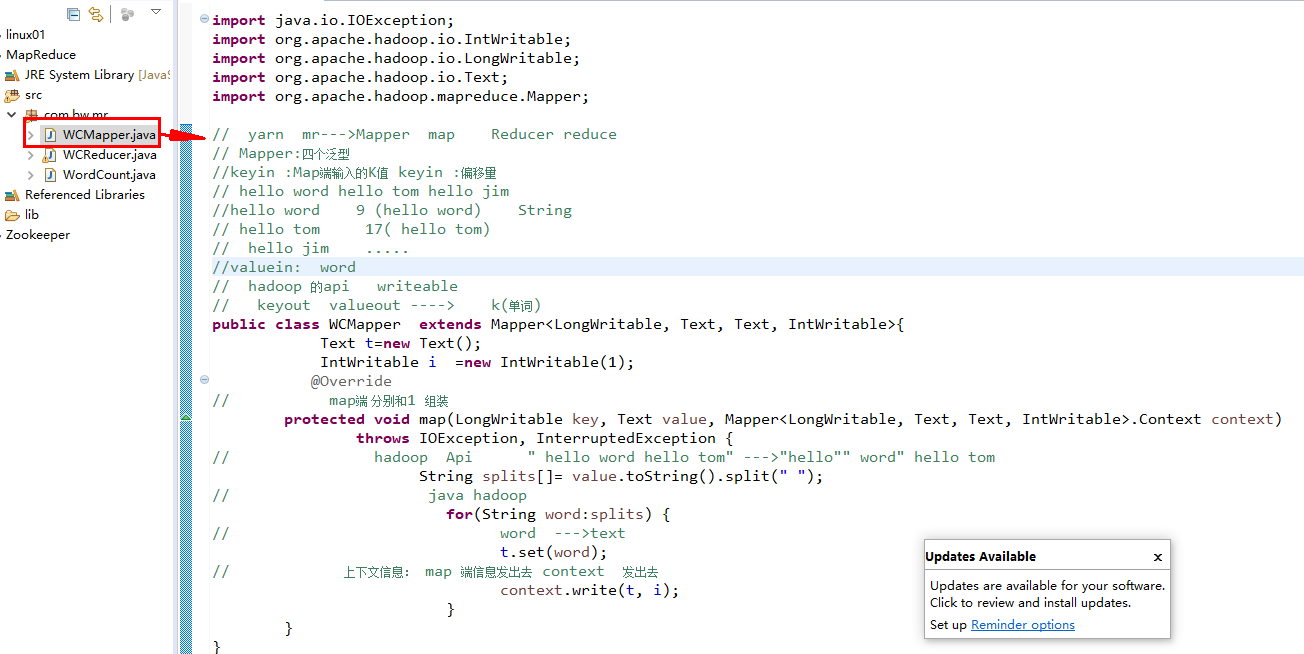

import org.apache.hadoop.mapreduce.Mapper; // yarn mr--->Mapper map Reducer reduce

// Mapper:四个泛型

//keyin :Map端输入的K值 keyin :偏移量

// hello word hello tom hello jim

//hello word 9 (hello word) String

// hello tom 17( hello tom)

// hello jim .....

//valuein: word

// hadoop 的api writeable

// keyout valueout ----> k(单词)

public class WCMapper extends Mapper<LongWritable, Text, Text, IntWritable>{

Text t=new Text();

IntWritable i =new IntWritable(1);

@Override

// map端 分别和1 组装

protected void map(LongWritable key, Text value, Mapper<LongWritable, Text, Text, IntWritable>.Context context)

throws IOException, InterruptedException {

// hadoop Api " hello word hello tom" --->"hello"" word" hello tom

String splits[]= value.toString().split(" ");

// java hadoop

for(String word:splits) {

// word --->text

t.set(word);

// 上下文信息: map 端信息发出去 context 发出去

context.write(t, i);

}

}

}

package com.bw.mr; import java.io.IOException; import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; // Mr :input map reduce output

// reducer reduce hello(1,1,1,1,1)-->hello(1+1+1+...)

// map(LongWriteable,text) --->(text,IntWriteable)\

// reduce (text,IntWriteable) ---->(text,IntWriteable)

// hello(1,1,1,1,1)-->

public class WCReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

// 重写 reduce 方法

@Override

// text :word Iterable (111111111111111)

protected void reduce(Text arg0, Iterable<IntWritable> arg1,

Reducer<Text, IntWritable, Text, IntWritable>.Context arg2) throws IOException, InterruptedException {

// reduce --->归并 ---》 word(1,1,1,1,...)---->word(count)

int count =0;

// 循环 。。。for

for(IntWritable i:arg1) {

count++;

}

// 输出最后 的结果

arg2.write(arg0,new IntWritable(count));

}

}

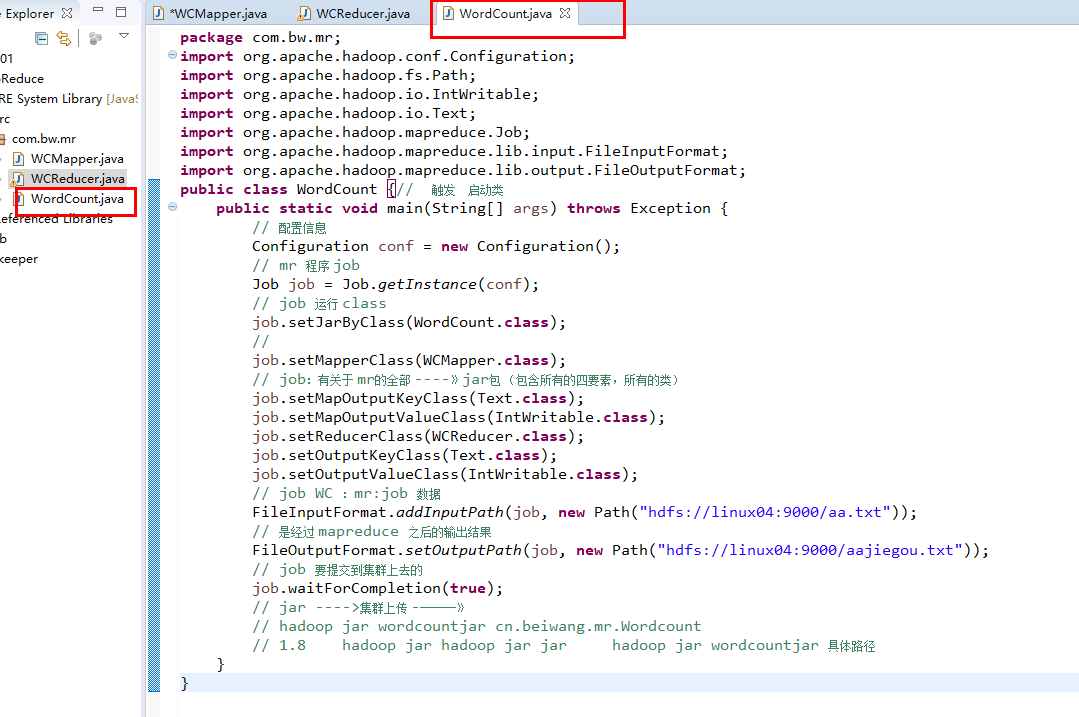

package com.bw.mr;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class WordCount {// 触发 启动类

public static void main(String[] args) throws Exception {

// 配置信息

Configuration conf = new Configuration();

// mr 程序 job

Job job = Job.getInstance(conf);

// job 运行 class

job.setJarByClass(WordCount.class);

//

job.setMapperClass(WCMapper.class);

// job:有关于 mr的全部 ----》jar包 (包含所有的四要素,所有的类)

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class);

job.setReducerClass(WCReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

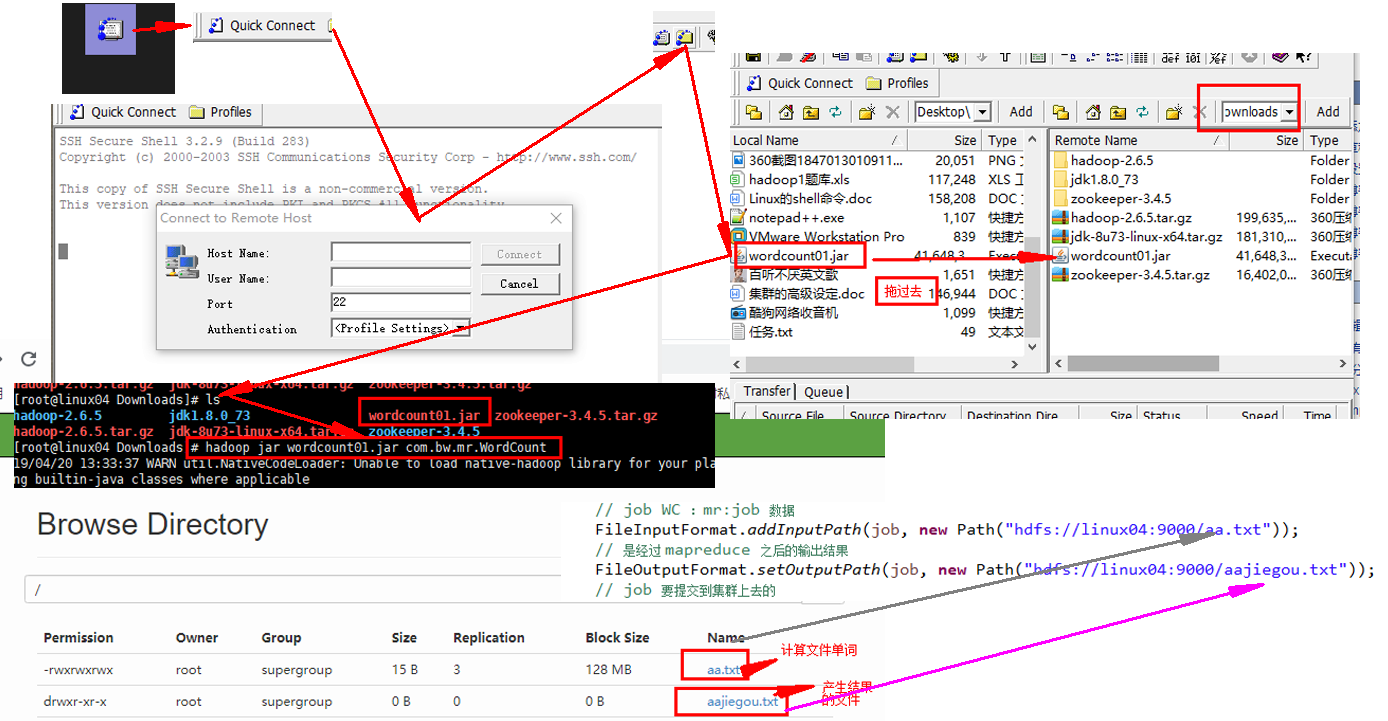

// job WC :mr:job 数据

FileInputFormat.addInputPath(job, new Path("hdfs://linux04:9000/aa.txt"));

// 是经过 mapreduce 之后的输出结果

FileOutputFormat.setOutputPath(job, new Path("hdfs://linux04:9000/aajiegou.txt"));

// job 要提交到集群上去的

job.waitForCompletion(true);

// jar ---->集群上传 -————》

// hadoop jar wordcountjar cn.beiwang.mr.Wordcount

// 1.8 hadoop jar hadoop jar jar hadoop jar wordcountjar 具体路径

}

}

用eclipce编写 MR程序 MapReduce的更多相关文章

- C#码农的大数据之路 - 使用C#编写MR作业

系列目录 写在前面 从Hadoop出现至今,大数据几乎就是Java平台专属一般.虽然Hadoop或Spark也提供了接口可以与其他语言一起使用,但作为基于JVM运行的框架,Java系语言有着天生优势. ...

- 2 weekend110的mapreduce介绍及wordcount + wordcount的编写和提交集群运行 + mr程序的本地运行模式

把我们的简单运算逻辑,很方便地扩展到海量数据的场景下,分布式运算. Map作一些,数据的局部处理和打散工作. Reduce作一些,数据的汇总工作. 这是之前的,weekend110的hdfs输入流之源 ...

- 编写简单的Mapreduce程序并部署在Hadoop2.2.0上运行

今天主要来说说怎么在Hadoop2.2.0分布式上面运行写好的 Mapreduce 程序. 可以在eclipse写好程序,export或用fatjar打包成jar文件. 先给出这个程序所依赖的Mave ...

- Hadoop MapReduce概念学习系列之mr程序组件全貌(二十)

其实啊,spilt是,控制Apache Hadoop Mapreduce的map并发任务数,详细见http://www.cnblogs.com/zlslch/p/5713652.html map,是m ...

- 用PHP编写Hadoop的MapReduce程序

用PHP编写Hadoop的MapReduce程序 Hadoop流 虽然Hadoop是用Java写的,但是Hadoop提供了Hadoop流,Hadoop流提供一个API, 允许用户使用任何语言编 ...

- 一起学Hadoop——使用IDEA编写第一个MapReduce程序(Java和Python)

上一篇我们学习了MapReduce的原理,今天我们使用代码来加深对MapReduce原理的理解. wordcount是Hadoop入门的经典例子,我们也不能免俗,也使用这个例子作为学习Hadoop的第 ...

- 编写一个基于HBase的MR程序,结果遇到一个错:ERROR security.UserGroupInformation - PriviledgedActionException as ,求帮助

环境说明:Ubuntu12.04,使用CDH4.5,伪分布式环境 Hadoop配置如下: core-site.xml: <configuration><property> ...

- Windows下Eclipse提交MR程序到HadoopCluster

作者:Syn良子 出处:http://www.cnblogs.com/cssdongl 欢迎转载,转载请注明出处. 以前Eclipse上写好的MapReduce项目经常是打好包上传到Hadoop测试集 ...

- 用python + hadoop streaming 编写分布式程序(一) -- 原理介绍,样例程序与本地调试

相关随笔: Hadoop-1.0.4集群搭建笔记 用python + hadoop streaming 编写分布式程序(二) -- 在集群上运行与监控 用python + hadoop streami ...

随机推荐

- 从壹开始前后端分离 [ Vue2.0+.NET Core2.1] 二十四║ Vuex + JWT 实现授权验证登录

壹周回顾 哈喽,又是元气满满的一个周一,又与大家见面了,周末就是团圆节了,正好咱们的前后端也要团圆了,为什么这么说呢,因为以后的开发可能就需要前后端一起了,两边也终于会师了,还有几天Vue系列就基本告 ...

- 一次composer错误使用引发的思考

一次composer错误使用引发的思考 这个思考源自于一个事故.让我对版本依赖重新思考了一下. 事故现象 一个线上的管理后台,一个使用laravel搭建的管理后台,之前在线上跑的好好的,今天comop ...

- 把ABP框架部署到Docker中

本文旨在将Abp项目部署到Docker容器中,借助Gitee存储,Jenkins持续构建,利用Docker Compose生成镜像.启动镜像,在官网给定的Abp项目中,虽然用到了Dockerfile. ...

- Java Web开发模式

一 Java Web开发模式的变迁 1 最初的Java web服务器端编程技术是Servlet,利用Servlet就可以开发出一个Web应用程序. 2 为了解决Servlet缺陷,SUN推出了JSP技 ...

- 4.4管道和中间件介绍「深入浅出ASP.NET Core系列」

希望给你3-5分钟的碎片化学习,可能是坐地铁.等公交,积少成多,水滴石穿,谢谢关注. 管道流 我们知道一个管道可以有一个或多个中间件,而中间件的职责是根据HttpContext处理HTTP请求,然后往 ...

- (七) Keras 绘制网络结构和cpu,gpu切换

视频学习来源 https://www.bilibili.com/video/av40787141?from=search&seid=17003307842787199553 笔记 首先安装py ...

- window模拟linux环境-cygwin安装

cygwin是一个在windows平台上运行的unix模拟环境,它对于学习unix/linux操作环境,或者从unix到windows的应用程序移植,非常有用.通过它,你就可以在不安装linux的情况 ...

- Android项目实战(五十三):判断网络连接是否为有线状态(tv项目适配)

一般对于android手机,我们可以通过sdk提供的方法判断网络情况 /** * 获取当前的网络状态 :没有网络-0:WIFI网络1:4G网络-4:3G网络-3:2G网络-2 * 自定义 * * @p ...

- axis根据wsdl生成java客户端代码

根据wsdl生成java客户端代码有多个方法,其中使用axis生成的代码比较友好,也是经常用的一种方法.首先下载axis jar包:axis-bin-1_4.zip 官方地址:http://ws.Ap ...

- Oracle下载与Oracle安装图解(Oracle19c,Oracle18c,Oracle12c,Oracle11g)

Oracle下载与Oracle安装图解(Oracle19c,Oracle18c,Oracle12c,Oracle11g) 1.Oracle下载(Oracle11g) oracle下载方法,请根据以下步 ...