lucene_02_IKAnalyre

前言

在lucene中虽然已经提供了许多的分词器:StandardAnalyzer、CJKAnalyzer等,但在解析中文的时候都会把文中拆成一个个的单子。

毕竟老外不懂中文。这里介绍一个中文的分词器:IKAnalyre。虽然在其在分词的时候还不够完美

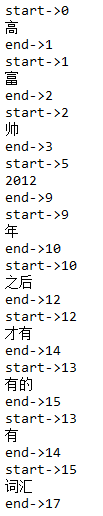

例如:将“高富帅,是2012年之后才有的词汇”

拆分为下图:

但是它可以通过配置文件来,增加新词和过滤不许出现的词比如:“的、啊、呀”等等没有具体意思的修饰副词和语气词等等。

配置IK解析器

第一步:在pom.xml 引入IK,注意:这个分词器由于从2012年之后就没有更新过,所以只能在低版本的lucene的版本中使用,该例使用的是:4.10.3

<!--ik 中文分词器-->

<!-- https://mvnrepository.com/artifact/com.janeluo/ikanalyzer -->

<dependency>

<groupId>com.janeluo</groupId>

<artifactId>ikanalyzer</artifactId>

<version>2012_u6</version>

</dependency>

完整pom.xml

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion> <groupId>com.chen</groupId>

<artifactId>lucene</artifactId>

<version>1.0-SNAPSHOT</version>

<packaging>jar</packaging> <name>lucene</name>

<url>http://maven.apache.org</url> <properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

</properties> <dependencies>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>3.8.1</version>

<scope>test</scope>

</dependency> <!-- https://mvnrepository.com/artifact/org.apache.lucene/lucene-core -->

<dependency>

<groupId>org.apache.lucene</groupId>

<artifactId>lucene-core</artifactId>

<version>4.10.3</version>

</dependency> <!-- https://mvnrepository.com/artifact/org.apache.lucene/lucene-queryparser -->

<dependency>

<groupId>org.apache.lucene</groupId>

<artifactId>lucene-queryparser</artifactId>

<version>4.10.3</version>

</dependency> <!-- https://mvnrepository.com/artifact/org.apache.lucene/lucene-analyzers-common -->

<dependency>

<groupId>org.apache.lucene</groupId>

<artifactId>lucene-analyzers-common</artifactId>

<version>4.10.3</version>

</dependency> <!-- https://mvnrepository.com/artifact/commons-io/commons-io -->

<dependency>

<groupId>commons-io</groupId>

<artifactId>commons-io</artifactId>

<version>2.6</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>RELEASE</version>

</dependency> <!-- https://mvnrepository.com/artifact/io.github.zacker330.es/ik-analysis-core -->

<!--ik 中文分词器-->

<!-- https://mvnrepository.com/artifact/com.janeluo/ikanalyzer -->

<dependency>

<groupId>com.janeluo</groupId>

<artifactId>ikanalyzer</artifactId>

<version>2012_u6</version>

</dependency> </dependencies> <build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.6.0</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

</plugins>

</build>

</project>

第二步:在资源目录下引入配置文件和扩展词汇文件、过滤词文件

IKAnalyzer.cfg.xml,是该分词器的核心配置文件,管理着ext.dic(扩展词汇文件)、stopword.dic(禁词文件)

内容如下:

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties>

<comment>IK Analyzer 扩展配置</comment>

<!--用户可以在这里配置自己的扩展字典 -->

<entry key="ext_dict">ext.dic;</entry> <!--用户可以在这里配置自己的扩展停止词字典-->

<entry key="ext_stopwords">stopword.dic;</entry> </properties>

ext.dic 内容示例:

高富帅

白富美

java工程师

stopword.dic内容示例:

我

是

用

的

你

它

他

她

a

an

and

are

as

at

be

but

by

for

if

in

into

is

it

no

not

of

on

or

such

that

the

their

then

there

these

they

this

to

was

will

with

测试代码

// 查看标准分析器的分词效果

@Test

public void testTokenStream() throws Exception {

// 创建一个标准分析器对象

// Analyzer analyzer = new StandardAnalyzer();

// Analyzer analyzer = new CJKAnalyzer();

// Analyzer analyzer = new SmartChineseAnalyzer();

Analyzer analyzer = new IKAnalyzer();

// 获得tokenStream对象

// 第一个参数:域名,可以随便给一个

// 第二个参数:要分析的文本内容

// TokenStream tokenStream = analyzer.tokenStream("test",

// "The Spring Framework provides a comprehensive programming and configuration model.");

TokenStream tokenStream = analyzer.tokenStream("test",

"高富帅,是2012年之后才有的词汇");

// 添加一个引用,可以获得每个关键词

CharTermAttribute charTermAttribute = tokenStream.addAttribute(CharTermAttribute.class);

// 添加一个偏移量的引用,记录了关键词的开始位置以及结束位置

OffsetAttribute offsetAttribute = tokenStream.addAttribute(OffsetAttribute.class);

// 将指针调整到列表的头部

tokenStream.reset();

// 遍历关键词列表,通过incrementToken方法判断列表是否结束

while (tokenStream.incrementToken()) {

// 关键词的起始位置 System.out.println("start->" + offsetAttribute.startOffset());

// 取关键词

System.out.println(charTermAttribute);

// 结束位置

System.out.println("end->" + offsetAttribute.endOffset());

}

tokenStream.close();

}

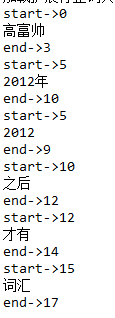

结果如下图:

lucene_02_IKAnalyre的更多相关文章

随机推荐

- 配置Java连接池的两种方式:tomcat方式以及spring方式

1. tomcat方式:在context.xml配置连接池,然后在web.xml中写配置代码(也能够在server.xml文件里配置连接池).这两种方法的差别是:在tomcat6版本号及以上中cont ...

- Spring源代码解析和配置文件载入

Spring类的继承结构图: Spring运用了大量的模板方法模式和策略模式,所以各位看源代码的时候,务必留意,每个继承的层次都有不同的作用.然后将同样的地方抽取出来,依赖抽象将不同的处理依照不同的策 ...

- HDU 5538/ 2015长春区域 L.House Building 水题

题意:求给出图的表面积,不包括底面 #include<bits/stdc++.h> using namespace std ; typedef long long ll; #define ...

- B1232 [Usaco2008Nov]安慰奶牛cheer 最小生成树

%%%小詹太巨啦!!!我就想直接最小生成树之后建树跑dfs,然后写跪了...然后看小詹博客之后恍然大悟,原来直接把边权改为w * 2 + 两边点权值就行了. 但是还是不对,为什么呢?原来我们起点走了三 ...

- 初识Java,Java语言概述

Java语言是SUN(斯坦福大学网络公司)公司1995年推出的一门高级编程语言,由此James Gosling被公认为Java语言之父.Java语言起初运用在小型的家用电子产品上,后来随着互联网的发展 ...

- 前端面试准备之JavaScript

1.数据类型. JavaScript中有5种简单数据类型(也称为基本数据类型):Undefined.Null.Boolean.Number和String.还有1种复杂数据类型——Object,Obje ...

- HTML多媒体标记之字幕标记

在HTML中,可以向页面中插入字幕,水平或垂直滚动显示文字信息,字幕标记的格式如下: <marquee 属性="值"...>滚动的文字信息</marquee> ...

- Kubernetes+Jenkins+Nexus+Gitlab进行CI/CD集成

前面已经完成了 二进制部署Kubernetes集群,下面进行CI/CD集成. 一.流程说明 应用构建和发布流程说明: 1.用户向Gitlab提交代码,代码中必须包含Dockerfile: 2.将代码提 ...

- 多线程通信(wait/notify)

线程通信概念:线程是操作系统中独立的个体,但这些个体如果不经过特殊的处理就不能成为一个整体,线程间的通信就成为整体的必用方式之一.当线程存在通信指挥,系统间的交互性会更强大,在提高CPU利用率的同时就 ...

- ASP之ViewState和IsPostBack

没怎么写过ASPX页面,今天在做增删改的界面的时候,修改出了问题. 根据传过来的ObjectID加载页面数据,赋值给TextBox控件后,修改控件的值回写数据库,发现值没有变化. 简单的例子如下: 然 ...