.Net Core 商城微服务项目系列(十三):搭建Log4net+ELK+Kafka日志框架

之前是使用NLog直接将日志发送到了ELK,本篇将会使用Docker搭建ELK和kafka,同时替换NLog为Log4net。

一.搭建kafka

1.拉取镜像

//下载zookeeper

docker pull wurstmeister/zookeeper //下载kafka

docker pull wurstmeister/kafka:2.11-0.11.0.3

2.启动

//启动zookeeper

docker run -d --name zookeeper --publish : --volume /etc/localtime:/etc/localtime wurstmeister/zookeeper //启动kafka

docker run -d --name kafka --publish : \

--link zookeeper \

--env KAFKA_ZOOKEEPER_CONNECT=192.168.3.131: \

--env KAFKA_ADVERTISED_HOST_NAME=192.168.3.131 \

--env KAFKA_ADVERTISED_PORT= \

--volume /etc/localtime:/etc/localtime \

wurstmeister/kafka:2.11-0.11.0.3

3.测试Kafka

//查看Kafka容器ID

docker ps 进入容器

docker exec -it [容器ID] bin/bash //创建topic

bin/kafka-topics.sh --create --zookeeper 192.168.3.131: --replication-factor --partitions --topic mykafka //查看topic

bin/kafka-topics.sh --list --zookeeper 192.168.3.131: //创建生产者

bin/kafka-console-producer.sh --broker-list 192.168.3.131: --topic mykafka //再开一个客户端进入容器

//创建消费者

bin/kafka-console-consumer.sh --zookeeper 192.168.3.131: --topic mykafka --from-beginning

再生产端发送消息,消费端可以成功接收到就说明没问题。

二.Docker安装ELK

.拉取镜像

docker pull sebp/elk .启动ELK

docker run -p : -p : -p : -p : -e ES_MIN_MEM=128m -e ES_MAX_MEM=2048m -d --name elk sebp/elk //若启动过程出错一般是因为elasticsearch用户拥有的内存权限太小,至少需要262144

切换到root用户 执行命令: sysctl -w vm.max_map_count= 查看结果: sysctl -a|grep vm.max_map_count 显示: vm.max_map_count = 上述方法修改之后,如果重启虚拟机将失效,所以: 解决办法: 在 /etc/sysctl.conf文件最后添加一行 vm.max_map_count= 即可永久修改

等几十秒,然后访问9200和5601端口就可以看到ELK相关的面板。

然后我们还需要配置下logstash:

.查看elk容器ID

docker ps .进入elk容器

docker exec -it 容器ID bin/bash .执行命令

/opt/logstash/bin/logstash -e 'input { stdin { } } output { elasticsearch { hosts => ["localhost"] } }'

当命令成功被执行后,看到:Successfully started Logstash API endpoint {:port=>9600} 信息后,输入:this is a dummy entry 然后回车,模拟一条日志进行测试。

打开浏览器,输入:http://:9200/_search?pretty 如图,就会看到我们刚刚输入的日志内容。

注意:如果看到这样的报错信息 Logstash could not be started because there is already another instance using the configured data directory. If you wish to run multiple instances, you must change the "path.data" setting. 请执行命令:service logstash stop 然后在执行就可以了。

OK,测试没问题的话,说明Logstash和ES之间是可以正常联通,然后我们需要配置Logstash从Kafka消费消息:

.找到config文件

cd /opt/logstash/config .编辑配置文件

vi logstash.config

input {

kafka{

bootstrap_servers =>["192.168.3.131:9092"]

client_id => "test" group_id => "test"

consumer_threads =>

decorate_events => true

topics => "mi"

}

}

filter{

json{

source => "message"

}

}

output {

elasticsearch {

hosts => ["localhost"]

index => "mi-%{app_id}"

codec => "json"

}

}

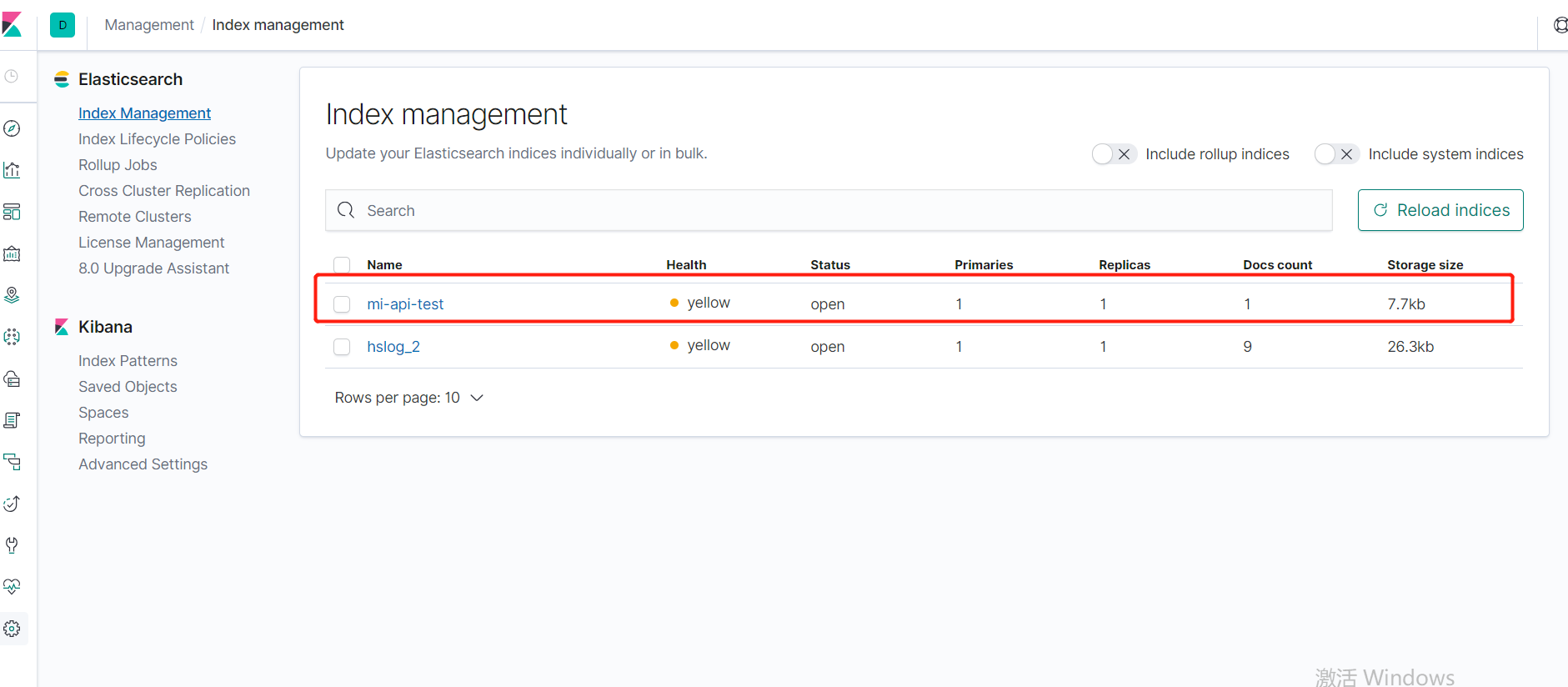

bootstrap_servers:Kafka地址

这里介绍下这个app_id的作用,生产场景下我们根据不同的项目生成不同的ES索引,比如服务是一个单独的索引,Web是一个,MQ是一个,这些就可以通过传入的app_id来区分创建。

配置完成后加载该配置:

/opt/logstash/bin/logstash -f /opt/logstash/config/logstash.conf

没问题的话,此时Logstash就会从Kafka消费数据了,然后我们新建一个.net core API项目测试一下:

1.通过NuGet引用 Microsoft.Extensions.Logging.Log4Net.AspNetCore;

2.启动文件中注入 Log4Net:

public static IWebHost BuildWebHost(string[] args) =>

WebHost.CreateDefaultBuilder(args)

.ConfigureLogging((logging) =>

{

// 过滤掉 System 和 Microsoft 开头的命名空间下的组件产生的警告级别以下的日志

logging.AddFilter("System", LogLevel.Warning);

logging.AddFilter("Microsoft", LogLevel.Warning);

logging.AddLog4Net();

})

.UseStartup<Startup>()

.Build();

3.根目录下添加 log4net.config,设置为 “如果较新则复制”

<?xml version="1.0" encoding="utf-8" ?>

<log4net>

<appender name="KafkaAppender" type="log4net.Kafka.Core.KafkaAppender, log4net.Kafka.Core">

<KafkaSettings>

<broker value="192.168.3.131:9092" />

<topic value="mi" />

</KafkaSettings>

<layout type="log4net.Kafka.Core.KafkaLogLayout,log4net.Kafka.Core" >

<appid value="api-test" />

</layout>

</appender>

<root>

<level value="ALL"/>

<appender-ref ref="KafkaAppender" />

</root>

</log4net>

topic:日志对应的 Topic 名称;

appid:服务唯一标识,辅助识别日志来源;

[Route("api/[controller]")]

public class ValuesController : Controller

{

private readonly ILogger _logger;

public ValuesController(ILogger<ValuesController> logger)

{

_logger = logger;

}

// GET api/values

[HttpGet]

public IEnumerable<string> Get()

{

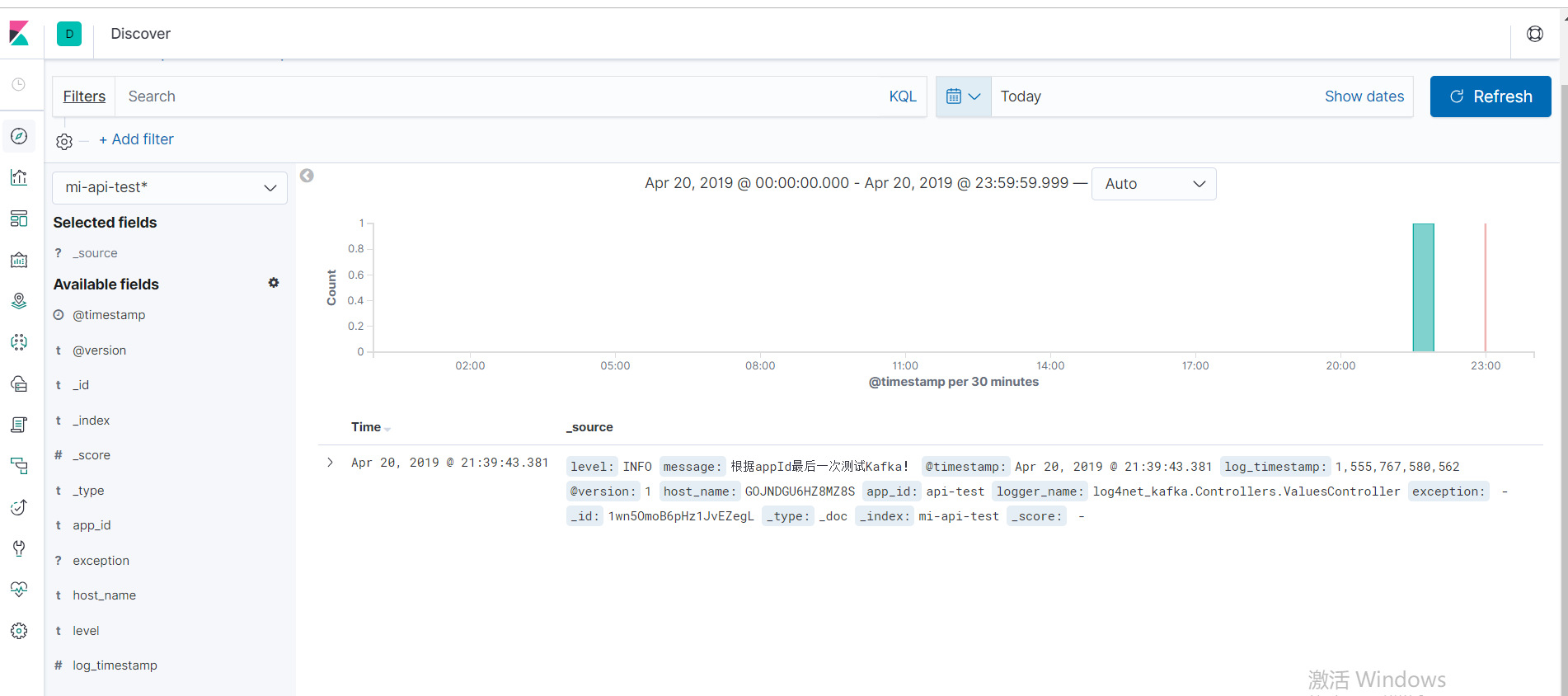

_logger.LogInformation("根据appId最后一次测试Kafka!");

return new string[] { "value1", "value2" };

}

}

OK,运行然后访问5601端口查看:

.Net Core 商城微服务项目系列(十三):搭建Log4net+ELK+Kafka日志框架的更多相关文章

- .Net Core 商城微服务项目系列(一):使用IdentityServer4构建基础登录验证

这里第一次搭建,所以IdentityServer端比较简单,后期再进行完善. 1.新建API项目MI.Service.Identity,NuGet引用IdentityServer4,添加类InMemo ...

- .Net Core 商城微服务项目系列(十四):分布式部署携程Apollo构建配置中心

一.开场白 在系统设计里我们有很多配置希望独立于系统之外,而又能够被系统实时读取.但是在传统的系统设计里,配置信息通常是耦合在系统内的,比如.net里通常会放在App.config或者web.conf ...

- .Net Core 商城微服务项目系列(六):搭建自己的Nuget包服务器

当我们使用微服务架构之后,紧接而来的问题便是服务之间的程序集引用问题,可能没接触过的同学不太理解这句话,都已经微服务化了为什么还要互相引用程序集,当然可以不引用.但是我们会有这样一种情况,我们的每个接 ...

- .Net Core 商城微服务项目系列(七):使用消息队列(RabbitMQ)实现服务异步通信

RabbitMQ是什么,怎么使用我就不介绍了,大家可以到园子里搜一下教程.本篇的重点在于实现服务与服务之间的异步通信. 首先说一下为什么要使用消息队列来实现服务通信:1.提高接口并发能力. 2.保证 ...

- .Net Core 商城微服务项目系列(十二):使用k8s部署商城服务

一.简介 本篇我们将会把商城的服务部署到k8s中,同时变化的还有以下两个地方: 1.不再使用Consul做服务的注册和发现,转而使用k8s-dns来实现. 2.不再使用Ocelot作为业务网关,使用T ...

- .Net Core 商城微服务项目系列(五):使用Polly处理服务错误

项目进行微服务化之后,随之而来的问题就是服务调用过程中发生错误.超时等问题的时候我们该怎么处理,比如因为网络的瞬时问题导致服务超时,这在我本人所在公司的项目里是很常见的问题,当发生请求超时问题的时候, ...

- .Net Core 商城微服务项目系列(八):购物车

最近加班有点多,一周五天,四天加班到11点+,心很累.原因是我当前在的这个组比较特殊,相当于业务的架构组,要为其它的开发组提供服务和监控.所以最近更新的也少,不过这个元旦三天假应该会更新三篇. 这篇是 ...

- .Net Core 商城微服务项目系列(十):使用SkyWalking构建调用链监控(2019-02-13 13:25)

SkyWalking的安装和简单使用已经在前面一篇介绍过了,本篇我们将在商城中添加SkyWalking构建调用链监控. 顺带一下怎么把ES设置为Windows服务,cd到ES的bin文件夹,运行ela ...

- .Net Core 商城微服务项目系列(十五): 构建定时任务调度和消息队列管理系统

一.系统描述 嗨,好久不见各位老哥,最近有点懒,技术博客写的太少了,因为最近在写小说,写的顺利的话说不定就转行了,哈哈哈哈哈哈哈哈哈. 今天要介绍的是基于.Net Core的定时任务调度和消息队列管理 ...

随机推荐

- 消息中间件——RabbitMQ(九)RabbitMQ整合Spring AMQP实战!(全)

前言 1. AMQP 核心组件 RabbitAdmin SpringAMQP声明 RabbitTemplate SimpleMessageListenerContainer MessageListen ...

- CF1005C Summarize to the Power of Two 暴力 map

Summarize to the Power of Two time limit per test 3 seconds memory limit per test 256 megabytes inpu ...

- "ANDROID" 支持的KEYCODE

例子: adb shell input text keyevent 4 0 --> "KEYCODE_UNKNOWN" 1 --> "KEYCODE_ ...

- I don't Blame You that You don't Understand Me

I don't Blame You that You don't Understand Me Every one has a dead corner in himself, with no entry ...

- 第四篇 跟踪过程以及openvslam中的相关实现详解

在成功初始化之后,会创建地图以及局部地图. 创建地图 在初始化正常过后,紧接着会创建地图 // src/openvslam/module/initializer.cc:67 // create new ...

- 一篇RPO漏洞挖掘文章翻译加深理解。

这是我第一次尝试翻译一篇漏洞挖掘文章,翻译它也是为了加深理解它.这是一篇很有意思的漏洞挖掘文章. 前几天在看fd的博客,偶然看到了这篇文章,虽然有点老了.但是思路真的牛皮.我决定花费时间和精力研究它们 ...

- 在VMware中就显示lo回环IP:127.0.0.1的解决办法。

在VMware时由于某些原因导致,在使用ifconfig只会显示lo,不显示其他的东西 步骤:1.sudo lshw -numeric -class network 2.sudo route -nv ...

- ImageView的功能和使用

ImageView继承自View类,它的功能用于显示图片, 或者显示Drawable对象 xml属性: src和background区别 参考:http://hi.baidu.com/sunboy_2 ...

- 纯css写一个大太阳的天气图标

效果 效果图如下 实现思路 div实现太阳的一条矩形光影 before伪元素制作另一条光影矩形,和已有的转变90° after伪元素画个圆实现太阳样式 dom结构 用两个嵌套的div容器,父容器来 ...

- Python—字符串和常用数据结构

目录 1. 字符串 2. 列表 2.1 列表的增删改查 2.2 列表的切片和排序 2.3 生成式语法 3. 元组 4.集合 5. 字典 5.1 字典的增删改查 5.2 字典的常见操作 序言:这一章我们 ...