GoogLeNet结构

Inception v1

论文:《Going deeper with convolutions》

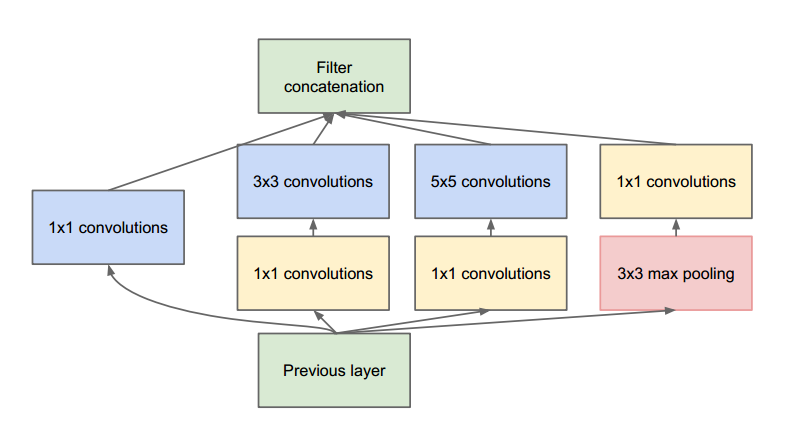

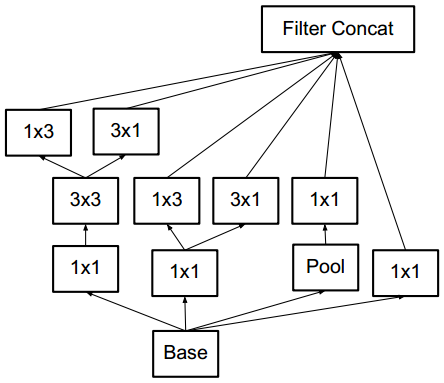

在较低的层(靠近输入的层)中,相关单元更侧重提取局部区域的信息。因此使用1x1的特征可以保存这些特征,从而与其他支路提取的特征进行融合。

3x3和5x5的卷积是想要提取不同尺度的特征,3x3卷积和5x5卷积之前的1x1的卷积作用是减少channel,从而降低参数量。

论文中说到之所以使用pooling,是因为pooling操作在目前最好的卷积网络中是必要的,个人理解是pooling操作可以增强网络的平移不变性。

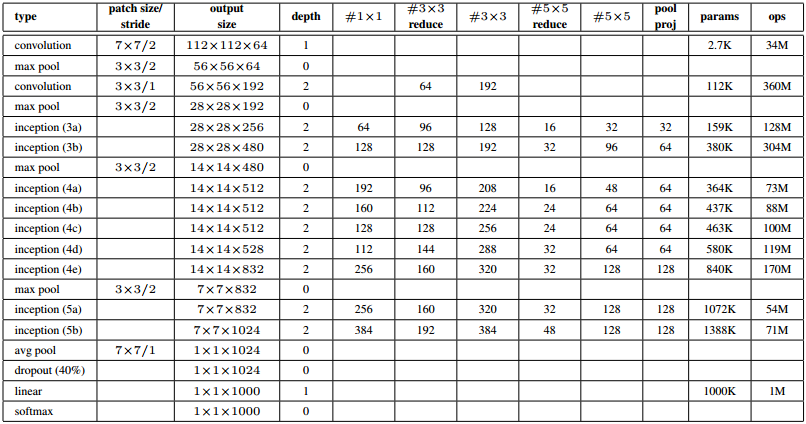

GoogLeNet结构(Inception V1)

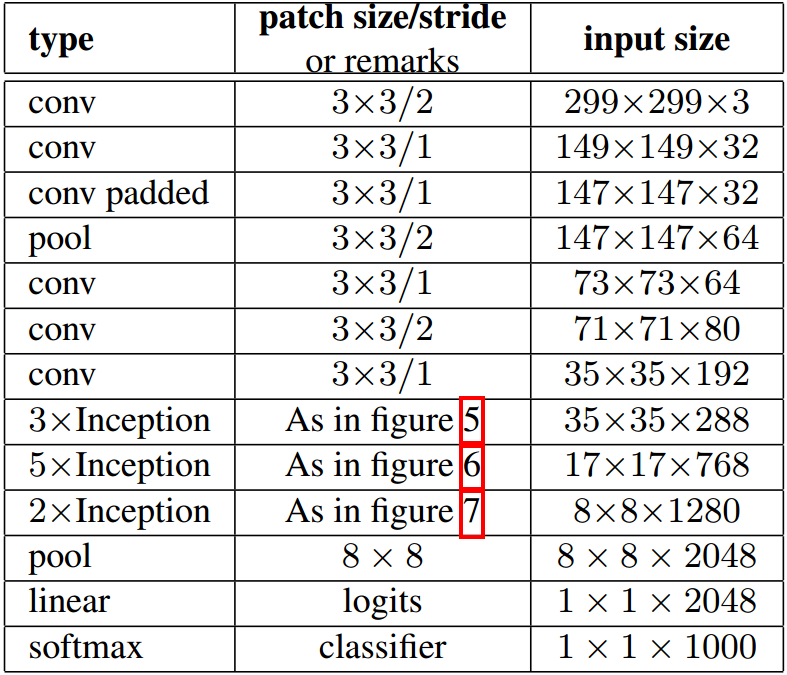

输入为224x224的RGB图像,‘#3x3 reduce’和‘#5x5 reduce’表示3x3和5x5卷积之前1x1的卷积核的个数。

为了阻止该网络中间部分梯度消失,作者引入了两个辅助分类器。它们对其中两个 Inception 模块的输出执行 softmax 操作,然后在同样的标签上计算辅助损失。总损失即辅助损失和真实损失的加权和。辅助损失只是用于训练,在推断过程中并不使用。

Inception v2

论文:《Rethinking the Inception Architecture for Computer Vision》

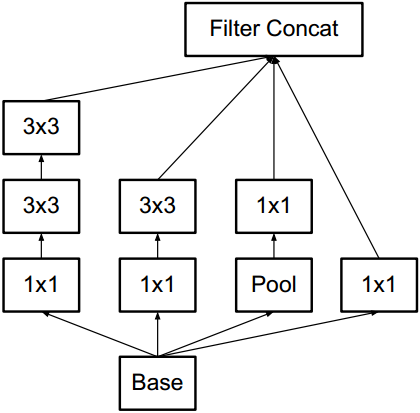

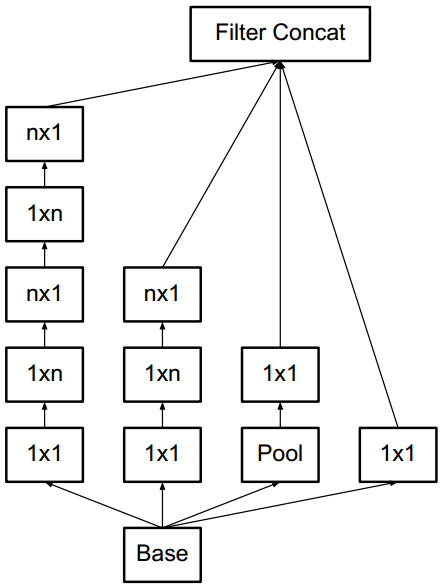

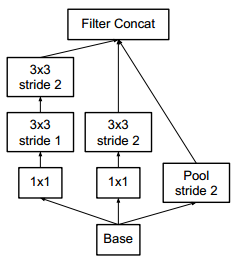

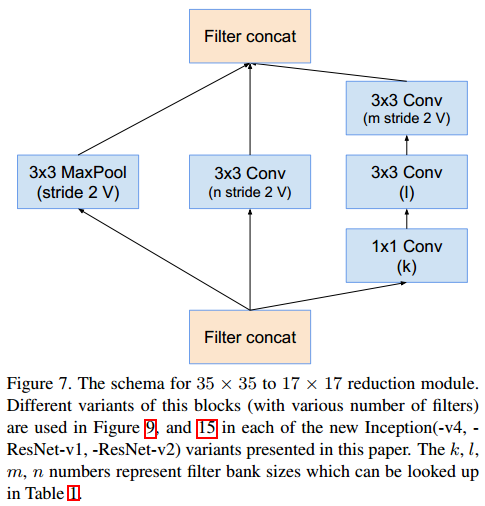

大尺度的卷积往往会造成计算的浪费,因为大尺度卷积可以分解为几个小尺度的卷积,从而减小计算量。例如5x5的卷积可以分解为两层3x3的卷积,而后者的计算量也更小。因此,在inception v2中,大尺度的卷积被分解为小尺度卷积。此外,论文还提出了使用1xn和nx1的两层卷积代替nxn卷积。inception模块之间使用stride=2的卷积来降低尺度,而非pooling操作。

论文提出的几种inception模块如下

Figure 5

Figure 6

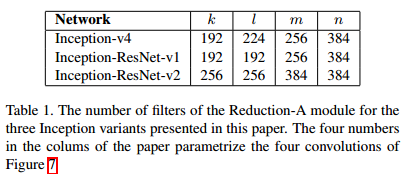

Figure 7

GoogLeNet的结构如下

inception之间使用下面模块降低尺度。

Inception v3

作者注意到辅助分类器直到训练过程快结束时才有较多贡献,那时准确率接近饱和。作者认为辅助分类器的功能是正则化,尤其是它们具备 BatchNorm 或 Dropout 操作时。是否能够改进 Inception v2 而无需大幅更改模块仍需要调查。

解决方案:

Inception Net v3 整合了前面 Inception v2 中提到的所有升级,还使用了:

- RMSProp 优化器;

- Factorized 7x7 卷积;

- 辅助分类器使用了 BatchNorm;

- 标签平滑(添加到损失公式的一种正则化项,旨在阻止网络对某一类别过分自信,即阻止过拟合)。

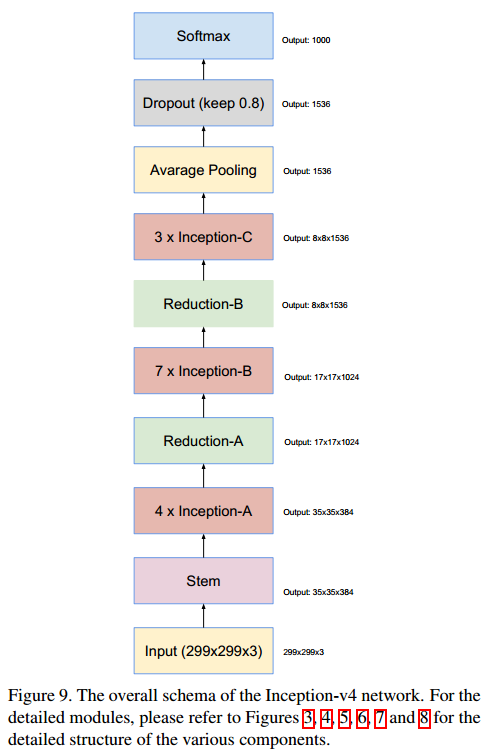

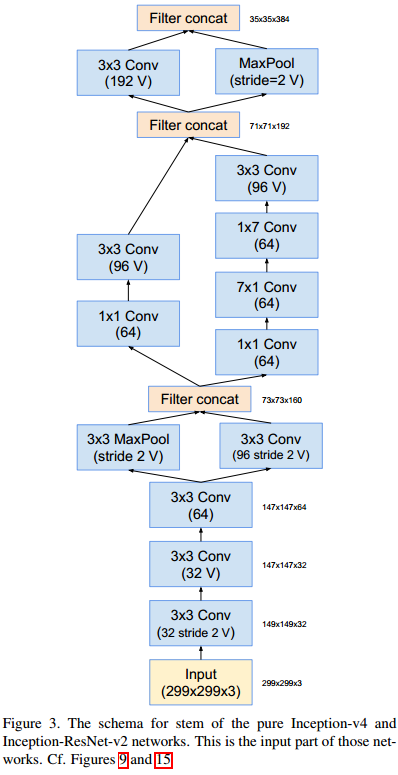

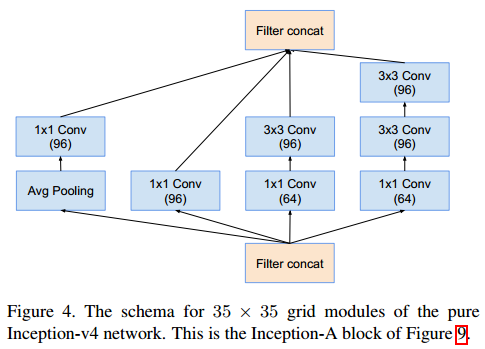

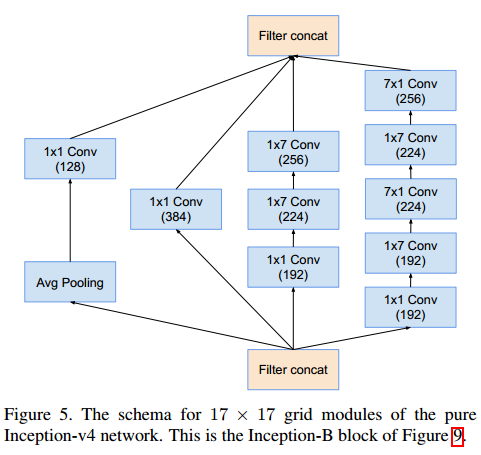

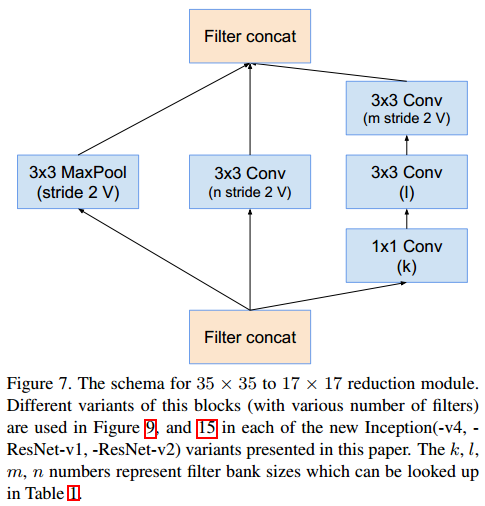

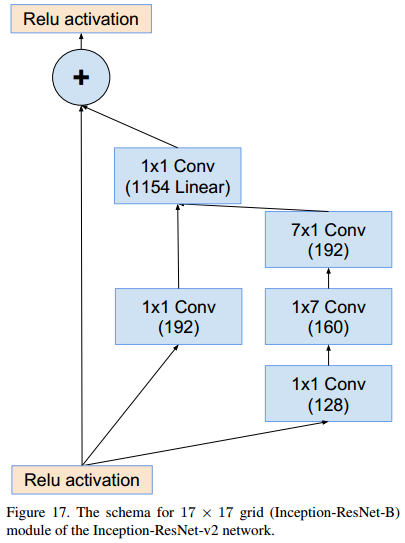

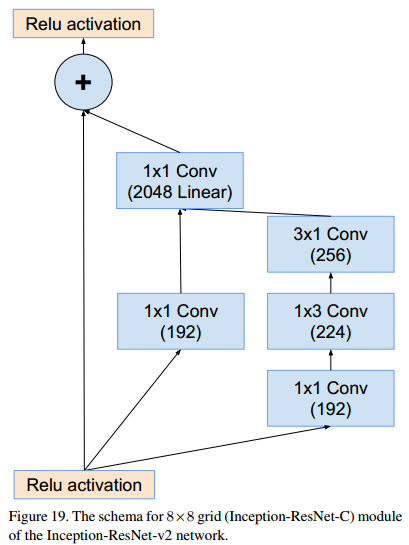

Inception v4

论文:《Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning》

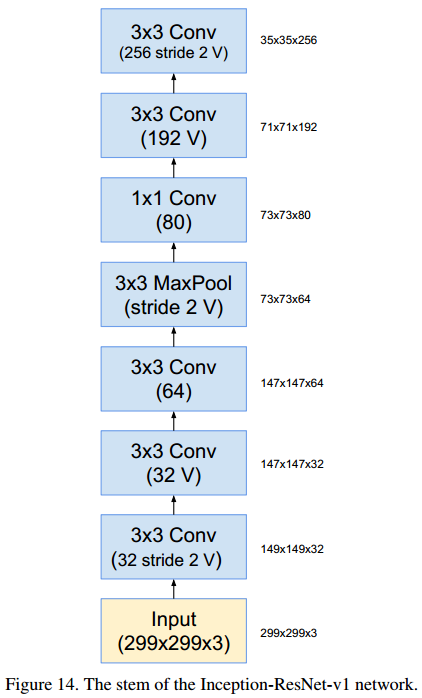

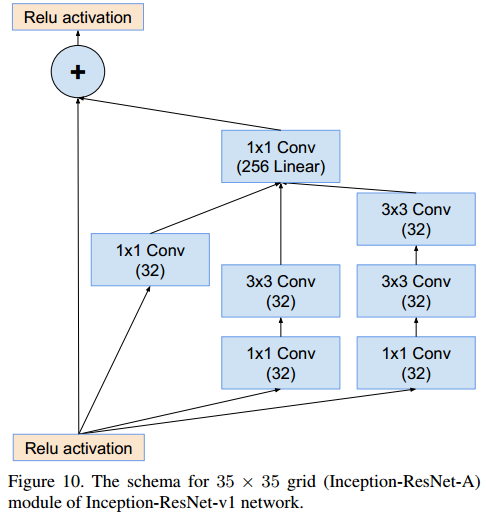

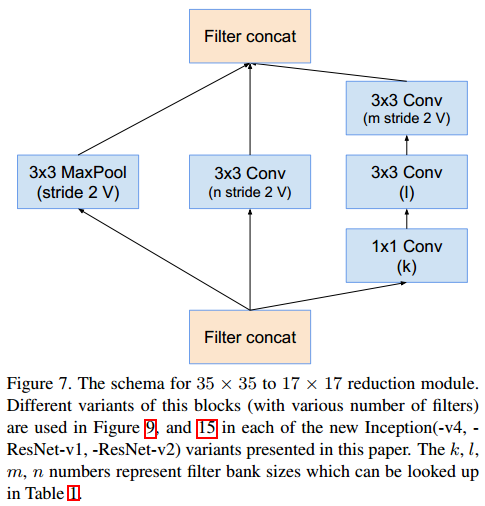

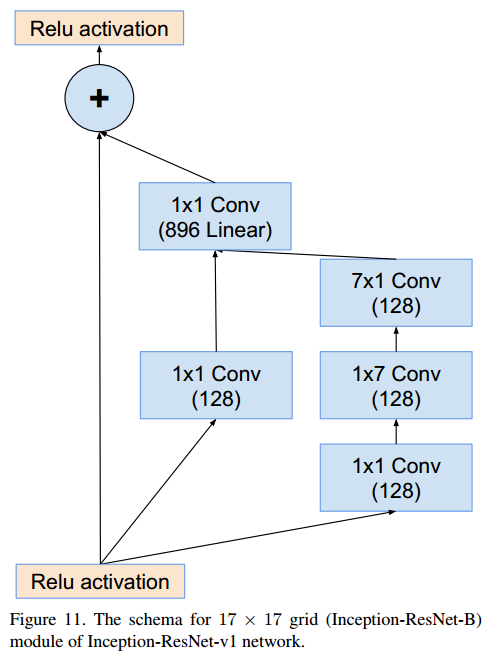

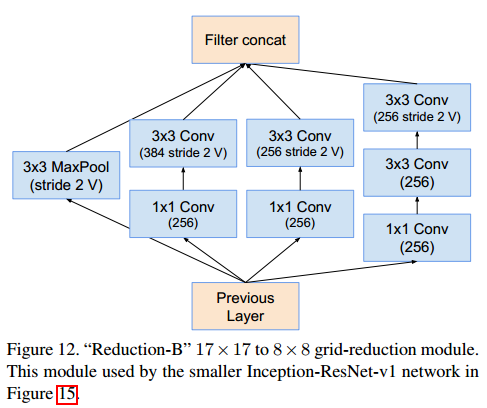

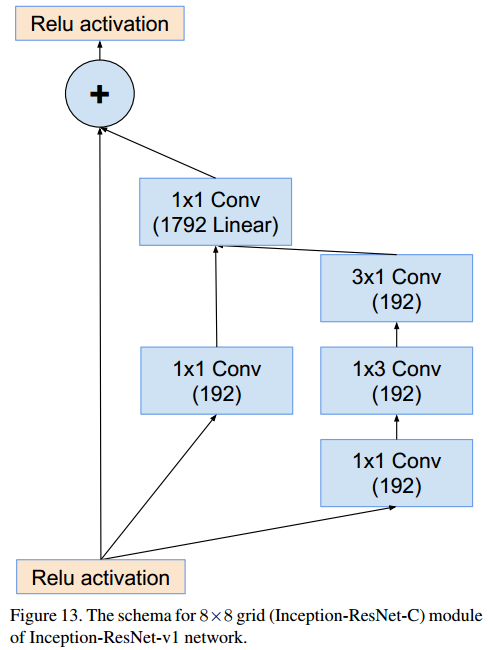

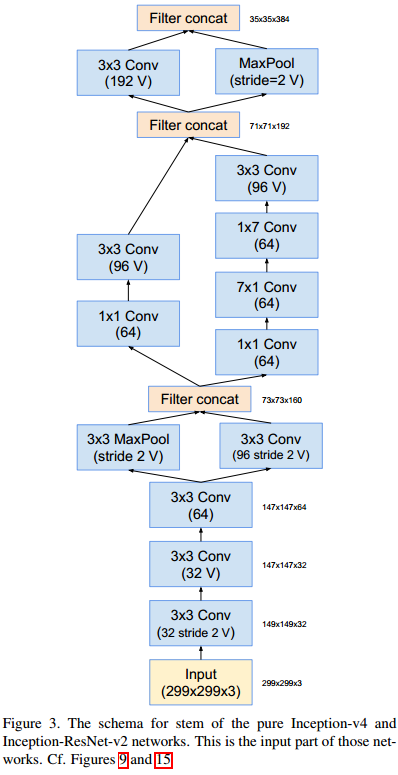

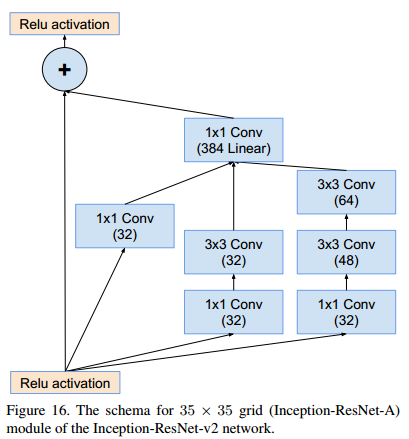

改论文提出了inception结合ResNet的网络模块。卷积网络参数中标V的,padding使用valid类型。由于论文提出的模块较多,在此方向模块结构,不做详细说明。

GoogLeNet结构的更多相关文章

- 【转】CNN卷积神经网络_ GoogLeNet 之 Inception(V1-V4)

http://blog.csdn.net/diamonjoy_zone/article/details/70576775 参考: 1. Inception[V1]: Going Deeper with ...

- alexnet,VGG,googlenet,resnet

非常好的一篇:https://my.oschina.net/u/876354/blog/1637819 alexnet和VGG没什么特别的,VGG深一些. Deep learning 实际上是一种 f ...

- 【CV论文阅读】Going deeper with convolutions(GoogLeNet)

目的: 提升深度神经网络的性能. 一般方法带来的问题: 增加网络的深度与宽度. 带来两个问题: (1)参数增加,数据不足的情况容易导致过拟合 (2)计算资源要求高,而且在训练过程中会使得很多参数趋向于 ...

- 论文阅读笔记三十一:YOLO 9000: Better,Faster,Stronger(CVPR2016)

论文源址:https://arxiv.org/abs/1612.08242 代码:https://github.com/longcw/yolo2-pytorch 摘要 本文提出YOLO9000可以检测 ...

- 论文笔记系列-Neural Architecture Search With Reinforcement Learning

摘要 神经网络在多个领域都取得了不错的成绩,但是神经网络的合理设计却是比较困难的.在本篇论文中,作者使用 递归网络去省城神经网络的模型描述,并且使用 增强学习训练RNN,以使得生成得到的模型在验证集上 ...

- 论文笔记:CNN经典结构1(AlexNet,ZFNet,OverFeat,VGG,GoogleNet,ResNet)

前言 本文主要介绍2012-2015年的一些经典CNN结构,从AlexNet,ZFNet,OverFeat到VGG,GoogleNetv1-v4,ResNetv1-v2. 在论文笔记:CNN经典结构2 ...

- #Deep Learning回顾#之LeNet、AlexNet、GoogLeNet、VGG、ResNet

CNN的发展史 上一篇回顾讲的是2006年Hinton他们的Science Paper,当时提到,2006年虽然Deep Learning的概念被提出来了,但是学术界的大家还是表示不服.当时有流传的段 ...

- GoogleNet tips

Inception Module googlenet的Inception Module Idea 1: Use 1x1, 3x3, and 5x5 convolutions in parallel t ...

- 解读(GoogLeNet)Going deeper with convolutions

(GoogLeNet)Going deeper with convolutions Inception结构 目前最直接提升DNN效果的方法是increasing their size,这里的size包 ...

随机推荐

- MyBtis之关于#{}和${}

1.${}的用法的mapper文件配置: </select> <select id="selById2" resultType="com.sus ...

- Python入门基础学习(面向对象)

Python基础学习笔记(四) 面向对象的三个基本特征: 封装:把客观事物抽象并封装成对象,即将属性,方法和事件等集合在一个整体内 继承:允许使用现有类的功能并在无须重新改写原来的类情况下,对这些功能 ...

- python使用beautifulsoup4爬取酷狗音乐

声明:本文仅为技术交流,请勿用于它处. 小编经常在网上听一些音乐但是有一些网站好多音乐都是付费下载的正好我会点爬虫技术,空闲时间写了一份,截止4月底没有问题的,会下载到当前目录,只要按照bs4库就好, ...

- TeamyinyinFish-凡事遇则立

小组github地址: https://github.com/TeamyinyinFish 1.项目的总结反思 阿尔法迭代的时候我们只是理想的随意的选择了一个项目并且认为非常简单. 在第二轮迭代的时候 ...

- idea tomcat debug不能启动的问题

显示:Connected to the target VM, address: '127.0.0.1:54692', transport: 'socket' 其实原因是没调整好面板.晕 ...

- LeetCode 1243 数组变换

地址 https://leetcode-cn.com/contest/biweekly-contest-12/problems/array-transformation/ 首先,给你一个初始数组 ar ...

- bzoj5092 分割序列

题目链接 problem 对于一个长度为n的非负整数序列\(b_1,b_2,...,b_n\),定义这个序列的能量为:\(f(b)=\max\limits_{i=0,1,...,n}(b_1 \oti ...

- 【洛谷5335】[THUSC2016] 补退选(指针实现Trie)

点此看题面 大致题意: 三种操作:加入一个字符串,删除一个字符串,求最早什么时候以某个字符串为前缀的字符串个数超过给定值. \(Trie\) 这道题显然是\(Trie\)的暴力裸题. 考虑我们对于\( ...

- Optical Flow 发展历程 (1)

Optical flow estimation Traditional Method Variational approach TVL-1 [1] Deep Method Supervised Flo ...

- 【STM32H7教程】第30章 STM32H7的USART应用之八个串口FIFO实现

完整教程下载地址:http://www.armbbs.cn/forum.php?mod=viewthread&tid=86980 第30章 STM32H7的USART应用之八个串口 ...