[Flink]Flink1.6三种运行模式安装部署以及实现WordCount

前言

Flink三种运行方式:Local、Standalone、On Yarn。成功部署后分别用Scala和Java实现wordcount

环境

版本:Flink 1.6.2

集群环境:Hadoop2.6

开发工具: IntelliJ IDEA

一.Local模式

解压:tar -zxvf flink-1.6.2-bin-hadoop26-scala_2.11.tgz

cd flink-1.6.2

启动:./bin/start-cluster.sh

停止:./bin/stop-cluster.sh

可以通过master:8081监控集群状态

二.Standalone模式

集群安装

1:修改conf/flink-conf.yaml

jobmanager.rpc.address: hadoop100

2:修改conf/slaves

hadoop101

hadoop102

3:拷贝到其他节点

scp -rq /usr/local/flink-1.6.2 hadoop101:/usr/local

scp -rq /usr/local/flink-1.6.2 hadoop102:/usr/local

4:在hadoop100(master)节点启动

bin/start-cluster.sh

5:访问http://hadoop100:8081

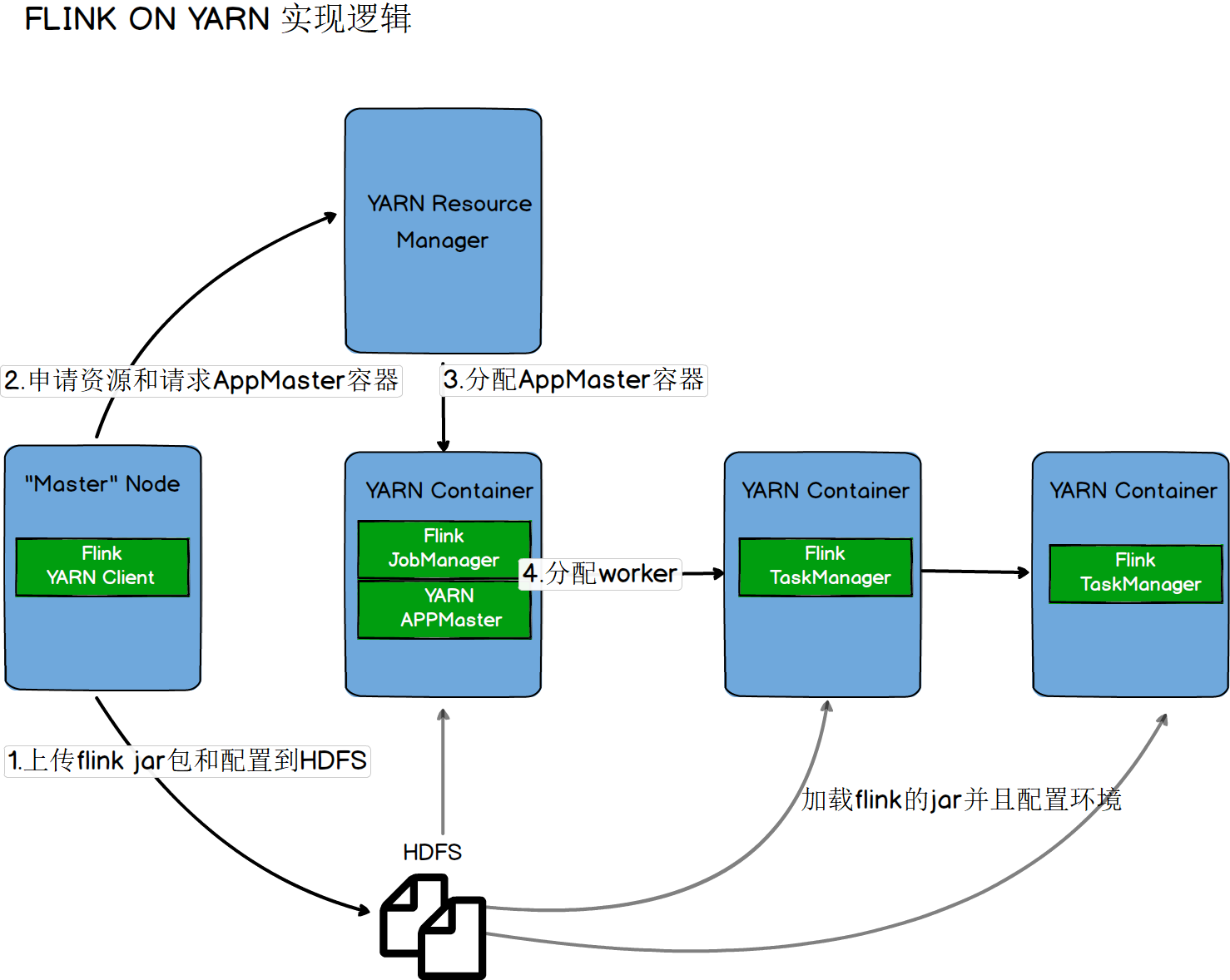

三.Flink On Yarn模式

On Yarn实现逻辑

##### 第一种【yarn-session.sh(开辟资源)+flink run(提交任务)】

启动一个一直运行的flink集群

./bin/yarn-session.sh -n 2 -jm 1024 -tm 1024 [-d]

附着到一个已存在的flink yarn session

./bin/yarn-session.sh -id application_1463870264508_0029

执行任务

./bin/flink run ./examples/batch/WordCount.jar -input hdfs://hadoop100:9000/LICENSE -output hdfs://hadoop100:9000/wordcount-result.txt

停止任务 【web界面或者命令行执行cancel命令】

##### 第二种【flink run -m yarn-cluster(开辟资源+提交任务)】

启动集群,执行任务

./bin/flink run -m yarn-cluster -yn 2 -yjm 1024 -ytm 1024 ./examples/batch/WordCount.jar

注意:client端必须要设置YARN_CONF_DIR或者HADOOP_CONF_DIR或者HADOOP_HOME环境变量,通过这个环境变量来读取YARN和HDFS的配置信息,否则启动会失败

四.WordCount

代码

Scala实现代码

package com.skyell

import org.apache.flink.api.java.utils.ParameterTool

import org.apache.flink.streaming.api.scala.StreamExecutionEnvironment

import org.apache.flink.streaming.api.windowing.time.Time

/**

* 滑动窗口计算

*

* 每隔1秒统计最近2秒数据,打印到控制台

*/

object SocketWindowWordCountScala {

def main(args: Array[String]): Unit = {

// 获取socket端口号

val port: Int = try{

ParameterTool.fromArgs(args).getInt("port")

}catch {

case e: Exception => {

System.err.println("No port set use default port 9002--scala")

}

9002

}

// 获取运行环境

val env: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment

// 连接socket获取数据

val text = env.socketTextStream("master", port, '\n')

//添加隐式转换,否则会报错

import org.apache.flink.api.scala._

// 解析数据(把数据打平),分组,窗口计算,并且聚合求sum

val windowCount = text.flatMap(line => line.split("\\s"))

.map(w => WordWithCount(w, 1))

.keyBy("word") // 针对相同word进行分组

.timeWindow(Time.seconds(2), Time.seconds(1))// 窗口时间函数

.sum("count")

windowCount.print().setParallelism(1) // 设置并行度为1

env.execute("Socket window count")

}

// case 定义的类可以直接调用,不用new

case class WordWithCount(word:String,count: Long)

}

Java实现代码

package com.skyell;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.java.DataSet;

import org.apache.flink.api.java.ExecutionEnvironment;

import org.apache.flink.api.java.operators.DataSource;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.util.Collector;

public class BatchWordCountJava {

public static void main(String[] args) throws Exception{

String inputPath = "D:\\DATA\\file";

String outPath = "D:\\DATA\\result";

// 获取运行环境

ExecutionEnvironment env = ExecutionEnvironment.getExecutionEnvironment();

// 读取本地文件中内容

DataSource<String> text = env.readTextFile(inputPath);

// groupBy(0):从0聚合 sum(1):以第二个字段加和计算

DataSet<Tuple2<String, Integer>> counts = text.flatMap(new Tokenizer()).groupBy(0).sum(1);

counts.writeAsCsv(outPath, "\n", " ").setParallelism(1);

env.execute("batch word count");

}

public static class Tokenizer implements FlatMapFunction<String, Tuple2<String,Integer>>{

public void flatMap(String value, Collector<Tuple2<String, Integer>> out) throws Exception {

String[] tokens = value.toLowerCase().split("\\W+");

for (String token: tokens

) {

if(token.length()>0){

out.collect(new Tuple2<String, Integer>(token, 1));

}

}

}

}

}

pom依赖配置

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>1.6.2</version>

<scope>provided</scope>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.11</artifactId>

<version>1.6.2</version>

<scope>provided</scope>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-scala_2.11</artifactId>

<version>1.6.2</version>

<scope>provided</scope>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-scala_2.11</artifactId>

<version>1.6.2</version>

<scope>provided</scope>

</dependency>

[Flink]Flink1.6三种运行模式安装部署以及实现WordCount的更多相关文章

- hadoop记录-[Flink]Flink三种运行模式安装部署以及实现WordCount(转载)

[Flink]Flink三种运行模式安装部署以及实现WordCount 前言 Flink三种运行方式:Local.Standalone.On Yarn.成功部署后分别用Scala和Java实现word ...

- ubuntu上Hadoop三种运行模式的部署

Hadoop集群支持三种运行模式:单机模式.伪分布式模式,全分布式模式,下面介绍下在Ubuntu下的部署 (1)单机模式 默认情况下,Hadoop被配置成一个以非分布式模式运行的独立JAVA进程,适合 ...

- Tomcat Connector的三种运行模式

详情参考: http://tomcat.apache.org/tomcat-7.0-doc/apr.html http://www.365mini.com/page/tomcat-connector- ...

- 【Tomcat】Tomcat Connector的三种运行模式【bio、nio、apr】

Tomcat Connector(Tomcat连接器)有bio.nio.apr三种运行模式 bio bio(blocking I/O,阻塞式I/O操作),表示Tomcat使用的是传统的Java I/O ...

- PHP语言学习之php-fpm 三种运行模式

本文主要向大家介绍了PHP语言学习之php-fpm 三种运行模式,通过具体的内容向大家展示,希望对大家学习php语言有所帮助. php-fpm配置 配置文件:php-fpm.conf 开启慢日志功能的 ...

- Tomcat Connector三种运行模式(BIO, NIO, APR)的比较和优化

Tomcat Connector的三种不同的运行模式性能相差很大,有人测试过的结果如下: 这三种模式的不同之处如下: BIO: 一个线程处理一个请求.缺点:并发量高时,线程数较多,浪费资源. Tomc ...

- Tomcat Connector(BIO, NIO, APR)三种运行模式(转)

Tomcat支持三种接收请求的处理方式:BIO.NIO.APR . BIO 阻塞式I/O操作即使用的是传统 I/O操作,Tomcat7以下版本默认情况下是以BIO模式运行的,由于每个请求都要创建一个线 ...

- php-fpm 三种运行模式

php-fpm配置 配置文件:php-fpm.conf 开启慢日志功能的: slowlog = /usr/local/var/log/php-fpm.log.slowrequest_slowlog_t ...

- python编程(python开发的三种运行模式)【转】

转自:http://blog.csdn.net/feixiaoxing/article/details/53980886 版权声明:本文为博主原创文章,未经博主允许不得转载. 目录(?)[-] 单循环 ...

随机推荐

- 运算符 字符串 for循环

1. 运算符 1.1赋值运算符 = += -= *= /= //= %= **= 1.2比较运算符 < > = <= == != 1.3成员运算符 in not in 1.4逻辑运算 ...

- 你应该知道的简单易用的CSS技巧

作为前端,在工作中难免会遇到关于排版的问题,以下是我整理的一些关于CSS的技巧,希望对你能有帮助. 1.每个单词的首字母大写 一般我们会用JS实现,其实CSS就可以实现. JS代码: var str ...

- Android资源管理利器Resources和AssetManager

前言 : Android工程在运行的时候往往需要引用资源.使用 Resources 来获取 res 目录下的各种与设备相关的资源.而使用 AssetManager 来获取 assets 目录下的资源 ...

- git分支概念与项目中的应用

文档:https://git-scm.com/book/zh/v2/Git-%E5%88%86%E6%94%AF-%E5%88%86%E6%94%AF%E7%AE%80%E4%BB%8B 分支理解 m ...

- 基于.NET环境,C#语言 实现 TCP NAT

基于.NET平台和C#语言实现TCP NAT穿越 1.<C# WinForm 跨线程访问控件(实用简洁写法)> 2.<基于.NET环境,C#语言 实现 TC ...

- Apache Kylin 概述

1 Kylin是什么 今天,随着移动互联网.物联网.AI等技术的快速兴起,数据成为了所有这些技术背后最重要,也是最有价值的"资产".如何从数据中获得有价值的信息?这个问题驱动了相关 ...

- 在Mac上搭建带ssl协议和域名指向的Apache服务器

顾名思义,就是要在苹果电脑上搭建 Apache 服务器,并且支持 https 协议,能用指定域名访问(有些开发调试需要注册域名,比如调试微信JS-SDK),当然最好能在手机端进行调试.首先,Mac 系 ...

- Java 添加、修改、读取、删除PPT备注

概述 幻灯片中的备注信息是只提供给幻灯片演讲者观看的特定内容,在演讲者放映幻灯片时,备注信息可给演讲者提供讲解思路,起到辅助讲解的作用.本文将通过Java程序来演示如何操作PPT幻灯片中的备注信息,要 ...

- bugku 程序员本地网站

提示从本地访问,怎样让服务器认为你是从本地进行访问的: 使用burp抓包并在包中进行修改加入X-Forwarded-For: 127.0.0.1 X-Forwarded-For: 简称XFF头,它代表 ...

- 蓝牙TWS耳机IBRT的原理初分析

最近在倒腾TWS对耳的一些东西,看到一些源码,发现一个新概念,IBRT没有搞清楚,抱着吾将上下而求索的态度,详细看了一些代码,查了一些资料,还是发现了不少有价值的信息的.至少,我突然感觉自己懂了一些什 ...