caffe层解读-softmax_loss

转自https://blog.csdn.net/shuzfan/article/details/51460895。

Loss Function

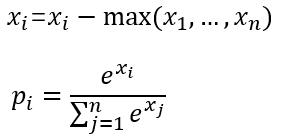

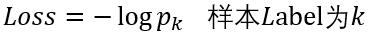

softmax_loss的计算包含2步:

(1)计算softmax归一化概率

(2)计算损失

这里以batchsize=1的2分类为例:

设最后一层的输出为[1.2 0.8],减去最大值后为[0 -0.4],

然后计算归一化概率得到[0.5987 0.4013],

假如该图片的label为1,则Loss=-log0.4013=0.9130

可选参数

(1) ignore_label

int型变量,默认为空。

如果指定值,则label等于ignore_label的样本将不参与Loss计算,并且反向传播时梯度直接置0.

(2) normalize

bool型变量,即Loss会除以参与计算的样本总数;否则Loss等于直接求和

(3) normalization

enum型变量,默认为VALID,具体代表情况如下面的代码。

enum NormalizationMode {

// Divide by the number of examples in the batch times spatial dimensions.

// Outputs that receive the ignore label will NOT be ignored in computing the normalization factor.

FULL = ;

// Divide by the total number of output locations that do not take the

// ignore_label. If ignore_label is not set, this behaves like FULL.

VALID = ;

// Divide by the batch size.

BATCH_SIZE = ;

//

NONE = ;

}

归一化case的判断:

(1) 如果未设置normalization,但是设置了normalize。

则有normalize==1 -> 归一化方式为VALID

normalize==0 -> 归一化方式为BATCH_SIZE

(2) 一旦设置normalization,归一化方式则由normalization决定,不再考虑normalize。

使用方法

layer {

name: "loss"

type: "SoftmaxWithLoss"

bottom: "fc1"

bottom: "label"

top: "loss"

top: "prob"

loss_param{

ignore_label:

normalize:

normalization: FULL

}

}

扩展使用

(1) 如上面的使用方法中所示,softmax_loss可以有2个输出,第二个输出为归一化后的softmax概率

(2) 最常见的情况是,一个样本对应一个标量label,但softmax_loss支持更高维度的label。

当bottom[0]的输入维度为N*C*H*W时,

其中N为一个batch中的样本数量,C为channel通常等于分类数,H*W为feature_map的大小通常它们等于1.

此时我们的一个样本对应的label不再是一个标量了,而应该是一个长度为H*W的矢量,里面的数值范围为0——C-1之间的整数。

至于之后的Loss计算,则采用相同的处理。

caffe层解读-softmax_loss的更多相关文章

- caffe层解读系列-softmax_loss

转自:http://blog.csdn.net/shuzfan/article/details/51460895 Loss Function softmax_loss的计算包含2步: (1)计算sof ...

- 【Android】Sensor框架Framework层解读

Sensor整体架构 整体架构说明 黄色部分表示硬件,它要挂在I2C总线上 红色部分表示驱动,驱动注册到Kernel的Input Subsystem上,然后通过Event Device把Sensor数 ...

- proposal_layer.py层解读

proposal_layer层是利用训练好的rpn网络来生成region proposal供fast rcnn使用. proposal_layer整个处理过程:1.生成所有的anchor,对ancho ...

- anchor_target_layer层解读

总结下来,用generate_anchors产生多种坐标变换,这种坐标变换由scale和ratio来,相当于提前计算好.anchor_target_layer先计算的是从feature map映射到原 ...

- caffe dropout解读

先上caffe dropout_layer.cpp源码,如下: // LayerSetUp DCHECK(threshold_ > 0.); DCHECK(threshold_ < 1.) ...

- 【Android】Sensor框架HAL层解读

Android sensor构建 Android4.1 系统内置对传感器的支持达13种,他们分别是:加速度传感器(accelerometer).磁力传感器(magnetic field).方向传感器( ...

- 修改caffe层的一般流程

https://blog.csdn.net/u012273127/article/details/78701161

- slover层解读

void Solver<Dtype>::UpdateSmoothedLoss(Dtype loss, int start_iter, int average_loss) { if (los ...

- caffe︱ImageData层、DummyData层作为原始数据导入的应用

Part1:caffe的ImageData层 ImageData是一个图像输入层,该层的好处是,直接输入原始图像信息就可以导入分析. 在案例中利用ImageData层进行数据转化,得到了一批数据. 但 ...

随机推荐

- mac 下的 tree 命令 终端展示你的目录树结构

相信很多使用过Linux的用户都用过tree命令,它可以像windows的文件管理器一样清楚明了的显示目录结构.mac 下使用 brew包管理工具安装 tree 前提:安装了homebrew(安装指令 ...

- OpenFOAM计算结果转换到CFD-Post当中处理

我们编写如下的Python代码 源代码:

- cnetos7 搭建wordpress(apache+php+mariadb)

.安装apache.php.php库 yum -y install httpd php php-mbstring php-pear 2.修改php配置文件地区 vim /etc/php.ini 在87 ...

- sqlite3 读写锁

转载:https://blog.csdn.net/u012218838/article/details/79362929(sqlite3 使用读写锁SRWLOCK例子) 转载:https://my.o ...

- linux环境,无dig命令-bash: dig: command not found?

背景描述: 今天使用dig命令,报错命令不存在,-bash: dig: command not found 解决: 通过yum方式安装 yum -y install bind-utils 备注:之前尝 ...

- Python高级笔记(十)闭包

1. 闭包 #!/usr/bin/python # -*- encoding=utf- -*- def test(number): # 在函数里面再定义一个函数,并且这个函数用到外边函数的变量,那么将 ...

- 【docker】 yaml.scanner.ScannerError: mapping values are not allowed here in "./docker-compose.yml", line 60, column 35

在启动docker-compose 时候 报错了 命令: docker-compose up -d && docker-compose logs -f 错误代码: 解决 出现这个错误的 ...

- Laya的版本管理

参考: Laya项目发布详解 发布时,勾选开启版本管理 点击上图“是否开启版本管理”右边的+号. 可以选择加入版本管理,或者排除版本管理的文件夹. 比如我要排除bin/test这个文件夹下的文件,不使 ...

- postgrelsql 的 wm_concat : string_agg

string_agg,array_agg 这两个函数的功能大同小异,只不过合并数据的类型不同 array_agg(expression) 把表达式变成一个数组 一般配合 array_to_string ...

- [LeetCode] 131. Palindrome Partitioning 回文分割

Given a string s, partition s such that every substring of the partition is a palindrome. Return all ...