elasticsearch ik中文分词器安装

特殊说明:灰色文字用来辅助理解的。

安装IK中文分词器

我在百度上搜索了下,大多介绍的都是用maven打包下载下来的源码,这种方法也行,但是不够方便,为什么这么说?

首先需要安装maven吧?其次需要下载源码吧?最后需要打包吧?

我直接下载打包好的多方便?

1、下载打包好的压缩包

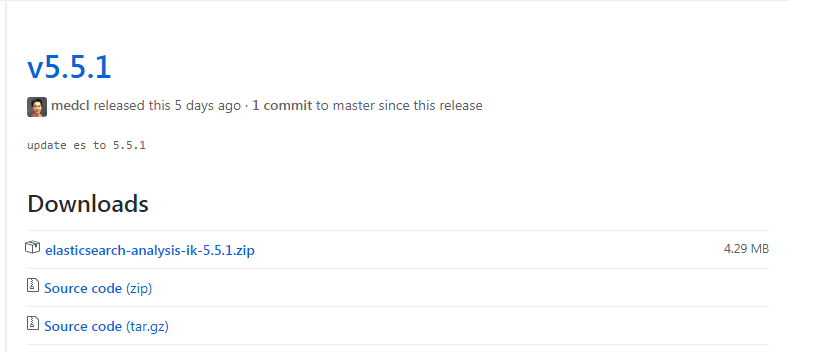

我们需要下载打包好的压缩包,而不是下载需要再用maven打包的源码。举例说明,最新版本是v5.5.1。

下载地址:https://github.com/medcl/elasticsearch-analysis-ik/releases

最上面elasticsearch-analysis-ik-5.5.1.zip就是打包好的,直接下载下来用就行了。

另外需要注意ik的版本需要和你的elasticsearch保持一致。我的是5.2.2的。

上图中下面两个都是源码,如果下载的是源码,仅使用maven打包过程就花了15分钟,时间就是金钱啊。

打包完后,会有提示,告诉你打包在了哪个位置:

[INFO] Building zip: /usr/local/elasticsearch/plugins/ik/target/releases/elasticsearch-analysis-ik-5.2.2.zip

[INFO] ------------------------------------------------------------------------

[INFO] BUILD SUCCESS

[INFO] ------------------------------------------------------------------------

[INFO] Total time: 14:41 min

[INFO] Finished at: 2017-08-06T00:00:35+08:00

[INFO] Final Memory: 29M/91M

[INFO] ------------------------------------------------------------------------

我们可以把打包好的文件保存下来,以后别的机器要用,直接拷贝过去就可以了

2、将下载下来的压缩包,拷贝到centos,并解压在elasticsearch的plugins插件目录下即可

压缩包我是放在/soft目录下的,elasticsearch的安装目录是/usr/local/elasticsearch

[root@localhost soft]# unzip -d /usr/local/elasticsearch/plugins/ik /soft/elasticsearch-analysis-ik-5.2.2.zip

3、重启elasticsearch

在日志里你应该可以看到加载分词字典的日志信息,表示安装成功。

elasticsearch ik中文分词器安装的更多相关文章

- elasticsearch ik中文分词器的安装配置使用

安装步骤 https://github.com/medcl/elasticsearch-analysis-ik 以插件形式安装: [elsearch@localhost elasticsearch- ...

- elasticsearch ik中文分词器的使用详解

(基于es5.4)先喵几眼github,按照步骤安装好分词器 link:https://github.com/medcl/elasticsearch-analysis-ik 复习一下常用的操作 .查看 ...

- 搜索引擎ElasticSearch系列(五): ElasticSearch2.4.4 IK中文分词器插件安装

一:IK分词器简介 IK Analyzer是一个开源的,基于java语言开发的轻量级的中文分词工具包.从2006年12月推出1.0版开始, IKAnalyzer已经推出了4个大版本.最初,它是以开源 ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十九)ES6.2.2 安装Ik中文分词器

注: elasticsearch 版本6.2.2 1)集群模式,则每个节点都需要安装ik分词,安装插件完毕后需要重启服务,创建mapping前如果有机器未安装分词,则可能该索引可能为RED,需要删除后 ...

- 沉淀再出发:ElasticSearch的中文分词器ik

沉淀再出发:ElasticSearch的中文分词器ik 一.前言 为什么要在elasticsearch中要使用ik这样的中文分词呢,那是因为es提供的分词是英文分词,对于中文的分词就做的非常不好了 ...

- 30.IK中文分词器的安装和简单使用

在之前我们学的都是英文,用的也是英文的standard分词器.从这一节开始,学习中文分词器.中国人基本上都是中文应用,很少是英文的,而standard分词器是没有办法对中文进行合理分词的,只是将每个中 ...

- ElasticSearch的中文分词器ik

一.前言 为什么要在elasticsearch中要使用ik这样的中文分词呢,那是因为es提供的分词是英文分词,对于中文的分词就做的非常不好了,因此我们需要一个中文分词器来用于搜索和使用. 二.IK ...

- elasticsearch使用ik中文分词器

elasticsearch使用ik中文分词器 一.背景 二.安装 ik 分词器 1.从 github 上找到和本次 es 版本匹配上的 分词器 2.使用 es 自带的插件管理 elasticsearc ...

- Elasticsearch:IK中文分词器

Elasticsearch内置的分词器对中文不友好,只会一个字一个字的分,无法形成词语,比如: POST /_analyze { "text": "我爱北京天安门&quo ...

随机推荐

- Django BoundField

一.BoundField from django.forms.boundfield import BoundField BoundField是一个将字段添加数据的一个类,给对应的form字段封装上数据 ...

- Python subprocess- call、check_call、check_output

简介 subprocess模块用来创建新的进程,连接到其stdin.stdout.stderr管道并获取它们的返回码.subprocess模块的出现是为了替代如下旧模块及函数:os.system.os ...

- Spring 事务管理基础知识点

参考文章 spring事物配置,声明式事务管理和基于@Transactional注解的使用 尚硅谷 佟刚 Spring视频教程PPT Spring支持编程式事务管理和声明式事务管理两种方式 编程式事务 ...

- 20165333 2016-2017-2 《Java程序设计》第1周学习总结

20165333 2016-2017-2 <Java程序设计>第1周学习总结 教材学习内容总结 java 的地位 Java 的特点 安装JDK 系统环境的设置 Java程序的编写,编译和运 ...

- 《精通Python设计模式》学习行为型之责任链模式

感觉是全新的学习了. 因为在以前的工作中,并没有有意识的去运用哪一种编程模式. 以后要注意的了. 这才是高手之路呀~ class Event: def __init__(self, name): se ...

- MySQL下concat函数中null值问题

在mysql中,使用CONCAT(str1,str2,...)函数拼接字符串的过程中,如果你拼接的字段当中有值为null,那么拼接的结果就为null 注: select CONCAT(字段1,字段2) ...

- bzoj 2819

2819 思路: 手工栈: 代码: #include <bits/stdc++.h> using namespace std; #define maxn 500005 #define ma ...

- 推荐 远程部署 fabric

自己写的一个例子: from fabric.api import run, env env.hosts = ['nanjing','hefei','haerbin','lanzhou','taiyua ...

- 【LOJ】#2123. 「HEOI2015」最短不公共子串

题解 我们对于B串建出后缀自动机和序列自动机 对于问题1,枚举左端点然后跑后缀自动机,直到不能匹配作为这个左端点的答案 对于问题2,枚举左端点然后跑序列自动机,直到不能匹配 对于问题3,设f[i][j ...

- USACO 5.2 Snail Trails

Snail TrailsAll Ireland Contest Sally Snail likes to stroll on a N x N square grid (1 <n <= 12 ...