loj6171/bzoj4899 记忆的轮廊(期望dp+优化)

题目:

分析:

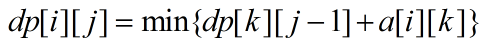

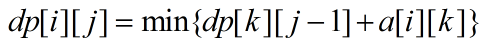

设dp[i][j]表示从第i个点出发(正确节点),还可以有j个存档点(在i点使用一个存档机会),走到终点n的期望步数

那么

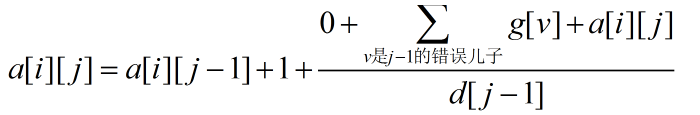

a[i][k]表示i点为存档点,从i点走到k点(正确节点)的期望步数(中间没有其它存档点)

那么a[i][j]可以递推预处理出

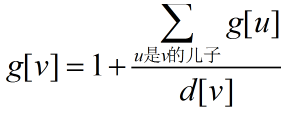

其中g[v]表示从一个错误节点v开始走,期望走g[v]步会读档

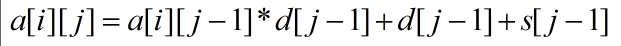

解方程可以解出

s[j-1]就是点j-1出去的所有错误儿子的g[v]之和

那么接下来只要知道如何求g[v]就行了

这个直接dfs一遍就行了

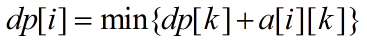

好,那么现在我们的主dp就可以求解了

但是直接dp的复杂度是O(n^2p)的,这样会TLE

方法一:

注意到这个dp的本质是把一个序列给分成p段,那么其中某一段会不会很长呢?

我们会发现a的增长是非常快的,而最终的答案不会很大,所以也就是说当前的i的最优转移j,不会离i太远

所以通过计算可以发现这个距离step<=40

所以时间复杂度O(40n^2)

方法二:

考虑dp优化的惯用套路

容易得出此dp是决策单调的,也就是f(i)<=f(i+1)

那么就可以决策单调优化O(nplogn)

具体的就维护一个队列,队列里每个元素存着[l,r,p]表示区间l~r,当前最优决策是p

每次从队头取出最优策略,将此次新的决策从队尾开始放入并合并区间

dp[][n]=0.0;

for(int now=;now<=number;++now)

{

int head=,tail=;

q[]={,n-,n};

for(int i=n-;i>=;--i)

{

while(head<tail&&q[head].l>i) ++head;

dp[now][i]=cal(now-,i,q[head].p);

while(head<tail&&cal(now-,q[tail].r,i)<cal(now-,q[tail].r,q[tail].p)) --tail;

int position=find(now,q[tail].l,q[tail].r,i,q[tail].p);

if(position)

{

q[tail+]={,position,i};

q[tail].l=position+;

if(q[tail].l>q[tail].r) ++head;

++tail;

}

}

}

方法三:

一个很神奇的二分套路(详见王钦石《浅析一类二分方法》)

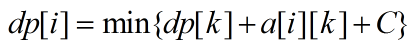

这是一个限制段数的dp,我们把它写成不限制段数的情况

然后我们去二分一个常数C,使得式子变成这样

这里的C表示每次重新开一段所需要的代价

很明显,C越大,最优情况下分的段数就越少,C越小,最优情况下分的段数就越多

所以我们可以二分C,对于每个C,进行dp

通过n->pre[n]->pre[pre[n]]->...->1,我们可以知道存了多少次档,当存档数恰好等于p的时候,此时对应的划分方案就是读档p次时候的最优解,就是将dp的最优值减去C*p

但是有个trick,王钦石论文里也提到了

就是可能当前eps下,并没有哪个C会使得我恰好读了p次档,即某个C情况下,我读了p-1次档,在C-eps情况下,我读了p+1次档,就是没有读p次档

这时候有个结论就是C-eps时,我读p+1次档这个情况下也必定有我读p次档的解,此时原本答案是dp-(p+1)*C,现在这样改成读p次档之后,答案就是dp-p*C

这样复杂度是O(n^2logA)

当然这里的dp可以优化,但不过预处理的时候O(n^2)是跑不掉的,所以再优化也不会低于O(n^2)的复杂度

int minnum=m+;

while (l+eps<=r)

{

long double mid=(l+r)/;

int num=check(mid);

long double sum=;

for(int now=n;now!=;now=pre[now]) sum+=w[pre[now]][now];

if (num<=p)

{

if (num==p)

{

ans=sum;

break;

};

r=mid-eps;

}

else

{

if(num<=minnum)

{

ans=sum+(num-p)*mid;

minnum=num;

}

l=mid+eps;

}

}

loj6171/bzoj4899 记忆的轮廊(期望dp+优化)的更多相关文章

- [BZOJ4899]:记忆的轮廓(概率DP)

题目传送门 题目描述: 通往贤者之塔的路上,有许多的危机. 我们可以把这个地形看做是一颗树,根节点编号为1,目标节点编号为n,其中1-n的简单路径上,编号依次递增, 在[1,n]中,一共有n个节点.我 ...

- 【BZOJ】1415 [Noi2005]聪聪和可可 期望DP+记忆化搜索

[题意]给定无向图,聪聪和可可各自位于一点,可可每单位时间随机向周围走一步或停留,聪聪每单位时间追两步(先走),问追到可可的期望时间.n<=1000. [算法]期望DP+记忆化搜索 [题解]首先 ...

- 【bzoj1415】【聪聪和可可】期望dp(记忆化搜索)+最短路

[pixiv] https://www.pixiv.net/member_illust.php?mode=medium&illust_id=57148470 Descrition 首先很明显是 ...

- 【CodeM初赛B轮】F 期望DP

[CodeM初赛B轮]F 题目大意:有n个景点,m条无向边,经过每条边的时间需要的时间是li,在第i个景点游览花费的时间是ti,游览完第i个景点可以获得的满意度是hi.你的总时间为k,起初你等概率的选 ...

- bzoj 1415: [Noi2005]聪聪和可可 期望dp+记忆化搜索

期望dp水题~ 你发现每一次肯定是贪心走 2 步,(只走一步的话就可能出现环) 然后令 $f[i][j]$ 表示聪在 $i$,可在 $j$,且聪先手两个人碰上面的期望最小次数. 用记忆化搜索转移就行了 ...

- 洛谷4206/NOI2005T4 聪聪和可可 期望DP+记忆化搜索

题意:给出n个点m条边的无向图,两个主角聪聪和可可开始分别在S点和T点.聪聪想吃掉可可,每次由匆匆先行动后来可可行动.聪聪的行动是选他到可可的最短路上的点走最多两步(如果最短路有几条就选编号最小的走) ...

- 【BZOJ-4008】亚瑟王 概率与期望 + DP

4008: [HNOI2015]亚瑟王 Time Limit: 20 Sec Memory Limit: 512 MBSec Special JudgeSubmit: 832 Solved: 5 ...

- 【期望DP】

[总览] [期望dp] 求解达到某一目标的期望花费:因为最终的花费无从知晓(不可能从$\infty$推起),所以期望dp需要倒序求解. 设$f[i][j]$表示在$(i, j)$这个状态实现目标的期望 ...

- [SCOI2008]奖励关(期望dp)

你正在玩你最喜欢的电子游戏,并且刚刚进入一个奖励关.在这个奖励关里,系统将依次随机抛出k次宝物,每次你都可以选择吃或者不吃(必须在抛出下一个宝物之前做出选择,且现在决定不吃的宝物以后也不能再吃). 宝 ...

随机推荐

- selective_search_rcnn.m中代码

im = imresize(im, [NaN im_width]):把图像转换为宽度为im_width,自动计算列数

- 使用Spring AOP切面解决数据库读写分离

http://blog.jobbole.com/103496/ 为了减轻数据库的压力,一般会使用数据库主从(master/slave)的方式,但是这种方式会给应用程序带来一定的麻烦,比如说,应用程序如 ...

- OpenCV2:总结篇 工具方法函数

一.简介 OpenCV提供了一些工具方法函数来辅助完成图像运算 二.时间相关 1.getTickCount()和getTickFrequency() double tTime; tTime = (do ...

- 定位 absolute和relative比较

absolute:脱离原来位置定位.是相对于最近的有定位的父级进行定位;如果没有有定位的父级元素,就相对文档进行定位 relative:保留原来位置进行定位,相对于自己原来的位置进行定位 下面举两个例 ...

- mysql系列安装

Mysql的5种安装方法:1.yum/rpm安装(适合要求不高,并发不大,公司内部,企业内部一些应用场景)2.编译安装(在线高并发业务)3.二进制安装(编译安装后,使用自带工具打包,然后拷贝到相同平台 ...

- JS应用之正则表达式

定义 正则表达式是用于匹配字符串中字符组合的模式. 创建正则表达式 两种方式: 1.new RegExp() let pattern1 = new RegExp('cat'); //第一个参数字符串 ...

- ARM Linux 3.x的设备树(Device Tree)(转)

http://blog.csdn.net/21cnbao/article/details/8457546

- pandas.read_csv 报ssl.SSLError

- java线程总结--synchronized关键字,原理以及相关的锁

在多线程编程中,synchronized关键字非常常见,当我们需要进行“同步”操作时,我们很多时候需要该该关键字对代码块或者方法进行锁定.被synchronized锁定的代码块,只能同时有一条线程访问 ...

- solr中的Tokenizer Filter

Tokenizer Tokenizer 的工作是将文本流分解为令牌,其中每个令牌(通常)是文本中字符的子序列.分析器知道它配置的字段,但 tokenizer 不是.Tokenizers 从字符流(Re ...