Scaled Exponential Linear Unit

https://www.bilibili.com/video/av9770302/?p=11

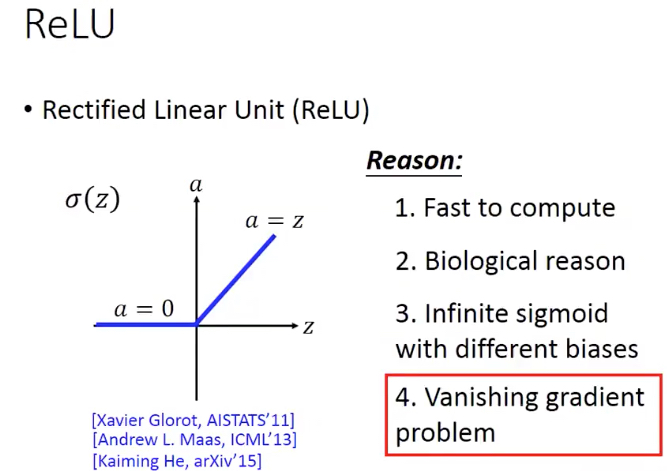

Relu

Leaky Relu

Parametric Relu就是把leaky部分的斜率学出来,而不是指定

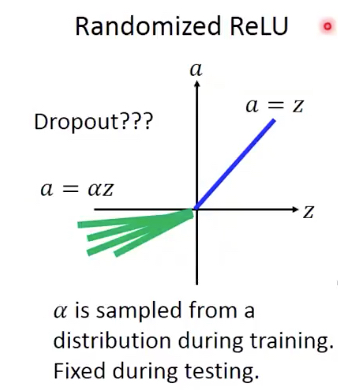

还有一种变体是,Randomized Relu,就是说这个斜率是每次随机的

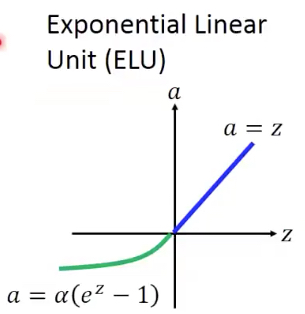

Exponential Linear Unit (ELU)

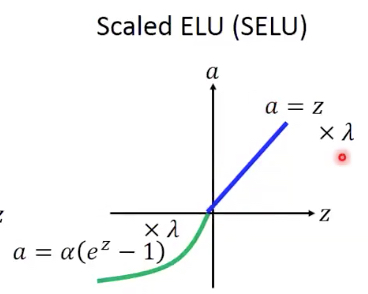

Scaled ELU

Scaled就是都乘上一个lamda

并且这里给出了alpha和lamda的取值,

这个是推导出来的

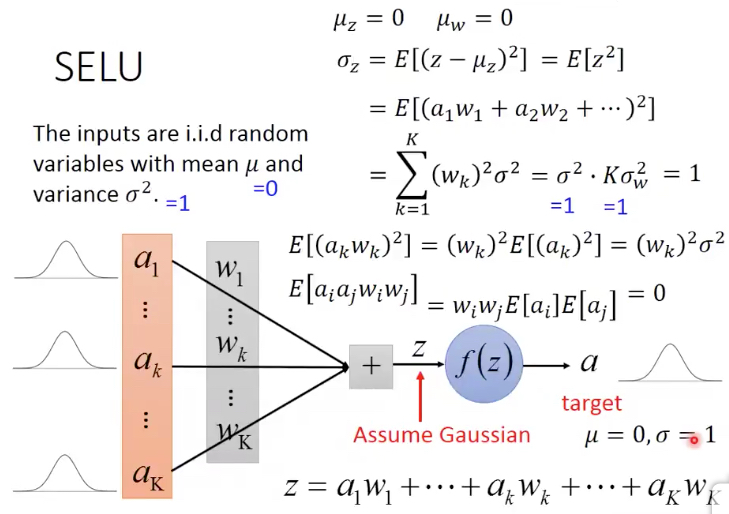

这里如果我们假设所有输入的a的分布为,mean=0, variance=1

所有参数w的分为也是,mean=0, variance=1/K (这个取值上面算出来的,为了保证z的variance为1)

就能得到z的分布也符合mean=0,variance=1

虽然这里对于a1...aK的分布没有假设,但是我们可以假设z的分布式是符合高斯分布的,根据中心极限定理

现在的问题是对于z经过SELU得到a,如果还要保证mean=0,variance=1,求alpha,lamda参数,求出来的值就是上面给出的

看这个推导有两个用处,

1. 知道使用Selu的前提假设,是有假设的,视频里面demo,在不满足假设的情况下,Selu没效果的

假设就是输入和参数的初始化必须要满足前面的分布假设

这里参数的初始化可以用lecun_normal,虽然参数后面会不断调整,但初始化还是很关键

2. 可以看出SELU让输出的分布满足mean=0, variance=1,这就可以达到BathNormalization的效果

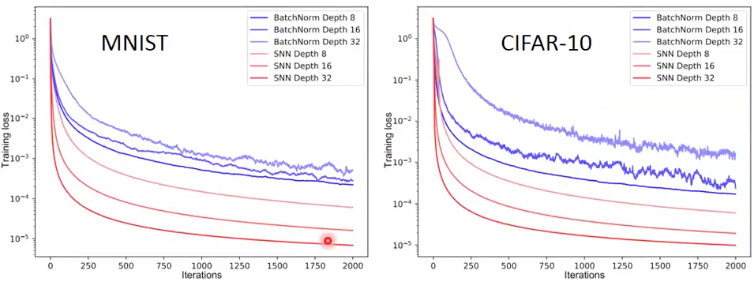

可以看到作者的比较,SELU NN比用BatchNorm的效果要好,loss更低,而且也更平滑

因为BatchNorm,每次是用batch的mean和var,所以用局部代表全局,会有波动,因为每个batch可能有较大的差异

Scaled Exponential Linear Unit的更多相关文章

- 修正线性单元(Rectified linear unit,ReLU)

修正线性单元(Rectified linear unit,ReLU) Rectified linear unit 在神经网络中,常用到的激活函数有sigmoid函数f(x)=11+exp(−x).双曲 ...

- Deep Learning基础--26种神经网络激活函数可视化

在神经网络中,激活函数决定来自给定输入集的节点的输出,其中非线性激活函数允许网络复制复杂的非线性行为.正如绝大多数神经网络借助某种形式的梯度下降进行优化,激活函数需要是可微分(或者至少是几乎完全可微分 ...

- 基于C#的机器学习--微基准测试和激活功能

本章我们将学习以下内容: l 什么是微基准测试 l 如何将它应用到代码中 l 什么是激活函数 l 如何绘制和基准测试激活函数 每个开发人员都需要有一个好的基准测试工具.质量基准无处不在;你们每 ...

- Batch Norm、Layer Norm、Weight Norm与SELU

加速网络收敛——BN.LN.WN与selu 自Batch Norm出现之后,Layer Norm和Weight Norm作为Batch Norm的变体相继出现.最近又出来一个很”简单”的激活函数Sel ...

- 大规模视觉识别挑战赛ILSVRC2015各团队结果和方法 Large Scale Visual Recognition Challenge 2015

Large Scale Visual Recognition Challenge 2015 (ILSVRC2015) Legend: Yellow background = winner in thi ...

- [Deep Learning] 常用的Active functions & Optimizers

深度学习的基本原理是基于人工神经网络,输入信号经过非线性的active function,传入到下一层神经元:再经过下一层神经元的activate,继续往下传递,如此循环往复,直到输出层.正是因为这些 ...

- 激活函数(ReLU, Swish, Maxout)

神经网络中使用激活函数来加入非线性因素,提高模型的表达能力. ReLU(Rectified Linear Unit,修正线性单元) 形式如下: \[ \begin{equation} f(x)= \b ...

- 【机器学习】激活函数(Activation Function)

https://blog.csdn.net/ChenVast/article/details/81382795 激活函数是模型整个结构中的非线性扭曲力 神经网络的每层都会有一个激活函数 1.逻辑函数( ...

- 【机器学习】激活函数(ReLU, Swish, Maxout)

https://blog.csdn.net/ChenVast/article/details/81382939 神经网络中使用激活函数来加入非线性因素,提高模型的表达能力. ReLU(Rectifie ...

随机推荐

- MySQL技术内幕读书笔记(七)——锁

锁 锁是数据库系统区分与文件系统的一个关键特性.为了保证数据一致性,必须有锁的介入.数据库系统使用锁是为了支持对共享资源进行并发访问,提供数据的完整性和一致性. lock与latch 使用命令 ...

- (七):处理MFC

(一):简单介绍 为了可以在一个Winelib应用中使用MFC,你须要首先使用Winelib又一次编译MFC. 在理论上,你应该为Windows的MFC编写一个封装(怎样编写在后面介绍).可是,在实践 ...

- Python中的__name__和类

1. python中if __name__ == '__main__': 的解析 经常会在代码的最下面看到if __name__ == '__main__':,现在就来介 绍一下它的作用. 模块是 ...

- Nmap备忘单

#在推特上看到,感觉做的相当不错就转一波. 目标规格 开关 例 描述 nmap 192.168.1.1 扫描一个IP nmap 192.168.1.1 192.168.2.1 扫描特定的IP地 ...

- Java编程的逻辑 (95) - Java 8的日期和时间API

本系列文章经补充和完善,已修订整理成书<Java编程的逻辑>,由机械工业出版社华章分社出版,于2018年1月上市热销,读者好评如潮!各大网店和书店有售,欢迎购买,京东自营链接:http: ...

- BrainFuck 指令

BrainFuck只有八条指令: 指令 含义 等价的C代码 > 指针加一 ++ptr; < 指针减一 --ptr; + 指针指向的字节的值加一 ++*ptr; - 指针指向的字节的值减一 ...

- 非root用户在80端口运行nginx

一般情况下没有这种需求,但对于强迫症患者来说,还是完整的走了一把. 普通用户是不允许使用1024以下端口的,所以此次操作仍然需要root权限来进行配置.而且由于使用了root安装,因此nginx用户仍 ...

- oracle查看某表字段类型

来源:https://www.cnblogs.com/ufindme/p/5033843.html 今天遇到一个问题:要求在可重复执行的SQL脚本添加一段SQL代码:修改当前的数据类型.因为SQL代码 ...

- Attacks for RL

1. http://rll.berkeley.edu/adversarial/ Adversarial Attacks on Neural Network Policies 就是对test时候的p ...

- 01Spark的TopN问题

和hadoop的目的一样,给你数据,然后取TopN.数据如下: 取出数据在排名前十的数据. 代码如下: package com.test.book; import java.util.ArrayLis ...