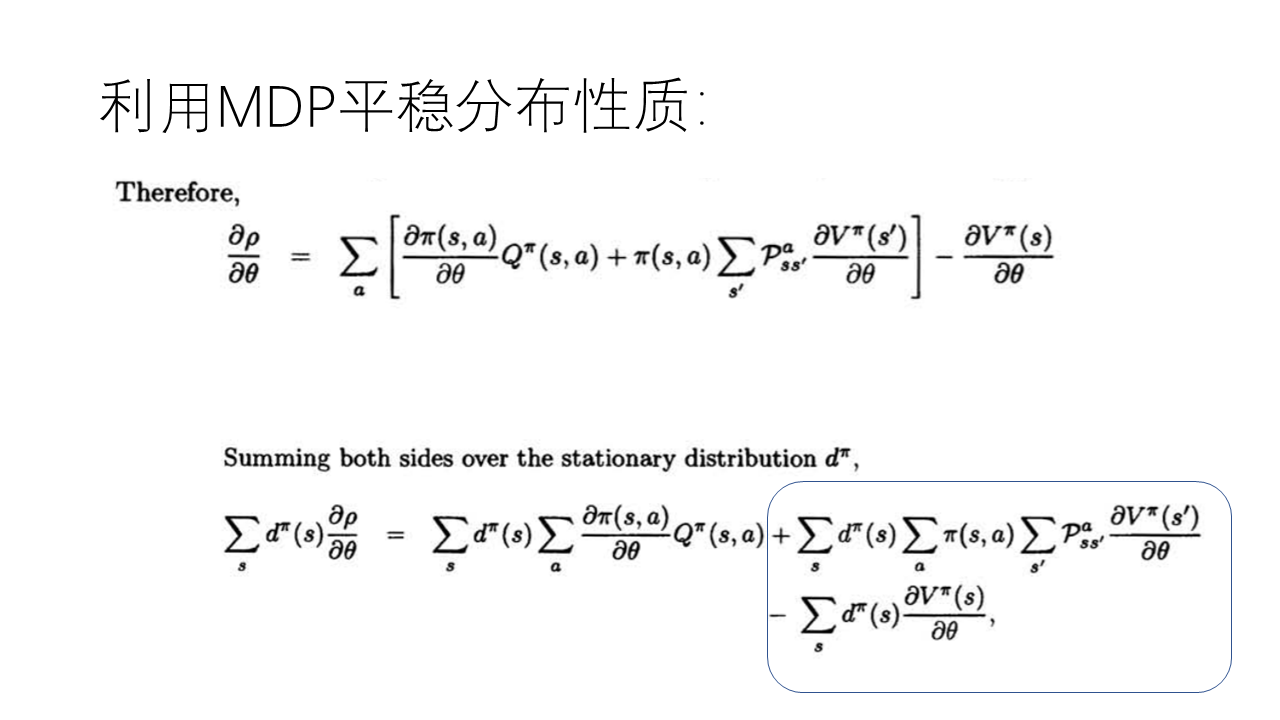

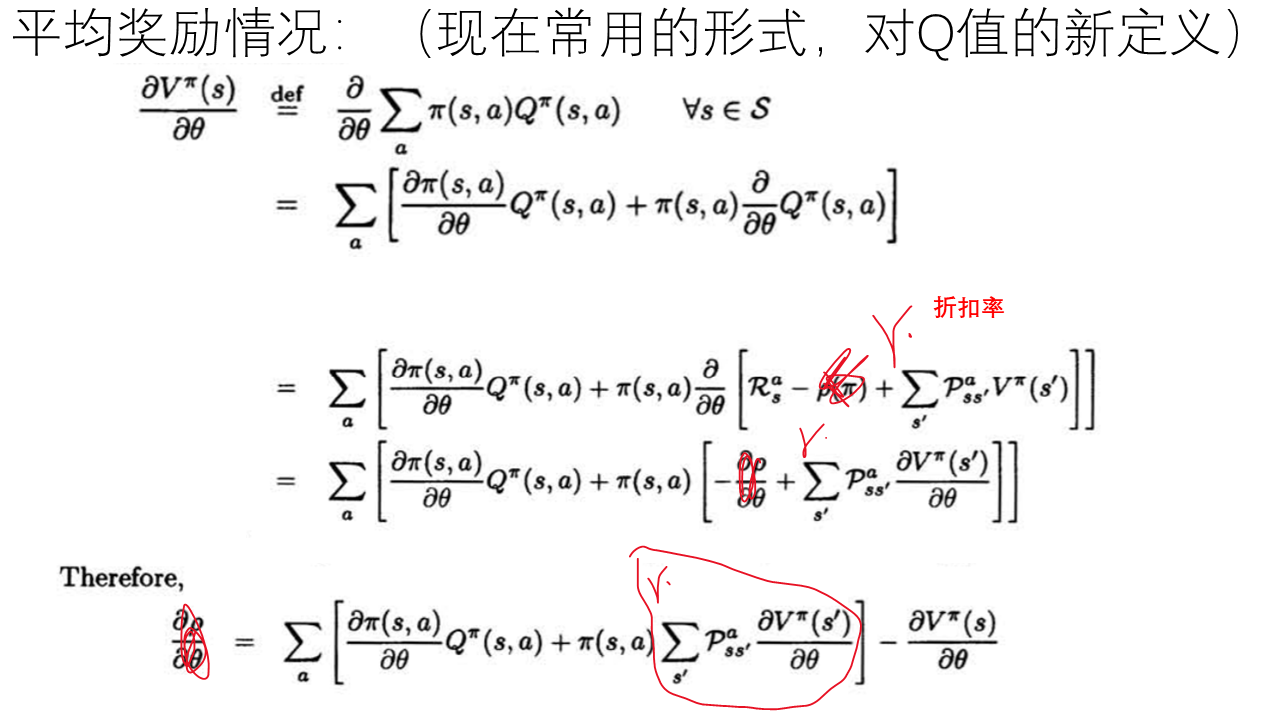

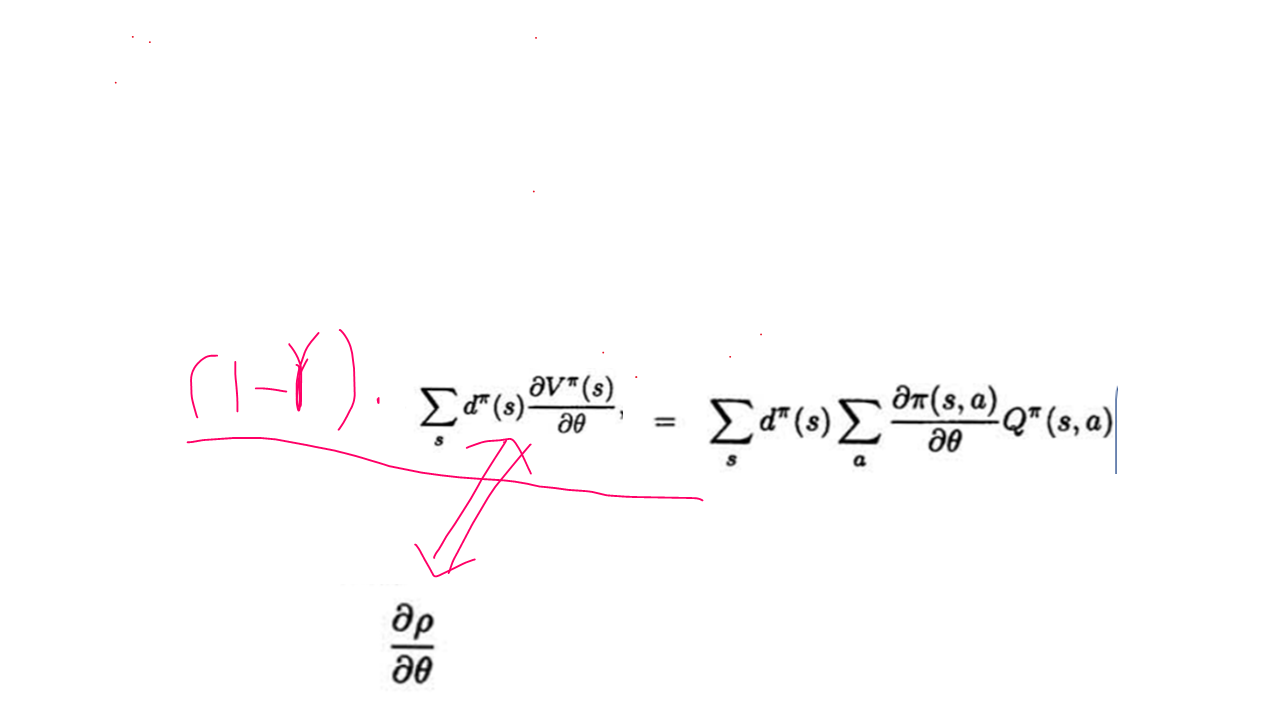

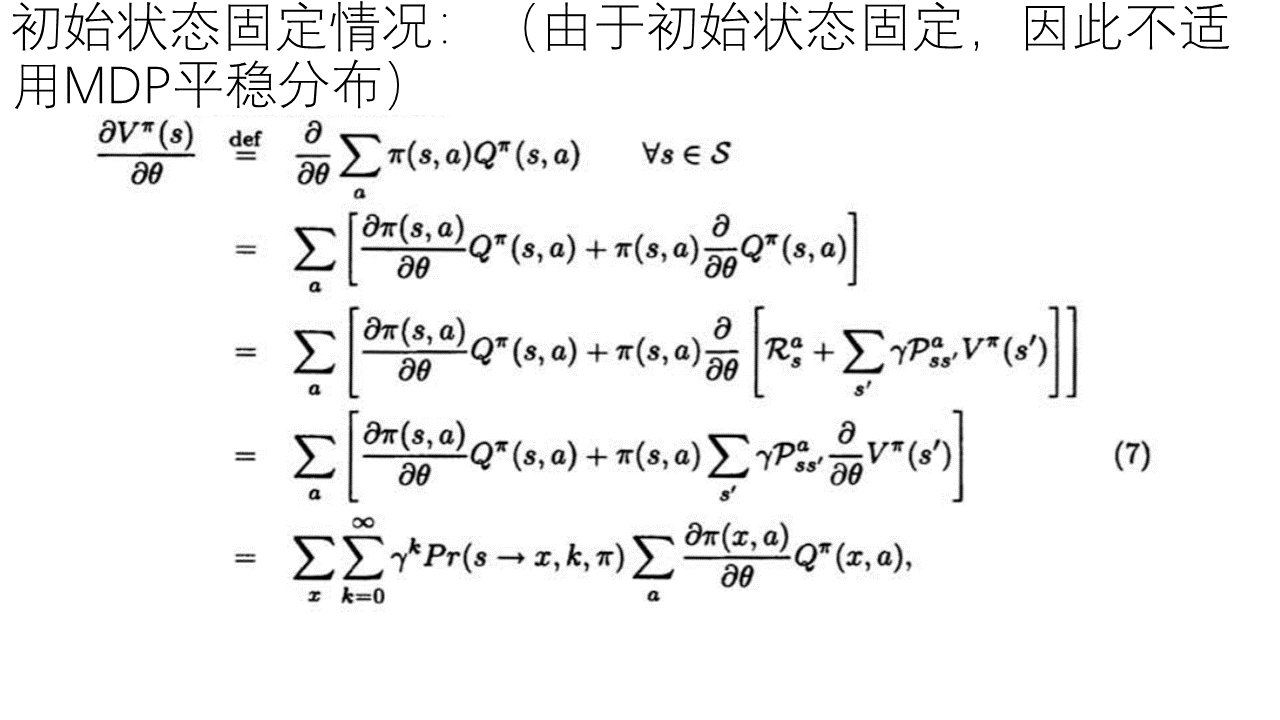

论文《policy-gradient-methods-for-reinforcement-learning-with-function-approximation 》的阅读——强化学习中的策略梯度算法基本形式与部分证明

最近组会汇报,由于前一阵听了中科院的教授讲解过这篇论文,于是想到以这篇论文为题做了学习汇报。论文《policy-gradient-methods-for-reinforcement-learning-with-function-approximation 》虽然发表的时间很早,但是确实很有影响性,属于这个领域很有里程牌的一篇论文,也是属于这个领域的研究者多少应该了解些的文章。以下给出根据自己理解做成的PPT。

---------------------------------------------------------------------------------

后注:

其实,很多人觉得这个推导就是多此一举,这个公式和证明根本没有必要,因为这个公式本身就是显而易见的,原因如下:

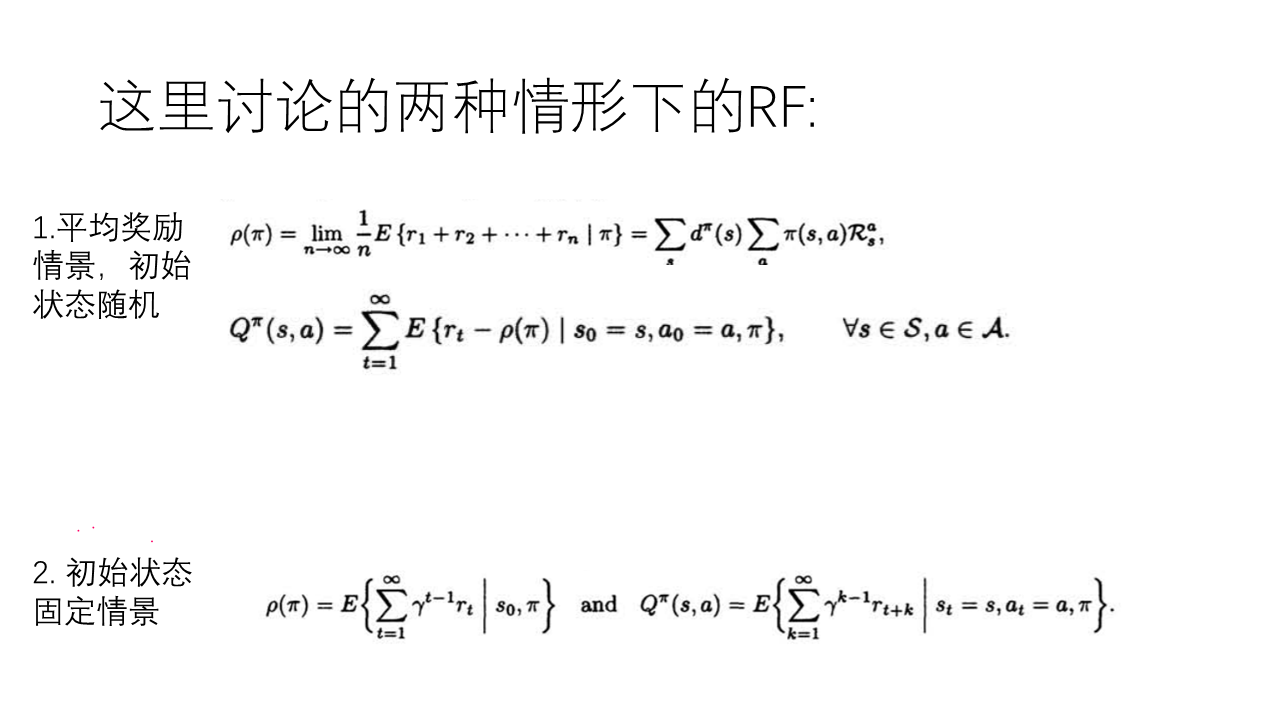

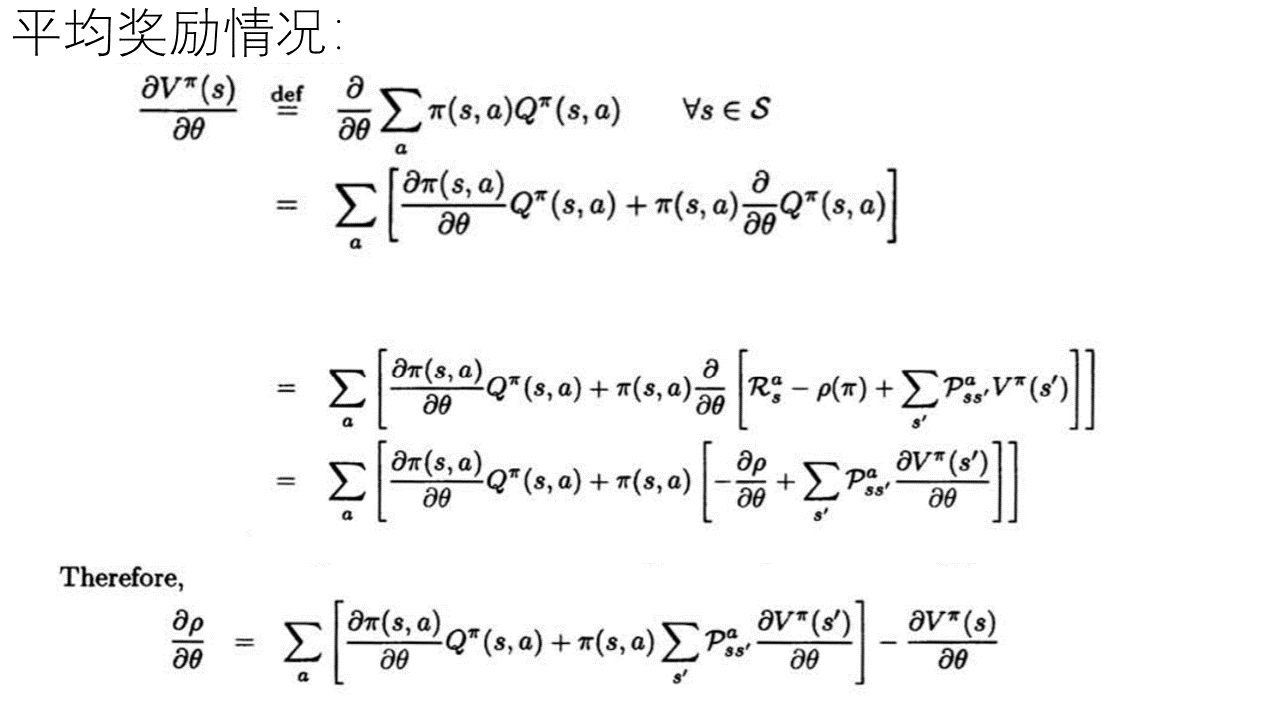

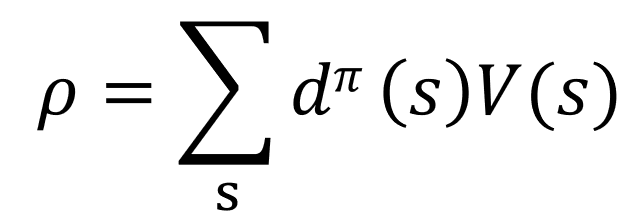

已知(根据MDP及强化学习的定义有):

公式(1):

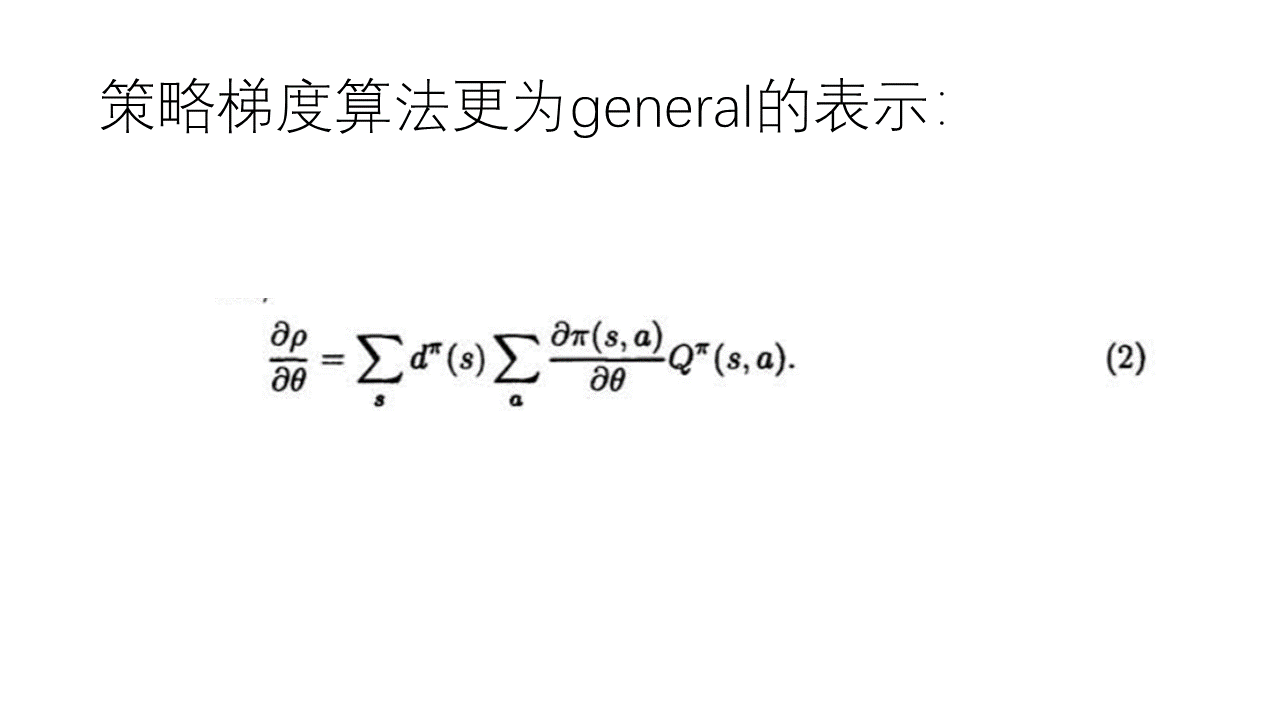

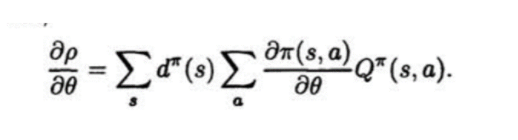

公式(2):

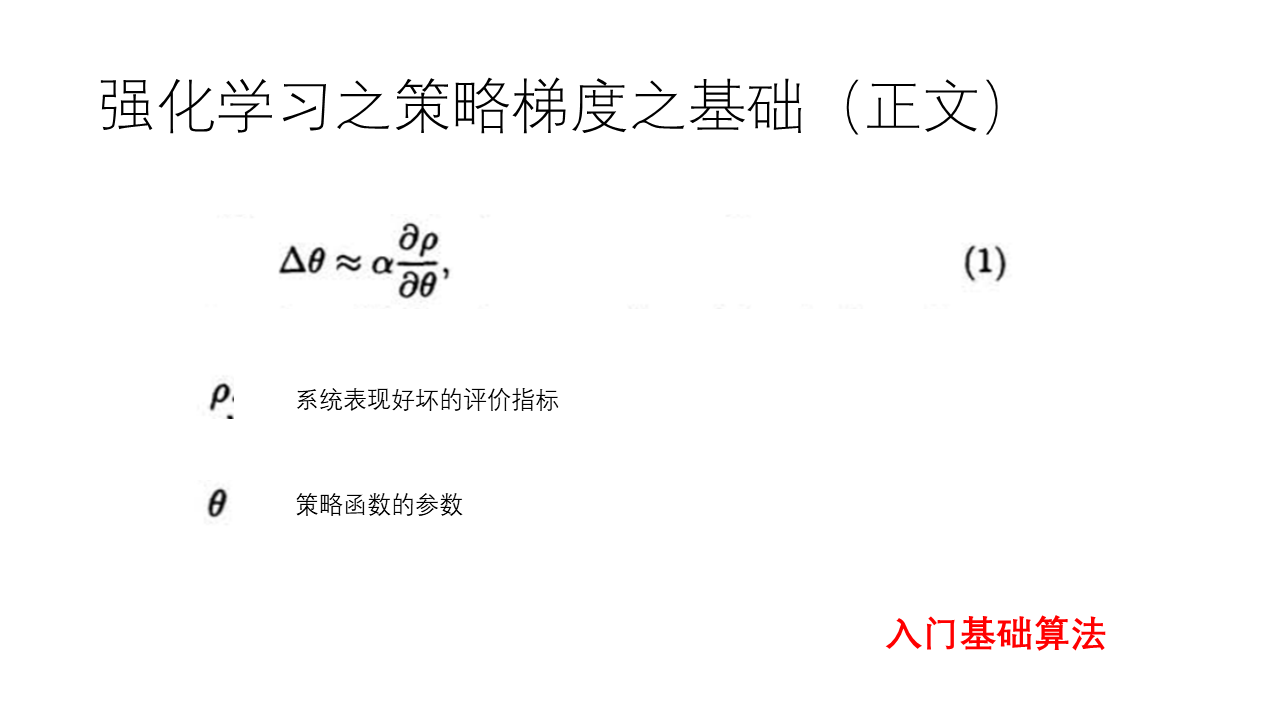

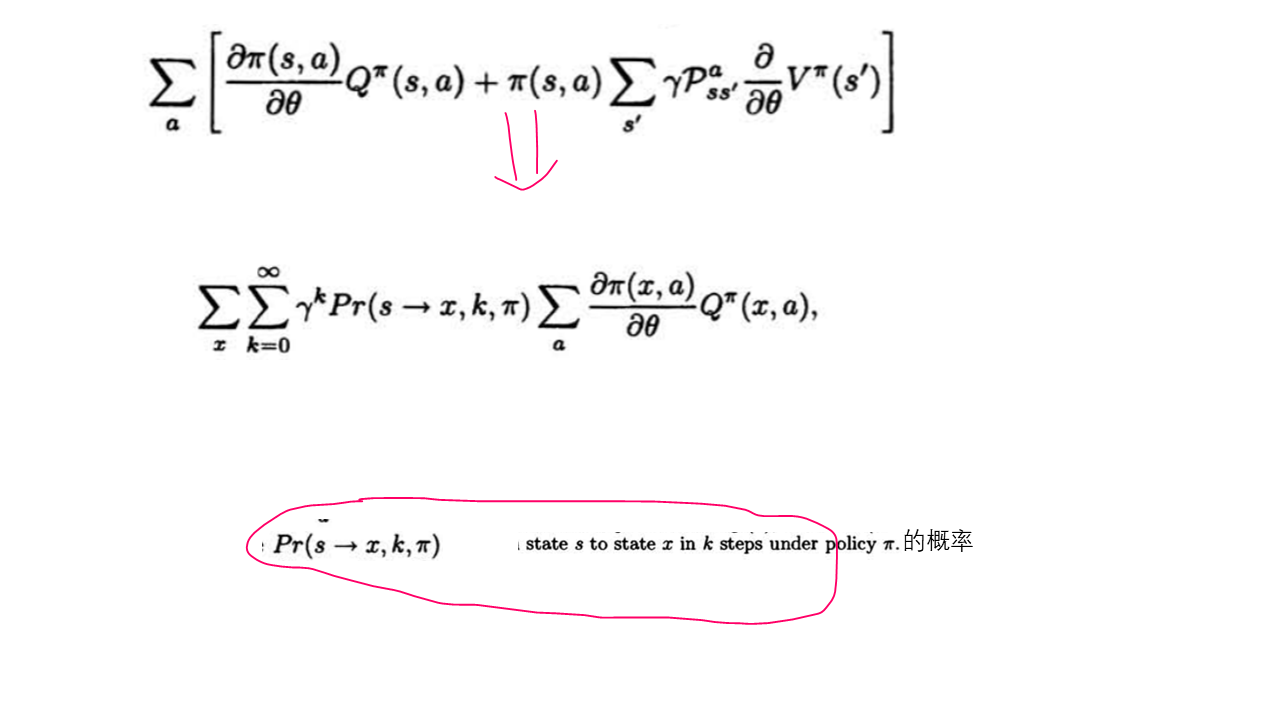

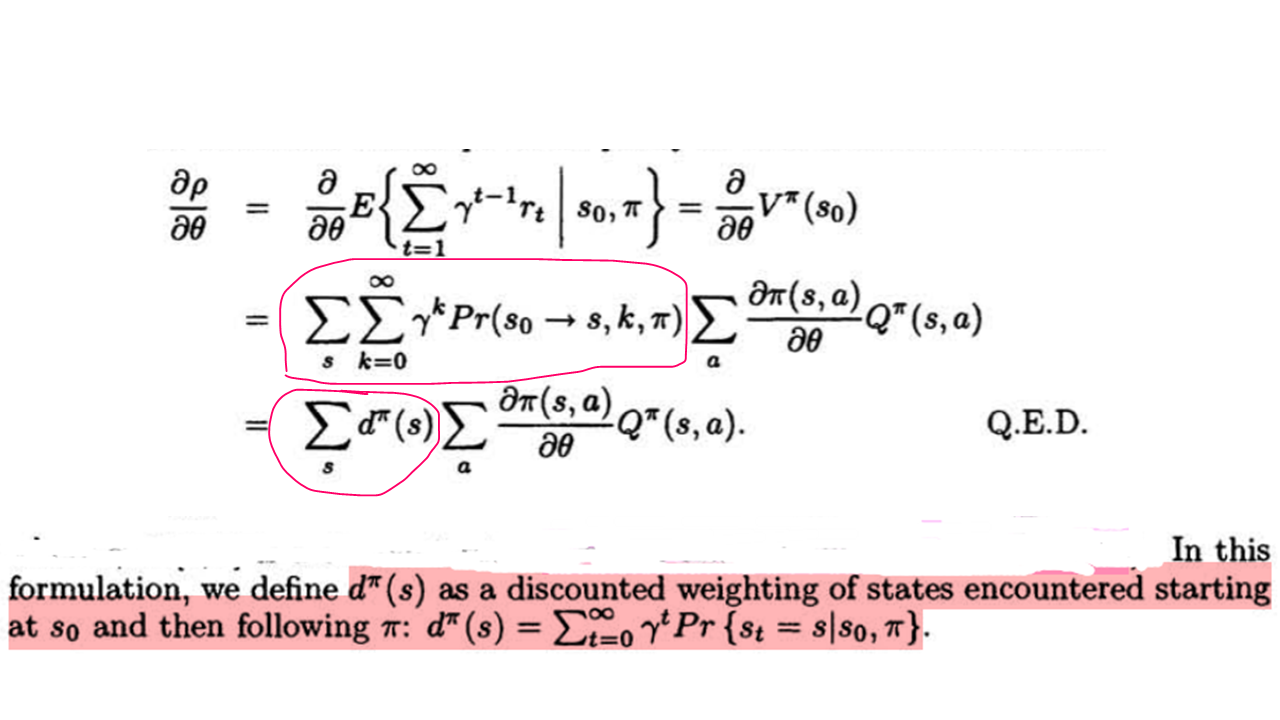

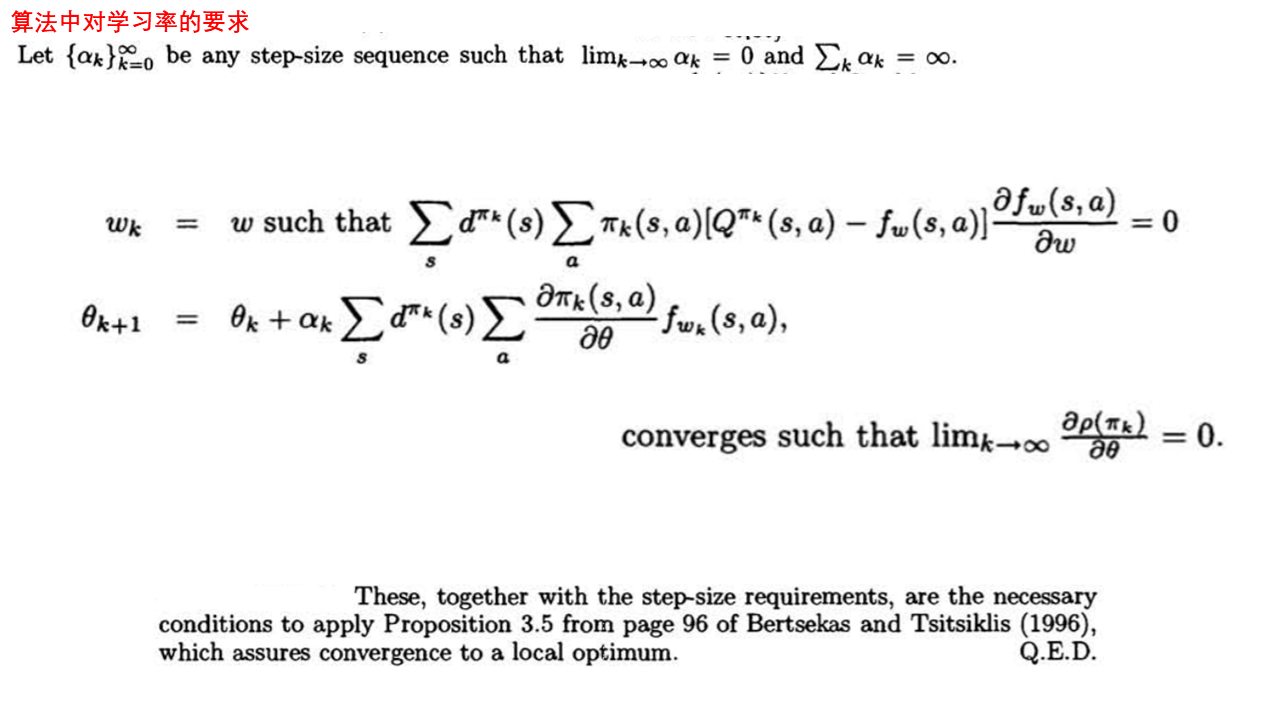

而上面的这篇论文通篇要做的就是下面的公式成立,并且满足逼近函数f为向量且上面的公式(4)及step_size的要求可以收敛到局部最优:

根据后注中的公式(1)和(2),不是直接就可以得到论文中的这个公式嘛,而且而这个公式必然在理想条件下收敛(对整体环境有很好的抽样的情况下),那么把Q换成逼近函数f ,不是也会收敛的嘛,又何必费力去推导最后还得到一个在多个条件下收敛到局部解的结论,这不是显而易见的事情还非得花无用功去为了推导公式而去推导公式和证明收敛的吗?

在此,回答一下 这方面的提问:

首先,要说的就是提出这个问题的人本身就忽略了下面的事情:

与

与  本身都是对策略依赖的,或者说这两个item本身就含有策略参数θ , 所以根本就不存在由后注中的(1),(2)公式可以推导出论文的最终公式的形式。

本身都是对策略依赖的,或者说这两个item本身就含有策略参数θ , 所以根本就不存在由后注中的(1),(2)公式可以推导出论文的最终公式的形式。

换句话说就是策略pi和Q 对策略参数θ来说都不是常数的,由此才有上面论文中的各种情况下的推导。

对于收敛的问题:

虽然我们可以知道在完全抽样的情况下策略梯度用策略和Q来表示是收敛的,都是实际Q并不知道,我们需要用函数近似和采样的方法来获得,而在这样的整个动态的学习过程中即要优化策略梯度的参数,又要优化近似函数f的参数,而这样的情况下是否收敛却并不知道的。

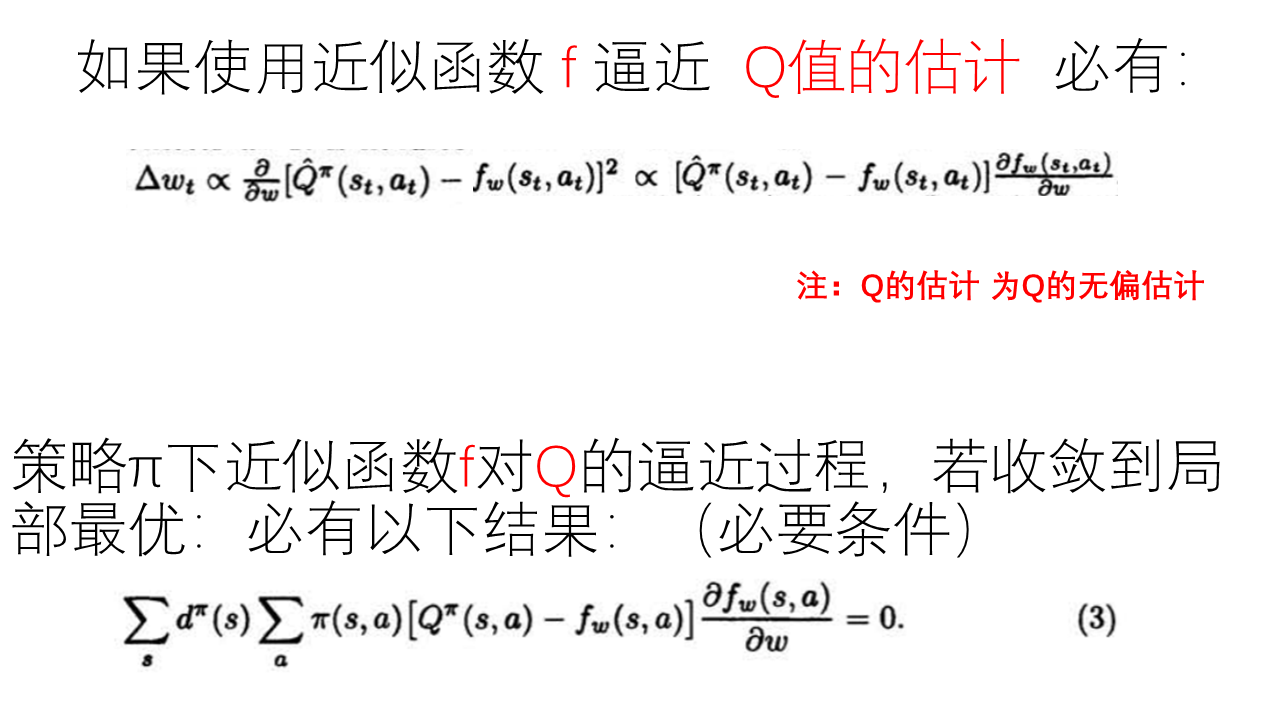

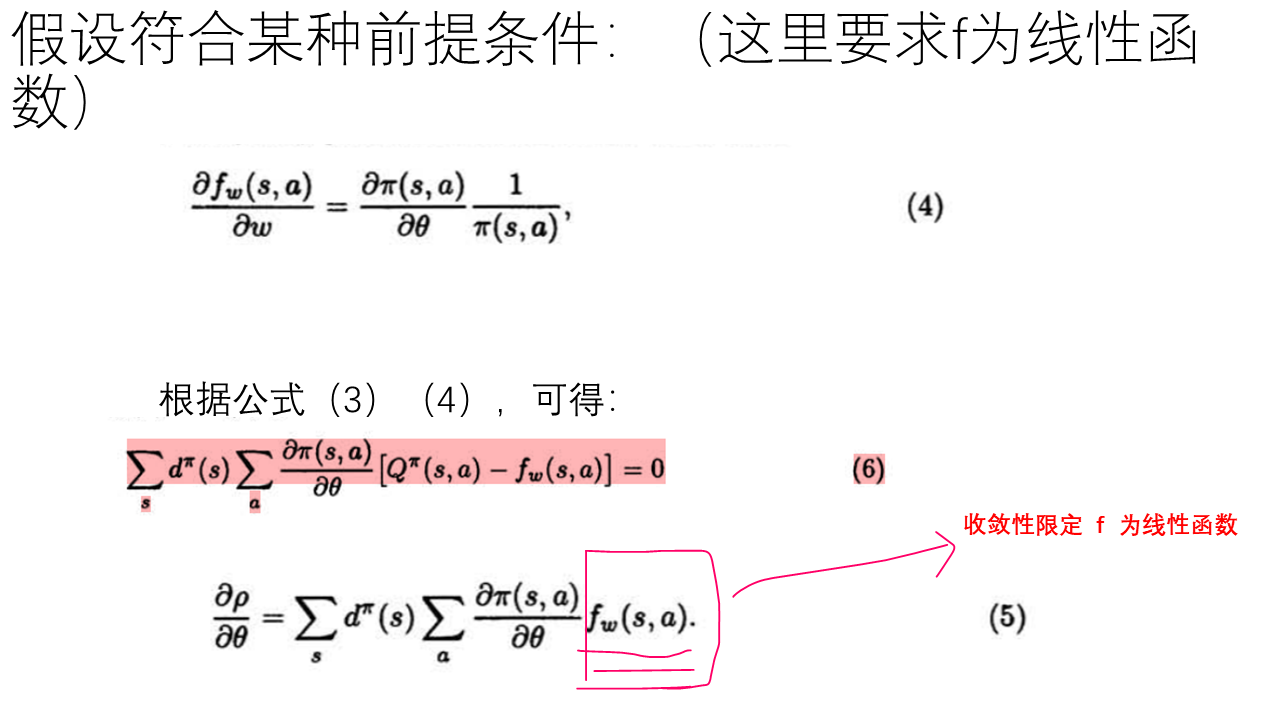

如果在某个学习过程中 近似函数f 对 Q值的估计 过程收敛到局部最优,则有论文中的公式 (3), 而在近似值函数f 和 策略函数pi 满足论文中的公式(4),则有论文中的公式(5),(6), 在有对step_size的限制下才有 满足以上条件的值函数近似策略梯度算法收敛都局部最优的结论。

---------------------------------------

论文《policy-gradient-methods-for-reinforcement-learning-with-function-approximation 》的阅读——强化学习中的策略梯度算法基本形式与部分证明的更多相关文章

- 《DRN: A Deep Reinforcement Learning Framework for News Recommendation》强化学习推荐系统

摘要 新闻推荐系统中,新闻具有很强的动态特征(dynamic nature of news features),目前一些模型已经考虑到了动态特征. 一:他们只处理了当前的奖励(ctr);. 二:有一些 ...

- [Reinforcement Learning] Value Function Approximation

为什么需要值函数近似? 之前我们提到过各种计算值函数的方法,比如对于 MDP 已知的问题可以使用 Bellman 期望方程求得值函数:对于 MDP 未知的情况,可以通过 MC 以及 TD 方法来获得值 ...

- Ⅶ. Policy Gradient Methods

Dictum: Life is just a series of trying to make up your mind. -- T. Fuller 不同于近似价值函数并以此计算确定性的策略的基于价 ...

- 强化学习读书笔记 - 13 - 策略梯度方法(Policy Gradient Methods)

强化学习读书笔记 - 13 - 策略梯度方法(Policy Gradient Methods) 学习笔记: Reinforcement Learning: An Introduction, Richa ...

- 论文翻译--StarCraft Micromanagement with Reinforcement Learning and Curriculum Transfer Learning

(缺少一些公式的图或者效果图,评论区有惊喜) (个人学习这篇论文时进行的翻译[谷歌翻译,你懂的],如有侵权等,请告知) StarCraft Micromanagement with Reinforce ...

- [Reinforcement Learning] Policy Gradient Methods

上一篇博文的内容整理了我们如何去近似价值函数或者是动作价值函数的方法: \[ V_{\theta}(s)\approx V^{\pi}(s) \\ Q_{\theta}(s)\approx Q^{\p ...

- 强化学习七 - Policy Gradient Methods

一.前言 之前我们讨论的所有问题都是先学习action value,再根据action value 来选择action(无论是根据greedy policy选择使得action value 最大的ac ...

- DRL之:策略梯度方法 (Policy Gradient Methods)

DRL 教材 Chpater 11 --- 策略梯度方法(Policy Gradient Methods) 前面介绍了很多关于 state or state-action pairs 方面的知识,为了 ...

- 深度学习课程笔记(十三)深度强化学习 --- 策略梯度方法(Policy Gradient Methods)

深度学习课程笔记(十三)深度强化学习 --- 策略梯度方法(Policy Gradient Methods) 2018-07-17 16:50:12 Reference:https://www.you ...

- 论文选读一: Towards end-to-end reinforcement learning of dialogue agents for information access

Towards end-to-end reinforcement learning of dialogue agents for information access KB-InfoBot 与知识库交 ...

随机推荐

- C#.NET FRAMEWORK ASP.NET MVC 获取客户端IP

C#.NET FRAMEWORK ASP.NET MVC 获取客户端IP 工具类: using System; namespace CommonUtils { public static class ...

- PowerBI_一分钟了解POWERBI计算组_基础运用篇(一)

在第一篇计算组的文章中,给大家介绍了,POWERBI的计算组功能的基本概念和作用. 本文,旨在通过简单案例,介绍计算组功能的具体应用场景. 没有看过第一篇的同学,可以先简单过一下第一篇,补齐一下概念和 ...

- .Net Core+NPOI快速导入导出Excel

Excel导入导出在开发中是非常常见的,对Excel操作,NPOI使用的是最常用的,但单单用NPOI,要写得代码还是比较多的,可以借助一个Npoi.Mapper库,操作起来就非常简单了,十来行代码就可 ...

- DHorse的配置文件

首先看一下DHorse的配置文件,如下: #============================================================================== ...

- R 语言入门学习笔记:软件安装踩坑记录——删除所有包以及彻底解决库包被安装到 C 盘用户目录下的问题,以及一些其他需要注意的点

目录 R 语言入门学习笔记:软件安装踩坑记录--删除所有包以及彻底解决库包被安装到 C 盘用户目录下的问题,以及一些其他需要注意的点 软件版本及环境 遇到的问题描述 问题的分析和探究 最终的解决方案 ...

- Typora行内公式识别不了

Typora行内公式识别不了,主要是因为行内公式属于LaTeX扩展语法,并非Markdown的通用标准 需要在Typora的"文件"-"偏好设置"-" ...

- 配置 Nginx + PHP(FastCGI/FPM)

有关概念 Nginx是什么 Nginx ("engine x") 是一个高性能的HTTP和反向代理服务器,也是一个IMAP/POP3/SMTP服务器. Php-fpm是什么 1.c ...

- “科来杯”第九届山东省大学生网络安全技能大赛决赛部分wp

1.损坏的流量包 wireshark打不开,丢进winhex里,找关键字flag 哎,没找到. 那就仔细看看,在最后发现一串类似base64的密文 base64解密 得到flag 2.签到题 一个 ...

- “进口”双核A53@1.4GHz仅188元起,超高性价比!“邮票孔”AM62x工业核心板,正式发布!

创龙科技作为TI官方合作伙伴,在2022年9月即推出搭载TI最新明星处理器AM62x的工业核心板-SOM-TL62x(B2B版本).为了让工业客户进一步降低产品成本,并提高产品连接的可靠性,我们再次推 ...

- 详解Web应用安全系列(8)不足的日志记录和监控

在Web安全领域,不足的日志记录和监控是一个重要的安全隐患,它可能导致攻击者能够更隐蔽地进行攻击,同时增加了攻击被检测和响应的难度.以下是对Web攻击中不足的日志记录和监控漏洞的详细介绍. 一.日志记 ...