Filebeat日志收集简单使用

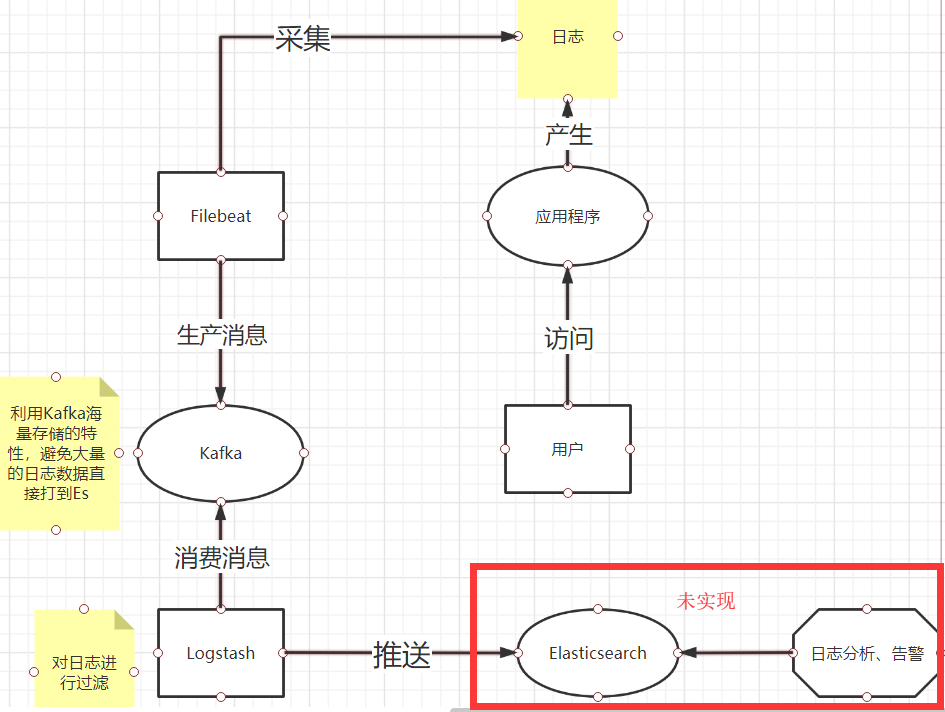

1.简略介绍

2.本文实现的功能

3.事先必备:

4.配置Log4j,自定义代码中日志信息输出格式以及文件名称

<?xml version="1.0" encoding="UTF-8"?>

<Configuration status="info" schema="Log4J-V2.0.xsd" monitorInterval="600">

<Properties>

//存放日志的文件夹名称

<Property name="LOG_HOME">logs</Property>

//日志文件名称

<property name="FILE_NAME">collector</property>

//日志格式

//[%d{yyyy-MM-dd'T'HH:mm:ss.SSSZZ}] 日志输入时间,东八区

//[%level{length=5}] 日志级别,debug、info、warn、error

//[%thread-%tid] 当前线程信息

//[%logger] 当前日志信息所属类全路径

//[%X{hostName}] 当前节点主机名。需要通过MDC来自定义。

//[%X{ip}] 当前节点ip。需要通过MDC来自定义。

//[%X{applicationName}] 当前应用程序名。需要通过MDC来自定义。

//[%F,%L,%C,%M] %F:当前日志信息所属的文件(类)名,%L:日志信息在所属文件中的行号,%C:当前日志所属文件的全类名,%M:当前日志所属的方法名

//[%m] 日志详情

//%ex 异常信息

//%n 换行

<property name="patternLayout">[%d{yyyy-MM-dd'T'HH:mm:ss.SSSZZ}] [%level{length=5}] [%thread-%tid] [%logger]

[%X{hostName}] [%X{ip}] [%X{applicationName}] [%F,%L,%C,%M] [%m] ## '%ex'%n

</property>

</Properties>

<Appenders>

//日志输出至控制台

<Console name="CONSOLE" target="SYSTEM_OUT">

<PatternLayout pattern="${patternLayout}"/>

</Console>

//全量日志信息

<RollingRandomAccessFile name="appAppender" fileName="${LOG_HOME}/app-${FILE_NAME}.log"

filePattern="${LOG_HOME}/app-${FILE_NAME}-%d{yyyy-MM-dd}-%i.log">

<PatternLayout pattern="${patternLayout}"/>

<Policies>

<TimeBasedTriggeringPolicy interval="1"/>

<SizeBasedTriggeringPolicy size="500MB"/>

</Policies>

<DefaultRolloverStrategy max="20"/>

</RollingRandomAccessFile>

//日志级别是warn以上的日志信息

<RollingRandomAccessFile name="errorAppender" fileName="${LOG_HOME}/error-${FILE_NAME}.log"

filePattern="${LOG_HOME}/error-${FILE_NAME}-%d{yyyy-MM-dd}-%i.log">

<PatternLayout pattern="${patternLayout}"/>

<Filters>

<ThresholdFilter level="warn" onMatch="ACCEPT" onMismatch="DENY"/>

</Filters>

<Policies>

<TimeBasedTriggeringPolicy interval="1"/>

<SizeBasedTriggeringPolicy size="500MB"/>

</Policies>

<DefaultRolloverStrategy max="20"/>

</RollingRandomAccessFile>

</Appenders>

<Loggers>

<!-- 业务相关 异步logger -->

<AsyncLogger name="com.sakura.*" level="info" includeLocation="true">

<AppenderRef ref="appAppender"/>

</AsyncLogger>

<AsyncLogger name="com.sakura.*" level="info" includeLocation="true">

<AppenderRef ref="errorAppender"/>

</AsyncLogger>

<Root level="info">

<Appender-Ref ref="CONSOLE"/>

<Appender-Ref ref="appAppender"/>

<AppenderRef ref="errorAppender"/>

</Root>

</Loggers>

</Configuration>

5.Filebeat安装

#上传Filebeat至任意目录下

cd /usr/local/software

tar -zxvf filebeat-6.6.0-linux-x86_64.tar.gz -C /usr/local/

cd /usr/local

mv filebeat-6.6.0-linux-x86_64/ filebeat-6.6.0

## 配置filebeat

vim /usr/local/filebeat-5.6.2/filebeat.yml

##可参考下方配置信息

启动:

## 检查配置是否正确

cd /usr/local/filebeat-6.6.0

./filebeat -c filebeat.yml -configtest

## Config OK

## 启动filebeat

/usr/local/filebeat-6.6.0/filebeat &

#查看是否启动成功

ps -ef | grep filebeat

###################### Filebeat Configuration Example #########################

filebeat.prospectors: - input_type: log paths:

## app-服务名称.log, 为什么写死,防止发生轮转抓取历史数据

- /usr/local/logs/app-collector.log #日志文件地址

#定义写入 ES 时的 _type 值

document_type: "app-log"

multiline:

#pattern: '^\s*(\d{4}|\d{2})\-(\d{2}|[a-zA-Z]{3})\-(\d{2}|\d{4})' # 指定匹配的表达式(匹配以 2017-11-15 08:04:23:889 时间格式开头的字符串)

pattern: '^\[' # 指定匹配的表达式(匹配以 "{ 开头的字符串)。具体以哪种形式进行匹配要根据实际的日志格式来配置。

negate: true # 是否必须匹配到

match: after # 以[开头的多行数据,从第二行开始合并到上一行的末尾

max_lines: 2000 # 最大的行数,多余的不再合并到上一行末尾

timeout: 2s # 如果在规定时间没有新的日志事件就不等待后面的日志,提交数据

fields:

logbiz: collector

logtopic: app-log-collector ## 按服务划分用作kafka topic

evn: dev - input_type: log paths:

- /usr/local/logs/error-collector.log

document_type: "error-log"

multiline:

#pattern: '^\s*(\d{4}|\d{2})\-(\d{2}|[a-zA-Z]{3})\-(\d{2}|\d{4})' # 指定匹配的表达式(匹配以 2017-11-15 08:04:23:889 时间格式开头的字符串)

pattern: '^\[' # 指定匹配的表达式(匹配以 "{ 开头的字符串)

negate: true # 是否匹配到

match: after # 合并到上一行的末尾

max_lines: 2000 # 最大的行数

timeout: 2s # 如果在规定时间没有新的日志事件就不等待后面的日志

fields:

logbiz: collector

logtopic: error-log-collector ## 按服务划分用作kafka topic

evn: dev output.kafka:

enabled: true

hosts: ["192.168.204.139:9092"]

topic: '%{[fields.logtopic]}'

partition.hash:

reachable_only: true

compression: gzip

max_message_bytes: 1000000

required_acks: 1

logging.to_files: true

6.在kafka上创建对应的topic

略

7.启动kafka、代码程序,最后启动Filebeat。

8.使用Logstash消费Kafka中的数据

A.安装Logstash

Logstash安装及基础命令:https://www.cnblogs.com/monument/p/12950290.html

B.配置Logstash启动脚本

input {

kafka {

## app-log-服务名称

topics_pattern => "app-log-.*"

bootstrap_servers => "192.168.11.51:9092"

codec => json

consumer_threads => ## 因为只设置了一个partition,所以消费者线程数设置为1

decorate_events => true

#auto_offset_rest => "latest"

group_id => "app-log-group"

}

kafka {

## error-log-服务名称

topics_pattern => "error-log-.*"

bootstrap_servers => "192.168.11.51:9092"

codec => json

consumer_threads =>

decorate_events => true

#auto_offset_rest => "latest"

group_id => "error-log-group"

}

}

filter {

## 时区转换

ruby {

code => "event.set('index_time',event.timestamp.time.localtime.strftime('%Y.%m.%d'))"

}

if "app-log" in [fields][logtopic]{

grok {

## 表达式

match => ["message", "\[%{NOTSPACE:currentDateTime}\] \[%{NOTSPACE:level}\] \[%{NOTSPACE:thread-id}\] \[%{NOTSPACE:class}\] \[%{DATA:hostName}\] \[%{DATA:ip}\] \[%{DATA:applicationName}\] \[%{DATA:location}\] \[%{DATA:messageInfo}\] ## (\'\'|%{QUOTEDSTRING:throwable})"]

}

}

if "error-log" in [fields][logtopic]{

grok {

## 表达式

match => ["message", "\[%{NOTSPACE:currentDateTime}\] \[%{NOTSPACE:level}\] \[%{NOTSPACE:thread-id}\] \[%{NOTSPACE:class}\] \[%{DATA:hostName}\] \[%{DATA:ip}\] \[%{DATA:applicationName}\] \[%{DATA:location}\] \[%{DATA:messageInfo}\] ## (\'\'|%{QUOTEDSTRING:throwable})"]

}

}

}

## 测试输出到控制台:

output {

stdout { codec => rubydebug }

}

## elasticsearch,未实现:

output {

if "app-log" in [fields][logtopic]{

## es插件

elasticsearch {

# es服务地址

hosts => ["192.168.11.35:9200"]

# 用户名密码

user => "elastic"

password => ""

## 索引名,+ 号开头的,就会自动认为后面是时间格式:

## javalog-app-service-2019.01.

index => "app-log-%{[fields][logbiz]}-%{index_time}"

# 是否嗅探集群ip:一般设置true;http://192.168.11.35:9200/_nodes/http?pretty

# 通过嗅探机制进行es集群负载均衡发日志消息

sniffing => true

# logstash默认自带一个mapping模板,进行模板覆盖

template_overwrite => true

}

}

if "error-log" in [fields][logtopic]{

elasticsearch {

hosts => ["192.168.11.35:9200"]

user => "elastic"

password => ""

index => "error-log-%{[fields][logbiz]}-%{index_time}"

sniffing => true

template_overwrite => true

}

}

}

C.启动Logstash

9.将Logstash消费的数据推送到ElasticSearch

Filebeat日志收集简单使用的更多相关文章

- 【linux】【ELK】搭建Elasticsearch+Logstash+Kibana+Filebeat日志收集系统

前言 ELK是Elasticsearch.Logstash.Kibana的简称,这三者是核心套件,但并非全部. Elasticsearch是实时全文搜索和分析引擎,提供搜集.分析.存储数据三大功能:是 ...

- Filebeat 日志收集

Filebeat 介绍 Filebeat 安装 # 上传代码包 [root@redis03 ~]# rz filebeat-6.6.0-x86_64.rpm # 安装 [root@redis03 ~] ...

- Filebeat 日志收集器 安装和配置

Filebeat的配置文件是/etc/filebeat/filebeat.yml,遵循YAML语法.具体可以配置如下几个项目: Filebeat Output Shipper Logging(可选) ...

- ELK Stack 介绍 & Logstash 日志收集

ELK Stack 组成 Software Description Function E:Elasticsearch Java 程序 存储,查询日志 L:Logstash Java 程序 收集.过滤日 ...

- CentOS7下 简单安装和配置Elasticsearch Kibana Filebeat 快速搭建集群日志收集平台

目录 1.添加elasticsearch官网的yum源 2.Elasticsearch 安装elasticsearch 配置elasticsearch 启动elasticsearch并设为开机启动 3 ...

- 快速搭建应用服务日志收集系统(Filebeat + ElasticSearch + kibana)

快速搭建应用服务日志收集系统(Filebeat + ElasticSearch + kibana) 概要说明 需求场景,系统环境是CentOS,多个应用部署在多台服务器上,平时查看应用日志及排查问题十 ...

- 日志收集之filebeat使用介绍

此系列文章一共分为三部分,分为filebeat部分,logstash部分,es部分.这里会按照每天几百亿条的数据量来考虑,去设计.部署.优化这个日志系统,来最大限度的利用资源,并达到一个最优的性能.本 ...

- Elasticsearch + Logstash + Kibana +Redis +Filebeat 单机版日志收集环境搭建

1.前置工作 1.虚拟机环境简介 Linux版本:Linux localhost.localdomain 3.10.0-862.el7.x86_64 #1 SMP Fri Apr 20 16:44:2 ...

- asp.Net Core免费开源分布式异常日志收集框架Exceptionless安装配置以及简单使用图文教程

最近在学习张善友老师的NanoFabric 框架的时了解到Exceptionless : https://exceptionless.com/ !因此学习了一下这个开源框架!下面对Exceptionl ...

随机推荐

- 不花钱搞定PDF编辑难题

PDF格式是专为显示而设计的格式,并不容易被编辑,市面上并没有一款可以真正免费使用的PDF编辑器. 不花钱搞定PDF编辑难题的办法: 1.免费使用PDF编辑器+去水印:免费版的PDF编辑器不是会加水印 ...

- 关于前端数据&逻辑的思考

最近重构了一个项目,一个基于redux模型的react-native项目,目标是在混乱的代码中梳理出一个清晰的结构来,为了实现这个目标,首先需要对项目的结构做分层处理,将各个逻辑分离出来,这里我是基于 ...

- Azure Web App (一)发布你的Net Core Web 项目

一,引言 今天我们看一下Azure上的一个服务-----Web 应用,我们都知道云计算的三大模式:Iaas(基础设施即服务),Paas(平台即服务),Saas(软件即服务). Iass,其实就是虚拟主 ...

- BJDCTF-2020-WRITEUP---TiKi小组

title: BJDCTF 2020 刷题记录categories: CTFtags: BJDCTF CTF2020 BJDCTF Web duangShell 根据提示,输入.index.php.s ...

- 使用CodeMirror插件遇到的问题

CodeMirror的正常使用: //首先通过<script>标签引入相应的js,这个就不必说了 var myCodeMirror = CodeMirror.fromTextArea(my ...

- day15 作业

day15 作业 目录 day15 作业 第一题 第二题 第三题 第四题 第五题 第六题 第七题 第一题 ===================题目一=================== input ...

- python基础之打/解包及运算符与控制流程

python基础之打/解包及运算符与控制流程 python中的解压缩(即序列类型的打包和解包) python提供了两个设计元祖和其他序列类型的处理的便利,也就是自动打包与自动解包功能,比如: data ...

- three.js 几何体(二)

上一篇简单的介绍了几何体的构造体参数,这一篇郭先生就更加详细的说一说(十分简单的几何体我就不说了). 1. ShapeGeometry形状几何体 形状几何体方便我们从一个或多个路径形状中创建一个单面多 ...

- less基础

less less的含义: less是一种动态样式语言,属于css预处理器的范畴,它扩展了css语言,增加了变量.Mixin.函数等特性,使css更易维护和扩展. 此外,less既可以在客户端上运行, ...

- bzoj3622已经没有什么好害怕的了

bzoj3622已经没有什么好害怕的了 题意: 给n个数Ai,n个数Bi,将Ai中的数与Bi中的数配对,求配对Ai比Bi大的比Bi比Ai大的恰好有k组的方案数.n,k≤2000 题解: 蒟蒻太弱了只能 ...