ELK搭建以及运行和ElasticStarch的详细使用(7.X版本之上)

使用分析

- 处理方式灵活:Elasticsearch 是实时全文索引;

- 配置简易上手

- 检索性能高效:

- 集群线性扩展:(分布式功能);

- 前端操作炫丽:Kibana 界面上,只需要点击鼠标,就可以完成搜索、聚合功能,生成炫丽的仪表板

- 有很多相关的 配套插件

- .........

- 数据不是实时性(近实时性)

- 功能点:告警、权限管理、关联分析等还是不太行

- 缺点也有:各个版本的收费情况 (https://blog.csdn.net/vkingnew/article/details/91549698)

- 还是 比较吃内存的 吃配置的

- .........

- 数据(日志)的日益增多

- 开源

- ELK 本身非常易用,有一个非常好的社区

- .........

- 问题排查

- 监控和预警

- 关联事件

- 数据分析

- 修改默认的 Elasticsearch 集群名称

- 不要暴露 Elasticsearch 在公网上

- 不要以 root 身份运行 Elasticsearch

- 定期对 Elasticsearch 进行备份

- 安装Elasticsearch的权限系统插件-SearchGuard

- 利用操作系统防火墙设置规避9200端口开放问题

RESTFul API 请求相关内容

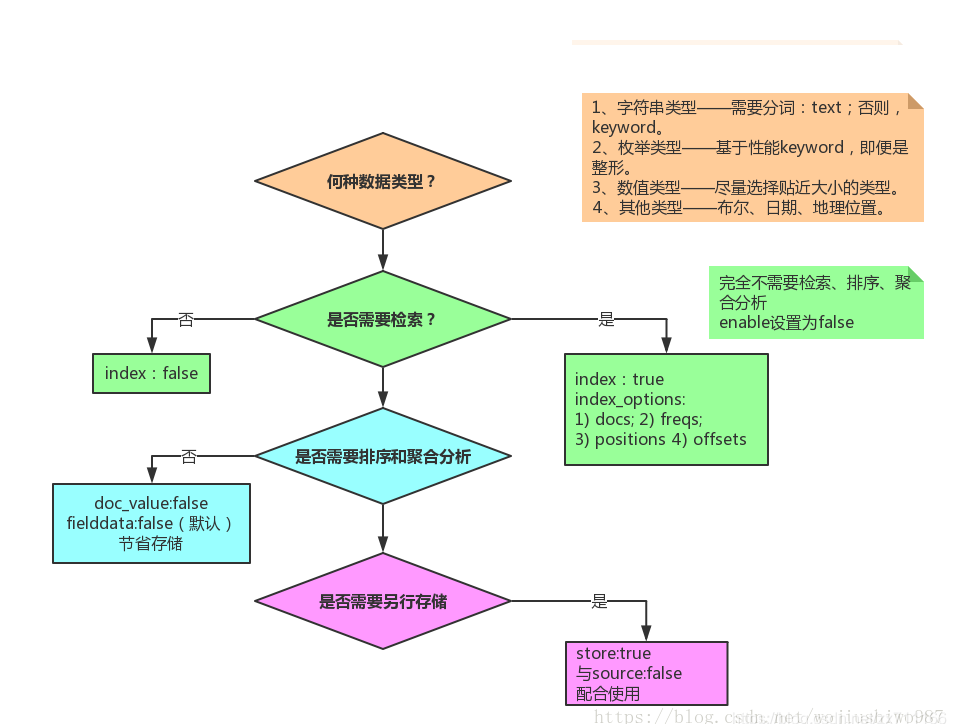

1.设置映射的mappings字段等字段类型等

PUT

http://localhost:9200/local_index/cytest/ 在POST时

{

"mappings": {

"cytest": {

"id": {

"type": "long"

},

"title": {

"type": "text"

},

"content": {

"type": "keyword"

},

"date": {

"type": "date",

"fromat": "yyyy-MM-dd HH:mm:ss"

}

}

}

} 2. 往对应的映射字段里面赋值(链接(POST http://localhost:9200/local_idx_1/cytest/))

下数据库_表下增加一个数据) {

"id": "1",

"title": "测试数据1",

"content": "大意了没有闪",

"date": "2020-11-04"

} 修改的话 得到_id 拼到链接后面 传入数据就是修改 3.简单查询 POST (http://localhost:9200/local_index/cytest/_search/) POST http://127.0.0.1:9200/myname/_search

{

"query":{

"match":{

"name":"zhangsan"

}

}

}

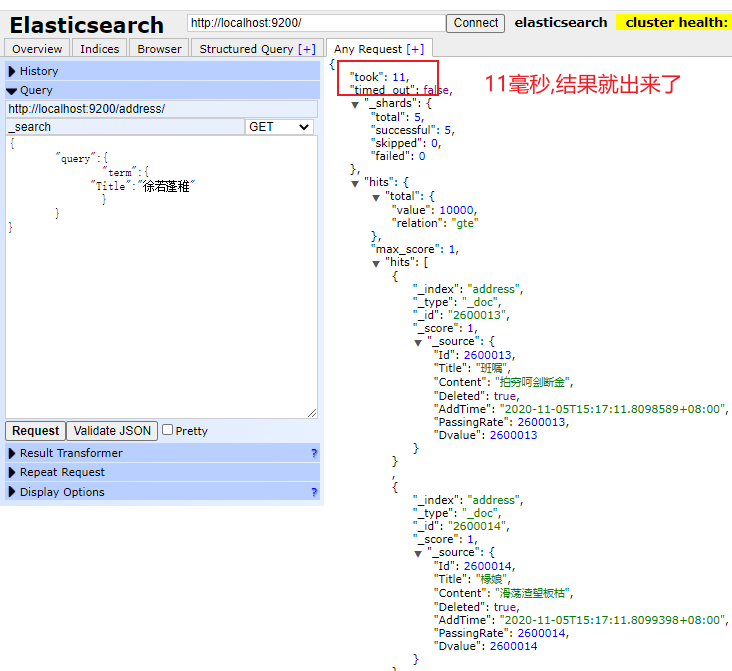

{

"query":{

"term":{

"Title":"徐若蓬稚"

}

}

} 1 term查询(精准查询)

terms 查询是term的扩展,可以支持多个vlaue匹配,只需要一个匹配就可以了。

2 math查询(分词匹配查询)

match查询是按ES分词的倒排表进行查询,而keyword不会被分词,match的需要跟keyword的完全匹配可以。可以用于一般性的匹配查询。

match_all可以用于查询全部信息。

multi_match

multi_match是多字段进行匹配查询。

3 fuzzy查询(模糊查询)

4 wildcard(通配符查询)

5 bool查询(布尔查询)

6其他知识点

取特定字段(_source)

分页(size ,from)

排序(sort) 具体的更多详请访问

https://blog.csdn.net/shu616048151/article/details/102647313

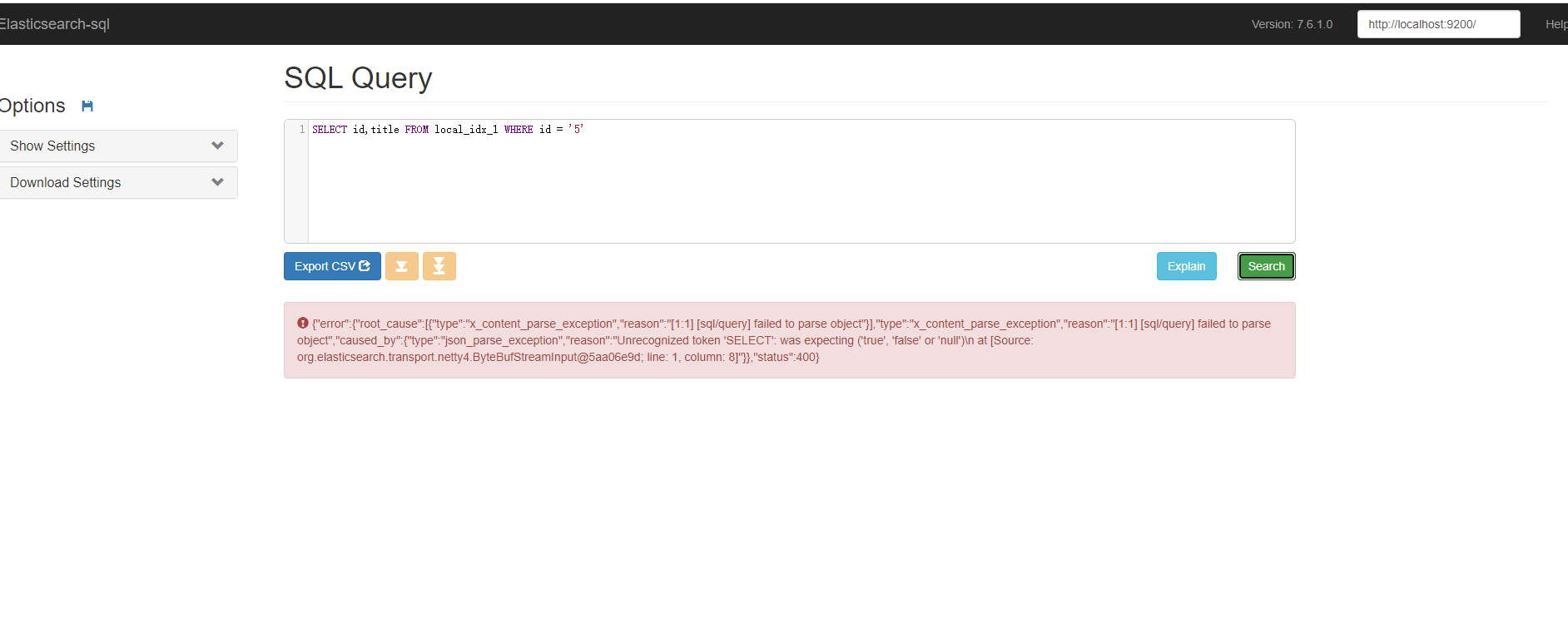

./bin/elasticsearch-plugin install https://github.com/NLPchina/elasticsearch-sql/releases/download/6.3.1.0/elasticsearch-sql-6.3.1.1.zip

- cd site-server

- npm install express --save

- node node-server.js

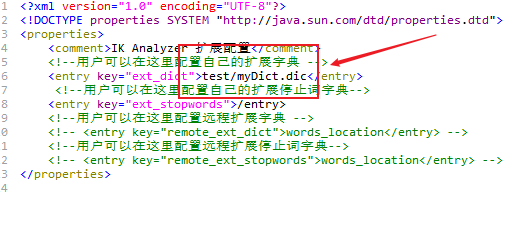

IK分词的相关使用

POST _analyze { "analyzer":"ik_max_word", "text":"我爱你中国" }

GET _analyze { "analyzer": "ik_smart", "text":"年轻人不讲武德" } GET _analyze { "analyzer": "ik_smart", "text":"大意了没有闪" }

GET _analyze

{

"analyzer": "ik_smart",

"text":"年轻人不讲武德"

} GET _analyze

{

"analyzer": "ik_smart",

"text":"大意了没有闪"

}

C#对接使用

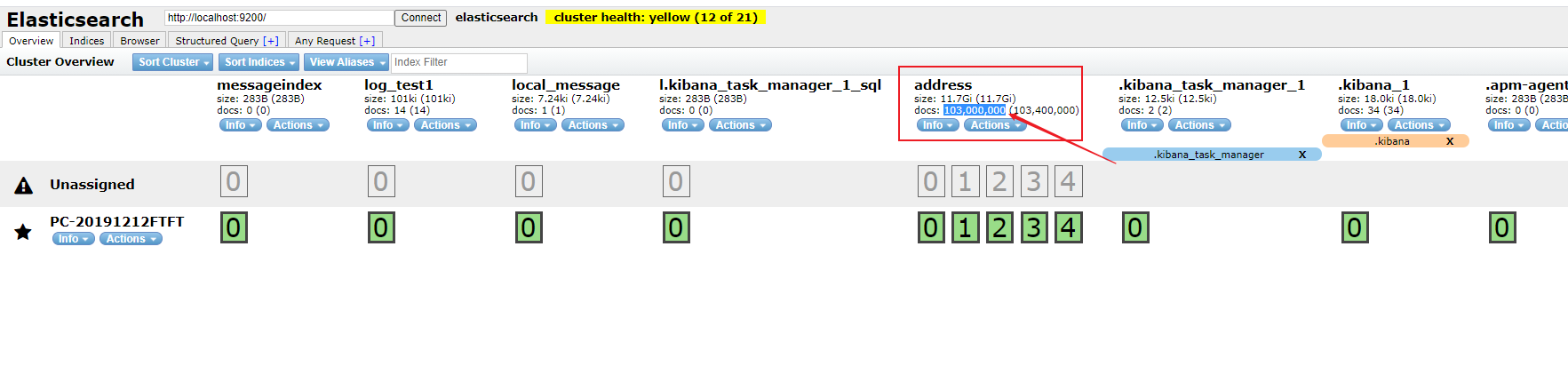

实际运行效果图

ELK搭建以及运行和ElasticStarch的详细使用(7.X版本之上)的更多相关文章

- elk搭建的详细步骤以及说明

一:准备工作 1.准备一台虚拟机 192.168.175.222 elk-node2 2.关闭防火墙以及selinux 命令:systemctl stop firewalld # ...

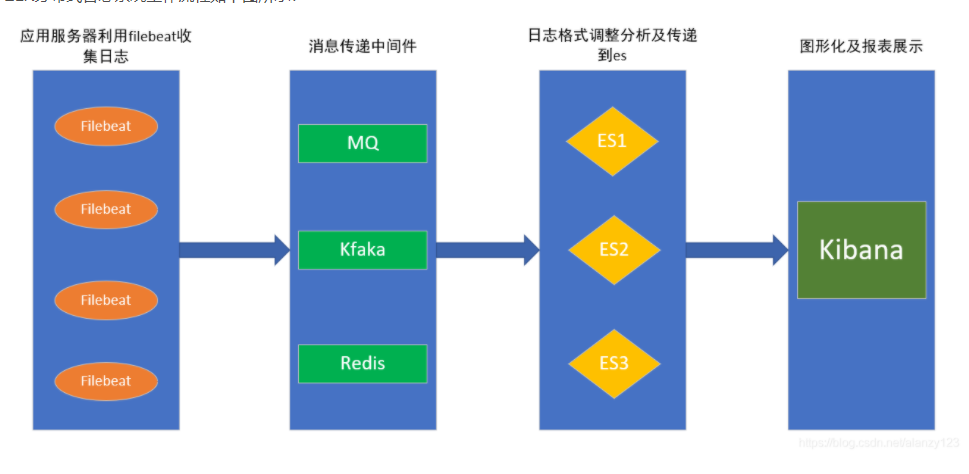

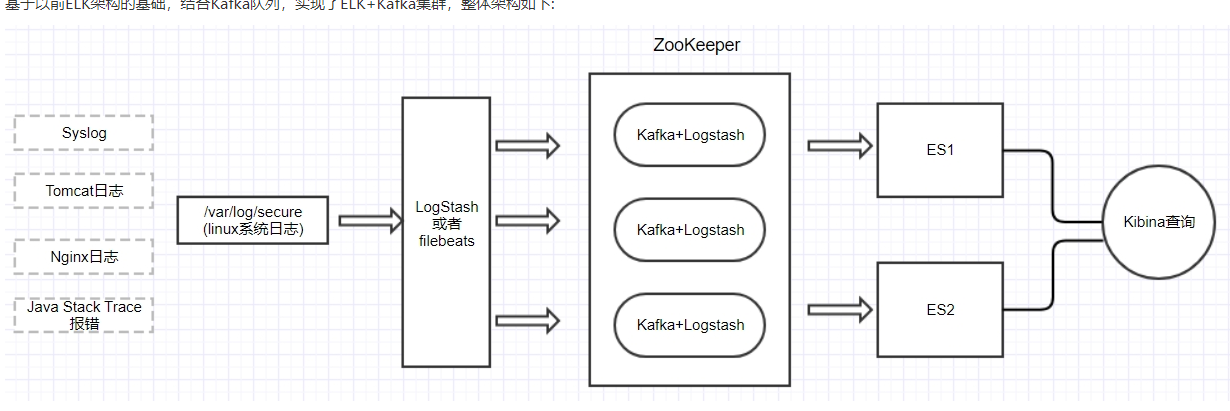

- 基于Kafka+ELK搭建海量日志平台

早在传统的单体应用时代,查看日志大都通过SSH客户端登服务器去看,使用较多的命令就是 less 或者 tail.如果服务部署了好几台,就要分别登录到这几台机器上看,等到了分布式和微服务架构流行时代,一 ...

- 利用 ELK 搭建 Docker 容器化应用日志中心

利用 ELK 搭建 Docker 容器化应用日志中心 概述 应用一旦容器化以后,需要考虑的就是如何采集位于 Docker 容器中的应用程序的打印日志供运维分析.典型的比如SpringBoot应用的日志 ...

- Ubuntu 搭建Web服务器(MySQL+PHP+Apache)详细教程

Ubuntu 搭建Web服务器(MySQL+PHP+Apache)详细教程 看了好多人的博客,有的不全 or 有问题,整理了一下,适合小白 新手先整理几个小问题 1.为啥使用 Linux 搭建服务器? ...

- 2018年ElasticSearch6.2.2教程ELK搭建日志采集分析系统(教程详情)

章节一 2018年 ELK课程计划和效果演示1.课程安排和效果演示 简介:课程介绍和主要知识点说明,ES搜索接口演示,部署的ELK项目演示 es: localhost:9200 k ...

- Asp.net Core + Log4net + ELK 搭建日志中心

原文:Asp.net Core + Log4net + ELK 搭建日志中心 Docker中一键安装ELK 对于这种工具类的东西,第一步就直接到docker的hub中查找了,很幸运,不仅有Elasti ...

- 海量可视化日志分析平台之ELK搭建

ELK是什么? E=ElasticSearch ,一款基于的Lucene的分布式搜索引擎,我们熟悉的github,就是由ElastiSearch提供的搜索,据传已经有10TB+的数据量. L=LogS ...

- ELK搭建(docker环境)

ELK是Elasticsearch.Logstash.Kibana的简称,这三者是核心套件,但并非全部. Elasticsearch是实时全文搜索和分析引擎,提供搜集.分析.存储数据三大功能:是一套开 ...

- 自动化运维工具Ansible详细部署 (转载)

自动化运维工具Ansible详细部署 标签:ansible 原创作品,允许转载,转载时请务必以超链接形式标明文章 原始出处 .作者信息和本声明.否则将追究法律责任.http://sofar.blog. ...

随机推荐

- 02 Writing Your First Program 写你的第一个C程序

Let's print "Hi" 打印输出"Hi" In your first computer program, let's print something ...

- IO那些事

IO(Input\Output): 即输入输出,通常指数据在存储器(内部和外部)或其他周边设备之间的输入和输出,是信息处理系统(例如计算机)与外部世界(可能是人类或另一信息处理系统)之间的通信.说的简 ...

- RHSA-2018:3032-低危: binutils 安全和BUG修复更新

[root@localhost ~]# cat /etc/redhat-release CentOS Linux release 7.2.1511 (Core) 修复命令: 使用root账号登陆She ...

- TP5自定义路由,为了安全性

1,入口文件index.php,不要指定任意模块,不然,自定义路由,就不会有任何效果哦 2,在配置文件 route.php 中引进 use think\Router 自带路由文件 3,将路由进 ...

- iOS企业重签名管理软件之风车签名

这是一款在Mac平台下安全可控的iOS签名管理软件,旨在对签名后的APP能够完全控制,包括APP的开启或禁用.设置到期时间锁.注入第三方动态库文件.设置安装限量.修改APP名称和自定义Bundle I ...

- 【dos】wmic命令

++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++ 磁盘 查看硬盘信息:wmic diskdrive 查看逻辑盘信息:wmic l ...

- java -inally转

1.不管有木有出现异常,finally块中代码都会执行: 2.当try和catch中有return时,finally仍然会执行:3.finally是在return后面的表达式运算后执行的(此时并没有返 ...

- C#数据结构-链栈

上一篇我们通过数组结构实现了栈结构(准确的说是栈的顺序存储结构),现在我们通过链(单链)存储栈,也就是链栈. 通常对于正向单链表来说,是从头节点开始,在链的尾部附加节点,前一个节点的指针指向附加节点: ...

- Mysql架构与内部模块-第二章

接上文,上文简述到了Mysql中的查询缓存和解析器,今日我们继续. 先来看一段SQL:SELECT * FROM `jianghuadong`; 先假设我们数据库中并没有一张名为jianghuadon ...

- [leetcode] 剑指 Offer 专题(一)

又开了一个笔记专题的坑,未来一两周希望能把<剑指Offer>的题目刷完