HDFS核心类FileSystem的使用

一、导入jar包

本次使用的是eclipse操作的,所以需要手动导入jar包

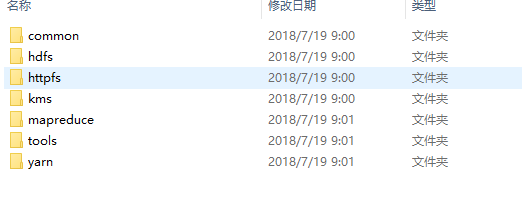

在Hadoop.7.7/share/hadoop里有几个文件夹

common为核心类,此次需要引入common和hdfs两个文件夹下的所有jar包(包括作者写的三个jar包以及lib里面的所有jar包)

连接HDFS的服务

//连接hdfs的服务

@Test

public void connect()

{

Configuration conf=new Configuration();

conf.set("fs.defaultFS", "hdfs://192.168.0.32:9000");

try {

FileSystem fileSystem = FileSystem.get(conf);

FileStatus fileStatus = fileSystem.getFileStatus(new Path("/UPLOAD"));

System.out.println(fileStatus.isFile()); //是不是一个文件

System.out.println(fileStatus.isDirectory()); //是不是一个目录

System.out.println(fileStatus.getPath()); //文件的路径

System.out.println(fileStatus.getLen()); //文件大小

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} }

重命名

在操作重命名是出现错误,是权限不够

执行hadoop fs -chmod 777 / 给予所有操作权限再运行就可以了

//重命名

@Test

public void mv()

{

Configuration conf=new Configuration();

try {

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.0.32:9000"), conf); //连接

boolean rename = fileSystem.rename(new Path("/UPLOAD/jdk-8u221-linux-x64.tar.gz"),new Path("/UPLOAD/jdk1.8.tar.gz"));

System.out.println(rename?"修改成功":"修改失败");

fileSystem.close(); //关闭

} catch (IOException | URISyntaxException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

创建文件夹

//创建文件夹

@Test

public void mkdir()

{

Configuration conf=new Configuration();

try {

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.0.32:9000"),conf); //连接

fileSystem.mkdirs(new Path("/test"));

fileSystem.mkdirs(new Path("/other/hello/world"));

fileSystem.close(); //关闭

} catch (IOException | URISyntaxException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

文件上传

//文件上传

@Test

public void upload()

{

Configuration conf=new Configuration();

try {

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.0.32:9000"),conf);

FSDataOutputStream out = fileSystem.create(new Path("/hadoop.jar"));

FileInputStream in=new FileInputStream(new File("D:\\hadoop.jar"));

byte[]b=new byte[];

int len=;

while((len=in.read(b))!=-)

{

out.write(b,,len);

in.close();

out.close();

}

} catch (IOException | URISyntaxException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

文件下载

//文件下载

@Test

public void download()

{

Configuration conf=new Configuration();

try {

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.0.32:9000"),conf);

FSDataInputStream in = fileSystem.open(new Path("/hadoop.jar"));

FileOutputStream out=new FileOutputStream(new File("D://soft//hadoop.jar"));

byte[]b=new byte[];

int len=;

while((len=in.read(b))!=-)

{

out.write(b,,len);

}

in.close();

out.close();

} catch (IOException | URISyntaxException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} }

遍历文件系统

@Test //遍历文件系统

public void lsr() {

Configuration conf = new Configuration();

try {

FileSystem fileSystem = FileSystem.get(new URI("hdfs://192.168.0.32:9000"),conf);

FileStatus[] status = fileSystem.listStatus(new Path("/"));

for(FileStatus f:status) {

judge(fileSystem,f);

}

fileSystem.close();

} catch (IOException | URISyntaxException e) {

e.printStackTrace();

}

} public void judge(FileSystem fileSystem,FileStatus s) {

String name = s.getPath().toString().split("hdfs://192.168.0.32:9000/")[];

if(s.isDirectory()) {

System.out.println("文件夹: "+name);

try {

FileStatus[] status= fileSystem.listStatus(new Path("/"+name));

for(FileStatus f:status) {

judge(fileSystem,f);

}

} catch (IllegalArgumentException | IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}else {

System.out.println("文件: "+name);

}

}

HDFS核心类FileSystem的使用的更多相关文章

- hadoop之HDFS核心类Filesystem的使用

1.导入jar包,要使用hadoop的HDFS就要导入hadoop-2.7.7\share\hadoop\common下的3个jar包和lib下的依赖包.hadoop-2.7.7\share\hado ...

- Java代码操作HDFS测试类

1.Java代码操作HDFS需要用到Jar包和Java类 Jar包: hadoop-common-2.6.0.jar和hadoop-hdfs-2.6.0.jar Java类: java.net.URL ...

- HDFS 工具类

读取HDFS上文件数据 import java.io.File; import java.io.FileInputStream; import java.io.IOException; import ...

- cesium核心类Viewer简介

1.简单描述Viewer Viewer类是cesium的核心类,是地图可视化展示的主窗口,cesium程序应用的切入口,扮演必不可少的核心角色. 官网的英文解析如下: A base widget fo ...

- HDFS 核心原理

HDFS 核心原理 2016-01-11 杜亦舒 HDFS(Hadoop Distribute File System)是一个分布式文件系统文件系统是操作系统提供的磁盘空间管理服务,只需要我们指定把文 ...

- Webwork 学习之路【03】核心类 ServletDispatcher 的初始化

1. Webwork 与 Xwork 搭建环境需要的的jar 为:webwork-core-1.0.jar,xwork-1.0.jar,搭建webwork 需要xwork 的jar呢?原因是这样的,W ...

- Hibernate核心类用法-使用Transaction管理事务

一个典型的事务应该使用下面的形式 在创建完Session对象后即使用beginTransaction()启动事务 从此开始直到commit()之间的代码 都会处于同一个事务中 这两个函数之间所有的数据 ...

- 理解Lucene索引与搜索过程中的核心类

理解索引过程中的核心类 执行简单索引的时候需要用的类有: IndexWriter.Directory.Analyzer.Document.Field 1.IndexWriter IndexWr ...

- android的消息处理有三个核心类:Looper,Handler和Message。

android的消息处理机制(图+源码分析)——Looper,Handler,Message 作为 一名android程序员,我学习android的一大乐趣是可以通过源码学习google大牛们的设 ...

随机推荐

- 【Thinkphp】记录一次分页的实现

thinkphp分页非常简单 1,控制器渲染数据: $studentList = StudentDb::paginate(5); $this->view->assign('list',$s ...

- SpringMVC开发RESTful接口

概念: 什么是REST? REST是Representational State Transfer的缩写.翻译为"表现层状态转化",restful是一种接口设计风格,它不是一个协议 ...

- XSS 3

打开第三题然后会看到 然后进行一下添加数据 然后会发现数据被添加到 value=""双引号中然后然后我们会想到提前闭合 代码 然后进行编码 然后就可以通过了 此题与xss 2类似 ...

- Java中查询某个日期下所有时间段的数据

除了利用时间段进行查询外,还有一个方法: 利用mybatis中的函数,将datetime转为date <if test="purch_date!= null and purch_dat ...

- 数据库程序接口——JDBC——API解读第三篇——处理结果集的核心对象

核心对象 处理结果集的核心对象有ResultSet和RowSet.其中ResultSet指定关系型数据库的结果集,RowSet更为抽象,凡是由行列组成的数据都可以. ResultSet ResultS ...

- ubuntu建立软链接注意事项

ln 参数 源文件 目标链接文件 -s:代表新建一个软链接,又称符号链接: eg. ln -s /mnt/d/Documents/source.xlsx target.xlsx 1.目标文件的后缀名 ...

- AttributeError: This QueryDict instance is immutable

当写添加注册后端时,运行当运行时,会出现: "AttributeError: This QueryDict instance is immutable": 因为默认的 QueryD ...

- 【强烈推荐,超详细,实操零失误】node.js安装 + npm安装教程 + Vue开发环境搭建

node.js安装 + npm安装教程 + Vue开发环境搭建 [强烈推荐,超详细,实操零失误] 原博客园地址:https://www.cnblogs.com/goldlong/p/8027997.h ...

- word中如何删除一张空白表格

百度知道:https://baijiahao.baidu.com/s?id=1631677477148377412&wfr=spider&for=pc 当word中出现如下一张空白表格 ...

- Java进阶学习(3)之对象容器(上)

对象容器 顺序容器 记事本的例子 UI设计和业务逻辑要分离 接口设计 add(String note); getSize(); getNote(int index); removeNote(index ...