爬虫(七):爬取猫眼电影top100

一:分析网站

目标站和目标数据

目标地址:http://maoyan.com/board/4?offset=20

目标数据:目标地址页面的电影列表,包括电影名,电影图片,主演,上映日期以及评分。

二:上代码

(1):导入相应的包

import requests

from requests.exceptions import RequestException # 处理请求异常

import re

import pymysql

import json

from multiprocessing import Pool

(2):分析网页

通过检查发现需要的内容位于网页中的<dd>标签内。通过翻页发现url中的参数的变化。

(3):获取html网页

# 获取一页的数据

def get_one_page(url):

# requests会产生异常

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36',

}

try:

response = requests.get(url, headers=headers)

if response.status_code == 200: # 状态码是200表示成功

return response.text

else:

return None

except RequestException:

return None

(4):通过正则提取需要的信息 --》正则表达式详情

# 解析网页内容

def parse_one_page(html):

pattern = re.compile(

'<dd>.*?board-index.*?>(\d+)</i>.*?data-src="(.*?)".*?class="name"><a.*?>(.*?)</a>.*?star">(.*?)</p>.*?releasetime">(.*?)</p>.*?integer">(.*?)</i>.*?fraction">(.*?)</i>.*?</dd>',

re.S) # re.S可以匹配任意字符包括换行

items = re.findall(pattern, html) # 将括号中的内容提取出来

for item in items:

yield { # 构造一个生成器

'index': item[0].strip(),

'title': item[2].strip(),

'actor': item[3].strip()[3:],

'score': ''.join([item[5].strip(), item[6].strip()]),

'pub_time': item[4].strip()[5:],

'img_url': item[1].strip(),

}

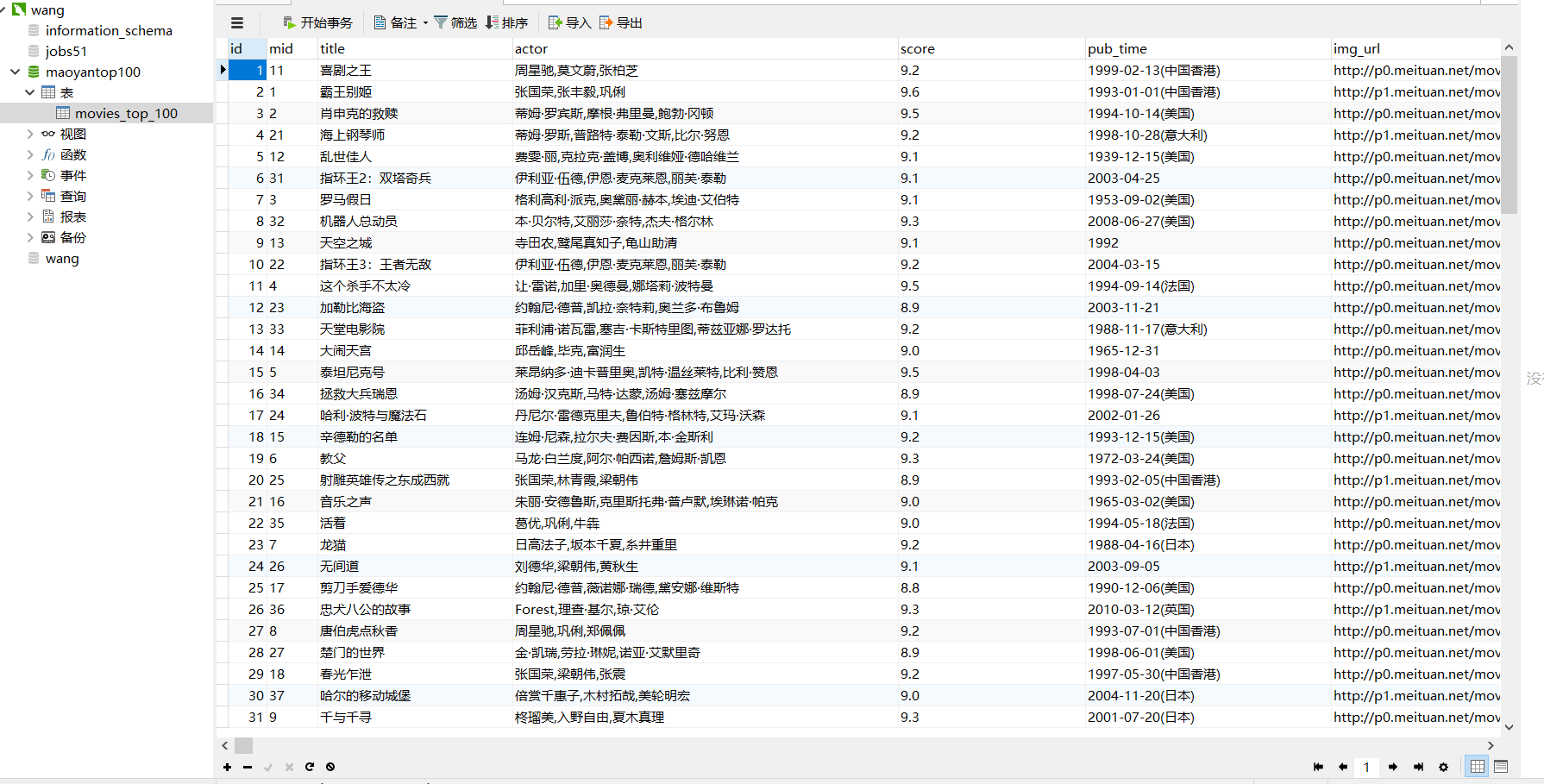

(5):将获取的内容存入mysql数据库

# 连接数据库,首先要在本地创建好数据库

def commit_to_sql(dic):

conn = pymysql.connect(host='localhost', port=3306, user='mydb', passwd='', db='maoyantop100',

charset='utf8')

cursor = conn.cursor(cursor=pymysql.cursors.DictCursor) # 设置游标的数据类型为字典

sql = '''insert into movies_top_100(mid,title,actor,score,pub_time,img_url) values("%s","%s","%s","%s","%s","%s")''' % (

dic['index'], dic['title'], dic['actor'], dic['score'], dic['pub_time'], dic['img_url'],)

cursor.execute(sql) # 执行sql语句并返回受影响的行数

# # 提交

conn.commit()

# 关闭游标

cursor.close()

# 关闭连接

conn.close()

(6):主程序及运行

def main(url):

html = get_one_page(url)

for item in parse_one_page(html):

print(item)

commit_to_sql(item) if __name__ == '__main__':

urls = ['http://maoyan.com/board/4?offset={}'.format(i) for i in range(0, 100, 10)]

# 使用多进程

pool = Pool()

pool.map(main, urls)

(7):最后的结果

完整代码:

# -*- coding: utf-8 -*-

# @Author : FELIX

# @Date : 2018/4/4 9:29 import requests

from requests.exceptions import RequestException

import re

import pymysql

import json

from multiprocessing import Pool # 连接数据库

def commit_to_sql(dic):

conn = pymysql.connect(host='localhost', port=3306, user='wang', passwd='', db='maoyantop100',

charset='utf8')

cursor = conn.cursor(cursor=pymysql.cursors.DictCursor) # 设置游标的数据类型为字典

sql = '''insert into movies_top_100(mid,title,actor,score,pub_time,img_url) values("%s","%s","%s","%s","%s","%s")''' % (

dic['index'], dic['title'], dic['actor'], dic['score'], dic['pub_time'], dic['img_url'],)

cursor.execute(sql) # 执行sql语句并返回受影响的行数

# # 提交

conn.commit()

# 关闭游标

cursor.close()

# 关闭连接

conn.close() # 获取一页的数据

def get_one_page(url):

# requests会产生异常

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36',

}

try:

response = requests.get(url, headers=headers)

if response.status_code == 200: # 状态码是200表示成功

return response.text

else:

return None

except RequestException:

return None # 解析网页内容

def parse_one_page(html):

pattern = re.compile(

'<dd>.*?board-index.*?>(\d+)</i>.*?data-src="(.*?)".*?class="name"><a.*?>(.*?)</a>.*?star">(.*?)</p>.*?releasetime">(.*?)</p>.*?integer">(.*?)</i>.*?fraction">(.*?)</i>.*?</dd>',

re.S) # re.S可以匹配任意字符包括换行

items = re.findall(pattern, html) # 将括号中的内容提取出来

for item in items:

yield { # 构造一个生成器

'index': item[0].strip(),

'title': item[2].strip(),

'actor': item[3].strip()[3:],

'score': ''.join([item[5].strip(), item[6].strip()]),

'pub_time': item[4].strip()[5:],

'img_url': item[1].strip(),

}

# print(items) def write_to_file(content):

with open('result.txt', 'a', encoding='utf8')as f:

f.write(json.dumps(content, ensure_ascii=False) + '\n') ii = 0 def main(url):

html = get_one_page(url)

for item in parse_one_page(html):

global ii

print(ii, item)

ii = ii + 1

commit_to_sql(item)

write_to_file(item) # print(html) if __name__ == '__main__':

urls = ['http://maoyan.com/board/4?offset={}'.format(i) for i in range(0, 100, 10)]

# 使用多进程

pool = Pool()

pool.map(main, urls)

爬虫(七):爬取猫眼电影top100的更多相关文章

- Python爬虫项目--爬取猫眼电影Top100榜

本次抓取猫眼电影Top100榜所用到的知识点: 1. python requests库 2. 正则表达式 3. csv模块 4. 多进程 正文 目标站点分析 通过对目标站点的分析, 来确定网页结构, ...

- 爬虫系列(1)-----python爬取猫眼电影top100榜

对于Python初学者来说,爬虫技能是应该是最好入门,也是最能够有让自己有成就感的,今天在整理代码时,整理了一下之前自己学习爬虫的一些代码,今天先上一个简单的例子,手把手教你入门Python爬虫,爬取 ...

- 50 行代码教你爬取猫眼电影 TOP100 榜所有信息

对于Python初学者来说,爬虫技能是应该是最好入门,也是最能够有让自己有成就感的,今天,恋习Python的手把手系列,手把手教你入门Python爬虫,爬取猫眼电影TOP100榜信息,将涉及到基础爬虫 ...

- PYTHON 爬虫笔记八:利用Requests+正则表达式爬取猫眼电影top100(实战项目一)

利用Requests+正则表达式爬取猫眼电影top100 目标站点分析 流程框架 爬虫实战 使用requests库获取top100首页: import requests def get_one_pag ...

- # [爬虫Demo] pyquery+csv爬取猫眼电影top100

目录 [爬虫Demo] pyquery+csv爬取猫眼电影top100 站点分析 代码君 [爬虫Demo] pyquery+csv爬取猫眼电影top100 站点分析 https://maoyan.co ...

- 40行代码爬取猫眼电影TOP100榜所有信息

主要内容: 一.基础爬虫框架的三大模块 二.完整代码解析及效果展示 1️⃣ 基础爬虫框架的三大模块 1.HTML下载器:利用requests模块下载HTML网页. 2.HTML解析器:利用re正则表 ...

- 用requests库爬取猫眼电影Top100

这里需要注意一下,在爬取猫眼电影Top100时,网站设置了反爬虫机制,因此需要在requests库的get方法中添加headers,伪装成浏览器进行爬取 import requests from re ...

- python 爬取猫眼电影top100数据

最近有爬虫相关的需求,所以上B站找了个视频(链接在文末)看了一下,做了一个小程序出来,大体上没有修改,只是在最后的存储上,由txt换成了excel. 简要需求:爬虫爬取 猫眼电影TOP100榜单 数据 ...

- # 爬虫连载系列(1)--爬取猫眼电影Top100

前言 学习python有一段时间了,之前一直忙于学习数据分析,耽搁了原本计划的博客更新.趁着这段空闲时间,打算开始更新一个爬虫系列.内容大致包括:使用正则表达式.xpath.BeautifulSoup ...

- 爬虫--requests爬取猫眼电影排行榜

'''目标:使用requests分页爬取猫眼电影中榜单栏目中TOP100榜的所有电影信息,并将信息写入文件URL地址:http://maoyan.com/board/4 其中参数offset表示其实条 ...

随机推荐

- 使用uiautomator 截图

1)PC与移动设备建立连接. 2)找到ADB的安装路径,双击启动uiautomator. 路径:D:\ProgramFiles\adt-bundle-windows-x86_64-20140702\a ...

- JPA逆向工程

1.1 说明 所谓的逆向工程就是通过数据库的结构生成代码. 目的:提高开发的效率 1.2 步骤 1.2.1 第一步:创建JPA项目 (1)创建项目 (2)指定项目名.JPA版本 (3)完成创建 1.2 ...

- 记一次纯sqlite数据库的小项目开发经历

sqlite有哪些坑 1.支持的数据量级:根据SQLite的官方提示:http://www.sqlite.org/limits.htmlSQLIte数据库最大支持128TiB(140 terabyte ...

- Oracle触发器编译错误及解决方案

错误 TRIGGER **** 编译错误 错误:PLS-00103: 出现符号 "END"在需要下列之一时: ( begin case declare exit ...

- ajax提交异常解决

一.遇到的问题 在项目中使用ajax提交表单失败,并且后台程序都没有执行,分析具体问题是由于post表单时contenttype的类型不一致. 二.解决方式 $.ajax({ type: 'post' ...

- 什么叫工业4.0,这篇接地气的文章终于讲懂了(ZT)

原地址:https://www.cnblogs.com/namei/p/6110382.html 笔者早年从事过工业自动化行业,后来去了几个城市,讲过<工业互联网与工业文明史>这门课,以至 ...

- MIG(ddr3)工程报错解决:IO constraint DQS_BIAS\Multiple Driver Net

现象 在布线自己写的ddr3压力测试代码时,报如下错误. [Constraints 18-586]IO constraint DQS_BIAS with a setting of TRUE for c ...

- win10 下的 CUDA10.0 +CUDNN + tensorflow + opencv 环境部署

1 CUDA 10.0 安装 win10 下的cuda 安装是非常简单的,和其他程序安装没什么区别,现在 tensorflow 1.13 版本以上 支持 CUDA 10.0 ,这里选取了CUDA 1 ...

- echarts的一点记录

echart官网地址: https://www.echartsjs.com/index.html echarts实例地址:https://echarts.baidu.com/examples/ vue ...

- 第十三篇:socket网络编程

本篇主要介绍网络编程的基础,以及UDP/TCP网络的socket编程,关于UDP套接字聊天器的实现.以及基于TCP套接字的服务器/客户端的实现上传下载功能. 一.网络通信 关于网络通信即通过网络(介质 ...