Apache Lucene学习笔记

Hadoop概述

Apache lucene:

全球第一个开源的全文检索引擎工具包

完整的查询引擎和搜索引擎

部分文本分析引擎

开发人员在此基础建立完整的全文检索引擎

以下为转载:http://www.cnblogs.com/xing901022/p/3933675.htm

首先呢,学习任何一门新的亦或是旧的开源技术,百度其中一二是最简单的办法,先了解其中的大概,思想等等。这里就贡献一个讲解很到位的ppt。已经被我转成了PDF,便于搜藏。

其次,关于第一次编程初探,建议还是查看官方资料。百度到的资料,目前Lucene已经更新到4.9版本,这个版本需要1.7以上的JDK,所以如果还用1.6甚至是1.5的小盆友,请参考低版本,由于我用的1.6,因此在使用Lucene4.0。

这是Lucene4.0的官网文档:http://lucene.apache.org/core/4_0_0/core/overview-summary.html

这里非常佩服Lucene的开元贡献者,可以阅读Lucene in Action,作者最初想要写软件赚钱,最后贡献给了Apache,跑题了。

最后,提醒学习Lucene的小盆友们,这个开源软件的版本更新不慢,版本之间的编程风格亦是不同,所以如果百度到的帖子,可能这段代码,用了4.0或者3.6就会不好使。

比如,以前版本的申请IndexWriter时,是这样的:

IndexWriter indexWriter = new IndexWriter(indexDir,luceneAnalyzer, true );

但是4.0,我们需要配置一个conf,把配置内容放到这个对象中:

IndexWriterConfig config = new IndexWriterConfig(Version.LUCENE_CURRENT, analyzer);

IndexWriter iwriter = new IndexWriter(directory, config);

所以,请一定要参考官方文档的编程风格,进行代码的书写。

最后的最后,从官网上面下载下来的文件,已经上传至百度网盘,欢迎下载。

这是其中最常用的五个文件:

第一个,也是最重要的,Lucene-core-4.0.0.jar,其中包括了常用的文档,索引,搜索,存储等相关核心代码。

第二个,Lucene-analyzers-common-4.0.0.jar,这里面包含了各种语言的词法分析器,用于对文件内容进行关键字切分,提取。

第三个,Lucene-highlighter-4.0.0.jar,这个jar包主要用于搜索出的内容高亮显示。

第四个和第五个,Lucene-queryparser-4.0.0.jar,提供了搜索相关的代码,用于各种搜索,比如模糊搜索,范围搜索,等等。

废话说到这里,下面我们简单的讲解一下什么是全文检索。

比如,我们一个文件夹中,或者一个磁盘中有很多的文件,记事本、world、Excel、pdf,我们想根据其中的关键词搜索包含的文件。例如,我们输入Lucene,所有内容含有Lucene的文件就会被检查出来。这就是所谓的全文检索。

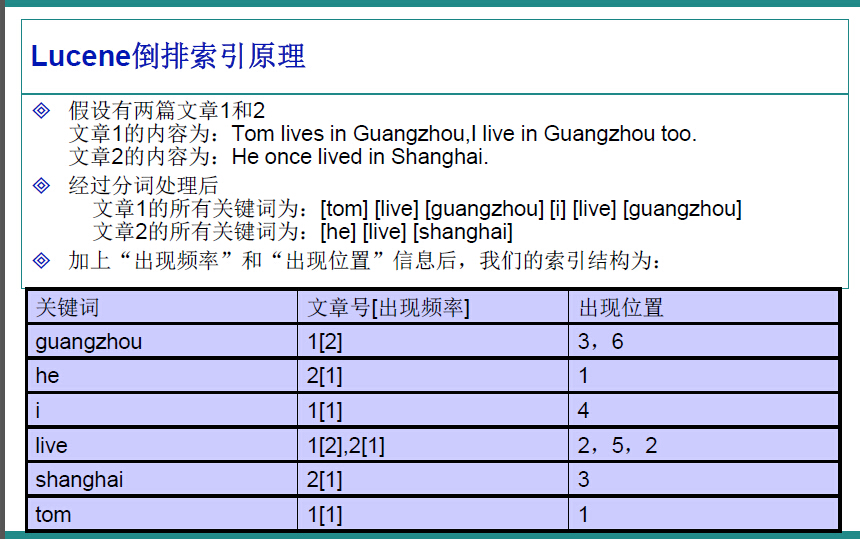

因此,很容易的我们想到,应该建立一个关键字与文件的相关映射,盗用ppt中的一张图,很明白的解释了这种映射如何实现。

在Lucene中,就是使用这种“倒排索引”的技术,来实现相关映射。

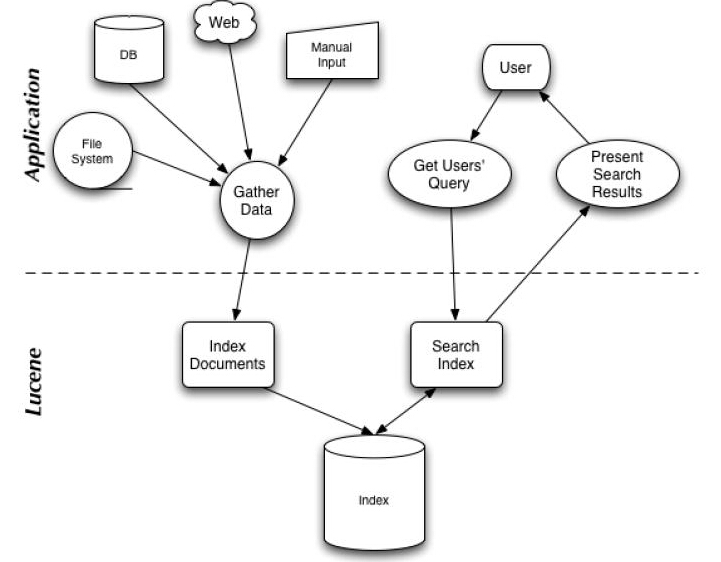

有了这种映射关系,我们就来看看Lucene的架构设计。

下面是Lucene的资料必出现的一张图,但也是其精髓的概括。

我们可以看到,Lucene的使用主要体现在两个步骤:

1 创建索引,通过IndexWriter对不同的文件进行索引的创建,并将其保存在索引相关文件存储的位置中。

2 通过索引查寻关键字相关文档。

下面针对官网上面给出的一个例子,进行分析:

1 Analyzer analyzer = new StandardAnalyzer(Version.LUCENE_CURRENT);

2

3 // Store the index in memory:

4 Directory directory = new RAMDirectory();

5 // To store an index on disk, use this instead:

6 //Directory directory = FSDirectory.open("/tmp/testindex");

7 IndexWriterConfig config = new IndexWriterConfig(Version.LUCENE_CURRENT, analyzer);

8 IndexWriter iwriter = new IndexWriter(directory, config);

9 Document doc = new Document();

10 String text = "This is the text to be indexed.";

11 doc.add(new Field("fieldname", text, TextField.TYPE_STORED));

12 iwriter.addDocument(doc);

13 iwriter.close();

14

15 // Now search the index:

16 DirectoryReader ireader = DirectoryReader.open(directory);

17 IndexSearcher isearcher = new IndexSearcher(ireader);

18 // Parse a simple query that searches for "text":

19 QueryParser parser = new QueryParser(Version.LUCENE_CURRENT, "fieldname", analyzer);

20 Query query = parser.parse("text");

21 ScoreDoc[] hits = isearcher.search(query, null, 1000).scoreDocs;

22 assertEquals(1, hits.length);

23 // Iterate through the results:

24 for (int i = 0; i < hits.length; i++) {

25 Document hitDoc = isearcher.doc(hits[i].doc);

26 assertEquals("This is the text to be indexed.", hitDoc.get("fieldname"));

27 }

28 ireader.close();

29 directory.close();

索引的创建

首先,我们需要定义一个词法分析器。

比如一句话,“我爱我们的中国!”,如何对他拆分,扣掉停顿词“的”,提取关键字“我”“我们”“中国”等等。这就要借助的词法分析器Analyzer来实现。这里面使用的是标准的词法分析器,如果专门针对汉语,还可以搭配paoding,进行使用。

1 Analyzer analyzer = new StandardAnalyzer(Version.LUCENE_CURRENT);

参数中的Version.LUCENE_CURRENT,代表使用当前的Lucene版本,本文环境中也可以写成Version.LUCENE_40。

第二步,确定索引文件存储的位置,Lucene提供给我们两种方式:

1 本地文件存储

Directory directory = FSDirectory.open("/tmp/testindex");

2 内存存储

Directory directory = new RAMDirectory();

可以根据自己的需要进行设定。

第三步,创建IndexWriter,进行索引文件的写入。

IndexWriterConfig config = new IndexWriterConfig(Version.LUCENE_CURRENT, analyzer);

IndexWriter iwriter = new IndexWriter(directory, config);

这里的IndexWriterConfig,据官方文档介绍,是对indexWriter的配置,其中包含了两个参数,第一个是目前的版本,第二个是词法分析器Analyzer。

第四步,内容提取,进行索引的存储。

Document doc = new Document();

String text = "This is the text to be indexed.";

doc.add(new Field("fieldname", text, TextField.TYPE_STORED));

iwriter.addDocument(doc);

iwriter.close();

第一行,申请了一个document对象,这个类似于数据库中的表中的一行。

第二行,是我们即将索引的字符串。

第三行,把字符串存储起来(因为设置了TextField.TYPE_STORED,如果不想存储,可以使用其他参数,详情参考官方文档),并存储“表明”为"fieldname".

第四行,把doc对象加入到索引创建中。

第五行,关闭IndexWriter,提交创建内容。

这就是索引创建的过程。

关键字查询:

第一步,打开存储位置

DirectoryReader ireader = DirectoryReader.open(directory);

第二步,创建搜索器

IndexSearcher isearcher = new IndexSearcher(ireader);

第三步,类似SQL,进行关键字查询

QueryParser parser = new QueryParser(Version.LUCENE_CURRENT, "fieldname", analyzer);

Query query = parser.parse("text");

ScoreDoc[] hits = isearcher.search(query, null, 1000).scoreDocs;

assertEquals(1, hits.length);

for (int i = 0; i < hits.length; i++) {

Document hitDoc = isearcher.doc(hits[i].doc);

assertEquals("This is the text to be indexed.",hitDoc.get("fieldname"));

}

这里,我们创建了一个查询器,并设置其词法分析器,以及查询的“表名“为”fieldname“。查询结果会返回一个集合,类似SQL的ResultSet,我们可以提取其中存储的内容。

关于各种不同的查询方式,可以参考官方手册,或者推荐的PPT

第四步,关闭查询器等。

ireader.close();

directory.close();

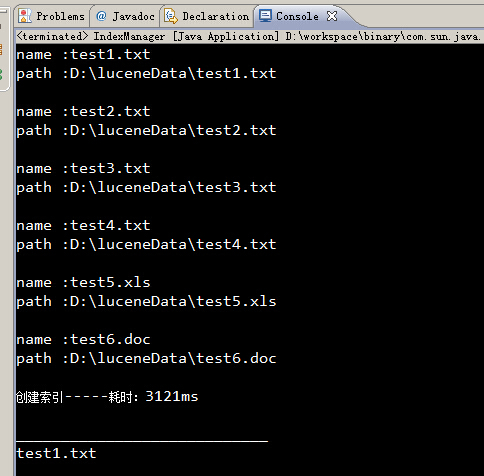

最后,博猪自己写了个简单的例子,可以对一个文件夹内的内容进行索引的创建,并根据关键字筛选文件,并读取其中的内容。

创建索引:

/**

* 创建当前文件目录的索引

* @param path 当前文件目录

* @return 是否成功

*/

public static boolean createIndex(String path){

Date date1 = new Date();

List<File> fileList = getFileList(path);

for (File file : fileList) {

content = "";

//获取文件后缀

String type = file.getName().substring(file.getName().lastIndexOf(".")+1);

if("txt".equalsIgnoreCase(type)){ content += txt2String(file); }else if("doc".equalsIgnoreCase(type)){ content += doc2String(file); }else if("xls".equalsIgnoreCase(type)){ content += xls2String(file); } System.out.println("name :"+file.getName());

System.out.println("path :"+file.getPath());

// System.out.println("content :"+content);

System.out.println(); try{

analyzer = new StandardAnalyzer(Version.LUCENE_CURRENT);

directory = FSDirectory.open(new File(INDEX_DIR)); File indexFile = new File(INDEX_DIR);

if (!indexFile.exists()) {

indexFile.mkdirs();

}

IndexWriterConfig config = new IndexWriterConfig(Version.LUCENE_CURRENT, analyzer);

indexWriter = new IndexWriter(directory, config); Document document = new Document();

document.add(new TextField("filename", file.getName(), Store.YES));

document.add(new TextField("content", content, Store.YES));

document.add(new TextField("path", file.getPath(), Store.YES));

indexWriter.addDocument(document);

indexWriter.commit();

closeWriter(); }catch(Exception e){

e.printStackTrace();

}

content = "";

}

Date date2 = new Date();

System.out.println("创建索引-----耗时:" + (date2.getTime() - date1.getTime()) + "ms\n");

return true;

}

进行查询:

/**

* 查找索引,返回符合条件的文件

* @param text 查找的字符串

* @return 符合条件的文件List

*/

public static void searchIndex(String text){

Date date1 = new Date();

try{

directory = FSDirectory.open(new File(INDEX_DIR));

analyzer = new StandardAnalyzer(Version.LUCENE_CURRENT);

DirectoryReader ireader = DirectoryReader.open(directory);

IndexSearcher isearcher = new IndexSearcher(ireader); QueryParser parser = new QueryParser(Version.LUCENE_CURRENT, "content", analyzer);

Query query = parser.parse(text); ScoreDoc[] hits = isearcher.search(query, null, 1000).scoreDocs; for (int i = 0; i < hits.length; i++) {

Document hitDoc = isearcher.doc(hits[i].doc);

System.out.println("____________________________");

System.out.println(hitDoc.get("filename"));

System.out.println(hitDoc.get("content"));

System.out.println(hitDoc.get("path"));

System.out.println("____________________________");

}

ireader.close();

directory.close();

}catch(Exception e){

e.printStackTrace();

}

Date date2 = new Date();

System.out.println("查看索引-----耗时:" + (date2.getTime() - date1.getTime()) + "ms\n");

}

全部代码:

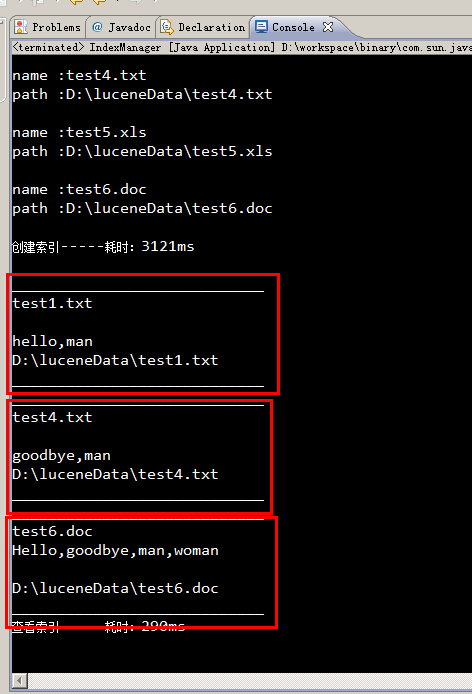

运行结果:

所有包含man关键字的文件,都被筛选出来了。

Apache Lucene学习笔记的更多相关文章

- Lucene学习笔记(更新)

1.Lucene学习笔记 http://www.cnblogs.com/hanganglin/articles/3453415.html

- Apache Flink学习笔记

Apache Flink学习笔记 简介 大数据的计算引擎分为4代 第一代:Hadoop承载的MapReduce.它将计算分为两个阶段,分别为Map和Reduce.对于上层应用来说,就要想办法去拆分算法 ...

- Lucene学习笔记

师兄推荐我学习Lucene这门技术,用了两天时间,大概整理了一下相关知识点. 一.什么是Lucene Lucene即全文检索.全文检索是计算机程序通过扫描文章中的每一个词,对每一个词建立一个索引,指明 ...

- Apache OFBiz 学习笔记 之 服务引擎 二

加载服务定义文件 ofbiz-component.xml:所有的服务定义文件在每个组件的ofbi-component.xml文件中 加载服务定义 例:framework/common/ofbi ...

- Lucene学习笔记1(V7.1)

Lucene是一个搜索类库,solr.nutch和elasticsearch都是基于Lucene.个人感觉学习高级搜索引擎应用程序之前 有必要了解Lucene. 开发环境:idea maven spr ...

- Lucene学习笔记:基础

Lucence是Apache的一个全文检索引擎工具包.可以将采集的数据存储到索引库中,然后在根据查询条件从索引库中取出结果.索引库可以存在内存中或者存在硬盘上. 本文主要是参考了这篇博客进行学习的,原 ...

- Apache Ignite 学习笔记(一): Ignite介绍、部署安装和REST/SQL客户端使用

Apache Ignite 介绍 Ignite是什么呢?先引用一段官网关于Ignite的描述: Ignite is memory-centric distributed database, cachi ...

- lucene学习笔记:三,Lucene的索引文件格式

Lucene的索引里面存了些什么,如何存放的,也即Lucene的索引文件格式,是读懂Lucene源代码的一把钥匙. 当我们真正进入到Lucene源代码之中的时候,我们会发现: Lucene的索引过程, ...

- Lucene学习笔记: 四,Lucene索引过程分析

对于Lucene的索引过程,除了将词(Term)写入倒排表并最终写入Lucene的索引文件外,还包括分词(Analyzer)和合并段(merge segments)的过程,本次不包括这两部分,将在以后 ...

随机推荐

- Windows Azure Storage (20) 使用Azure File实现共享文件夹

<Windows Azure Platform 系列文章目录> Update 2016-4-14.在Azure VM配置FTP和IIS,请参考: http://blogs.iis.net/ ...

- Mongoose Schemas定义中timestamps选项的妙用

在Node.js中使用MongoDB少不了Mongoose. 假设有如下Mongoose Schemas的定义: var ItemSchema = new mongoose.Schema({ biz: ...

- TODO:Linux安装PHP MongoDB驱动

TODO:Linux安装PHP MongoDB驱动 PHP利于学习,使用广泛,主要适用于Web开发领域. MongoDB的主要目标是在键/值存储方式(提供了高性能和高度伸缩性)以及传统的RDBMS系统 ...

- Android开发学习之路-回调机制学习笔记

不知道是我学Java的时候没有认真听还是怎么的,曾经一直不知道什么是“回调”,它有什么用,百度一大堆,都太复杂看不明白(好吧是我笨),所以想把自己理解的分享给其他看到的人,大家都真正认识一下这个重要的 ...

- 2013 duilib入门简明教程 -- XML基础类(7)

现在大家应该对XML描述界面不那么陌生了,那么我们做进一步介绍. 前面的教程我们写了很多代码,为的是让大家了解下基本流程,其实duilib已经对常用的操作做了很好的包装,正式使用时无需像前面的教程那样 ...

- IM消息送达保证机制实现(二):保证离线消息的可靠投递

1.前言 本文的上篇<IM消息送达保证机制实现(一):保证在线实时消息的可靠投递>中,我们讨论了在线实时消息的投递可以通过应用层的确认.发送方的超时重传.接收方的去重等手段来保证业务层面消 ...

- 以Excel 作为Data Source,将data导入db

将Excel作为数据源,将数据导入db,是SSIS的一个简单的应用,下图是示例Excel,数据列是code和name 第一部分,Excel中的数据类型是数值类型 1,使用SSDT创建一个package ...

- 深入浏览器兼容 细数jQuery Hooks 属性篇

关于钩子:http://www.cnblogs.com/aaronjs/p/3387906.html 本章的目的很简单,通过钩子函数更细节的了解浏览器差异与处理方案, 版本是2.0.3所以不兼容ie6 ...

- Math的三个将小数值舍入为整数方法

舍入规则: Math.ceil():执行向上舍入,即它总是将数值向上舍入为最接近的整数: Math.floor():执行向下舍入,即它总是将数值向下舍入为最接近的整数: Math.round():执行 ...

- 深入理解javascript描述元素内容的5个属性

× 目录 [1]innerHTML [2]outerHTML [3]innerText[4]outerText[5]textContent 前面的话 <p>This is a <i& ...