pyspark SparkSession及dataframe基本操作

from pyspark import SparkContext, SparkConf

import os

from pyspark.sql.session import SparkSession

from pyspark.sql import Row def CreateSparkContex():

sparkconf = SparkConf().setAppName("MYPRO").set("spark.ui.showConsoleProgress", "false")

sc = SparkContext(conf=sparkconf)

print("master:" + sc.master)

sc.setLogLevel("WARN")

Setpath(sc)

spark = SparkSession.builder.config(conf=sparkconf).getOrCreate()

return sc, spark def Setpath(sc):

global Path

if sc.master[:5] == "local":

Path = "file:/C:/spark/sparkworkspace"

else:

Path = "hdfs://test" if __name__ == "__main__":

print("Here we go!\n")

sc, spark = CreateSparkContex()

readcsvpath = os.path.join(Path, 'iris.csv')

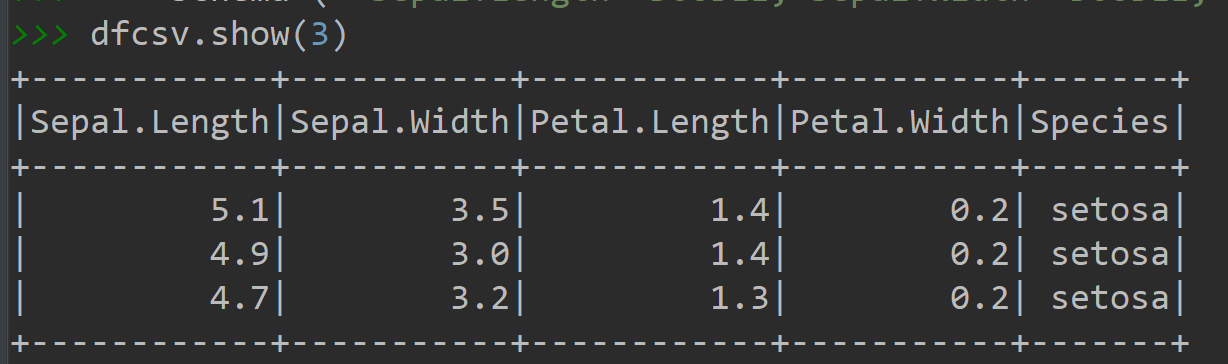

dfcsv = spark.read.csv(readcsvpath, header=True,

schema=("`Sepal.Length` DOUBLE,`Sepal.Width` DOUBLE,`Petal.Length` DOUBLE,`Petal.Width` DOUBLE,`Species` string"))

#指定数据类型读取 dfcsv.show(3) dfcsv.registerTempTable('Iris')#创建并登陆临时表

spark.sql("select * from Iris limit 3").show()#使用sql语句查询

spark.sql("select Species,count(1) from Iris group by Species").show() df = dfcsv.alias('Iris1')#创建一个别名

df.select('Species', '`Sepal.Width`').show(4)#因表头有特殊字符需用反引号``转义

df.select(df.Species,df['`Sepal.Width`']).show(4)

dfcsv.select(df.Species).show(4)#原始名、别名的组合

df[df.Species, df['`Sepal.Width`']].show(4)

df[['Species']]#与pandas相同

df['Species']#注意这是一个字段名 #########增加字段

df[df['`Sepal.Length`'], df['`Sepal.Width`'], df['`Sepal.Length`'] - df['`Sepal.Width`']].show(4)

df[df['`Sepal.Length`'], df['`Sepal.Width`'],

(df['`Sepal.Length`'] - df['`Sepal.Width`']).alias('rua')].show(4)#重命名 #########筛选数据

df[df.Species == 'virginica'].show(4)#与pandas筛选一样

df[(df.Species == 'virginica') & (df['`Sepal.Width`']>1)].show(4)#多条件筛选

df.filter(df.Species == 'virginica').show(4)#也可以用fileter方法筛选

spark.sql("select * from Iris where Species='virginica'").show(4)#sql筛选 ##########多字段排序

spark.sql("select * from Iris order by `Sepal.Length` asc ").show(4)#升序

spark.sql("select * from Iris order by `Sepal.Length` desc ").show(4)#降序

spark.sql("select * from Iris order by `Sepal.Length` asc,`Sepal.Width` desc ").show(4)#升降序 df.select('`Sepal.Length`', '`Sepal.Width`').orderBy('`Sepal.Width`',ascending=0).show(4)#按降序

df.select('`Sepal.Length`', '`Sepal.Width`').orderBy('`Sepal.Width`').show(4) # 升序

df.select('`Sepal.Length`', '`Sepal.Width`').orderBy('`Sepal.Width`', ascending=1).show(4) # 按升序,默认的

df.select('`Sepal.Length`', '`Sepal.Width`').orderBy(df['`Sepal.Width`'].desc()).show(4) # 按降序 df.select('`Sepal.Length`', '`Sepal.Width`').orderBy(

['`Sepal.Length`','`Sepal.Width`'], ascending=[0,1]).show(4)#两个字段按先降序再升序

df.orderBy(df['`Sepal.Length`'].desc(),df['`Sepal.Width`']).show(4) ##########去重

spark.sql("select distinct Species from Iris").show()

spark.sql("select distinct Species,`Sepal.Width` from Iris").show() df.select('Species').distinct().show()

df.select('Species','`Sepal.Width`').distinct().show()

df.select('Species').drop_duplicates().show()#同上,与pandas用法相同

df.select('Species').dropDuplicates().show()#同上 ##########分组统计

spark.sql("select Species,count(1) from Iris group by Species").show()

df[['Species']].groupby('Species').count().show()

df.groupby(['Species']).agg({'`Sepal.Width`': 'sum'}).show()

df.groupby(['Species']).agg({'`Sepal.Width`': 'sum', '`Sepal.Length`': 'mean'}).show() #########联结数据

dic=[['virginica','A1'],['versicolor','A2'],['setosa','A3']]

rrd=sc.parallelize(dic)

df2=rrd.map(lambda p: Row(lei=p[0],al=p[1]))

df2frame=spark.createDataFrame(df2)

df2frame.show()

df2frame.registerTempTable('dictable')

spark.sql("select * from Iris u left join dictable z on u.Species=z.lei").show()

df.join(df2frame, df.Species == df2frame.lei, 'left_outer').show() sc.stop()

spark.stop()

pyspark SparkSession及dataframe基本操作的更多相关文章

- DataFrame基本操作

这些操作在网上都可以百度得到,为了便于记忆自己再根据理解总结在一起.---------励志做一个优雅的网上搬运工 1.建立dataframe (1)Dict to Dataframe df = pd. ...

- 将 数据从数据库 直接通过 pyspark 读入到dataframe

from pyspark.sql import SparkSession spark = SparkSession \ .builder \ .appName("Python Spark S ...

- [Spark SQL] SparkSession、DataFrame 和 DataSet 练习

本課主題 DataSet 实战 DataSet 实战 SparkSession 是 SparkSQL 的入口,然后可以基于 sparkSession 来获取或者是读取源数据来生存 DataFrameR ...

- python做数据分析pandas库介绍之DataFrame基本操作

怎样删除list中空字符? 最简单的方法:new_list = [ x for x in li if x != '' ] 这一部分主要学习pandas中基于前面两种数据结构的基本操作. 设有DataF ...

- 用python做数据分析pandas库介绍之DataFrame基本操作

怎样删除list中空字符? 最简单的方法:new_list = [ x for x in li if x != '' ] 这一部分主要学习pandas中基于前面两种数据结构的基本操作. 设有DataF ...

- pandas库介绍之DataFrame基本操作

怎样删除list中空字符? 最简单的方法:new_list = [ x for x in li if x != '' ] 今天是5.1号. 这一部分主要学习pandas中基于前面两种数据结构的基本操作 ...

- 用python做数据分析4|pandas库介绍之DataFrame基本操作

原文地址 怎样删除list中空字符? 最简单的方法:new_list = [ x for x in li if x != '' ] 今天是5.1号. 这一部分主要学习pandas中基于前面两种数据结构 ...

- 机器学习三剑客之Pandas中DataFrame基本操作

Pandas 是基于Numpy 的一种工具,是为了解决数据分析任务而创建的.Pandas 纳入了大量库和一些标准的数据模型,提供了高效地操作大型数据集所需的工具.Pandas提供了大量能使我们快速便捷 ...

- sparksession创建DataFrame方式

spark创建dataFrame方式有很多种,官方API也比较多 公司业务上的个别场景使用了下面两种方式 1.通过List创建dataFrame /** * Applies a schema to a ...

随机推荐

- php无限级分类

使用递归方法,遍历子类,对数据进行重新排序,使用level进行无限级分类 /** * 功能:无限级分类 * 参数:$data 类别查询结果集 * 返回值:$arr 排序后的数组 */ public f ...

- HYSBZ 1036 树的统计Count (水题树链剖分)

题意:中文题. 析:就是直接维护一个最大值和一个和,用线段树维护即可,这个题很简单,但是我卡了一晚上,就是在定位的时候,位置直接反过来了,但是样例全过了...真是... 代码如下: #pragma c ...

- - Unknown tag (c:set).

<%@ taglib prefix="c" uri="http://java.sun.com/jsp/jstl/core" %>

- C#转java

懂C#的话,转Java也不是那么难,毕竟,语言语法还是相似的.尝试了下Java,说说自己的体会吧. 一,Java和C#都是完全面向对象的语言.在面向对象编程的三大原则方面,这两种语言接近得不能再接近. ...

- 使用web3部署一个比较复杂的智能合约

以太坊系列之二十一 使用web3部署比较复杂的智能合约 搭建私链上的雷电网络 以太坊系列之二十一 使用web3部署比较复杂的智能合约 1 雷电网络智能合约简单介绍 2 remix 无法部署使用了lib ...

- (c++11)随机数------c++程序设计原理与实践(进阶篇)

随机数既是一个实用工具,也是一个数学问题,它高度复杂,这与它在现实世界中的重要性是相匹配的.在此我们只讨论随机数哦最基本的内容,这些内容可用于简单的测试和仿真.在<random>中,标准库 ...

- Delphi XE8中开发DataSnap程序常见问题和解决方法 (三)用TClientDataSet的“ProviderName”属性连接服务器时,无法找到服务器端的“DatasetProvier”

当我们在客户端用TClientDataSet的“ProviderName”属性连接服务器时,无法找到服务器端的“DatasetProvier”!! 问题原因:服务器端对提供服务的控件所属单元选择错误. ...

- BZOJ 1061 [Noi2008]志愿者招募(费用流)

题目描述 申奥成功后,布布经过不懈努力,终于成为奥组委下属公司人力资源部门的主管.布布刚上任就遇到了一个难题:为即将启动的奥运新项目招募一批短期志愿者.经过估算,这个项目需要N 天才能完成,其中第i ...

- audio.play dom对象 JQ不支持play

*/ PausePlayVoice:function() { $("#spPauseAudio").click(function() { ...

- ubuntu下QtCreator启动无响应问题解决

打开Qt后就卡死. 解决方法:删除系统配置目录下的QtProject文件夹: find / -name QtProject 输出: /root/.config/QtProject 删除QtProjec ...