HBase-集群安装

需要先启动 HDFS 集群和 ZooKeeper 集群。

Hadoop 集群安装:https://www.cnblogs.com/jhxxb/p/10629796.html

ZooKeeper 集群安装:https://www.cnblogs.com/jhxxb/p/10744264.html

zkServer.sh start

start-dfs.sh # 不启动 yarn 也可以

start-yarn.sh

一、安装

curl -o /opt/hbase-2.2.-bin.tar.gz http://mirrors.tuna.tsinghua.edu.cn/apache/hbase/2.2.1/hbase-2.2.1-bin.tar.gz tar -zxf /opt/hbase-2.2.-bin.tar.gz -C /opt/

二、配置

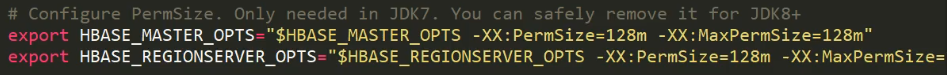

hbase-env.sh

vim /opt/hbase-2.2./conf/hbase-env.sh # The java implementation to use. Java 1.8+ required.

export JAVA_HOME=/opt/jdk1..0_202/ # 不使用自带的 ZK

# Tell HBase whether it should manage it's own instance of ZooKeeper or not.

export HBASE_MANAGES_ZK=false

若是之前的版本还需注释两行配置,不然会报一些警告日志。

hbase-site.xml

可配置项在 hbase-default.xml 中,hbase-default.xml 在 lib/hbase-common-x.x.x.jar 中。

也可在线浏览:https://gitbox.apache.org/repos/asf?p=hbase.git;a=blob;f=hbase-common/src/main/resources/hbase-default.xml;hb=HEAD,或是 GitHub 上。

<configuration>

<!-- 数据在 HDFS 上的路径-->

<property>

<name>hbase.rootdir</name>

<value>hdfs://h136:9000/HBase</value>

</property> <!-- 默认 false,为单机模式 -->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property> <!-- 0.98 后的变动,之前版本没有 port,默认端口为 60000 -->

<property>

<name>hbase.master.port</name>

<value>16000</value>

</property> <property>

<name>hbase.zookeeper.quorum</name>

<value>h136,h138,h140</value>

</property> <property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/opt/apache-zookeeper-3.5.5-bin/zkData</value>

</property> <property>

<name>hbase.unsafe.stream.capability.enforce</name>

<value>false</value>

</property>

</configuration>

regionservers

配置 HBase 集群

h136

h138

h140

软连接 hadoop 配置文件到 HBase

ln -s /opt/hadoop-2.9./etc/hadoop/core-site.xml /opt/hbase-2.2./conf/core-site.xml

ln -s /opt/hadoop-2.9./etc/hadoop/hdfs-site.xml /opt/hbase-2.2./conf/hdfs-site.xml

复制到其它节点

# yum install -y rsync

# rsync -avz /opt/hbase-2.2. h140:/opt/ scp -rq /opt/hbase-2.2./ root@h138:/opt/

scp -rq /opt/hbase-2.2./ root@h140:/opt/

附上环境变量配置(/etc/profile)

export HADOOP_HOME=/opt/hadoop-2.9.2

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin export JAVA_HOME=/opt/jdk1.8.0_202

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$CLASSPATH

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH export KAFKA_HOME=/opt/kafka_2.12-2.3.0

export PATH=$PATH:$KAFKA_HOME/bin export ZOOKEEPER_HOME=/opt/apache-zookeeper-3.5.5-bin

export PATH=$PATH:$ZOOKEEPER_HOME/bin export HBASE_HOME=/opt/hbase-2.2.1

export PATH=$PATH:$HBASE_HOME/bin

三、启动

如果集群之间的节点时间不同步,会导致 regionserver 无法启动,抛出 ClockOutOfSyncException 异常。

同步时间服务或修改属性

<property>

<name>hbase.master.maxclockskew</name>

<value>180000</value>

<description>Time difference of regionserver from master</description>

</property>

1.单节点启动(手动启动所有节点)

hbase-daemon.sh start master

hbase-daemon.sh start regionserver

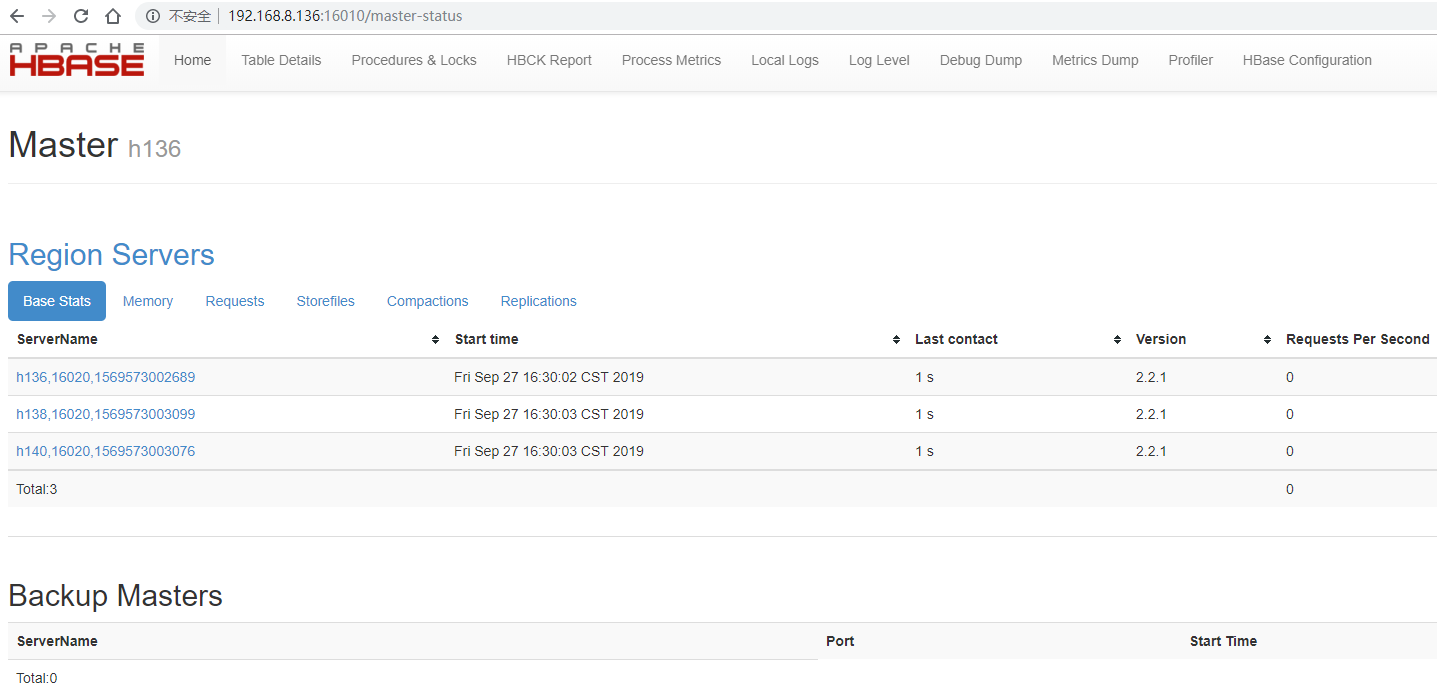

2.集群启动(哪个节点启动 HBase,哪个节点就是 master 角色)

start-hbase.sh

stop-hbase.sh

3.查看 HBase 页面

启动成功后,可以通过 http://IP:16010 的方式来访问 HBase 管理页面。

https://hbase.apache.org/book.html#_configuration_files

https://abloz.com/hbase/book.html#example_config

HBase-集群安装的更多相关文章

- hbase单机环境的搭建和完全分布式Hbase集群安装配置

HBase 是一个开源的非关系(NoSQL)的可伸缩性分布式数据库.它是面向列的,并适合于存储超大型松散数据.HBase适合于实时,随机对Big数据进行读写操作的业务环境. @hbase单机环境的搭建 ...

- HBase集群安装部署

0x01 软件环境 OS: CentOS6.5 x64 java: jdk1.8.0_111 hadoop: hadoop-2.5.2 hbase: hbase-0.98.24 0x02 集群概况 I ...

- Hbase集群安装Version1.1.5

Hbase集群安装,基于版本1.1.5, 使用hbase-1.1.5.tar.gz安装包. 1.安装说明 使用外部Zookeeper集群而非Hbase自带zookeeper, 使用Hadoop文件系统 ...

- hbase集群安装与部署

1.相关环境 centos7 hadoop2.6.5 zookeeper3.4.9 jdk1.8 hbase1.2.4 本篇文章仅涉及hbase集群的搭建,关于hadoop与zookeeper的相关部 ...

- Hbase 集群安装(Hadoop 2.6.0 hbase0.99.2)

一:说明 该安装是在hadoop集群安装后进行,详情可见上一篇博客虚拟机centos7系统下安装hadoop ha和yarn ha(详细) .其中涉及五台机器,两台master(机器名:master, ...

- HBase学习之路 (二)HBase集群安装

前提 1.HBase 依赖于 HDFS 做底层的数据存储 2.HBase 依赖于 MapReduce 做数据计算 3.HBase 依赖于 ZooKeeper 做服务协调 4.HBase源码是java编 ...

- Apache HBase 集群安装文档

简介: Apache HBase 是一个分布式的.面向列的开源 NoSQL 数据库.具有高性能.高可靠性.可伸缩.面向列.分布式存储的特性. HBase 的数据文件最终落地在 HDFS 之上,所以在 ...

- hbase集群安装和shell操作

1.上传hbase安装包 2.解压 3.配置hbase集群,要修改3个文件(首先zk集群已经安装好了) 注意:要把hadoop的hdfs-site.xml和core-site.xml 放到hbase/ ...

- 1.Hbase集群安装配置(一主三从)

1.HBase安装配置,使用独立zookeeper,shell测试 安装步骤:首先在Master(shizhan2)上安装:前提必须保证hadoop集群和zookeeper集群是可用的 1.上传:用 ...

- HBase集群安装

1.HBase的机群搭建过程(在原来的hadoop0上的HBase伪分布基础上进行搭建)1.1 集群结构,主节点(hmaster)是hadoop0,从节点(region server)是hadoop1 ...

随机推荐

- WebService 的发布和调用

WebService 四种发布方式总结 :https://blog.csdn.net/zl834205311/article/details/51612207 调用webService的几种方式 ht ...

- Shell 脚本操作数据库实战

安装mariadb 数据库 (默认没有密码,直接mysql即可进入数据库管理控制台) yum install mariadb mariadb-server mariadb-libs -y syste ...

- Dymola — 多学科系统仿真平台

Dymola 是法国Dassault Systems公司的多学科系统仿真平台,广泛应用于国内外汽车.工业.交通.能源等行业的系统总体架构设计.指标分解以及系统功能验证及优化等.Dymo ...

- mysql 新手入门 官方文档+官方中文文档附地址

点评: 官方文档地址 官方中文文档地址 sql语句扩展

- Spring Boot 项目在 IntelliJ IDEA 中配置 DevTools 实现热部署(macOS 系统)

要配置的内容: 1.Preference -> Build, Execution, Deployment -> Complier -> Build project automatic ...

- Java:JVM的内存模型

JVM内存模型 JVM内存模型可以分为两个部分,如下图所示,堆和方法区是所有线程共有的,而虚拟机栈,本地方法栈和程序计数器则是线程私有的. 1. 堆(Heap) 堆内存是所有线程共有的,可以分为两 ...

- python中的lambda()函数

语句:print map(lambda x:x ** 2,[1,2,3,4,5]) 其中lambda()函数在Python文档,文档中解释如下: lambda An anonymous inline ...

- 如何学好java?

忻州seo:如何学好java?想必对于任何一个在学习java的朋友们,都会在学习过程中遇到一些问题.例如:Java反射机制是什么?小编也是学习java编程的,现在给大家简单介绍一下:Java反射机制就 ...

- [ZJOI2009] 硬币游戏(找规律)

题目 洛谷传送门 题解 把1/21/21/2转化成0/10/10/1,所以直接可以异或. 对于长度为nnn的0/10/10/1数列,发现每变换2k(k>1)2^k(k>1)2k(k> ...

- 使用openoffice转pdf,详细

期由于项目的需求,需要word文档转pdf在线预览,由于一直没有接触这块,所以花了将近四天时间才弄明白. 写这篇文章的主要目的是加深自己的记忆,同时方便以后在用. (最近有使用了这个功能,发现这篇文章 ...