爬虫之解析库BeautifulSoup

介绍

Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据。官方解释如下:

Beautiful Soup提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。 Beautiful Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码。你不需要考虑编码方式,除非文档没有指定一个编码方式,这时,Beautiful Soup就不能自动识别编码方式了。然后,你仅仅需要说明一下原始编码方式就可以了。 Beautiful Soup已成为和lxml、html6lib一样出色的python解释器,为用户灵活地提供不同的解析策略或强劲的速度。

使用方法

(1) 根据标签名查找

- suop.a 只能找到第一个符合要求的标签

(2) 获取属性值

- suop.a.attrs 获取a所有的属性和属性值,返回一个字典

- suop.a.attrs["href"] 获取href属性值

- suop.a["href"] 简写为这种形式

(3) 获取内容

- suop.a.string 获取标签中直系的文本内容

- suop.a.text 获取所有标签中的文本内容

- suop.a.get_text() 获取所有标签中的文本内容

【注意】如果标签中还有标签,那么string获取到的结果为None,其他两个方法可以获取到文本内容

(4) find 找到第一个符合要求的标签

- suop.find("a") 找到第一个符合要求的

# 根据标签中的属性获取指定的a标签

- suop.find("a", class_="xxx") # class是关键字需要加_

- suop.find("a", id="xxx")

- suop.find("a", href="xxx")

- suop.find("a", alt="xxx")

- suop.find("a", tetle="xxx")

# 可以和获取内容的方法连用

- suop.find("a",href="/hecheng/27.html").text

(5) find_all 找到所有符合要求的标签

- suop.find_all("a")

- suop.find_all(["a","p"]) 找到所有a标签和p标签

- suop.find_all(["a","p"],limit=2) 取前两个

(6) 根据选择器选择指定的内容

select:suop.select("#id")

- 常见的选择器:标签选择器(a)|类选择器(.)|id选择器(#)|层级选择器

- 层级选择器:

div .mm div下面所有class属性值为mm的,子子孙孙,下面多级

div > .dd div儿子级class属性为dd的,下面一级

【注意】查询到的是所有数据,返回列表

项目演示

import requests

import lxml

from bs4 import BeautifulSoup

url = "http://www.shicimingju.com/book/sanguoyanyi.html"

response = requests.get(url).text

suop = BeautifulSoup(response,'lxml') # 实例化对象,使用lxml进行解析

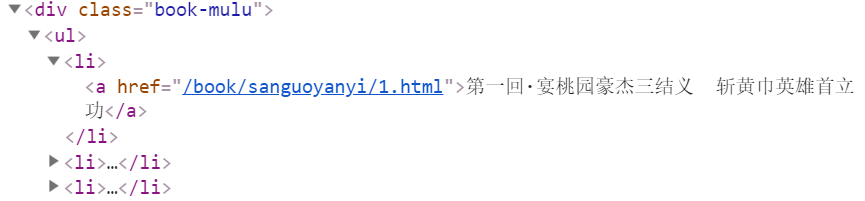

a_list = suop.select('.book-mulu > ul > li > a')

url = "http://www.shicimingju.com"

for a in a_list:

fiction_name = a.string # 小说章节名称

fiction_url = url+a["href"] # 小说章节url地址

response = requests.get(fiction_url).text # 请求每个章节的url地址

suop = BeautifulSoup(response,'lxml')

content = suop.find("div",class_="chapter_content").text # 获取标签内所有文本数据

with open("./{}.txt".format(fiction_name),"w",encoding="utf-8") as fp:

fp.write(content)

print("下载成功!!!")

select选择器选择a标签中的文本内容和gref属性

效果

爬虫之解析库BeautifulSoup的更多相关文章

- Python爬虫【解析库之beautifulsoup】

解析库的安装 pip3 install beautifulsoup4 初始化 BeautifulSoup(str,"解析库") from bs4 import BeautifulS ...

- 爬虫解析库——BeautifulSoup

解析库就是在爬虫时自己制定一个规则,帮助我们抓取想要的内容时用的.常用的解析库有re模块的正则.beautifulsoup.pyquery等等.正则完全可以帮我们匹配到我们想要住区的内容,但正则比较麻 ...

- 爬虫----爬虫解析库Beautifulsoup模块

一:介绍 Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式.Beautiful Soup会帮你 ...

- 爬虫之解析库-----re、beautifulsoup、pyquery

一.介绍 Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式.Beautiful Soup会帮你 ...

- 爬虫解析库BeautifulSoup的一些笔记

BeautifulSoup类使用 基本元素 说明 Tag 标签,最基本的信息组织单元,分别是<>和</>标明开头和结尾 Name 标签的名字,<p></p ...

- 爬虫解析库beautifulsoup

一.介绍 Beautiful Soup是一个可以从HTML或XML文件中提取数据的python库. #安装Beautiful Soup pip install beautifulsoup4 #安装解析 ...

- python爬虫数据解析之BeautifulSoup

BeautifulSoup是一个可以从HTML或者XML文件中提取数据的python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式. BeautfulSoup是python爬虫三 ...

- python爬虫之解析库Beautiful Soup

为何要用Beautiful Soup Beautiful Soup是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式, 是一个 ...

- 解析库beautifulsoup

目录 一.介绍 二.遍历文档树 三.搜索文档树(过滤) 四.修改文档树 五.总结 一.介绍 Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的 ...

随机推荐

- sql注入测试(4)--如何防止该类缺陷发生

检查用户输入的合法性,确信输入的内容只包含合法的数据,数据检查应当在客户端和服务器端都执行之所以要执行服务器端验证,是为了弥补客户端验证机制脆弱的安全性.在客户端,攻击者完全有可能获得网页的源代码,修 ...

- el-table表格错误问题

.el-table--border th.gutter:last-of-type { display: block!important; width: 17px!important; } 如果不行,则 ...

- buffers和cached

buffers和cached是为了提高数据访问性能,减少对磁盘的I/O操作 buffers 用来给块设备做的缓冲大小 例如,目录内容,权限 cached 用来给文件做缓冲 例如,打开的文件 测试 先后 ...

- Image Processing and Analysis_8_Edge Detection:Design of steerable filters for feature detection using canny-like criteria ——2004

此主要讨论图像处理与分析.虽然计算机视觉部分的有些内容比如特 征提取等也可以归结到图像分析中来,但鉴于它们与计算机视觉的紧密联系,以 及它们的出处,没有把它们纳入到图像处理与分析中来.同样,这里面也有 ...

- html和css的一些常用标签使用

HTML(HyperText Mark-up Language)超文本标签语言 <!DOCTYPE html> <!--声明这是一个html文档--> <html> ...

- python将一个字符串写入文件中的编码问题

python2将一个字符串写入文件中: 1.如果字符串是str类型 # -*- coding:utf-8 -*- txtFile="今天天气不错" name = "1.t ...

- 关闭安装包更新使用YUM在Linux中(RHEL / CentOS / Fedora)

YUM (Yellowdog Updater Modified) 是一个开源的命令行工具,以及基于图形的软件包管理工具, 用于基于 RPM (RedHat Package Manager) 的 Li ...

- YOLO---Darknet下的 GPU vs CPU 速度

YOLO---Darknet下的 GPU vs CPU 速度 目录 一.基础环境 二.安装Darknet-yolo v3 三.CPU下测试 四.GPU下测试 五.测试速度对比结论 正文 一.基础环境 ...

- Java基础 FileInputStream/ FileOutputStream / 字节输入流 字节输出流实现文件的复制

FileInputStream/FileOutputStream的笔记: /**(FileInputStream/FileOutputStream四个步骤: ①声明②加载地址③read/write④c ...

- 三种方法给Vmware虚拟机占用空间清理瘦身

随着VMware虚拟机使用时间的增长,其所占用的空间也越来越大,本文来说说怎么给VMware虚拟机占用的空间进行瘦身. 方法一:VMware自带的清理磁盘这个方法是VMware自带,具有普适性,对快照 ...