Python爬取前程无忧网站上python的招聘信息

前言

文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理。

作者: 我姓刘却留不住你的心

PS:如有需要Python学习资料的小伙伴可以加点击下方链接自行获取

http://note.youdao.com/noteshare?id=3054cce4add8a909e784ad934f956cef

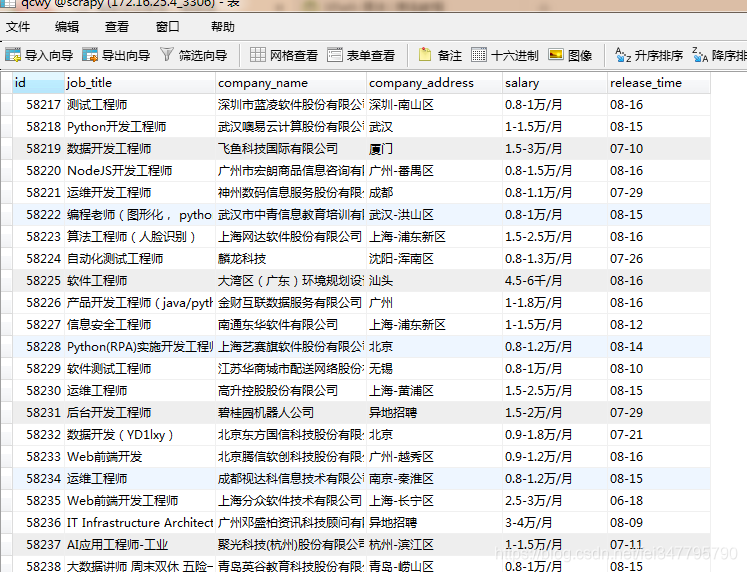

本文获取的字段有为职位名称,公司名称,公司地点,薪资,发布时间

创建爬虫项目

scrapy startproject qianchengwuyou

cd qianchengwuyou

scrapy genspider -t crawl qcwy www.xxx.com

items中定义爬取的字段

import scrapy

class QianchengwuyouItem(scrapy.Item):

# define the fields for your item here like:

job_title = scrapy.Field()

company_name = scrapy.Field()

company_address = scrapy.Field()

salary = scrapy.Field()

release_time = scrapy.Field()

qcwy.py文件内写主程序

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from qianchengwuyou.items import QianchengwuyouItem

class QcwySpider(CrawlSpider):

name = 'qcwy'

# allowed_domains = ['www.xxx.com']

start_urls = ['https://search.51job.com/list/000000,000000,0000,00,9,99,python,2,1.html?']

# https://search.51job.com/list/000000,000000,0000,00,9,99,python,2,7.html?lang=c&postchannel=0000&workyear=99&cotype=99°reefrom=99&jobterm=99&companysize=99&ord_field=0&dibiaoid=0&line=&welfare=

rules = (

Rule(LinkExtractor(allow=r'https://search.51job.com/list/000000,000000,0000,00,9,99,python,2,(\d+).html?'), callback='parse_item', follow=True),

)

def parse_item(self, response):

list_job = response.xpath('//div[@id="resultList"]/div[@class="el"][position()>1]')

for job in list_job:

item = QianchengwuyouItem()

item['job_title'] = job.xpath('./p/span/a/@title').extract_first()

item['company_name'] = job.xpath('./span[1]/a/@title').extract_first()

item['company_address'] = job.xpath('./span[2]/text()').extract_first()

item['salary'] = job.xpath('./span[3]/text()').extract_first()

item['release_time'] = job.xpath('./span[4]/text()').extract_first()

yield item

pipelines.py文件中写下载规则

import pymysql

class QianchengwuyouPipeline(object):

conn = None

mycursor = None

def open_spider(self, spider):

print('链接数据库...')

self.conn = pymysql.connect(host='172.16.25.4', user='root', password='root', db='scrapy')

self.mycursor = self.conn.cursor()

def process_item(self, item, spider):

print('正在写数据库...')

job_title = item['job_title']

company_name = item['company_name']

company_address = item['company_address']

salary = item['salary']

release_time = item['release_time']

sql = 'insert into qcwy VALUES (null,"%s","%s","%s","%s","%s")' % (

job_title, company_name, company_address, salary, release_time)

bool = self.mycursor.execute(sql)

self.conn.commit()

return item

def close_spider(self, spider):

print('写入数据库完成...')

self.mycursor.close()

self.conn.close()

settings.py文件中打开下载管道和请求头

ITEM_PIPELINES = {

'qianchengwuyou.pipelines.QianchengwuyouPipeline': 300,

}

USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/534.57.2 (KHTML, like Gecko) Version/5.1.7 Safari/534.57.2'

运行爬虫,同时写入.json文件

scrapy crawl qcwy -o qcwy.json --nolog

查看数据库是否写入成功,

.

Python爬取前程无忧网站上python的招聘信息的更多相关文章

- 爬取前程无忧网站上python的招聘信息。

本文获取的字段有为职位名称,公司名称,公司地点,薪资,发布时间 创建爬虫项目 scrapy startproject qianchengwuyou cd qianchengwuyou scrapy g ...

- python爬取当当网的书籍信息并保存到csv文件

python爬取当当网的书籍信息并保存到csv文件 依赖的库: requests #用来获取页面内容 BeautifulSoup #opython3不能安装BeautifulSoup,但可以安装Bea ...

- 使用python爬取东方财富网机构调研数据

最近有一个需求,需要爬取东方财富网的机构调研数据.数据所在的网页地址为: 机构调研 网页如下所示: 可见数据共有8464页,此处不能直接使用scrapy爬虫进行爬取,因为点击下一页时,浏览器只是发起了 ...

- [转]使用python爬取东方财富网机构调研数据

最近有一个需求,需要爬取东方财富网的机构调研数据.数据所在的网页地址为: 机构调研 网页如下所示: 可见数据共有8464页,此处不能直接使用scrapy爬虫进行爬取,因为点击下一页时,浏览器只是发起了 ...

- Python爬取散文网散文

配置python 2.7 bs4 requests 安装 用pip进行安装 sudo pip install bs4 sudo pip install requests 简要说明一下bs4的使用因为是 ...

- Python 爬取赶集网租房信息

代码已久,有可能需要调整 #coding:utf-8 from bs4 import BeautifulSoup #有这个bs4不用正则也可以定位要爬取的内容了 from urlparse impor ...

- 利用python爬取贝壳网租房信息

最近准备换房子,在网站上寻找各种房源信息,看得眼花缭乱,于是想着能否将基本信息汇总起来便于查找,便用python将基本信息爬下来放到excel,这样一来就容易搜索了. 1. 利用lxml中的xpath ...

- python爬取返利网中值得买中的数据

先使用以前的方法将返利网的数据爬取下来,scrapy框架还不熟练,明日再战scrapy 查找目标数据使用的是beautifulsoup模块. 1.观察网页,寻找规律 打开值得买这块内容 1>分析 ...

- Python爬取网址中多个页面的信息

通过上一篇博客了解到爬取数据的操作,但对于存在多个页面的网址来说,使用上一篇博客中的代码爬取下来的资料并不完整.接下来就是讲解该如何爬取之后的页面信息. 一.审查元素 鼠标移至页码处右键,选择检查元素 ...

随机推荐

- C#添加错误日志信息

错误日志是软件用来记录运行时出错信息的文本文件.编程人员和维护人员等可以利用错误日志对系统进行调试和维护. 系统日志 系统日志包含了由Windows系统组件记录的事件.例如,在启动期间装入驱动程序或其 ...

- [译]ASP.NET:WebForms vs MVC

原文示例(VS2012): 1. Download Simple WebForm demo - 6.7 KB 2. Download Simple MVC Demo demo - 1.5 MB 介 ...

- 微软、IBM、GitLab 等大厂全部到齐的 OCS 第一天有什么看点?

在本周一的推文中我们大致介绍了下 Open Core 峰会及到场嘉宾,(≧▽≦) 当然还有 Nebula Graph 在会场的展位位置图,本文我们来看看 Open Core 峰会第一天有哪些值得一看的 ...

- C#时间戳与时间相互转换

代码: using System; using System.Collections.Generic; using System.Linq; using System.Text; using Syst ...

- django简单密码加密和效验

通过django自带的类库,来加密解密很方便,下面来简单介绍下: 导入包: from django.contrib.auth.hashers import make_password, check_p ...

- goweb-搭建服务

web应用简介 Web 应用在我们的生活中无处不在.看看我们日常使用的各个应用程序,它们要 么是 Web 应用,要么是移动 App 这类 Web 应用的变种.无论哪一种编程语言,只要 它能够开发出与人 ...

- Java分布式系统---消息中间件

简介 消息中间件也可以称消息队列,是指用高效可靠的消息传递机制进行与平台无关的数据交流,并基于数据通信来进行分布式系统的集成.通过提供消息传递和消息队列模型,可以在分布式环境下扩展进程的通信.当下主流 ...

- Linux 操作系统的权限为什么是1,2,4 而不是 1,2,3?如何用二进制来做权限管理

1.二进制做权限的优点 大家都知道,在Linux操作系统中,x - 可执行权限,w - 可写权限 , r - 可读权限.其权限值分别是1,2,4,但是有没有想过为什么是1,2,4 而不是 1,2,3 ...

- 【Web前端】VS code 快捷键tips 【陆续记录】

学习资料为:chuanzhiheima培训资料,freecodecamp300小时基础前端,<精编CSS第三版>,<Node.js 开发指南>(BYvoid编著,淘宝买的二手书 ...

- NCCL(Nvidia Collective multi-GPU Communication Library) Nvidia英伟达的Multi-GPU多卡通信框架NCCL 学习;PCIe 速率调研;

为了了解,上来先看几篇中文博客进行简单了解: 如何理解Nvidia英伟达的Multi-GPU多卡通信框架NCCL?(较为优秀的文章) 使用NCCL进行NVIDIA GPU卡之间的通信(GPU卡通信模式 ...