Node.js 爬虫爬取电影信息

Node.js 爬虫爬取电影信息

我的CSDN地址:https://blog.csdn.net/weixin_45580251/article/details/107669713

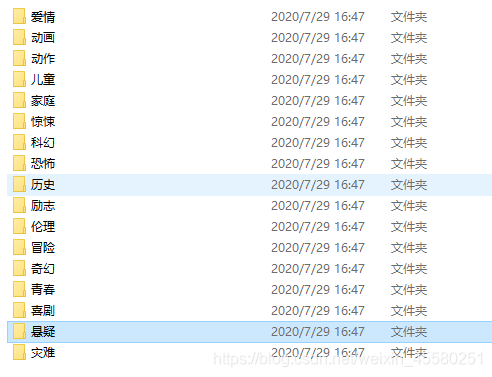

爬取的是1905电影网的信息,使用的是正则匹配。

本来为了更好地学习异步编程打好基础,没想到这玩意这么上头。

代码也写了好几天,自己技术不到家,肯定有写的不好的地方,还需要多努力。

下个月争取把vue学完,九月估计该开学了。

代码在最下面

const request=require('request');

const url="https://www.1905.com/vod/list/n_1/o3p1.html";

const fs=require('fs');

const { resolve } = require('path');

function req(url){

return new Promise((resolve,reject)=>{

request.get(url,(err,response,body)=>{

if(err) reject(err)

else resolve({response,body});

})

})

}

//获取起始界面的所有分类地址

async function getClassUrl(){

let {response,body}=await req(url);

// console.log(body);

let reg1=/<span class="search-index-L">类型 :<\/span>(.*?)<div class="grid-12x">/igs; //i不区分大小写 g全局 s让.匹配换行

let result1=reg1.exec(body)[1];

let reg2=/<a href="javascript\:void\(0\);" onclick="location\.href='(.*?)';return false;"(.*?)>(.*?)<\/a>/igs;

let result2="";

// console.log(reg2.exec(result1));

let urlArr=[];

while(result2=reg2.exec(result1)){

if(result2[3]!="全部"){

let obj={

className:result2[3],

url:result2[1]

}

urlArr.push(obj);

fs.mkdir("./movies/"+result2[3],{ recursive: true },(err) => {

if (err) throw err;

});

getMovies(result2[1],result2[3]);

// console.log(result2.index);

// console.log(reg2.lastIndex);

}

}

// console.log(urlArr.length); //17个分类

};

//通过分类栏,获取页面中的电影连接

async function getMovies(url,className){

let {response,body}=await req(url);

let reg3=/<a class="pic-pack-outer" target="_blank" href="(.*?)".*?><img/igs;

let result3="";

let urlArr=[];

while(result3=reg3.exec(body)){

urlArr.push(result3[1]);

getDate(result3[1],className);

}

}

//对电影详情页进行分析

async function getDate(url,className){

let {response,body}=await req(url);

let reg1=/<h1 class="playerBox-info-name playerBox-info-cnName">(.*?)<\/h1>/;

// let reg4=/<!-- 文字简介 -->.*?<span id="playerBoxIntroCon">(.*?)<a href="(.*?)" target="_blank" data-hrefexp="fr=vodplay_ypzl_xx">\.\.\.<span>[详细]/;

let result1=reg1.exec(body);

// console.log(result1[1]);

let reg2=/<span id="playerBoxIntroCon">(.*?)<a href="(.*?)" /;

let result2=reg2.exec(body);

// console.log(result2[2]);

writeFile(result1,result2,url,className);

}

//写入文件

async function writeFile(result1,result2,url,className){

let movie={

name:result1[1],

brief:result2[1],

url:url,

details:result2[2]

};

let data=JSON.stringify(movie);

fs.writeFile(`./movies/${className}/${movie.name}.json`,data,(err)=>{

if (err) {return console.log(err)}

});

//下面的写入流写法也可以

// let w = fs.createWriteStream(`./movies/${className}/${movie.name}.json`);

// w.write(data,'utf-8');

// w.end;

// w.on('error', function(err){

// console.log(err.stack);

// });

};

getClassUrl();

Node.js 爬虫爬取电影信息的更多相关文章

- Node.js爬虫-爬取慕课网课程信息

第一次学习Node.js爬虫,所以这时一个简单的爬虫,Node.js的好处就是可以并发的执行 这个爬虫主要就是获取慕课网的课程信息,并把获得的信息存储到一个文件中,其中要用到cheerio库,它可以让 ...

- 养只爬虫当宠物(Node.js爬虫爬取58同城租房信息)

先上一个源代码吧. https://github.com/answershuto/Rental 欢迎指导交流. 效果图 搭建Node.js环境及启动服务 安装node以及npm,用express模块启 ...

- node.js爬虫爬取拉勾网职位信息

简介 用node.js写了一个简单的小爬虫,用来爬取拉勾网上的招聘信息,共爬取了北京.上海.广州.深圳.杭州.西安.成都7个城市的数据,分别以前端.PHP.java.c++.python.Androi ...

- 手把手教你用Node.js爬虫爬取网站数据

个人网站 https://iiter.cn 程序员导航站 开业啦,欢迎各位观众姥爷赏脸参观,如有意见或建议希望能够不吝赐教! 开始之前请先确保自己安装了Node.js环境,还没有安装的的童鞋请自行百度 ...

- node js 爬虫爬取静态页面,

先打一个简单的通用框子 //根据爬取网页的协议 引入对应的协议, http||https var http = require('https'); //引入cheerio 简单点讲就是node中的jq ...

- node:爬虫爬取网页图片

代码地址如下:http://www.demodashi.com/demo/13845.html 前言 周末自己在家闲着没事,刷着微信,玩着手机,发现自己的微信头像该换了,就去网上找了一下头像,看着图片 ...

- 一个简单python爬虫的实现——爬取电影信息

最近在学习网络爬虫,完成了一个比较简单的python网络爬虫.首先为什么要用爬虫爬取信息呢,当然是因为要比人去收集更高效. 网络爬虫,可以理解为自动帮你在网络上收集数据的机器人. 网络爬虫简单可以大致 ...

- Python多线程爬虫爬取电影天堂资源

最近花些时间学习了一下Python,并写了一个多线程的爬虫程序来获取电影天堂上资源的迅雷下载地址,代码已经上传到GitHub上了,需要的同学可以自行下载.刚开始学习python希望可以获得宝贵的意见. ...

- 用java编写爬虫爬取电影

一.爬取前提1)本地安装了mysql数据库2)安装了idea或者eclipse等开发工具 二.爬取内容 电影名称.电影简介.电影图片.电影下载链接 三.爬取逻辑1)进入电影网列表页, 针对列表的htm ...

随机推荐

- 后羿:我射箭了快上—用MotionLayout实现王者荣耀团战

前言 昨晚跟往常一样,饭后开了一局王者荣耀,前中期基本焦灼,到了后期一波决定胜负的时候,我果断射箭,射中对面,配合队友直接秒杀,打赢团战一波推完基地.那叫一个精彩,队友都发出了666666的称赞,我酷 ...

- sql 删除所有存储过程

1.执行以下sql语句即可删除所有存储过程 --/**********删除所有存储过程*************************/-- use 数据库名 go declare @tname v ...

- html中object标签

首先将这个强大web页面打印例子(pintTest.html)贴上来. <!DOCTYPE HTML PUBLIC "-//W3C//DTD HTML 4.0 Transitional ...

- MySQL数据库基础-1

数据库原理 数据时代 信息创造价值 -结构化数据 关系完整,密切 -非结构化数据 数据散乱,相互关系不大 -半结构化数据 XML HTML 也不是完全没有结构,也不是特别规矩 MySQL适合管理结构化 ...

- 【转】time 模块详解(时间获取和转换)

转自鱼C论坛--https://fishc.com.cn/forum.php?mod=viewthread&tid=51326&highlight=time time 模块 -- 时间 ...

- SSM中 spring-mvc.xml 配置文件

<!--扫描控制器包--><context:component-scan base-package="<!--控制器包所在路径-->">< ...

- ES7 - 11新特性总结

es7 1 Array.prototype.includes 之前都是使用indexOf判断,没有返回-1,现在includes更加方便 Includes 方法用来检测数组中是否包含某个元素,返回bo ...

- mysql 架构简介

mysql的逻辑架构 第一层:进行连接处理.权限认证.安全校验等. 当客户端(应用)连接到mysql服务器时,服务器会创建使用一个线程进行处理连接(少量的线程服务大量的连接),随后服务器需要对该连接进 ...

- Stream(四)

public class Test { /* * 创建:一步 * 中间:0~n步 * 终结:一步 * * 三.终结操作 * 1.void forEach(Consumer ):遍历流中的数据 * 2. ...

- Hive源码解析

date: 2020-07-08 15:12:00 updated: 2020-08-21 17:38:00 Hive源码解析 入口:hive-cli-1.1.0-cdh5.14.4.jar!/org ...