Python爬虫教程-03-使用 chardet 检测编码

Spider-03-使用chardet

继续学习python爬虫,我们经常出现解码问题,因为所有的页面编码都不统一,我们使用chardet检测页面的编码,尽可能的减少编码问题的出现

网页编码问题解决

- 使用chardet 可以自动检测页面文件的编码格式,但是也有可能出错

- 需要安装chardet,

- 如果使用Anaconda环境,使用下面命令:

conda install chardet

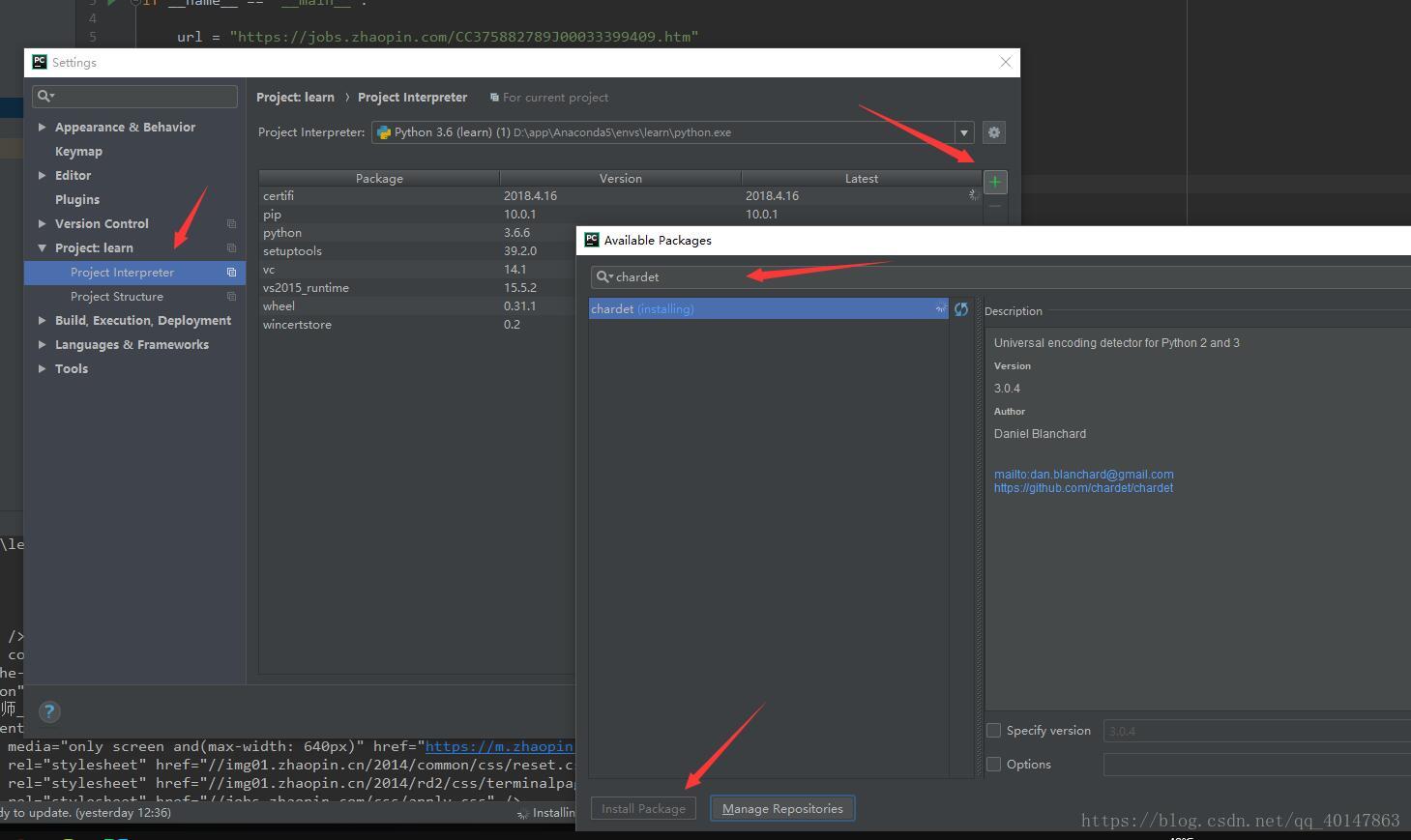

- 如果不是,就自己手动在【PyCharm】>【file】>【settings】>【Project Interpreter】>【+】>【chardet】>【install】

具体操作截图:

案例v2

- py03chardet.py文件:https://xpwi.github.io/py/py爬虫/py03chardet.py

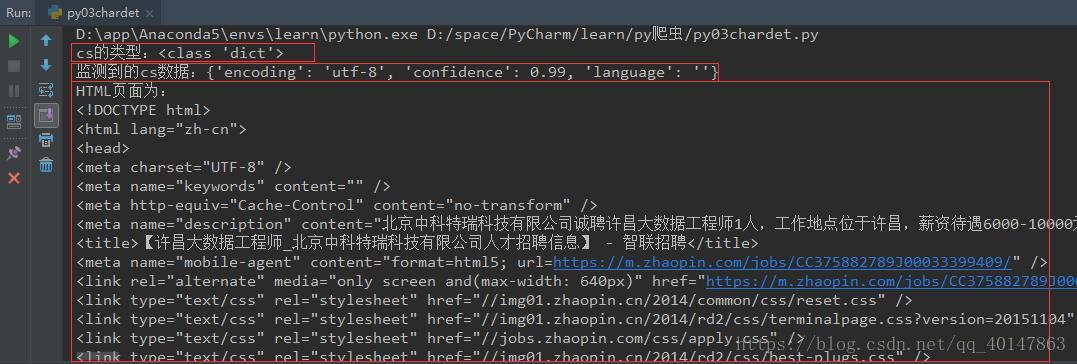

# py03chardet.py# 使用request下载页面,并自动检测页面编码from urllib import requestimport chardetif __name__ == '__main__':url = 'https://jobs.zhaopin.com/CC375882789J00033399409.htm'rsp = request.urlopen(url)# 按住Ctrl键不送,同时点击urlopen,可以查看文档,有函数的具体参数和使用方法html = rsp.read()cs = chardet.detect(html)print("cs的类型:{0}".format(type(cs)))print("监测到的cs数据:{0}".format(cs))html = html.decode(cs.get("encoding", "utf-8"))# 意思是监测到就使用监测到的,监测不到就使用utf-8print("HTML页面为:\n%s" % html)

右键运行,截图如下

编码检测就介绍完了,最要的功能是检测页面的编码,尽可能的减少编码问题的出现

更多文章链接:Python 爬虫随笔

- 本笔记不允许任何个人和组织转载

Python爬虫教程-03-使用 chardet 检测编码的更多相关文章

- Python爬虫教程-01-爬虫介绍

Spider-01-爬虫介绍 Python 爬虫的知识量不是特别大,但是需要不停和网页打交道,每个网页情况都有所差异,所以对应变能力有些要求 爬虫准备工作 参考资料 精通Python爬虫框架Scrap ...

- Python爬虫教程-00-写在前面

鉴于好多人想学Python爬虫,缺没有简单易学的教程,我将在CSDN和大家分享Python爬虫的学习笔记,不定期更新 基础要求 Python 基础知识 Python 的基础知识,大家可以去菜鸟教程进行 ...

- Python爬虫教程-31-创建 Scrapy 爬虫框架项目

本篇是介绍在 Anaconda 环境下,创建 Scrapy 爬虫框架项目的步骤,且介绍比较详细 Python爬虫教程-31-创建 Scrapy 爬虫框架项目 首先说一下,本篇是在 Anaconda 环 ...

- Python爬虫教程-30-Scrapy 爬虫框架介绍

从本篇开始学习 Scrapy 爬虫框架 Python爬虫教程-30-Scrapy 爬虫框架介绍 框架:框架就是对于相同的相似的部分,代码做到不出错,而我们就可以将注意力放到我们自己的部分了 常见爬虫框 ...

- Python爬虫教程-08-post介绍(百度翻译)(下)

Python爬虫教程-08-post介绍(下) 为了更多的设置请求信息,单纯的通过urlopen已经不太能满足需求,此时需要使用request.Request类 构造Request 实例 req = ...

- Python爬虫教程-07-post介绍(百度翻译)(上)

Python爬虫教程-07-post介绍(百度翻译)(上) 访问网络两种方法 get: 利用参数给服务器传递信息 参数为dict,使用parse编码 post :(今天给大家介绍的post) 一般向服 ...

- Python爬虫教程-28-Selenium 操纵 Chrome

我觉得本篇是很有意思的,闲着没事来看看! Python爬虫教程-28-Selenium 操纵 Chrome PhantomJS 幽灵浏览器,无界面浏览器,不渲染页面.Selenium + Phanto ...

- Python爬虫教程-23-数据提取-BeautifulSoup4(一)

Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据,查看文档 https://www.crummy.com/software/BeautifulSoup/bs4/doc. ...

- Python爬虫教程-19-数据提取-正则表达式(re)

本篇主页内容:match的基本使用,search的基本使用,findall,finditer的基本使用,匹配中文,贪婪与非贪婪模式 Python爬虫教程-19-数据提取-正则表达式(re) 正则表达式 ...

随机推荐

- java源码解析之Object类

一.Object类概述 Object类是java中类层次的根,是所有类的基类.在编译时会自动导入.Object中的方法如下: 二.方法详解 Object的方法可以分成两类,一类是被关键字fin ...

- [BZOJ 5155][Tjoi2014]电源插排

传送门 网上大部分题解都写得是动态开点线段树,然而像\(MiEcoku\)这么懒惰的显然不会去写线段树... \(\color{green}{solution}\) 我们考虑来点骚操作. 线段树维护的 ...

- (二)Audio子系统之new AudioRecord()

在上一篇文章<(一)Audio子系统之AudioRecord.getMinBufferSize>中已经介绍了AudioRecord如何获取最小缓冲区大小,接下来,继续分析AudioReco ...

- css的reset和常用的html标签的默认样式整理

先看下常用的这些标签浏览器的默认样式有哪些: body{ margin: 8px;} hr{ border:1px inset; margin-top:.5em;margin-bottom:.5em; ...

- MongoDB ver 4 几个常用命令

1. 为某个数据库创建用户: use db_test1; db.createUser({ user:"test_user_1", pwd:"test_user_1_pwd ...

- django.core.exceptions.ImproperlyConfigured: The SECRET_KEY setting must not be empty

https://www.e-learn.cn/content/wangluowenzhang/165461 问题: I created a new project in django and past ...

- 窗口大小调整后处理事件jQuery插件ResizeEnd

需要引入的文件: <script src="js/jquery.min.js"></script> <script src="js/jQue ...

- 【文档】五、Mysql Binlog事件结构

这个部分描述了事件被写入binlog或者delay log中的属性.所有的事件有相同的整体结构,也就是包含事件头和事件数据: +===================+ | event header ...

- 3-0 js基础 语言特性及性能优化

1.语言特性: 内存泄露:内存没有释放,越堆越多. 垃圾回收(生命周期): 1.局部 很短 在局部中当函数完成时.已经释放了.全局变量在页面关闭的时候才被回收. 2.全局 很长 3.闭包.可长可短,只 ...

- archlinux安装gnome的一些坑随记

问题1:网络设置无法查看,提示缺少NetworkManager 解决:安装networkmanager库,因为gnome调用的是networkmanager这个软件来管理网络的.然后要启动它:sudo ...