爬虫之scrapy框架

解析

Scrapy解释

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。 其可以应用在数据挖掘,信息处理或存储历史数据等一系列的程序中。

其最初是为了页面抓取 (更确切来说, 网络抓取 )所设计的, 也可以应用在获取API所返回的数据(例如 Amazon Associates Web Services ) 或者通用的网络爬虫。Scrapy用途广泛,可以用于数据挖掘、监测和自动化测试。

Scrapy 使用了 Twisted异步网络库来处理网络通讯。整体架构大致如下

Scrapy组件

①引擎(Scrapy)

用来处理整个系统的数据流处理, 触发事务(框架核心)

②调度器(Scheduler)

用来接受引擎发过来的请求, 压入队列中, 并在引擎再次请求的时候返回. 可以想像成一个URL(抓取网页的网址或者说是链接)的优先队列,

由它来决定下一个要抓取的网址是什么, 同时去除重复的网址

③下载器(Downloader)

用于下载网页内容, 并将网页内容返回给蜘蛛(Scrapy下载器是建立在twisted这个高效的异步模型上的)

④爬虫(Spiders)

爬虫是主要干活的, 用于从特定的网页中提取自己需要的信息, 即所谓的实体(Item)。用户也可以从中提取出链接,让Scrapy继续抓取下一个页面

⑤项目管道(Pipeline)

负责处理爬虫从网页中抽取的实体,主要的功能是持久化实体、验证实体的有效性、清除不需要的信息。当页面被爬虫解析后,

将被发送到项目管道,并经过几个特定的次序处理数据。

⑥下载器中间件(Downloader Middlewares)

位于Scrapy引擎和下载器之间的框架,主要是处理Scrapy引擎与下载器之间的请求及响应。

⑦爬虫中间件(Spider Middlewares)

介于Scrapy引擎和爬虫之间的框架,主要工作是处理蜘蛛的响应输入和请求输出。

⑧调度中间件(Scheduler Middewares)

介于Scrapy引擎和调度之间的中间件,从Scrapy引擎发送到调度的请求和响应。

Scrapy运行流程

引擎从调度器中取出一个链接(URL)用于接下来的抓取

引擎把URL封装成一个请求(Request)传给下载器

下载器把资源下载下来,并封装成应答包(Response)

爬虫解析Response

解析出实体(Item),则交给实体管道进行进一步的处理

解析出的是链接(URL),则把URL交给调度器等待抓取

安装

在python3并不能完全支持Scrapy,因此为了完美运行Scrapy,我们使用python2.7来编写和运行Scrapy。

pip install Scrapy

注:windows平台需要依赖pywin32,请根据自己系统32/64位选择下载安装,https://sourceforge.net/projects/pywin32/

其它可能依赖的安装包:lxml-3.6.4-cp27-cp27m-win_amd64.whl,VCForPython27.msi

依赖包下载:http://pan.baidu.com/s/1eSdVdx4

使用

创建项目

运行命令:

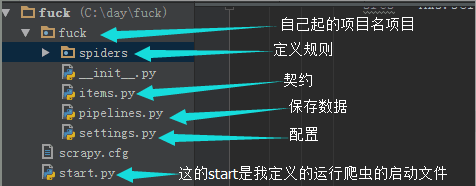

scrapy startproject fuck # fuck这是我起的项目名

项目创建后会自动创建几个目录

文件说明:

scrapy.cfg 项目的配置信息,主要为Scrapy命令行工具提供一个基础的配置信息。(真正爬虫相关的配置信息在settings.py文件中)

items.py 设置数据存储模板,用于结构化数据,如:Django的Model

pipelines 数据处理行为,如:一般结构化的数据持久化

settings.py 配置文件,如:递归的层数、并发数,延迟下载等

spiders 爬虫目录,如:创建文件,编写爬虫规则

注意:一般创建爬虫文件时,以网站域名命名

编写爬虫

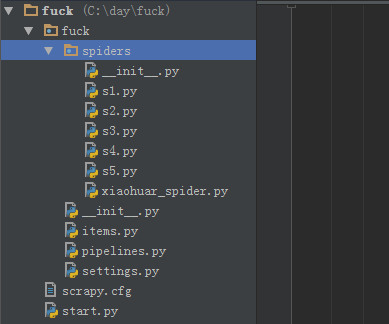

在spiders目录中新建一系列的定义规则的 xxx.py 文件(文件名自己写);

示例代码:

#!/usr/bin/env python

# -*- coding:utf-8 -*-

import scrapy class XiaoHuarSpider(scrapy.spiders.Spider):

name = "s1"

# allowed_domains = ["xiaohuar.com"]

start_urls = [

"http://www.xiaohuar.com/hua/",

] def parse(self, response):

# print(response, type(response))

# from scrapy.http.response.html import HtmlResponse

# print(response.body_as_unicode()) current_url = response.url # 爬取时请求的url

body = response.body # 返回的html

unicode_body = response.body_as_unicode() # 返回的html unicode编码

print body

注意:

1.爬虫文件需要定义一个类,并继承scrapy.spiders.Spider

2.必须定义name,即爬虫名,如果没有name,会报错。

3.编写函数parse,这里需要注意的是,该函数名不能改变,因为Scrapy源码中默认callback函数的函数名就是parse;

4.定义需要爬取的url,放在列表中,因为可以爬取多个url,Scrapy源码是一个For循环,从上到下爬取这些url,使用生成器迭代将url发送给下载器下载url的html

运行

在PyCharm中有相当方便的地方,很好的解决了我们多余的操作。

运行命令:

scrapy crawl s1 --nolog # s1是项目名,见上面的代码s1在哪。

格式:scrapy crawl 项目名 --nolog nolog意思是不显示日志

Scrapy查询

Scrapy内部支持更简单的查询语法,帮助我们在html中查询我们需要的标签和标签内容以及标签属性。

下面以div标签为例:

//div 表示查询某个标签的所有div标签

/div 表示查询某个标签的儿子

//div[@class='item_list'] 表示找到所有的div下属性为class='item_list'的

//div[@class='item_list']/div 表示找到这个div的所有儿子

//div[@class='item_list']//span 表示找在这个div下的子子孙孙中的所有span标签

//div[@class='item_list']//a/text() 表示找在这个div下的子子孙孙中的所有a标签并获得所有a标签的内容

//div[@class='item_list']//img/@src 表示找在这个div下的子子孙孙中的所有img标签并获得所有img标签的src属性

示例:

#!/usr/bin/env python

# -*- coding:utf-8 -*-

import scrapy

from scrapy.http import Request

from scrapy.selector import HtmlXPathSelector

import re

import urllib

import os class XiaoHuarSpider(scrapy.spiders.Spider):

name = "xiaohuar"

allowed_domains = ["xiaohuar.com"]

start_urls = [

"http://www.xiaohuar.com/list-1-1.html",

] def parse(self, response):

# 分析页面

# 找到页面中符合规则的内容(校花图片),保存

# 找到所有的a标签,再访问其他a标签,一层一层的搞下去 hxs = HtmlXPathSelector(response) # 创建查询对象 # 如果url是 http://www.xiaohuar.com/list-1-\d+.html

if re.match('http://www.xiaohuar.com/list-1-\d+.html', response.url):

items = hxs.select('//div[@class="item_list infinite_scroll"]/div') # //表示找到所有的div

for i in range(len(items)):

# 查询所有img标签的src属性,即获取校花图片地址

srcs = hxs.select('//div[@class="item_list infinite_scroll"]'

'/div[%d]//div[@class="img"]/a/img/@src' % i).extract()

# 获取span的文本内容,即校花姓名

names = hxs.select('//div[@class="item_list infinite_scroll"]'

'/div[%d]//div[@class="img"]/span/text()' % i).extract()

# 获取a的文本内容,即学校名

schools = hxs.select('//div[@class="item_list infinite_scroll"]'

'/div[%d]//div[@class="img"]/div[@class="btns"]/a/text()' % i).extract()

if srcs and names and schools: # 拿到第一个学校的校花图片和名字

print names[0], schools[0], srcs[0]

if srcs:

ab_src = "http://www.xiaohuar.com" + srcs[0] # 拼接绝对路径;就是要爬的url的地址 # 文件名,以自己的名字命名;因为python27默认编码格式是unicode编码,因此我们需要编码成utf-8

file_name = "%s_%s.jpg" % (schools[0].encode('utf-8'), names[0].encode('utf-8'))

file_path = os.path.join("E:\\picture", file_name) # 存放下载图片的路径;E:\\picture是我本地存放路径

urllib.urlretrieve(ab_src, file_path)

递归访问

以上的爬虫仅仅是爬去初始页,而我们爬虫是需要源源不断的执行下去,直到所有的网页被执行完毕

#!/usr/bin/env python

# -*- coding:utf-8 -*-

import scrapy

from scrapy.http import Request

from scrapy.selector import HtmlXPathSelector

import re

import urllib

import os class XiaoHuarSpider(scrapy.spiders.Spider):

name = "xiaohuar"

allowed_domains = ["xiaohuar.com"]

start_urls = [

"http://www.xiaohuar.com/list-1-1.html",

] def parse(self, response):

# 分析页面

# 找到页面中符合规则的内容(校花图片),保存

# 找到所有的a标签,再访问其他a标签,一层一层的搞下去 hxs = HtmlXPathSelector(response) # 创建查询对象 # 如果url是 http://www.xiaohuar.com/list-1-\d+.html

if re.match('http://www.xiaohuar.com/list-1-\d+.html', response.url):

items = hxs.select('//div[@class="item_list infinite_scroll"]/div') # //表示找到所有的div

for i in range(len(items)):

# 查询所有img标签的src属性,即获取校花图片地址

srcs = hxs.select('//div[@class="item_list infinite_scroll"]'

'/div[%d]//div[@class="img"]/a/img/@src' % i).extract()

# 获取span的文本内容,即校花姓名

names = hxs.select('//div[@class="item_list infinite_scroll"]'

'/div[%d]//div[@class="img"]/span/text()' % i).extract()

# 获取a的文本内容,即学校名

schools = hxs.select('//div[@class="item_list infinite_scroll"]'

'/div[%d]//div[@class="img"]/div[@class="btns"]/a/text()' % i).extract()

if srcs and names and schools: # 拿到第一个学校的校花图片和名字

print names[0], schools[0], srcs[0]

if srcs:

ab_src = "http://www.xiaohuar.com" + srcs[0] # 拼接绝对路径;就是要爬的url的地址 # 文件名,以自己的名字命名;因为python27默认编码格式是unicode编码,因此我们需要编码成utf-8

file_name = "%s_%s.jpg" % (schools[0].encode('utf-8'), names[0].encode('utf-8'))

file_path = os.path.join("E:\\picture", file_name) # 存放下载图片的路径

urllib.urlretrieve(ab_src, file_path) # 获取所有的url,继续访问,并在其中寻找相同的url

all_urls = hxs.select('//a/@href').extract()

for url in all_urls:

if url.startswith('http://www.xiaohuar.com/list-1-'):

yield Request(url, callback=self.parse) # 递归的找下去

以上代码将符合规则的页面中的图片保存在指定目录,并且在HTML源码中找到所有的其他 a 标签的href属性,从而“递归”的执行下去,直到所有的页面都被访问过为止。

以上代码之所以可以进行“递归”的访问相关URL,关键在于parse方法使用了 yield Request对象。

即通过yield生成器向每一个url发送request请求,并执行返回函数parse,从而递归获取校花图片和校花姓名学校等信息。

注:可以修改settings.py 中的配置文件,以此来指定“递归”的层数,如: DEPTH_LIMIT = 1

正则选择

语法规则:Selector(response=response查询对象).xpath('//li[re:test(@class, "item-\d*")]//@href').extract(),

即根据re正则匹配,test即匹配,属性名是class,匹配的正则表达式是"item-\d*",然后获取该标签的href属性。

from scrapy.selector import Selector

from scrapy.http import HtmlResponse

html = """<!DOCTYPE html>

<html>

<head lang="en">

<meta charset="UTF-8">

<title></title>

</head>

<body>

<li class="item-"><a href="link.html">first item</a></li>

<li class="item-0"><a href="link1.html">first item</a></li>

<li class="item-1"><a href="link2.html">second item</a></li>

</body>

</html>

"""

response = HtmlResponse(url='http://example.com', body=html,encoding='utf-8')

ret = Selector(response=response).xpath('//li[re:test(@class, "item-\d*")]//@href').extract()

print(ret)

正则选择器

#!/usr/bin/env python

# -*- coding:utf-8 -*- import scrapy

import hashlib

from tutorial.items import JinLuoSiItem

from scrapy.http import Request

from scrapy.selector import HtmlXPathSelector class JinLuoSiSpider(scrapy.spiders.Spider):

count = 0

url_set = set() name = "jluosi"

domain = 'http://www.jluosi.com'

allowed_domains = ["jluosi.com"] start_urls = [

"http://www.jluosi.com:80/ec/goodsDetail.action?jls=QjRDNEIzMzAzOEZFNEE3NQ==",

] def parse(self, response):

md5_obj = hashlib.md5()

md5_obj.update(response.url)

md5_url = md5_obj.hexdigest()

if md5_url in JinLuoSiSpider.url_set:

pass

else:

JinLuoSiSpider.url_set.add(md5_url)

hxs = HtmlXPathSelector(response)

if response.url.startswith('http://www.jluosi.com:80/ec/goodsDetail.action'):

item = JinLuoSiItem()

item['company'] = hxs.select('//div[@class="ShopAddress"]/ul/li[1]/text()').extract()

item['link'] = hxs.select('//div[@class="ShopAddress"]/ul/li[2]/text()').extract()

item['qq'] = hxs.select('//div[@class="ShopAddress"]//a/@href').re('.*uin=(?P<qq>\d*)&')

item['address'] = hxs.select('//div[@class="ShopAddress"]/ul/li[4]/text()').extract() item['title'] = hxs.select('//h1[@class="goodsDetail_goodsName"]/text()').extract() item['unit'] = hxs.select('//table[@class="R_WebDetail_content_tab"]//tr[1]//td[3]/text()').extract()

product_list = []

product_tr = hxs.select('//table[@class="R_WebDetail_content_tab"]//tr')

for i in range(2,len(product_tr)):

temp = {

'standard':hxs.select('//table[@class="R_WebDetail_content_tab"]//tr[%d]//td[2]/text()' %i).extract()[0].strip(),

'price':hxs.select('//table[@class="R_WebDetail_content_tab"]//tr[%d]//td[3]/text()' %i).extract()[0].strip(),

}

product_list.append(temp) item['product_list'] = product_list

yield item current_page_urls = hxs.select('//a/@href').extract()

for i in range(len(current_page_urls)):

url = current_page_urls[i]

if url.startswith('http://www.jluosi.com'):

url_ab = url

yield Request(url_ab, callback=self.parse)

选择器规则--Demo

def parse(self, response):

from scrapy.http.cookies import CookieJar

cookieJar = CookieJar()

cookieJar.extract_cookies(response, response.request)

print(cookieJar._cookies)

获取响应--Cookies

更多选择器规则:http://scrapy-chs.readthedocs.io/zh_CN/latest/topics/selectors.html

格式化处理

上述实例只是简单的图片处理,所以在parse方法中直接处理。如果对于想要获取更多的数据(获取页面的价格、商品名称、QQ等),则可以利用Scrapy的items将数据格式化,然后统一交由pipelines来处理。

在items.py中创建类:

# -*- coding: utf-8 -*- # Define here the models for your scraped items

#

# See documentation in:

# http://doc.scrapy.org/en/latest/topics/items.html import scrapy class JieYiCaiItem(scrapy.Item): company = scrapy.Field()

title = scrapy.Field()

qq = scrapy.Field()

info = scrapy.Field()

more = scrapy.Field()

上述定义模板,以后对于从请求的源码中获取的数据同意按照此结构来获取,所以在spider中需要有一下操作:

#!/usr/bin/env python

# -*- coding:utf-8 -*- import scrapy

import hashlib

from beauty.items import JieYiCaiItem

from scrapy.http import Request

from scrapy.selector import HtmlXPathSelector

from scrapy.spiders import CrawlSpider, Rule

from scrapy.linkextractors import LinkExtractor class JieYiCaiSpider(scrapy.spiders.Spider):

count = 0

url_set = set() name = "jieyicai"

domain = 'http://www.jieyicai.com'

allowed_domains = ["jieyicai.com"] start_urls = [

"http://www.jieyicai.com",

] rules = [

#下面是符合规则的网址,但是不抓取内容,只是提取该页的链接(这里网址是虚构的,实际使用时请替换)

#Rule(SgmlLinkExtractor(allow=(r'http://test_url/test?page_index=\d+'))),

#下面是符合规则的网址,提取内容,(这里网址是虚构的,实际使用时请替换)

#Rule(LinkExtractor(allow=(r'http://www.jieyicai.com/Product/Detail.aspx?pid=\d+')), callback="parse"),

] def parse(self, response):

md5_obj = hashlib.md5()

md5_obj.update(response.url)

md5_url = md5_obj.hexdigest()

if md5_url in JieYiCaiSpider.url_set:

pass

else:

JieYiCaiSpider.url_set.add(md5_url) hxs = HtmlXPathSelector(response)

if response.url.startswith('http://www.jieyicai.com/Product/Detail.aspx'):

item = JieYiCaiItem()

item['company'] = hxs.select('//span[@class="username g-fs-14"]/text()').extract()

item['qq'] = hxs.select('//span[@class="g-left bor1qq"]/a/@href').re('.*uin=(?P<qq>\d*)&')

item['info'] = hxs.select('//div[@class="padd20 bor1 comard"]/text()').extract()

item['more'] = hxs.select('//li[@class="style4"]/a/@href').extract()

item['title'] = hxs.select('//div[@class="g-left prodetail-text"]/h2/text()').extract()

yield item current_page_urls = hxs.select('//a/@href').extract()

for i in range(len(current_page_urls)):

url = current_page_urls[i]

if url.startswith('/'):

url_ab = JieYiCaiSpider.domain + url

yield Request(url_ab, callback=self.parse)

spider

此处代码的关键在于:

- 将获取的数据封装在了Item对象中

- yield Item对象 (一旦parse中执行yield Item对象,则自动将该对象交个pipelines的类来处理)

# -*- coding: utf-8 -*- # Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: http://doc.scrapy.org/en/latest/topics/item-pipeline.html import json

from twisted.enterprise import adbapi

import MySQLdb.cursors

import re mobile_re = re.compile(r'(13[0-9]|15[012356789]|17[678]|18[0-9]|14[57])[0-9]{8}')

phone_re = re.compile(r'(\d+-\d+|\d+)') class JsonPipeline(object): def __init__(self):

self.file = open('/Users/wupeiqi/PycharmProjects/beauty/beauty/jieyicai.json', 'wb') def process_item(self, item, spider):

line = "%s %s\n" % (item['company'][0].encode('utf-8'), item['title'][0].encode('utf-8'))

self.file.write(line)

return item class DBPipeline(object): def __init__(self):

self.db_pool = adbapi.ConnectionPool('MySQLdb',

db='DbCenter',

user='root',

passwd='',

cursorclass=MySQLdb.cursors.DictCursor,

use_unicode=True) def process_item(self, item, spider):

query = self.db_pool.runInteraction(self._conditional_insert, item)

query.addErrback(self.handle_error)

return item def _conditional_insert(self, tx, item):

tx.execute("select nid from company where company = %s", (item['company'][0], ))

result = tx.fetchone()

if result:

pass

else:

phone_obj = phone_re.search(item['info'][0].strip())

phone = phone_obj.group() if phone_obj else ' ' mobile_obj = mobile_re.search(item['info'][1].strip())

mobile = mobile_obj.group() if mobile_obj else ' ' values = (

item['company'][0],

item['qq'][0],

phone,

mobile,

item['info'][2].strip(),

item['more'][0])

tx.execute("insert into company(company,qq,phone,mobile,address,more) values(%s,%s,%s,%s,%s,%s)", values) def handle_error(self, e):

print 'error',e pipelines

pipelines

上述代码中多个类的目的是,可以同时保存在文件和数据库中,保存的优先级可以在配置文件settings中定义。

ITEM_PIPELINES = {

'beauty.pipelines.DBPipeline': 300,

'beauty.pipelines.JsonPipeline': 100,

}

# 每行后面的整型值,确定了他们运行的顺序,item按数字从低到高的顺序,通过pipeline,通常将这些数字定义在0-1000范围内。

更多详见:http://www.cnblogs.com/wupeiqi/articles/5354900.html

爬虫之scrapy框架的更多相关文章

- Python网络爬虫之Scrapy框架(CrawlSpider)

目录 Python网络爬虫之Scrapy框架(CrawlSpider) CrawlSpider使用 爬取糗事百科糗图板块的所有页码数据 Python网络爬虫之Scrapy框架(CrawlSpider) ...

- 爬虫06 /scrapy框架

爬虫06 /scrapy框架 目录 爬虫06 /scrapy框架 1. scrapy概述/安装 2. 基本使用 1. 创建工程 2. 数据分析 3. 持久化存储 3. 全栈数据的爬取 4. 五大核心组 ...

- Python逆向爬虫之scrapy框架,非常详细

爬虫系列目录 目录 Python逆向爬虫之scrapy框架,非常详细 一.爬虫入门 1.1 定义需求 1.2 需求分析 1.2.1 下载某个页面上所有的图片 1.2.2 分页 1.2.3 进行下载图片 ...

- Python爬虫进阶(Scrapy框架爬虫)

准备工作: 配置环境问题什么的我昨天已经写了,那么今天直接安装三个库 首先第一步: ...

- 爬虫之Scrapy框架介绍

Scrapy介绍 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内 ...

- 16.Python网络爬虫之Scrapy框架(CrawlSpider)

引入 提问:如果想要通过爬虫程序去爬取”糗百“全站数据新闻数据的话,有几种实现方法? 方法一:基于Scrapy框架中的Spider的递归爬取进行实现(Request模块递归回调parse方法). 方法 ...

- python爬虫随笔-scrapy框架(1)——scrapy框架的安装和结构介绍

scrapy框架简介 Scrapy,Python开发的一个快速.高层次的屏幕抓取和web抓取框架,用于抓取web站点并从页面中提取结构化的数据.Scrapy用途广泛,可以用于数据挖掘.监测和自动化测试 ...

- 5、爬虫之scrapy框架

一 scrapy框架简介 1 介绍 Scrapy一个开源和协作的框架,其最初是为了页面抓取 (更确切来说, 网络抓取 )所设计的,使用它可以以快速.简单.可扩展的方式从网站中提取所需的数据.但目前Sc ...

- Python学习---爬虫学习[scrapy框架初识]

Scrapy Scrapy是一个框架,可以帮助我们进行创建项目,运行项目,可以帮我们下载,解析网页,同时支持cookies和自定义其他功能. Scrapy是一个为了爬取网站数据,提取结构性数据而编写的 ...

随机推荐

- 打开office word excel弹出visual studio 2008

打开office word 或者excel或者ppt等文档就会弹出visual studio 2008正在配置对话框. 按照我下面的步骤,解决方法非常简单. 如果你的电脑是win7操作系统,从第一步开 ...

- CentOS 6 minimal 网络配置

安装CentOS6 minimal 之后ifconfig 只有lo本地 的127.0.0.1 没有局域网ip. 这边我用的是vmware nat DHCP 提供网络服务.过程就不赘述了. 解决笔记 ...

- objdump 分析

objdump -H 显示如下: 一般常用的是 objdump -x 显示文件头信息 objdump -d 反汇编代码段代码 objdump -D 反汇编所有代码 用法:objdump <选项& ...

- 浅谈P NP NPC

P问题:多项式时间内可以找到解的问题,这个解可以在多项式时间内验证. NP问题:有多项式时间内可以验证的解的问题,而并不能保证可以在多项式时间内找到这个解. 比如汉密尔顿回路,如果找到,在多项式时间内 ...

- 解决Eclipse中文乱码 - 技术博客 - 51CTO技术博客 http://hsj69106.blog.51cto.com/1017401/595598/

解决Eclipse中文乱码 - 技术博客 - 51CTO技术博客 http://hsj69106.blog.51cto.com/1017401/595598/

- shh(struts+spring+Hibernate)的搭建

一.Struts 一.struts的流程 (1)首先,用户在地址栏中输入你的项目访问路径,然后这个请求会发送到服务器,服务器先找到要web.xml的,给web.xml中配置了一个filter过滤器,过 ...

- Git学习笔记(Mac Linux系统)

最近参与学校一个比赛,和队友一起做一个小项目,需要将代码传到Coding(国内git代码托管平台),因此这几天才正式入手git版本控制系统,在这里我就记录一下最近的学习git心得体验,一来分享一下自己 ...

- 流编辑器-sed

sed 参数: 1.'s' 替换 sed 's/search-word/replace-word/' file-name 替换file-name文件中的search-word为replace-word ...

- Hibernate4.1之后关于占位符的问题

hibernate 4.1之后对于HQL中查询参数的占位符做了改进,如果仍然用老式的占位符会有类似如下的告警信息 [main] WARN [org.hibernate.hql.internal.ast ...

- 在Visual Studio中设置多核并行编译

VS是一款非常强大实用的IDE,是在Windows环境下学习编程的首选软件. 有些时候大一点的工程项目编译要耗时挺长时间,随便修改一下代码就可能要编译将近一分钟,甚至更多.即便在开启的增量编译的情况下 ...