RabbitMQ 全套

本博客代码运行环境

ErLang: ErLang_X64_22 version

RabbitMQ: RabbitMQ_Server_3.7.15 version

python : Python 3.7.1rc1 version

pip : pip 19.1.1 version

pika : pika 1.0.1 version

什么是MQ

消息队列(Message Queue,简称MQ),从字面意思上看,本质是个队列,FIFO先入先出,只不过队列中存放的内容是message而已。

其主要用途:不同进程Process/线程Thread之间通信。

为什么会产生消息队列?有几个原因: 不同进程(process)之间传递消息时,两个进程之间耦合程度过高,改动一个进程,引发必须修改另一个进程,为了隔离这两个进程,在两进程间抽离出一层(一个模块),所有两进程之间传递的消息,都必须通过消息队列来传递,单独修改某一个进程,不会影响另一个; 不同进程(process)之间传递消息时,为了实现标准化,将消息的格式规范化了,并且,某一个进程接受的消息太多,一下子无法处理完,并且也有先后顺序,必须对收到的消息进行排队,因此诞生了事实上的消息队列; 关于消息队列的详细介绍请参阅:

《Java帝国之消息队列》

《一个故事告诉你什么是消息队列》

《到底什么时候该使用MQ》 MQ框架非常之多,比较流行的有RabbitMq、ActiveMq、ZeroMq、kafka,以及阿里开源的RocketMQ。本文主要介绍RabbitMq。

RabbitMQ

RabbitMQ简介

1、MQ 为 Message Queue, 消息队列是应用程序和应用程序之间的通信方法,

2、RabbitMQ 是一个开源的, 在AMQP 基础上完整的,可复用的企业消息系统,消息中间件 , 消息队列

3、支持主流的 OS, Linux, Windows, MacOX 等,

4、多种开发语言支持, java、Python、Ruby、.NET、PHP、C/C++、node.js 等

5、是专业级别的, 甩 python 的队列好几条街

6、开发语言: Erlang----面向并发的编程语言----- 爱立信公司, 可以做到 热插拔, 局部加载, 不需要重启整个服务

AMQP: 消息队列的一个协议。

搭建RabbitMQ环境:windows下安装

第一步 提供 Erlang 编程语言环境-----》安装 Erlang

官网: http://www.erlang.org/download ,

安装RabbitMQ

官网: https://www.rabbitmq.com/install-windows.html

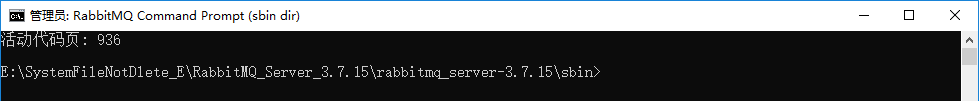

安装完成: 打开 cmd 命令行工具, cd 到 RabbitMQ 的安装目录下的 sbin/ 子目录 中。 如图:

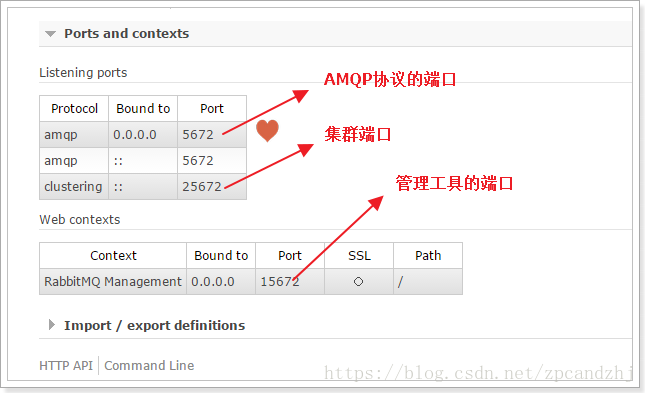

1、启动管理工具插件: rabbitmq-plugins enable rabbitmq_management

2、启动 RabbitMQ 服务:net start rabbitmq

3、浏览器输入地址: http://127.0.0.1:15672/

4、使用 默认账号管理: guest/ guest , 能够登陆 ,说明安装成功

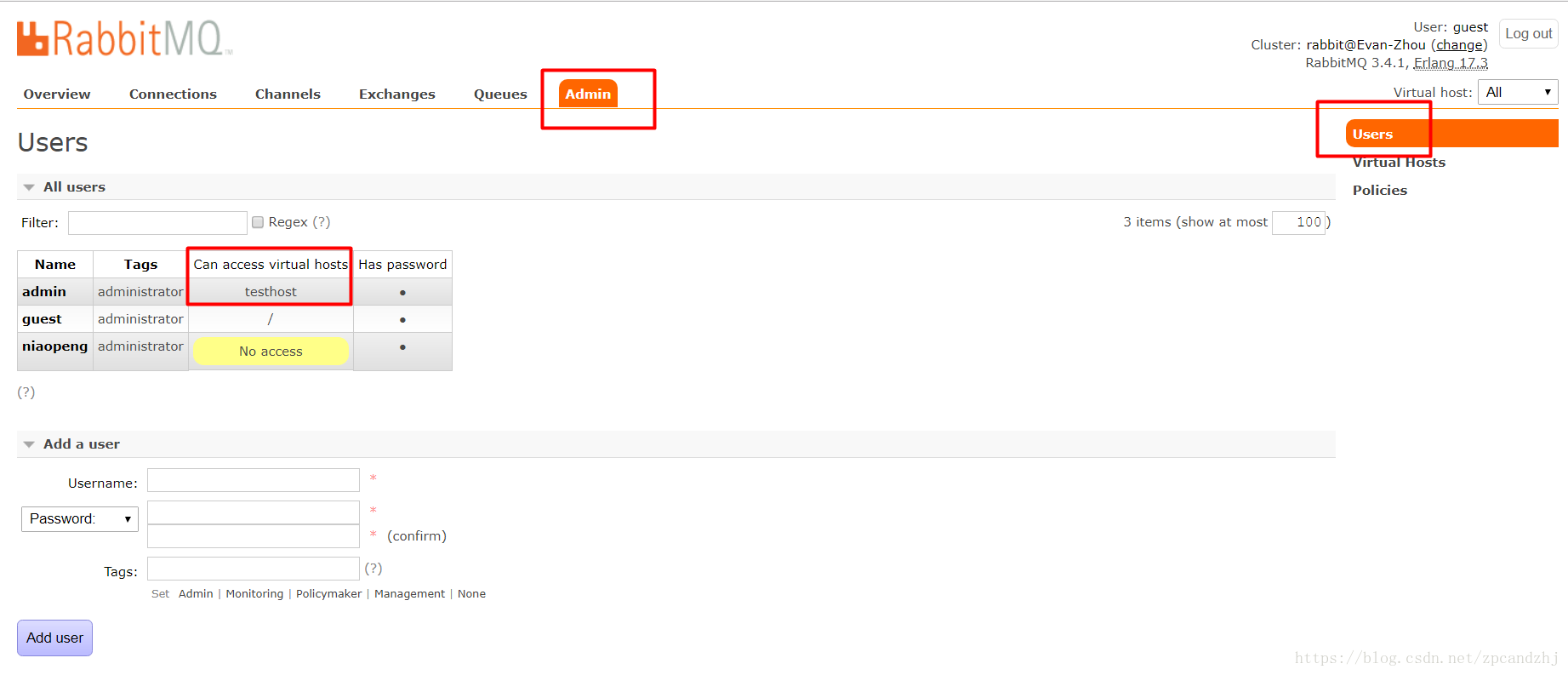

4.1、 添加 admin 用户:

4.2、用户角色:

1、超级管理员(administrator)

可登陆管理控制台,可查看所有的信息,并且可以对用户,策略(policy)进行操作。

2、监控者(monitoring)

可登陆管理控制台,同时可以查看rabbitmq节点的相关信息(进程数,内存使用情况,磁盘使用情况等)

3、策略制定者(policymaker)

可登陆管理控制台, 同时可以对policy进行管理。但无法查看节点的相关信息(上图红框标识的部分)。

4、普通管理者(management)

仅可登陆管理控制台,无法看到节点信息,也无法对策略进行管理。

5、其他

无法登陆管理控制台,通常就是普通的生产者和消费者。

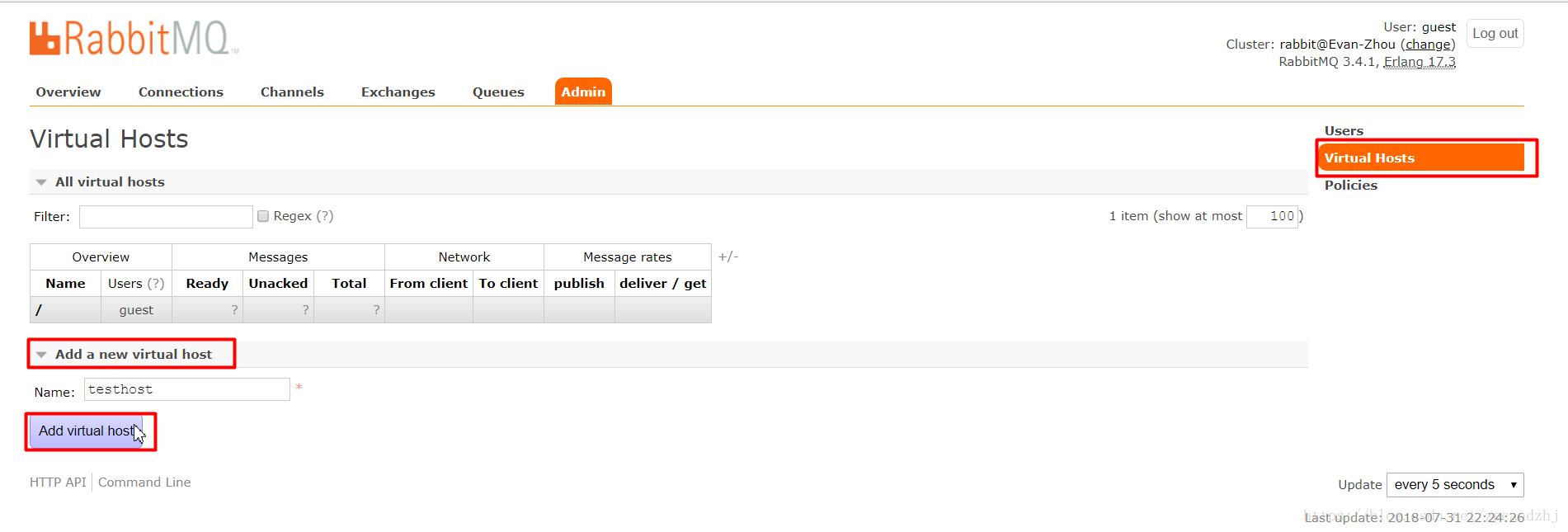

4.3、创建Virtual Hosts

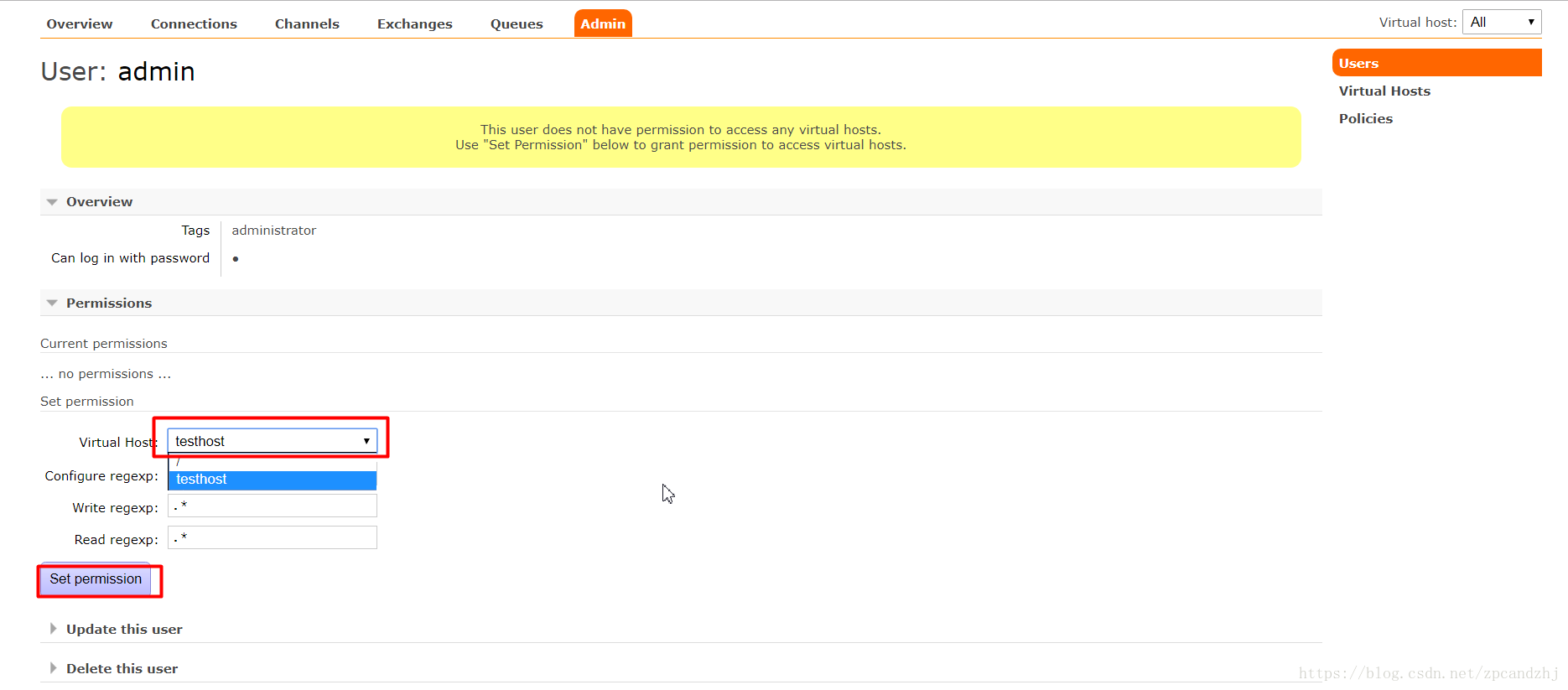

选中Admin用户,设置权限:

看到权限已加

4.4、 管理界面中的功能:

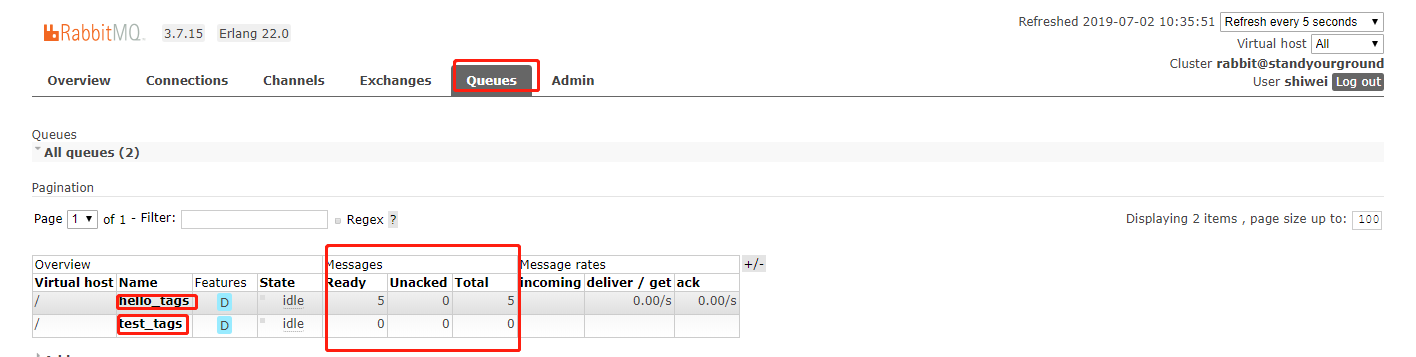

4.5、 管理工具中 查看队列消息:

点击上面的队列名称,查询具体的队列中的信息:

使用 rabbitMQ 命令 添加用户并设置权限的步骤:

1. 创建用户: rabbitmqctl add_user name password

2. 设置用户角色: rabbitmqctl set_user_tags name administrator

3. 远程连接需设置用户权限, 代表允许从外面访问:

rabbitmqctl set_permissions -p / name ".*" ".*" ".*"

解析: set_permissions [-p vhost] {user} {conf} {write} {read}

RabbitMQ 常用命令:

1、rabbitmq 管理器插件的启动和关闭:

**启动监控管理器:rabbitmq-plugins enable rabbitmq_management

关闭监控管理器:rabbitmq-plugins disable rabbitmq_management

2、服务的启动与关闭:

**启动rabbitmq:rabbitmq-service start

关闭rabbitmq:rabbitmq-service stop

**使用 windows 命令: net start rabbitmq

net stop rabbitmq

3、rabbitmq服务器的启动和关闭:

前台启动: rabbitmq-server start

后台启动: rabbitmq-server -detached

前台停止:rabbitmqctl stop

查看 RabbitMQ 的状态: rabbitmqctl status

4、rabbitmq 应用管理:

关闭应用:rabbitmqctl stop_app

启动应用:rabbitmqctl start_app

5、用户管理:

**添加用户: rabbitmqctl add_user username password

列出所有用户: rabbitmqctl list_users

删除用户: rabbitmqctl delete_user username

**修改用户密码: rabbitmqctl change_password username

newpassword

6、角色管理:

**分配角色:rabbitmqctl set_user_tags username administrator 角色说明

none 最小权限角色

management 管理员角色

policymaker 决策者

monitoring 监控

administrator 超级管理员

7. 权限管理:

清除用户权限: rabbitmqctl clear_permissions -p vhostpath user

**设置用户权限: rabbitmqctl set_permissions -p vhostpath username ".*" ".*" ".*"

8、虚拟主机管理:

列出所有虚拟主机: rabbitmqctl list_vhosts

创建虚拟主机: rabbitmqctl list_vhost vhostpath

删除虚拟主机: rabbitmqctl delete_vhost vhostpath

列出虚拟主机所有权限:rabbitmqctl list_permissions -p vhostpath

9、队列管理:

**查看所有的队列:rabbitmqctl list_queues

清除所有的队列:rabbitmqctl reset

查看所有绑定: rabbitmqctl list_bindings

查看所有通道: rabbitmqctl list_channels

查看所有连接: rabbitmqctl list_connections

列出所有消费者: rabbitmqctl list_consumers

**列出所有交换机: rabbitmqctl list_exchanges

Python 操作 RabbitMQ 之深入浅出

此博客代码托管地址: https://github.com/SuoSuo-Rocky/RabbitMQ-FullStack

安装 rabbitMQ module

pip install pika

or

easy_install pika

or

源码 : https://pypi.python.org/pypi/pika

实现最简单的队列通信

send端

# 发送端, 消费者

import pika credentials = pika.PlainCredentials('shiwei', 'shiwei666666')

connection = pika.BlockingConnection(pika.ConnectionParameters(host='localhost', credentials=credentials)) # 在连接之上创建一个 rabbit 协议的通道

channel = connection.channel() # 在通道中 声明 一个 queue

channel.queue_declare(queue='hello') # 一个消息永远不能直接发送到队列,它总是需要经过一个交换

# n RabbitMQ a message can never be sent directly to the queue, it always needs to go through an exchange.

channel.basic_publish(exchange='', # 交换机

routing_key='hello', # 路由键,写明将消息发往哪个队列,本例是将消息发往队列hello

body='Hello World!') # 生产者要发送的消息 内容

print(" [x] Sent 'Hello World!'")

connection.close() # 当生产者发送完消息后,可选择关闭连接

receive端

import pika

import time

credentials = pika.PlainCredentials('shiwei', 'shiwei666666')

connection = pika.BlockingConnection(pika.ConnectionParameters(host='localhost', credentials=credentials))

channel = connection.channel() # You may ask why we declare the queue again ‒ we have already declared it in our previous code.

# We could avoid that if we were sure that the queue already exists. For example if send.py program

# was run before. But we're not yet sure which program to run first. In such cases it's a good

# practice to repeat declaring the queue in both programs.

# 声明一个队列,生产者和消费者都要声明一个相同的队列,用来防止万一某一方挂了,另一方能正常运行

channel.queue_declare(queue='hello') # 定义一个回调函数,用来接收生产者发送的消息

def callback(ch, method, properties, body):

print("received msg...start processing....",body)

time.sleep(5)

print(" [x] msg process done....",body) channel.basic_consume(on_message_callback=callback, # 定义一个回调函数,用来接收生产者发送的消息

auto_ack=True,

queue='hello', # 指定取消息的队列名

) print(' [*] Waiting for messages. To exit press CTRL+C')

channel.start_consuming() #开始循环取消息

实现功能

(1)rabbitmq循环调度公平分发,将消息循环发送给不同的消费者,如:消息1,3,5发送给消费者1;消息2,4,6发送给消费者2。

(2)消息确认机制,为了确保一个消息不会丢失,RabbitMQ支持消息的确认 , 一个 ack(acknowlegement) 是从消费者端发送一个确认去告诉RabbitMQ 消息已经接收了、处理了,RabbitMQ可以释放并删除掉了。如果一个消费者死掉了(channel关闭、connection关闭、或者TCP连接断开了)而没有发送ack,RabbitMQ 就会认为这个消息没有被消费者处理,并会重新发送到生产者的队列里,如果同时有另外一个消费者在线,rabbitmq将会将消息很快转发到另外一个消费者中。 那样的话你就能确保虽然一个消费者死掉,但消息不会丢失。

这个是没有超时的,当消费方(consumer)死掉后RabbitMQ会重新转发消息,即使处理这个消息需要很长很长时间也没有问题。消息的 acknowlegments 默认是打开的,在前面的例子中关闭了: auto_ack = True . 现在删除这个标识 然后 发送一个 acknowledgment。

消息持久化

消息持久化,将消息写入硬盘中。

注意: (1)、RabbitMQ不允许你重新定义一个已经存在、但属性不同的queue, 否则报错

(2)、标记消息为持久化并不能完全保证消息不会丢失,尽管已经告诉RabbitMQ将消息保存到磁盘,但

RabbitMQ接收到的消息在还没有保存的时候,仍然有一个短暂的时间窗口。RabbitMQ不会对每个消息都执行同步 -

-- 可能只是保存到缓存cache还没有写入到磁盘中。因此这个持久化保证并不是很强,但这比我们简单的任务queue要

好很多,如果想要很强的持久化保证,可以使用 publisher confirms。

公平调度: 在一个消费者未处理完一个消息之前不要分发新的消息给它,而是将这个新消息分发给另一个不是很忙的消费

者进行处理。为了解决这个问题我们可以在消费者代码中使用 channel.basic.qos (prefetch_count = 1 ),将消费者设置为公平调度

生产者

import pika

import sys username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd))

chann = conn.channel() # 源码:

"""

# def queue_declare(self, # channel.queueDeclare 用来创建队列,有5个参数:

# queue, # String queue, 队列名;

# passive=False, #

# durable=False, # boolean durable, 该队列是否需要持久化

# exclusive=False, # boolean exclusive,该队列是否为该通道独占的(其他通道是否可以消费该队列)

# auto_delete=False, # boolean autoDelete,该队列不再使用的时候,是否让RabbitMQ服务器自动删除掉;

# arguments=None) """

chann.queue_declare(queue='test_tags', # 声明 队列, 不可与 已存在的 队列重名 , 否则 报错

durable=True, # 设置队列 持久化 , 报 : ChannelClosedByBroker: 406 , 错误, passive:是屈服的意思,将passive设为True,问题解决。

# passive= True,

)

message = "My name is shiwei" chann.basic_publish(exchange='',

routing_key='test_tags', # 表明 要将 消息 发送到哪个队列

body = message,

properties = pika.BasicProperties(delivery_mode = 2) # 设置消息持久化, 将消息的属性设置为 2 ,表示消息持久化

) print('[Publisher] Send %s' % message)

conn.close()

消费者

import pika

import time username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) chann = conn.channel() chann.queue_declare(queue='test_tags', # 声明 队列, 不可与 已存在的 队列重名 , 否则 报错

durable=True, # 设置队列 持久化 ,

# passive=True, # 是否检查当前队列 是否存在 , True 表示 当前声明队列 为 存在 的,

)

# 定义 接受消息 的 回调函数

def callback(ch,method, properties, body):

print(" [消费者] Received %r" % body)

time.sleep(3)

print(" [消费者] Done")

# 手动 确认 在接收到 消息后 给 rabbitmq 发送一个 确认 ACK, 返回 消息标识符

ch.basic_ack(delivery_tag=method.delivery_tag)

"""

def basic_consume(self,

queue,

on_message_callback,

auto_ack=False,

exclusive=False,

consumer_tag=None,

arguments=None):

"""

chann.basic.qos (prefetch_count = 1 )

# 注意 源码中的 位置参数的位置

chann.basic_consume(queue='test_tags',

on_message_callback = callback,

# 是否 需要 自动 确认, 若为 False, 则需要在 消息回调函数中手动确认,

auto_ack = False, # 默认是 False

) chann.start_consuming() # 开始 循环 接受消息

发布-订阅_广播:一对多-------交换机

exchange:交换机。生产者不是将消息发送给队列,而是将消息发送给交换机,由交换机决定将消息发送给哪个队列。所以

exchange必须准确知道消息是要送到哪个队列,还是要被丢弃。因此要在exchange中给exchange定义规则,所有的规

则都是在exchange的类型中定义的。

exchange有4个类型:

fanout : 所有bind到此exchange的queue都可以接收消息

direct :通过routingKey和exchange决定的那个唯一的queue可以接收消息

topic :所有符合routingKey(此时可以是一个表达式)的routingKey所bind的queue可以接收消息

表达式符号说明:#代表一个或多个字符,*代表任何字符

例:#.a会匹配a.a,aa.a,aaa.a等

*.a会匹配a.a,b.a,c.a等

注:使用RoutingKey为#,Exchange Type为topic的时候相当于使用fanout

headers :通过headers 来决定把消息发给哪些queue

之前,我们并没有讲过exchange,但是我们仍然可以将消息发送到队列中。这是因为我们用的是默认exchange.也就是

说之前写的:exchange='',空字符串表示默认的exchange。

exchange_type=fanout

广播类型,生产者将消息发送给所有消费者,如果某个消费者没有收到当前消息,就再也收不到了(消费者就像收音机)

生产者:(可以用作日志收集系统)

开启多个消费者后,会同时从生产者接收相同的消息

消息publisher

import pika username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) #在连接上创建一个频道

channel = conn.channel() #创建一个fanout(广播)类型的交换机exchange,名字为logs。

channel.exchange_declare(exchange="logs", exchange_type="fanout")

message = "info: Hello World!"

channel.basic_publish(exchange='logs',# 指定交换机exchange为logs,这里只需要指定将消息发给交换机logs就可以了,不需要指定队列,因为生产者消息是发送给交换机的。

routing_key='', # 在fanout类型中,绑定关键字routing_key必须忽略,写空即可

body=message)

print(" [x] Sent %r" % message)

conn.close()

消息subscriber

import pika

import sys username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) #在连接上创建一个频道

channel = conn.channel() channel.exchange_declare(exchange="logs", exchange_type="fanout") # 参数名改变了,以前版本是 type result = channel.queue_declare(exclusive=True, # 创建随机队列,exclusive=True(唯一性)当消费者与rabbitmq断开连接时,这个队列将自动删除。

queue='',) queue_name = result.method.queue # 分配随机队列的名字。

channel.queue_bind(exchange='logs',# 将交换机、队列绑定在一起,

queue=queue_name,) def callback(ch, method, properties, body): # 定义回调函数,接收消息

print(" [消费者] %r:%r" % (method.routing_key, body)) channel.basic_consume(queue=queue_name,

on_message_callback = callback,

auto_ack=True) # 消费者接收消息后,不给rabbimq回执确认。 channel.start_consuming() # 循环等待消息接收。

exchange_type=direct

RabbitMQ还支持根据关键字发送,无需声明队列,即:发布时给队列绑定关键字,发送者将数据根据关键字发送到消息exchange,exchange根据

关键字 判定应该将数据发送至指定队列。

例如: 根据 日志级别,info, warning, error, success,本例即是。

注意: *****本例 需从命令行启动,给定参数-------》队列的绑定关键字

消息publisher

import pika

import sys username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) #在连接上创建一个频道

channel = conn.channel() #创建一个交换机并声明 direct 的类型为:关键字类型,表示该交换机会根据消息中不同的关键字将消息发送给不同的队列

channel.exchange_declare(exchange="direct_logs", exchange_type="direct") severity = sys.argv[1] if len(sys.argv) > 1 else "info" message = ' '.join(sys.argv[2:]) or "Hello World!" channel.basic_publish(exchange='direct_logs', # 指明用于发布消息的交换机、关键字

routing_key=severity, # 绑定关键字,即将message与关键字info绑定,明确将消息发送到哪个关键字的队列中。

body=message)

print(" [x] Sent %r" % message)

conn.close()

消息subscriber

import pika

import sys username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) # 在连接上创建一个频道

channel = conn.channel() channel.exchange_declare(exchange="direct_logs", exchange_type="direct") # 参数 名改变了, 以前是 type result = channel.queue_declare(exclusive=True, # 创建随机队列,当消费者与rabbitmq断开连接时,这个队列将自动删除。

queue='',)

queue_name = result.method.queue # 分配随机队列的名字。 severities = sys.argv[1:]

if not severities:

sys.stderr.write("Usage: %s [info] [warning] [error]\n" % sys.argv[0])

sys.exit(1) for severity in severities: # 循环 队列, 使其与交换机绑定在一起,

channel.queue_bind(exchange='direct_logs',

queue=queue_name,

routing_key=severity,) def callback(ch, method, properties, body): # 定义回调函数,接收消息

print(" [消费者] %r:%r" % (method.routing_key, body)) channel.basic_consume(queue=queue_name,

on_message_callback = callback,

auto_ack=True,) # 消费者接收消息后,不给rabbimq回执确认。 channel.start_consuming() # 循环等待消息接收。

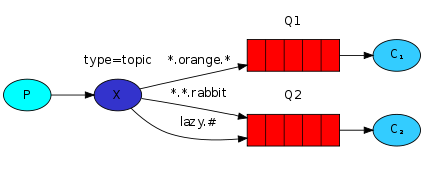

exchange_type=topic---> 模糊匹配类型。比较常用

发送到一个 topics交换机的消息,它的 routing_key不能是任意的 -- 它的routing_key必须是一个用小数点分割的

单词列表。 这个字符可以是任何单词,但是通常是一些指定意义的字符。比如:

“stock.usd.nyse","nyse.vmw","quick.orange.rabbit". 这里可以是你想要路由键的任意字符。最高限制

为255字节。

生产者与消费者的routing_key必须在同一个表单中。 Topic交换的背后的逻辑类似直接交换(direct) -- 包含特定关

键字的消息将会分发到所有匹配的关键字队列中。然后有两个重要的特殊情况:

绑定键值:

> * (星) 可代替一个单词

> # (井) 可代替0个或多个单词

注意: *****本例 需从命令行启动,给定参数-------》队列的绑定关键字

消息publisher

import pika

import sys username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) channel = conn.channel() channel.exchange_declare(exchange='topic_logs',

exchange_type='topic') routing_key = sys.argv[1] if len(sys.argv) > 1 else 'anonymous.info'

message = ' '.join(sys.argv[2:]) or 'Hello World!'

channel.basic_publish(exchange='topic_logs',

routing_key=routing_key,

body=message)

print(" [x] Sent %r:%r" % (routing_key, message))

conn.close()

消息subscriber

import pika

import sys username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) channel = conn.channel() channel.exchange_declare(exchange='topic_logs',

exchange_type='topic') result = channel.queue_declare(exclusive=True,

queue="",)

queue_name = result.method.queue binding_keys = sys.argv[1:]

if not binding_keys:

sys.stderr.write("Usage: %s [binding_key]...\n" % sys.argv[0])

sys.exit(1) for binding_key in binding_keys:

channel.queue_bind(exchange='topic_logs',

queue=queue_name,

routing_key=binding_key) print(' [*] Waiting for logs. To exit press CTRL+C') def callback(ch, method, properties, body):

print(" [x] %r:%r" % (method.routing_key, body)) channel.basic_consume(on_message_callback = callback,

queue=queue_name,

auto_ack=True) channel.start_consuming()

To receive all the logs run:

python receive_logs_topic.py "#"

To receive all logs from the facility "kern":

python receive_logs_topic.py "kern.*"

Or if you want to hear only about "critical" logs:

python receive_logs_topic.py "*.critical"

You can create multiple bindings:

python receive_logs_topic.py "kern.*" "*.critical"

And to emit a log with a routing key "kern.critical" type:

python emit_log_topic.py "kern.critical" "A critical kernel error"

exchange_type=topic----例 二 :

生产者

import pika

import sys username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) channel = conn.channel()

channel.exchange_declare(exchange='topic_logs',

exchange_type='topic') # 创建模糊匹配类型的exchange。。 routing_key = '[warn].kern' # 这里关键字必须为点号隔开的单词,以便于消费者进行匹配。引申:这里可以做一个判断,判断产生的日志是什么级别,然后产生对应的routing_key,使程序可以发送多种级别的日志

message = 'Hello World!'

channel.basic_publish(exchange='topic_logs',#将交换机、关键字、消息进行绑定

routing_key=routing_key, # 绑定关键字,将队列变成[warn]日志的专属队列

body=message)

print(" [x] Sent %r:%r" % (routing_key, message))

conn.close()

消费者

import pika

import sys username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) channel = conn.channel() channel.exchange_declare(exchange='topic_logs',

exchange_type='topic') # 声明exchange的类型为模糊匹配。 result = channel.queue_declare(exclusive=True,

queue="",) # 创建随机一个队列当消费者退出的时候,该队列被删除。

queue_name = result.method.queue # 创建一个随机队列名字。 # 绑定键。‘#’匹配所有字符,‘*’匹配一个单词。这里列表中可以为一个或多个条件,能通过列表中字符匹配到的消息,消费者都可以取到

binding_keys = ['[warn].*', 'info.*']

if not binding_keys:

sys.stderr.write("Usage: %s [binding_key]...\n" % sys.argv[0])

sys.exit(1) # 通过循环绑定多个“交换机-队列-关键字”,只要消费者在rabbitmq中能匹配到与关键字相应的队列,就从那个队列里取消息

for binding_key in binding_keys:

channel.queue_bind(exchange='topic_logs',

queue=queue_name,

routing_key=binding_key) print(' [*] Waiting for logs. To exit press CTRL+C') def callback(ch, method, properties, body):

print(" [x] %r:%r" % (method.routing_key, body)) channel.basic_consume(on_message_callback=callback,

queue=queue_name,

auto_ack=True) # 不给rabbitmq发送确认 channel.start_consuming() # 循环接收消息

远程过程调用(RPC)Remote procedure call

消息属性

AMQP协议在一个消息中预先定义了一个包含14个属性的集合。大部分属性很少用到,以下几种除外:

> delivery_mode: 标记一个消息为持久的(值为2)或者 瞬时的(其它值), 你需要记住这个属性(在第二课时用到过)

> content_type : 用来描述 MIME 类型的编码 ,比如我们经常使用的 JSON 编码,设置这个属性就非常好实现: application/json

> reply_to:reply_to没有特别的意义,只是一个普通的变量名,只是它通常用来命名一个 callback 队列

> correlation_id : 用来关联RPC的请求与应答。关联id的作用:当在一个队列中接收了一个返回,我们并不清楚这个结果时属于哪个请求的,这样当correlation_id属性使用后,我们为每个请求设置一个唯一值,这个值就是关联id。这样,请求会有一个关联id,该请求的返回结果也有一个相同的关联id。然后当我们从callback队列中接收到一个消息后,我们查看一下这个关联,基于这个我们就能将请求和返回进行匹配。如果我们看到一个未知的correlation_id值,我们可以直接丢弃这个消息 -- 它是不属于我们的请求。

RPC执行过程:

> 当客户端启动后,它创建一个匿名的唯一的回调队列

> 对一个RPC请求, 客户端发送一个消息包含两个属性: reply_to (用来设置回调队列)和 correlation_id(用来为每个请求设置一个唯一标识)

> 请求发送到 rpc_queue队列

> RPC worker( 服务端) 在那个队列中等待请求,当一个请求出现后,服务端就执行一个job并将结果消息发送给客户端,使用reply_to字段中的队列

> 客户端在callback 队列中等待数据, 当一个消息出现后,检查这个correlation_id属性,如果和请求中的值匹配将返回给应用

RPC Running Detail:

> 当客户端启动后,它创建一个匿名的唯一的回调队列

> 对一个RPC请求, 客户端发送一个消息包含两个属性: reply_to (用来设置回调队列)和 correlation_id(用来为每个请求设置一个唯一标识)

> 请求发送到 rpc_queue队列

> RPC worker( 服务端) 在那个队列中等待请求,当一个请求出现后,服务端就执行一个job并将结果消息发送给客户端,使用reply_to字段中的队列

> 客户端在callback 队列中等待数据, 当一个消息出现后,检查这个correlation_id属性,如果和请求中的值匹配将返回给应用

RPC Client

import pika

import uuid class FibonacciRpcClient(object):

def __init__(self):

username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

self.conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) self.channel = self.conn.channel() result = self.channel.queue_declare(exclusive=True, queue= '') # 随机生成 一个 queue , 用与 Server 发送消息

self.callback_queue = result.method.queue self.channel.basic_consume(on_message_callback = self.on_response, auto_ack = True, # 准备 发送 消息

queue=self.callback_queue) def on_response(self, ch, method, props, body):

if self.corr_id == props.correlation_id:

self.response = body def call(self, n):

self.response = None

self.corr_id = str(uuid.uuid4())

self.channel.basic_publish(exchange='',

routing_key='rpc_queue',

properties=pika.BasicProperties(

reply_to=self.callback_queue,

correlation_id=self.corr_id,),

body=str(n))

while self.response is None:

self.conn.process_data_events()

return int(self.response) fibonacci_rpc = FibonacciRpcClient()

print(" [x] Requesting fib(30)")

response = fibonacci_rpc.call(7)

print(" [.] Got %r" % response)

Client Running Detail:

> (11) 我们建立一个连接,通道并定义一个专门的’callback‘队列用来接收回复

> (19) 我们订阅了“callback”队列,因此我们能够接收 RPC 的返回结果

> (21) ’on_response' 在每个返回中执行的回调是一个简单的job, 对每个返回消息将检查correlation_id是否是我们需要查找的那个ID,如果是,将保存结果到 self.response 并终端consuming循环

> (25) 下一步,我们定义我们的main方法 - 执行实际的RPC请求

> (27) 在这方法中,首先我们生产一个唯一的 correlatin_id 号并保存 -- 'on_response"回调函数将用着号码来匹配发送和接收的消息值

> (28) 下一步,发布请求信息,使用两个属性: reply_to 和 correlation_id

> (34) 这一步我们可以坐等结果的返回

> (36) 最后我们返回结果给用户

RPC Server

import pika username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) channel = conn.channel() channel.queue_declare(queue='rpc_queue') def fib(n):

if n == 0:

return 0

elif n == 1:

return 1

else:

return fib(n - 1) + fib(n - 2) def on_request(ch, method, props, body):

n = int(body)

print(" [.] fib(%s)" % n)

response = fib(n) ch.basic_publish(exchange='',

routing_key=props.reply_to,

properties=pika.BasicProperties(correlation_id= props.correlation_id),

body=str(response))

ch.basic_ack(delivery_tag=method.delivery_tag) channel.basic_qos(prefetch_count=1)

channel.basic_consume(queue='rpc_queue', on_message_callback = on_request)

print(" [x] Awaiting RPC requests")

channel.start_consuming()

Server Running Detail:

> 当客户端启动后,它创建一个匿名的唯一的回调队列

> 对一个RPC请求, 客户端发送一个消息包含两个属性: reply_to (用来设置回调队列)和 correlation_id(用来为每个请求设置一个唯一标识)

> 请求发送到 rpc_queue队列

> RPC worker( 服务端) 在那个队列中等待请求,当一个请求出现后,服务端就执行一个job并将结果消息发送给客户端,使用reply_to字段中的队列

> 客户端在callback 队列中等待数据, 当一个消息出现后,检查这个correlation_id属性,如果和请求中的值匹配将返回给应用

RPC Demo02

处理方法描述:发送端在发送信息前,产生一个接收消息的临时队列,该队列用来接收返回的结果。其实在这里接收端、发送端

的概念已经比较模糊了,因为发送端也同样要接收消息,接收端同样也要发送消息,所以这里笔者使用另外的示例来演示这一过程。

示例内容:假设有一个控制中心和一个计算节点,控制中心会将一个自然数N发送给计算节点,计算节点将N值加1后,返回给控

制中心。这里用center.py模拟控制中心,compute.py模拟计算节点。

Client

import pika class Center(object):

def __init__(self):

username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd) # 创建连接

self.conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd)) self.channel = self.conn.channel()

# 定义接收返回消息的队列

result = self.channel.queue_declare(exclusive=True,queue="",)

self.callback_queue = result.method.queue self.channel.basic_consume(on_message_callback=self.on_response,

auto_ack=True,

queue=self.callback_queue) # 定义接收到返回消息的处理方法

def on_response(self, ch, method, props, body):

self.response = body def request(self, n):

self.response = None

# 发送计算请求,并声明返回队列

self.channel.basic_publish(exchange='',

routing_key='compute_queue',

properties=pika.BasicProperties(

reply_to=self.callback_queue,

),

body=str(n))

# 接收返回的数据

while self.response is None:

self.conn.process_data_events()

return int(self.response) center = Center() print(" [x] Requesting increase(30)")

response = center.request(30)

print(" [.] Got %r" % (response,))

Client

Server

import pika username = "shiwei"

pwd = 'shiwei666666'

user_pwd = pika.PlainCredentials(username, pwd)

# 创建连接

conn = pika.BlockingConnection(pika.ConnectionParameters("localhost", credentials=user_pwd))

channel = conn.channel() print(' [*] Waiting for n')

channel.queue_declare(queue='compute_queue') # 将n值加1

def increase(n):

return n + 1 # 定义接收到消息的处理方法

def request(ch, method, properties, body):

print(" [.] increase(%s)" % (body,)) response = increase(int(body)) # 将计算结果发送回控制中心

ch.basic_publish(exchange='',

routing_key=properties.reply_to,

body=str(response))

ch.basic_ack(delivery_tag=method.delivery_tag) channel.basic_qos(prefetch_count=1)

channel.basic_consume(on_message_callback=request,

queue='compute_queue') channel.start_consuming()

Server

参考文章:http://www.rabbitmq.com/tutorials/tutorial-six-python.html

RabbitMQ 全套的更多相关文章

- Go语言学习笔记(八)golang 操作 Redis & Mysql & RabbitMQ

加 Golang学习 QQ群共同学习进步成家立业工作 ^-^ 群号:96933959 Reids 安装导入 go get github.com/garyburd/redigo/redis import ...

- RabbitMQ进阶使用-延时队列的配置(Spring Boot)

依赖 MAVEN配置pom.xml <dependency> <groupId>org.springframework.boot</groupId> <art ...

- 老男孩Python高级全栈开发工程师【真正的全套完整无加密】

点击了解更多Python课程>>> 老男孩Python高级全栈开发工程师[真正的全套完整无加密] 课程大纲 老男孩python全栈,Python 全栈,Python教程,Django ...

- 2019黑马JAVAEE57期基础班就业班(全套)

黑马java57期 百度网盘 2019黑马JAVAEE57期基础班就业班(全套)百度网盘 下载 Spring全家桶解决方案 - 微服务认证解决方案(JWT) - 微服务网关解决方案(Zuul) 黑马j ...

- golang 操作 Redis & Mysql & RabbitMQ

golang 操作 Redis & Mysql & RabbitMQ Reids 安装导入 go get github.com/garyburd/redigo/redis import ...

- springboot实战开发全套教程,让开发像搭积木一样简单!Github星标已上10W+!

前言 先说一下,这份教程在github上面星标已上10W,下面我会一一给大家举例出来全部内容,原链接后面我会发出来!首先我讲一下接下来我们会讲到的知识和技术,对比讲解了多种同类技术的使用手日区别,大家 ...

- 这一篇文章帮你搞定Java(含Java全套资源)

当下想学习Java开发的人越来越多,对于很多零基础的人来说,没有相关的视频教程及相关的学习线路,学起来是一件很费劲的事情,还有很多人从网上及其它渠道购买视频,这些视频资料的价格对于刚毕业的大学生来说也 ...

- 消息队列——RabbitMQ学习笔记

消息队列--RabbitMQ学习笔记 1. 写在前面 昨天简单学习了一个消息队列项目--RabbitMQ,今天趁热打铁,将学到的东西记录下来. 学习的资料主要是官网给出的6个基本的消息发送/接收模型, ...

- RabbitMq应用二

在应用一中,基本的消息队列使用已经完成了,在实际项目中,一定会出现各种各样的需求和问题,rabbitmq内置的很多强大机制和功能会帮助我们解决很多的问题,下面就一个一个的一起学习一下. 消息响应机制 ...

随机推荐

- 【WINDOWS】设置路由表实现有线内网,无线外网

前提!!! 需要有线无线双网卡

- Nginx 作为代理服务与负载均衡

代理服务 代理一代为办理(代理理财.代理收货等等) 代理区别 区别在于代理的对象不一样 正向代理代理的对象是客户端 反向代理代理的对象是服务端 反向代理配置 server { listen 80; s ...

- Socket网络通信编程(一)

1.学习基本概念.传统的同步阻塞式I/O编程.伪异步IO实现 2.学习基于NIO的同步非阻塞式编程 3.了解基于NIO2.0的异步非阻塞(AIO)编程 1.1 基本概念 Socket又称“套接字”,应 ...

- es之java操作插入文档

4方式: . 使用json字符串直接创建 . 使用Map集合 . 使用第三方库来序列化 createDocumentBySerialize . 使用内置的帮助器XContentFactory.json ...

- vue-router 2.0 跳转之router.push()

router.push(location) 除了使用 创建 a 标签来定义导航链接,我们还可以借助 router 的实例方法,通过编写代码来实现. router.push(location) 想要导航 ...

- python 浮点运算

print(format(float(a)/float(b),'.2f'))

- [转] python关于ctypes使用char指针与bytes相互转换的问题

最近研究人脸识别,需要用python调用so动态库,涉及到c/c++中的指针字符串转Python的bytes对象的问题. 按照ctypes的文档,直观方式是先创建对应的类型数组,再将指针取地址一一赋值 ...

- python文件操作错误解决

1. python读取文件时提示"UnicodeDecodeError: 'gbk' codec can't decode byte 0x80 in position 205: illega ...

- 阶段1 语言基础+高级_1-3-Java语言高级_1-常用API_1_第2节 匿名对象_6-匿名对象的说明

没有名字的对象,叫做匿名对象 新建一个Person类 把赵又廷赋值交给匿名对象Person里面的成员变量name 想调用里面的ShowName的话 还需要再定义一个匿名对象. 第三个对象是一个全新的. ...

- postman连接mysql执行操作

postman也可以连接mysql 目录 1.安装 2.启动服务 3.执行sql语句 1.安装 想要postman连接mysql,需要安装xmysql,启动该服务,然后才可以调用. 预置条件:完成no ...