【实战小项目】python开发自动化运维工具--批量操作主机

有很多开源自动化运维工具都很好用如ansible/salt stack等,完全不用重复造轮子。只不过,很多运维同学学习Python之后,苦于没小项目训练,本篇演示用Python写一个批量操作主机的工具,大家空余时候可以试着写写,完善完善。

1 思路分析

在运维工作中,古老的方式部署环境、上线代码可能都需要手动在服务器上敲命令,不胜其烦。所以,脚本,自动化工具等还是很有必要的。我觉得一个批量操作工具应该考虑以下几点:

(1)本质上,就是到远程主机上执行命令并返回结果。

(2)做到批量。也就是要并发对多台机器进行操作。

(3)将返回的结果,清晰地展示给用户。

通常开源的主机批量管理工具有两类,一类是有agent,如SaltStack、Puppet等;另一类是无agent如ansible。虽然我们没必要重复造轮子,但是可以试着写一写,一是加深对这类软件原理的理解,二是练习Python。建议如果服务器规模在1000台以内的用无agent的方式也能hold住;如果超过1000台,用有agent的会好太多。

接下来我们一起看看怎么具体实现。

2 到远程机器上执行命令

到远程机器上执行命令,并返回结果,至少有两种方式:一是用paramiko模块;而是可以建立机器互信,从中控执行ssh命令。

下面我把自己封装好的代码贴一下,是基于paramiko模块封装的,ssh的大家可以自己实现:

import paramiko

class SSHParamiko(object):

err = "argument passwd or rsafile can not be None"

def __init__(self, host, port, user, passwd=None, rsafile=None):

self.h = host

self.p = port

self.u = user

self.w = passwd

self.rsa = rsafile

def _connect(self):

if self.w:

return self.pwd_connect()

elif self.rsa:

return self.rsa_connect()

else:

raise ConnectionError(self.err)

def _transfer(self):

if self.w:

return self.pwd_transfer()

elif self.rsa:

return self.rsa_transfer()

else:

raise ConnectionError(self.err)

def pwd_connect(self):

conn = paramiko.SSHClient()

conn.set_missing_host_key_policy(paramiko.AutoAddPolicy())

conn.connect(self.h, self.p, self.u, self.w)

return conn

def rsa_connect(self):

pkey = paramiko.RSAKey.from_private_key_file(self.rsa)

conn = paramiko.SSHClient()

conn.set_missing_host_key_policy(paramiko.AutoAddPolicy())

conn.connect(hostname=self.h, port=self.p, username=self.u, pkey=pkey)

return conn

def pwd_transfer(self):

transport = paramiko.Transport(self.h, self.p)

transport.connect(username=self.u, password=self.w)

sftp = paramiko.SFTPClient.from_transport(transport)

return sftp, transport

def rsa_transfer(self):

pkey = paramiko.RSAKey.from_private_key_file(self.rsa)

transport = paramiko.Transport(self.h, self.p)

transport.connect(username=self.u, pkey=pkey)

sftp = paramiko.SFTPClient.from_transport(transport)

return sftp, transport

def run_cmd(self, cmd):

conn = self._connect()

stdin, stdout, stderr = conn.exec_command(cmd)

code = stdout.channel.recv_exit_status()

stdout, stderr = stdout.read(), stderr.read()

conn.close()

if not stderr:

return code, stdout.decode()

else:

return code, stderr.decode()

def get_file(self, remote, local):

sftp, conn = self._transfer()

sftp.get(remote, local)

conn.close()

def put_file(self, local, remote):

sftp, conn = self._transfer()

sftp.put(local, remote)

conn.close()

当然,代码还可以重构一下哈。接下来我们看下效果:

if __name__ == '__main__':

h = "我的测试机IP"

p = 22

u = "我的用户名"

w = "我的密码" obj = SSHParamiko(h, p, u, w)

r = obj.run_cmd("df -h")

print(r[0])

print(r[1])

执行之后的结果是:

0

Filesystem Size Used Avail Use% Mounted on

/dev/vda1 40G 3.4G 34G 9% /

devtmpfs 3.9G 0 3.9G 0% /dev

tmpfs 3.9G 0 3.9G 0% /dev/shm

tmpfs 3.9G 410M 3.5G 11% /run

tmpfs 3.9G 0 3.9G 0% /sys/fs/cgroup

/dev/vdb 300G 12G 289G 4% /search/odin

tmpfs 783M 0 783M 0% /run/user/0

tmpfs 783M 0 783M 0% /run/user/1000

可以清晰看到第一行是命令执行的状态码,0表示成功,非0表示失败;第二行开始就是我们的命令返回结果。是不是比较清晰呢?

3 并发执行并展示输出结果

并发执行通常用Python3自带的线程模块就行,这里我用的from concurrent.futures import ThreadPoolExecutor。并且当拿到结果之后,我还做了一些格式化输出,比如绿色输出表示成功,红色输出表示命令执行失败,黄色表示提醒等。废话不多说,直接看代码吧!

from concurrent.futures import ThreadPoolExecutor class AllRun(object):

def __init__(self, ssh_objs, cmds, max_worker=50):

self.objs = [o for o in ssh_objs]

self.cmds = [c for c in cmds]

self.max_worker = max_worker # 最大并发线程数 self.success_hosts = [] # 存放成功机器数目

self.failed_hosts = [] # 存放失败的机器IP

self.mode = None

self.func = None def serial_exec(self, obj):

"""单台机器上串行执行命令,并返回结果至字典"""

result = list()

for c in self.cmds:

r = obj.run_cmd(c)

result.append([c, r])

return obj, result def concurrent_run(self):

"""并发执行"""

future = ThreadPoolExecutor(self.max_worker)

for obj in self.objs:

try:

future.submit(self.serial_exec, obj).add_done_callback(self.callback)

except Exception as err:

err = self.color_str(err, "red")

print(err)

future.shutdown(wait=True) def callback(self, future_obj):

"""回调函数,处理返回结果"""

ssh_obj, rlist = future_obj.result()

print(self.color_str("{} execute detail:".format(ssh_obj.h), "yellow"))

is_success = True

for item in rlist:

cmd, [code, res] = item

info = f"{cmd} | code => {code}\nResult:\n{res}"

if code != 0:

info = self.color_str(info, "red")

is_success = False

if ssh_obj.h not in self.failed_hosts:

self.failed_hosts.append(ssh_obj.h)

else:

info = self.color_str(info, "green")

print(info)

if is_success:

self.success_hosts.append(ssh_obj.h)

if ssh_obj.h in self.failed_hosts:

self.failed_hosts.remove(ssh_obj.h) def overview(self):

"""展示总的执行结果"""

for i in self.success_hosts:

print(self.color_str(i, "green"))

print("-" * 30)

for j in self.failed_hosts:

print(self.color_str(j, "red"))

info = "Success hosts {}; Failed hosts {}."

s, f = len(self.success_hosts), len(self.failed_hosts)

info = self.color_str(info.format(s, f), "yellow")

print(info) @staticmethod

def color_str(old, color=None):

"""给字符串添加颜色"""

if color == "red":

new = "\033[31;1m{}\033[0m".format(old)

elif color == "yellow":

new = "\033[33;1m{}\033[0m".format(old)

elif color == "blue":

new = "\033[34;1m{}\033[0m".format(old)

elif color == "green":

new = "\033[36;1m{}\033[0m".format(old)

else:

new = old

return new if __name__ == '__main__':

h1 = "adime01.shouji.sjs.ted"

p1 = 22

u1 = "odin"

w1 = "*****" h = "10.129.206.97"

p = 22

u = "root"

w = "*****" obj1 = SSHParamiko(h1, p1, u1, w1)

obj = SSHParamiko(h, p, u, w) cmds = ["df -h", "ls"] all_obj = AllRun([obj1, obj], cmds)

all_obj.concurrent_run()

all_obj.overview()

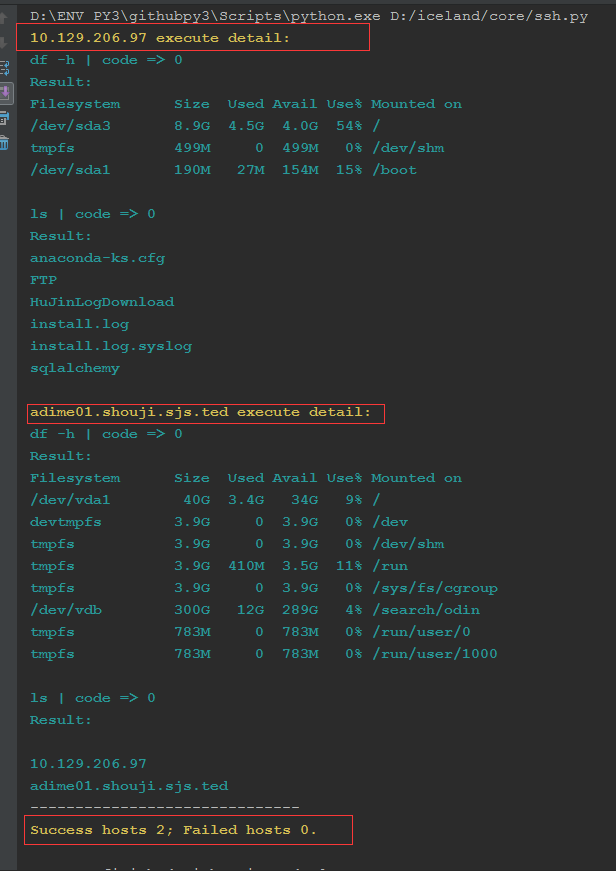

上述代码运行的结果:

从执行结果来看,高亮显示,清新明了。既显示了各个主机的各个命令执行状态码,返回结果,最后还汇总结果,成功了多少台机器和失败了多少台机器。

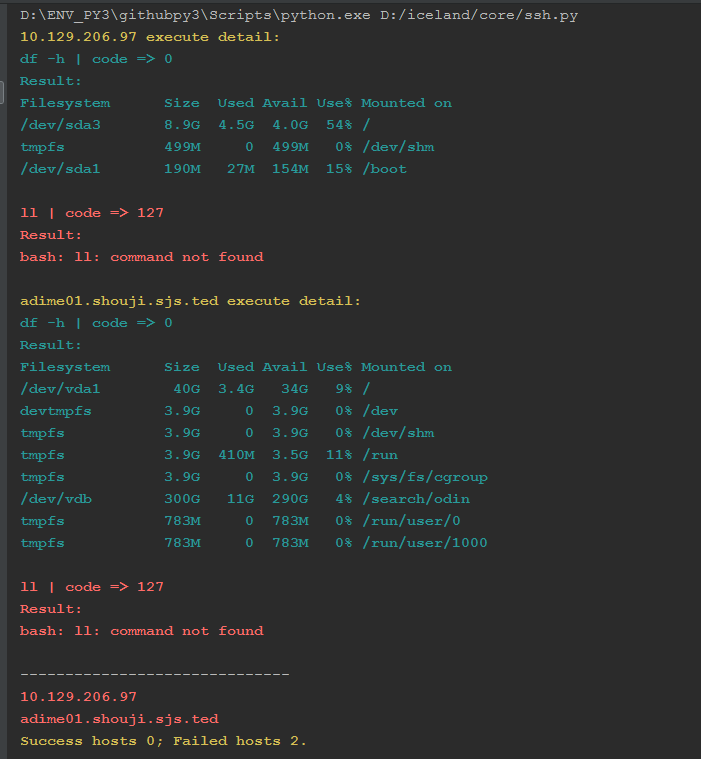

我们还可以换一下执行的命令,让命令执行失败看看:

后期还可以包装一下,将主机、密码、批量执行的命令写在配置文件中;或再根据需要包装成命令行工具,在日常运维工作中可以适当减少人肉敲命令的繁琐。

【实战小项目】python开发自动化运维工具--批量操作主机的更多相关文章

- 项目实战10.1—企业级自动化运维工具应用实战-ansible

实战环境: 公司计划在年底做一次大型市场促销活动,全面冲刺下交易额,为明年的上市做准备.公司要求各业务组对年底大促做准备,运维部要求所有业务容量进行三倍的扩容,并搭建出多套环境可以共开发和测试人员做测 ...

- 企业级自动化运维工具应用实战ansible

公司计划在年底做一次大型市场促销活动,全面冲刺下交易额,为明年的上市做准备.公司要求各业务组对年底大促做准备,运维部要求所有业务容量进行三倍的扩容,并搭建出多套环境可以共开发和测试人员做测试,运维老大 ...

- 企业级自动化运维工具应用实战-ansible

背景 公司计划在年底做一次大型市场促销活动,全面冲刺下交易额,为明年的上市做准备.公司要求各业务组对年底大促做准备,运维部要求所有业务容量进行三倍的扩容,并搭建出多套环境可以共开发和测试人员做测试,运 ...

- Linux实战教学笔记25:自动化运维工具之ansible (一)

第二十五节 ansible之文件的批量分发 标签(空格分隔): Linux实战教学笔记-陈思齐 ---本教学笔记是本人学习和工作生涯中的摘记整理而成,此为初稿(尚有诸多不完善之处),为原创作品,允许转 ...

- 企业级LINUX自动化运维工具Ansible实战课程下载

什么是Ansible? Ansible是新出现的自动化运维工具,基于Python开发,集合了众多运维工具(puppet.chef.func.fabric)的优点,实现了批量系统配置.批量程序部署.批量 ...

- CentOS7Linux中自动化运维工具Ansible的安装,以及通过模块批量管理多台主机

使用自动化运维工具Ansible集中化管理服务器 Ansible概述 Ansible是一款为类Unix系统开发的自由开源的配置和自动化工具.它用Python写成,类似于saltstack和Puppet ...

- 自动化运维工具 SaltStack 搭建

原文地址:https://www.ibm.com/developerworks/cn/opensource/os-devops-saltstack-in-cloud/index.html#N10072 ...

- Ansible 自动化运维工具

Ansible 自动化运维工具 Ansible是什么? Ansible是一个"配置管理工具"也是一个"自动化运维工具" Ansible 作用: Ansible是 ...

- Linux轻量级自动化运维工具— Ansible

Ansible 是什么 ? ansible是新出现的自动化运维工具,基于Python开发,集合了众多运维工具(puppet.cfengine.chef.func.fabric)的优点,实现了批量系统配 ...

随机推荐

- profile bashrc bash_profile之间的区别和联系

profile bashrc bash_profile之间的区别和联系 博客分类: Linux 执行顺序为:/etc/profile -> (~/.bash_profile | ~/.bas ...

- datetimepicker日期框选择后,无法触发bootstrapValidator

如上图所示,当选择日期后下面的"栏位不能为空"提示并不能及时的消失,同时点击提交按钮也没有用. 解决如下: 在birthday的校验规则里面添加trigger:'change',就 ...

- SpringBoot整合ElasticSearch实现多版本的兼容

前言 在上一篇学习SpringBoot中,整合了Mybatis.Druid和PageHelper并实现了多数据源的操作.本篇主要是介绍和使用目前最火的搜索引擎ElastiSearch,并和Spring ...

- FFPLAY的原理(二)

关于包Packets的注释 从技术上讲一个包可以包含部分或者其它的数据,但是ffmpeg的解释器保证了我们得到的包Packets包含的要么是完整的要么是多种完整的帧. 现在我们需要做的是让SaveFr ...

- Linux 下常用的Shell 命令

英文原文链接:https://www.lopezferrando.com/30-interesting-shell-commands/ 1. 监控命令(每2秒运行一次) watch "ls ...

- Gson序列化问题导致的内存溢出,tip:Background sticky concurrent mark sweep GC freed

问题原因,如果在json model里面放了非可序列化的对象就会导致这中问题,可序列化的就是那些基础数据类型和集合类型,如果在里面放个Android的Activity或者adapter这类类型字段,变 ...

- 【python进阶】深入理解系统进程1

前言 之前程序执⾏都是⼀条腿⾛路,甚⾄是⽤⼀杆枪来打天下. 通过系统编程的学习,会让⼤家有“多条腿”⼀起⾛路,就好⽐有了⼀把机关枪. 此篇为深入理解进程第一篇,下面开始今天的说明~~~ 进程 多任务的 ...

- Ext Js v6.2.0.103 Sencha Cmd 命令

Sencha Cmd v6.2.0.103 Sencha Cmd 提供几种全局开关命令. 在大多数案例中, 第一步是在Sencha SDK基础上创建应用 例如 Ext JS 或 Sencha Touc ...

- Zookeeper + Dubbo + SpringMVC + dubbo-admin

第一步:在CentOS/Windows上安装Zookeeper[前提] A:CentOS Zookeeper作为Dubbo服务的注册中心,Dubbo原先基于数据库的注册中心,没采用Zookee ...

- 0510JS流程语句

|--跳转语句|----break; 终止整个循环,不再进行判断|----continue; 终止本次循环,接着去判断是否执行下次循环 |-选择(判断)结构|--if 如果|----if(条件1){ ...