Windows + IDEA 手动开发MapReduce程序

- 参见马士兵老师的博文:map_reduce

环境配置

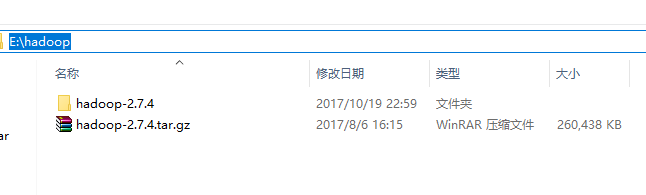

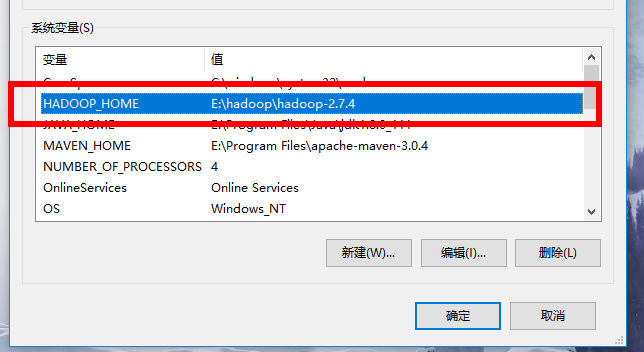

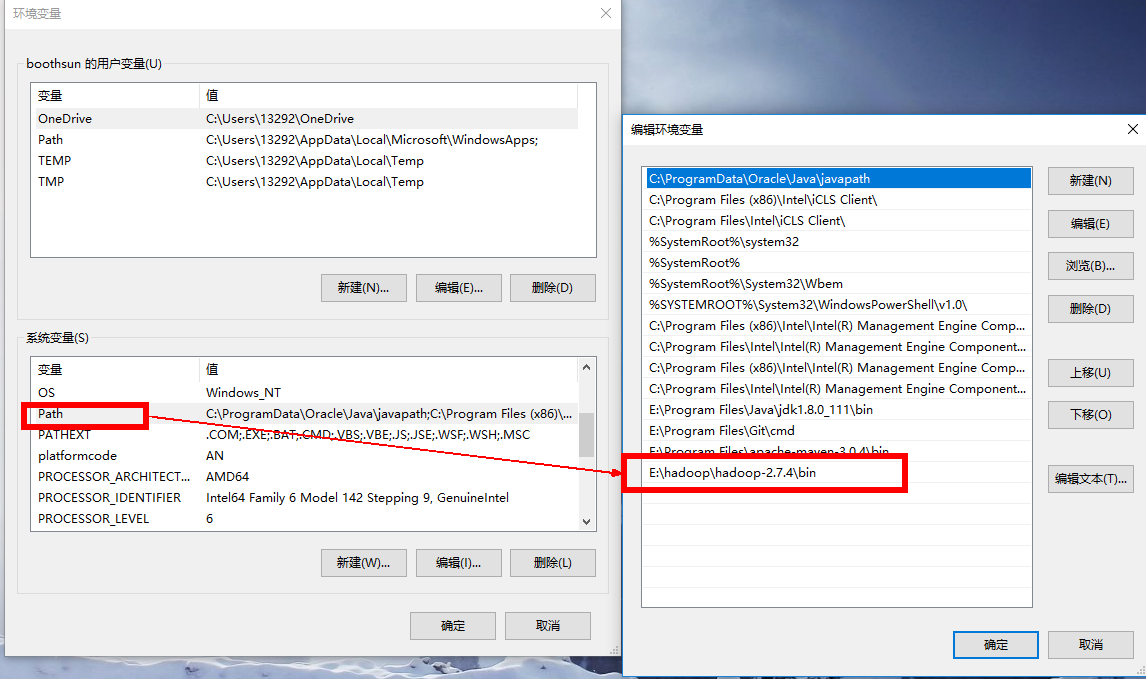

Windows本地解压Hadoop压缩包,然后像配置JDK环境变量一样在系统环境变量里配置HADOOP_HOME和path环境变量。注意:hadoop安装目录尽量不要包含空格或者中文字符。

形如:

添加windows环境下依赖的库文件

- 把盘中(盘地址 提取码:s6uv)共享的bin目录覆盖HADOOP_HOME/bin目录下的文件。

- 如果还是不行,把其中hadoop.dll复制到C:\windows\system32目录下,可能需要重启机器。

- 注意:配置好之后不需要启动Windows上的Hadoop

pom.xml

<!-- hadoop start -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-minicluster</artifactId>

<version>2.7.4</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.4</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-assemblies</artifactId>

<version>2.7.4</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-maven-plugins</artifactId>

<version>2.7.4</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.4</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.7.4</version>

</dependency>

<!-- hadoop end -->

代码

WordMapper:

public class WordMapper extends Mapper<Object,Text,Text,IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

@Override

public void map(Object key , Text value , Context context) throws IOException, InterruptedException{

StringTokenizer itr = new StringTokenizer(value.toString()) ;

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word,one);

}

}

}

WordReducer::

public class WordReducer extends Reducer<Text,IntWritable,Text,IntWritable> {

private IntWritable result = new IntWritable() ;

public void reduce(Text key , Iterable<IntWritable> values, Context context) throws IOException , InterruptedException {

int sum = 0 ;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key,result);

}

}

本地计算 + 本地HDFS文件

public static void main(String[] args) throws Exception{

//如果配置好环境变量,没有重启机器,然后报错找不到hadoop.home 可以手动指定

// System.setProperty("hadoop.home.dir","E:\\hadoop\\hadoop-2.7.4");

List<String> lists = Arrays.asList("E:\\input","E:\\output");

Configuration configuration = new Configuration();

Job job = new Job(configuration,"word count") ;

job.setJarByClass(WordMain.class); // 主类

job.setMapperClass(WordMapper.class); // Mapper

job.setCombinerClass(WordReducer.class); //作业合成类

job.setReducerClass(WordReducer.class); // reducer

job.setOutputKeyClass(Text.class); // 设置作业输出数据的关键类

job.setOutputValueClass(IntWritable.class); // 设置作业输出值类

FileInputFormat.addInputPath(job,new Path(lists.get(0))); //文件输入

FileOutputFormat.setOutputPath(job,new Path(lists.get(1))); // 文件输出

System.exit(job.waitForCompletion(true) ? 0 : 1); //等待完成退出

}

本地计算 + 远程HDFS文件

把远程HDFS文件系统中的文件拉到本地来运行。

相比上面的改动点:

FileInputFormat.setInputPaths(job, "hdfs://master:9000/wcinput/");

FileOutputFormat.setOutputPath(job, new Path("hdfs://master:9000/wcoutput2/"));

注意这里是把HDFS文件拉到本地来运行,如果观察输出的话会观察到jobID带有local字样,同时这样的运行方式是不需要yarn的(自己停掉jarn服务做实验)。

远程计算 + 远程HDFS文件

这个方式是将文件打成一个jar文件,通过Hadoop Client自动上传到Hadoop集群,然后使用远程HDFS文件进行计算。

java代码:

public static void main(String[] args) throws Exception{

Configuration configuration = new Configuration();

configuration.set("fs.defaultFS", "hdfs://master:9000/");

configuration.set("mapreduce.job.jar", "target/wc.jar");

configuration.set("mapreduce.framework.name", "yarn");

configuration.set("yarn.resourcemanager.hostname", "master");

configuration.set("mapreduce.app-submission.cross-platform", "true");

Job job = new Job(configuration,"word count") ;

job.setJarByClass(WordMain2.class); // 主类

job.setMapperClass(WordMapper.class); // Mapper

job.setCombinerClass(WordReducer.class); //作业合成类

job.setReducerClass(WordReducer.class); // reducer

job.setCombinerClass(WordReducer.class); //作业合成类

job.setOutputKeyClass(Text.class); // 设置作业输出数据的关键类

job.setOutputValueClass(IntWritable.class); // 设置作业输出值类

FileInputFormat.setInputPaths(job, "/opt/learning/hadoop/wordcount/*.txt");

FileOutputFormat.setOutputPath(job, new Path("/opt/learning/output7/"));

System.exit(job.waitForCompletion(true) ? 0 : 1); //等待完成退出

}

如果运行过程中遇到权限问题,配置执行时的虚拟机参数 -DHADOOP_USER_NAME=root 。

形如下图:

Windows + IDEA 手动开发MapReduce程序的更多相关文章

- windows环境下Eclipse开发MapReduce程序遇到的四个问题及解决办法

按此文章<Hadoop集群(第7期)_Eclipse开发环境设置>进行MapReduce开发环境搭建的过程中遇到一些问题,饶了一些弯路,解决办法记录在此: 文档目的: 记录windows环 ...

- [MapReduce_add_1] Windows 下开发 MapReduce 程序部署到集群

0. 说明 Windows 下开发 MapReduce 程序部署到集群 1. 前提 在本地开发的时候保证 resource 中包含以下配置文件,从集群的配置文件中拷贝 在 resource 中新建 ...

- 本地idea开发mapreduce程序提交到远程hadoop集群执行

https://www.codetd.com/article/664330 https://blog.csdn.net/dream_an/article/details/84342770 通过idea ...

- [b0010] windows 下 eclipse 开发 hdfs程序样例 (二)

目的: 学习windows 开发hadoop程序的配置 相关: [b0007] windows 下 eclipse 开发 hdfs程序样例 环境: 基于以下环境配置好后. [b0008] Window ...

- 在Eclipse中开发MapReduce程序

一.Eclipse的安装与设置 1.在Eclipse官网上下载eclipse-jee-oxygen-3a-linux-gtk-x86_64.tar.gz文件并将其拷贝到/home/jun/Resour ...

- [b0007] windows 下 eclipse 开发 hdfs程序样例

目的: 学习使用hdfs 的java命令操作 相关: 进化: [b0010] windows 下 eclipse 开发 hdfs程序样例 (二) [b0011] windows 下 eclipse 开 ...

- [b0011] windows 下 eclipse 开发 hdfs程序样例 (三)

目的: 学习windows 开发hadoop程序的配置. [b0007] windows 下 eclipse 开发 hdfs程序样例 太麻烦 [b0010] windows 下 eclipse 开发 ...

- Windows平台开发Mapreduce程序远程调用运行在Hadoop集群—Yarn调度引擎异常

共享原因:虽然用一篇博文写问题感觉有点奢侈,但是搜索百度,相关文章太少了,苦苦探寻日志才找到解决方案. 遇到问题:在windows平台上开发的mapreduce程序,运行迟迟没有结果. Mapredu ...

- hadoop开发MapReduce程序

准备工作: 1.设置HADOOP_HOME,指向hadoop安装目录 2.在window下,需要把hadoop/bin那个目录替换下,在网上搜一个对应版本的 3.如果还报org.apache.hado ...

随机推荐

- UVA.679 Dropping Balls (二叉树 思维题)

UVA.679 Dropping Balls (二叉树 思维题) 题意分析 给出深度为D的完全二叉树,按照以下规则,求第I个小球下落在那个叶子节点. 1. 默认所有节点的开关均处于关闭状态. 2. 若 ...

- react设置默认state和默认props

1.默认状态设置 1.constructor (ES6) constructor(props) { this.state = { n: ... } } 2.getInitialState (ES5) ...

- [学习笔记]FFT——快速傅里叶变换

大力推荐博客: 傅里叶变换(FFT)学习笔记 一.多项式乘法: 我们要明白的是: FFT利用分治,处理多项式乘法,达到O(nlogn)的复杂度.(虽然常数大) FFT=DFT+IDFT DFT: 本质 ...

- PLAN OF HEOI(unfinished)

Au:整体二分/计算几何/多项式/fwtAg:可持久化重量平衡树/线段树分治/线段树合并/最短路树/最短路DAGCu:三分Up:博弈论/置换群/杜教筛/矩阵树定理/BSGS/动态树分治/网络流(线性规 ...

- 002.比较vector对象是否相等

1.使用vector模板 //编写一段程序,比较vector对象是否相等 //注:该例类似于一个[彩票游戏] #include <iostream> #include <ctime& ...

- 手脱ACProtect V1.4X(有Stolen Code)

1.载入PEID ACProtect V1.4X -> risco 首先需要说明的是,这个壳被偷取的代码非常多,如果去找的话会比较麻烦,所以我们换一种另类的方法,不脱壳也可以使用资源修改器对程序 ...

- angularJs $resource自定义方法(待完善)

配置CompanyService var services = angular.module('liaoyuan.services'); services.factory('CompanyServic ...

- 【Android】完善Android学习(二:API 2.3.4)

备注:之前Android入门学习的书籍使用的是杨丰盛的<Android应用开发揭秘>,这本书是基于Android 2.2API的,目前Android已经到4.4了,更新了很多的API,也增 ...

- mvc Dapper_Report_Down_ExcelFile

一.基于Aspose.Cells.Dapper导出Excel Dapper的Query返回要不是对象的IEnumerable,要不是Dynamic的IEnumerable,都不适合不用反射就能够动态获 ...

- C# 从串口读取数据

最近要做系统集成,需要从串口读取数据,随学习一下相关知识: 以下是从串口读取数据 public static void Main() { SerialPort mySerialPort = new S ...