oozie coordinator 定时调度

(本段内容摘自http://blog.sina.com.cn/s/blog_e699b42b0102xjqw.html Oozie总结 行成于思的博客) Oozie提出了Coordinator的概念,它能够将每个工作流Job作为一个动作(Action)来运行,相当于工作流定义中的一个执行节点(我们可以理解为工作流的工作流),这样就能够将多个工作流Job组织起来,称为Coordinator Job,并指定触发时间和频率,还可以配置数据集、并发数等。一个Coordinator Job包含了在Job外部设置执行周期和频率的语义,类似于在工作流外部增加了一个协调器来管理这些工作流的工作流Job的运行。 相比较于单个任务的配置,Coordinator的配置是在job.properties中将oozie.wf.application.path修改为oozie.coord.application.path。并且还要定义一个coordinator.xml

coordinator application:

coordinator application是在满足一组条件时触发动作(通常是工作流作业)的程序。条件可以是时间频率、新数据集实例或其他外部事件。

coordinator application的类型:同步:它的协调器动作是在指定的时间间隔创建的,通常是参数化的。

coordinator job:

要创建一个coordinator job,必须向协调器引擎提供解决所有coordinator application参数的作业配置.

coordinator job是从开始时间到结束时间运行的coordinator application的运行实例,开始时间必须比结束时间早。

通常情况下,一个coordinator 作业是下列状态之一:PREP, RUNNING, RUNNINGWITHERROR, PREPSUSPENDED, SUSPENDED, SUSPENDEDWITHERROR, PREPPAUSED, PAUSED, PAUSEDWITHERROR, SUCCEEDED, DONEWITHERROR, KILLED, FAILED .

有效的coordinator job状态转换是:

PREP --> PREPSUSPENDED | PREPPAUSED | RUNNING | KILLED

RUNNING --> RUNNINGWITHERROR | SUSPENDED | PAUSED | SUCCEEDED | KILLED

RUNNINGWITHERROR --> RUNNING | SUSPENDEDWITHERROR | PAUSEDWITHERROR | DONEWITHERROR | KILLED | FAILED

PREPSUSPENDED --> PREP | KILLED

SUSPENDED --> RUNNING | KILLED

SUSPENDEDWITHERROR --> RUNNINGWITHERROR | KILLED

PREPPAUSED --> PREP | KILLED

PAUSED --> SUSPENDED | RUNNING | KILLED

PAUSEDWITHERROR --> SUSPENDEDWITHERROR | RUNNINGWITHERROR | KILLED

FAILED | KILLED --> IGNORED

IGNORED --> RUNNING

当一个coordinator 提交作业,Oozie解析 coordinator job XML。Oozie然后创建与状态准备coordinator 记录并返回一个唯一的ID,如果没有设置暂停时间coordinator 也立即开始.

Coordinator Action:

coordinator job 创建并执行 coordinator actions.

coordinator action通常是一个workflow job ,它消耗并生成数据集实例。

一旦创建了coordinator action(这也被称为正在实现的action), coordinator action 将一直等待,直到满足执行所需的所有输入,或者直到等待超时为止。

Synchronous Coordinator Application定义:

synchronous coordinator 是由 name, start time ,end time, the frequency of creation of its coordinator actions, the input events, the output events , action control information来定义的.

语法:

<coordinator-app name="[NAME]" frequency="[FREQUENCY]"

start="[DATETIME]" end="[DATETIME]" timezone="[TIMEZONE]"

xmlns="uri:oozie:coordinator:0.1">

#frequency:执行频率,小于五分钟要修改配置 start,end:开始与结束时间,若想跟北京时间一样也要修改配置文件,并修改时间格式

<controls>

<timeout>[TIME_PERIOD]</timeout>

<concurrency>[CONCURRENCY]</concurrency>

<execution>[EXECUTION_STRATEGY]</execution>

</controls>

.

<datasets>

<include>[SHARED_DATASETS]</include>

...

.

<!-- Synchronous datasets --> #---数据生成目录

<dataset name="[NAME]" frequency="[FREQUENCY]"

initial-instance="[DATETIME]" timezone="[TIMEZONE]">

<uri-template>[URI_TEMPLATE]</uri-template>

</dataset>

...

.

</datasets>

.

<input-events> #----定义了数据触发条件

<data-in name="[NAME]" dataset="[DATASET]">

<instance>[INSTANCE]</instance>

...

</data-in>

...

<data-in name="[NAME]" dataset="[DATASET]">

<start-instance>[INSTANCE]</start-instance>

<end-instance>[INSTANCE]</end-instance>

</data-in>

...

</input-events>

<output-events>

<data-out name="[NAME]" dataset="[DATASET]">

<instance>[INSTANCE]</instance>

</data-out>

...

</output-events>

<action>

<workflow>

<app-path>[WF-APPLICATION-PATH]</app-path> #---workflow.xml所在hdfs目录

<configuration>

<property> #----定义传给workflow的参数

<name>[PROPERTY-NAME]</name>

<value>[PROPERTY-VALUE]</value>

</property>

...

</configuration>

</workflow>

</action>

</coordinator-app>

官网给出的例子:

<coordinator-app name="hello-coord" frequency="${coord:days(1)}"

start="2009-01-02T08:00Z" end="2009-01-02T08:00Z"

timezone="America/Los_Angeles"

xmlns="uri:oozie:coordinator:0.1">

<datasets>

<dataset name="logs" frequency="${coord:days(1)}"

initial-instance="2009-01-02T08:00Z" timezone="America/Los_Angeles">

<uri-template>hdfs://bar:8020/app/logs/${YEAR}${MONTH}/${DAY}/data</uri-template>

</dataset>

<dataset name="siteAccessStats" frequency="${coord:days(1)}"

initial-instance="2009-01-02T08:00Z" timezone="America/Los_Angeles">

<uri-template>hdfs://bar:8020/app/stats/${YEAR}/${MONTH}/${DAY}/data</uri-template>

</dataset>

</datasets>

<input-events>

<data-in name="input" dataset="logs">

<instance>2009-01-02T08:00Z</instance>

</data-in>

</input-events>

<output-events>

<data-out name="output" dataset="siteAccessStats">

<instance>2009-01-02T08:00Z</instance>

</data-out>

</output-events>

<action>

<workflow>

<app-path>hdfs://bar:8020/usr/joe/logsprocessor-wf</app-path>

<configuration>

<property>

<name>wfInput</name>

<value>${coord:dataIn('input')}</value>

</property>

<property>

<name>wfOutput</name>

<value>${coord:dataOut('output')}</value>

</property>

</configuration>

</workflow>

</action>

</coordinator-app>

我们工作时写的:

coordinator.xml

<coordinator-app name="cron-coord" frequency="${coord:minutes(6)}" start="${start}" end="${end}" timezone="Asia/Shanghai"

xmlns="uri:oozie:coordinator:0.2">

<action>

<workflow>

<app-path>${workflowAppUri}</app-path>

<configuration>

<property>

<name>jobTracker</name>

<value>${jobTracker}</value>

</property>

<property>

<name>nameNode</name>

<value>${nameNode}</value>

</property>

<property>

<name>queueName</name>

<value>${queueName}</value>

</property>

<property>

<name>mainClass</name>

<value>com.ocn.itv.rinse.ErrorCollectRinse</value>

</property>

</configuration>

</workflow>

</action>

</coordinator-app>

workflow.xml

<workflow-app name="Spark-example1" xmlns="uri:oozie:workflow:0.5">

<start to="spark-SparkOozieAction"/>

<action name="spark-SparkOozieAction">

<spark xmlns="uri:oozie:spark-action:0.1">

<job-tracker>${jobTracker}</job-tracker>

<name-node>${nameNode}</name-node>

<configuration>

<property>

<name>mapred.job.queue.name</name>

<value>${queueName}</value>

</property>

</configuration>

<master>yarn-cluster</master>

<mode>cluster</mode>

<name>Spark Example</name>

<class>${mainClass}</class>

<jar>ocn-itv-spark-3.0.3-rc1.jar</jar>

<spark-opts>${sparkopts}</spark-opts>

<arg>${input}</arg>

</spark >

<ok to="end"/>

<error to="fail"/>

</action>

<kill name="fail">

<message>Action failed, error message[${wf:errorMessage(wf:lastErrorNode())}]</message>

</kill>

<end name="end"/>

</workflow-app>

job.properties nameNode=hdfs://hgdp-001:8020

jobTracker=hgdp-001:8032

queueName=default

input=2017-05-09 #输入参数

start=2017-08-28T17:50+0800 #开始时间

end=2017-08-28T18:50+0800 #结束时间

sparkopts=--executor-memory 1G

oozie.use.system.libpath=True #是否开启系统用户lib库(有action依赖的jar包)

hdfspath=user/root

examplesRoot=ocn-itv-oozie #全局目录

oozie.libpath=${nameNode}/${hdfspath}/${examplesRoot}/lib/ #用户lib库地址(自添加jar包)

workflowAppUri=${nameNode}/${hdfspath}/${examplesRoot}/wf/wf1/ #workflow.xml所在目录

oozie.coord.application.path=${nameNode}/${hdfspath}/${examplesRoot}/cd/cd1/ #coordinator.xml坐在目录

最后运行:

启动任务:oozie job -config job.properties -run -oozie http://xxxx(地址):11000/oozie

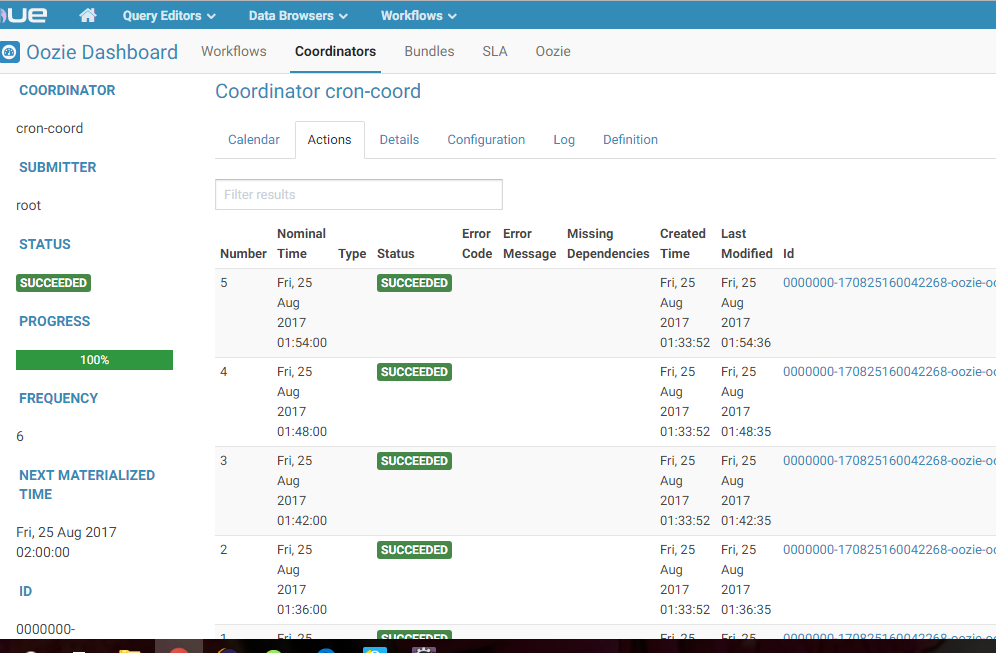

运行结果:

oozie coordinator 定时调度的更多相关文章

- 1.18-1.21 Oozie Coordinator调度

一.时区问题 1.修改系统时区 ## [root@hadoop-senior hadoop-2.5.0-cdh5.3.6]# rm -rf /etc/localtime [root@hadoop-se ...

- Oozie coordinator 作业自定义的配置的一些方法

Oozie的coordinator有啥用? The Oozie Coordinator system allows the user to define and execute recurrent a ...

- 基于Azkaban的任务定时调度实践

本文由云+社区发表 作者:maxluo 一.Azkaban介绍 Azkaban是LinkedIn开源的任务调度框架,类似于JavaEE中的JBPM和Activiti工作流框架. Azkaban功能和特 ...

- Apache Oozie Coordinator 作业自定义配置定时任务

一,介绍 Oozie是Hadoop的工作流系统,如果使用Oozie来提交MapReduce作业(Oozie 不仅仅支持MapReduce作业,还支持其他类型的作业),可以借助Oozie Coordin ...

- Oozie Coordinator job 之定时任务

使用 Coordinator job 可以执行定时任务和时间触发执行 需要注意的是 Oozie 默认使用的时区与中国时区不是一致的,需要进行一点修改 1.关于时区 a.修改 core-site.xml ...

- Quartz定时调度框架

Quartz定时调度框架CronTrigger时间配置格式说明 CronTrigger时间格式配置说明 CronTrigger配置格式: 格式: [秒] [分] [小时] [日] [月] [周] [年 ...

- Spring Quartz定时调度任务配置

applicationContext-quartz.xml定时调度任务启动代码: <?xml version="1.0" encoding="UTF-8" ...

- 定时调度框架Quartz随笔

最近项目中的定时批处理用到了quartz定时任务,在此记录下quartz的配置吧,一个小demo仅供参考,也方便自己今后复习! 下面直接来步骤吧! 一.首先,要搭起能让quartz正常运行的环境,至少 ...

- crontab 定时调度

crontab -e */1 8-23 * * * /www/target/sh/myorder.sh & 0 1 * * * /www/target/php/sh/mymoney.sh &a ...

随机推荐

- php 的基本语法

八种数据类型: 4种标量类型:boolean.integer.float.string 2种复合类型:array.object 2种特殊类型:resource.NULL 如果想看某个表达式的值和类型用 ...

- git平台创建项目(码云)

一.在码云创建项目 1.新建仓库 2,项目名称等 3.创建后的界面 4.克隆远程项目到本地(项目地址和用户名密码) git clone 仓库地址 注意,如果当前目录下出现git仓库同名目录时,会克隆失 ...

- ubuntu root用图形界面登录

http://blog.csdn.net/weimine/article/details/69055536 http://blog.csdn.net/gongxifacai_believe/artic ...

- RabbitMQ之消息持久化

消息的可靠性是RabbitMQ的一大特色,那么RabbitMQ是如何保证消息可靠性的呢——消息持久化. 为了保证RabbitMQ在退出或者crash等异常情况下数据没有丢失,需要将queue,exch ...

- oracle 备份恢复篇(一)---rman

一,rman介绍 RMAN(Recovery Manager)是随Oracle服务器软件一同安装的工具软件,它可以用来备份和恢复数据库文件.归档日志和控制文件,用来执行完全或不完全的数据库恢复.与传统 ...

- 简介SWT Jface

可以使用标准窗口小部件工具箱(Standard Widget Toolkit,SWT)和 JFace 库来开发用于 Eclipse 环境的图形用户界面,而且还可以将它们用于开发单独的 GUI 本机应用 ...

- gitbook一仓库多本书持续化部署

引言 本文档用户指导新手如何部署GitLab+Jenkins自动化构建GitBook,并使用Nginx发布资料.在部署过程中,如遇到任何问题,请自行百度. 注意: 此文章的环境和数据,仅为用于调试的片 ...

- django(6)model表语句操作、Form操作、序列化操作

1.model建表操作之创建索引.元数据 # 单表操作,创建表 class User(models.Model): name = models.CharField(max_length=32) ema ...

- CentOS初使用命令总结

最近买了一台aliyun(ECS服务器)用来学习使用,初次使用难免要走弯路.遇到一些问题好长时间解决不了,结果经人指点豁然开朗.于是乎,总结了一些新生上路经验. 首先要解决的问题是:通过PuTTY.S ...

- 关于meta标签中的http-equiv属性使用介绍

关于meta标签中的http-equiv属性使用介绍 meta是html语言head区的一个辅助性标签.也许你认为这些代码可有可无.其实如果你能够用好meta标签,会给你带来意想不到的效果,meta标 ...