深度学习原理与框架-递归神经网络-RNN_exmaple(代码) 1.rnn.BasicLSTMCell(构造基本网络) 2.tf.nn.dynamic_rnn(执行rnn网络) 3.tf.expand_dim(增加输入数据的维度) 4.tf.tile(在某个维度上按照倍数进行平铺迭代) 5.tf.squeeze(去除维度上为1的维度)

1. rnn.BasicLSTMCell(num_hidden) # 构造单层的lstm网络结构

参数说明:num_hidden表示隐藏层的个数

2.tf.nn.dynamic_rnn(cell, self.x, tf.float32) # 执行lstm网络,获得state和outputs

参数说明:cell表示实例化的rnn网络,self.x表示输入层,tf.float32表示类型

3. tf.expand_dim(self.w, axis=0) 对数据增加一个维度

参数说明:self.w表示需要增加的数据维度,axis表示哪个维度进行增加

4. tf.tile(tf_expand, [num_example, 1, 1]) # 延某个方向进行平铺操作

参数说明:tf_expand表示输入的数据, [num_example, 1, 1] 表示延第一个维度进行num_example倍的平铺迭代

sess = tf.Session()

x = tf.constant([[1,2,1],[1,2,1]])

y = tf.tile(x, [2,1])

print(sess.run(y))

# 代码结果

[[1 2 1]

[1 2 1]

[1 2 1]

[1 2 1]]

5.tf.squeeze(out) # 将维度上为1的维度都进行去除, 代码中将[?, 4, 1] 变成了[?, 4]

参数说明:out为输入数据

代码说明:代码使用了类的构造方式,在初始化阶段,进行参数和输入数据的初始化,同时使用self.model() 构造输出结果y_pred即?, 4, 返回的结果,在初始化过程中,使用tf.reduce_mean(tf.square(y - self.model))计算损失值,使用梯度下降进行优化,使用self.train和self.test输入实际值, 进行模型的训练和预测

数据说明:自己构造[?, 4, 1] 的数据集,数据集的规律是前两个相加等于预测结果,预测样本的维度为[?, 4] 压缩了最后一个维度

模型说明:使用的是单层的cell = rnn.LTSMCell(hidden_num),使用tf.nn.dynamic_rnn(cell, self.x, shape=tf.float32) , 获得输出值维度为[?, 4, 10]

代码主要分为三个部分:

第一部分:主要是构造初始参数,以及self.model() 进行模型的结果输出即y_pred, 对返回值使用均分误差,并使用自适应梯度下降降低损失值,同时构造self.Saver()

第二部分:构造输入函数self.train(self, train_x, train_y) 进行模型的训练,使用self.Saver.save(sess, './model') 进行模型的参数的保存

第三部分:构造输入函数self.test(self.test_x) 进行模型的预测, 使用self.Saver.restore(sess, './model') 进行模型参数的加载

第一部分:

第一步:构造类SeriesPredictor, 使用self.input_size = input_size 将输入转换为内部使用的数

第二步:使用tf.placeholder构造x的维度为[None, seq_size, input_size], 构造y的维度为[None, seq_size], 使用tf.Variable()构造W的维度为[hidden_num, 1], 构造b的维度为[1]

第三步:构造self.model() 用于获得预测值y_pred

第一步:使用rnn.BasicLSTMCell(self.hidden_num) 构造单层的LSTM网络

第二步: 使用tf.nn.dynamic_rnn(cell, self.x, shape=tf.float32)获得outputs和states的输出值,outputs的维度为[?, 4, 10]

第三步:使用tf.shape(self.x)[0] 获得self.x的样品数目

第四步:使用tf.expand_dim增加self.w_out的维度, 再使用tf.tile(tf_expand, [num_examples, 1, 1]) 将第一个维度的大小变得和样本数目self.x的大小相等

第五步:使用tf.matmul(self.x, tf_tile) + self.b_out 获得输出值

第六步:使用tf.squeeze(out) 将out的维度从[?, 4, 1]压缩为[?, 4]

第四步:将self.model() 返回的输出值与self.y 做均分误差用于计算损失值

第五步:tf.train.Adaoptimzer().minimize(cost) # 用于进行损失值的梯度下降

第六步:使用tf.Saver() 构建每个类的存储函数

import tensorflow as tf

import numpy as np

from tensorflow.contrib import rnn class SeriesPredictor: def __init__(self, input_size, seq_size, hidden_num): self.input_size = input_size

self.seq_size = seq_size

self.hidden_num = hidden_num # 使用tf.placeholder设置x和y, 并且设置W, b

self.W_out = tf.Variable(tf.random_normal([hidden_num, 1]), name='W_out')

self.b_out = tf.Variable(tf.constant(0.1, shape=[1]), name='b_out')

self.x = tf.placeholder(tf.float32, [None, seq_size, input_size])

self.y = tf.placeholder(tf.float32, [None, seq_size]) self.cost = tf.reduce_mean(tf.square(self.model() - self.y))

self.train_op = tf.train.AdamOptimizer().minimize(self.cost) self.saver = tf.train.Saver() def model(self): cell = rnn.BasicLSTMCell(self.hidden_num)

outputs, states = tf.nn.dynamic_rnn(cell, self.x, dtype=tf.float32)

num_example = tf.shape(self.x)[0] tf_expand = tf.expand_dims(self.W_out, axis=0)

tf_tile = tf.tile(tf_expand, [num_example, 1, 1])

out = tf.matmul(outputs, tf_tile) + self.b_out

out = tf.squeeze(out) return out

第二部分:在类中构建train函数,输入train_x, train_y 进行模型的训练

第一步:构建sess, tf.get_variable_scope().reuse_variable() 进行模型的参数的复用, 模型的初始化

第二步:sess.run([train_op, cost], feed_dict=) 执行降低损失值和计算cost的操作

第三步:每循环200次,打印损失值和迭代次数i

第四步:self.saver.save(sess, './model') # 将模型参数的sess进行保存

def train(self, train_x, train_y):

# 第一步:构建sess,

with tf.Session() as sess:

# 模型参数的复用

tf.get_variable_scope().reuse_variables()

# 模型初始化

sess.run(tf.global_variables_initializer())

for i in range(1000):

# 第二步:执行降低损失值和计算cost

_, mse = sess.run([self.train_op, self.cost], feed_dict={self.x:train_x, self.y:train_y})

# 第三步:每循环200次,打印结果

if i % 200 == 0:

print(i, mse)

# 第四步:保存sess的参数

save_path = self.saver.save(sess, './model')

print('Model saved to {}'.format(save_path))

第三部分:构建test函数,输入为test_x, 加载sess参数,进行模型的预测

第一步:构建sess函数,使用tf.get_variable_scope().reuse_variable() 进行参数的复用

第二步:使用self.saver.restore(sess, './model') # 进行参数的加载

第三步:使用sess.run(self.model(), feed_dict={self.x:test_x}) 获得实际的预测值y_pred,返回预测的结果

def test(self, test_x):

# 第一步:构建sess,并进行模型参数的复用

with tf.Session() as sess:

tf.get_variable_scope().reuse_variables()

# 第二步:加载sess模型的参数

self.saver.restore(sess, './model')

# 第三步:输出模型的预测结果self.model, 返回结果

out = sess.run(self.model(), feed_dict={self.x:test_x})

return out

代码的主要调用函数

if __name__ == '__main__':

# 实例化模型,input_size表示每一次输入,seq_size表示一共有几个单元,hidden_num表示隐藏层的个数

predictor = SeriesPredictor(input_size=1, seq_size=4, hidden_num=10)

# 训练集的X

train_x = [[[1], [2], [5], [6]],

[[5], [7], [7], [8]],

[[3], [4], [5], [7]]]

# 训练集的y

train_y = [[1, 3, 7, 11],

[5, 12, 14, 15],

[3, 7, 9, 12]]

# 调用实例化函数的train进行模型训练

predictor.train(train_x, train_y)

# 测试集的x

test_x = [[[1], [2], [3], [4]], # 1, 3, 5, 7

[[4], [5], [6], [7]]]

# 测试集的y

actual_y = [[[1], [3], [5], [7]],

[[4], [9], [11], [13]]]

# 调用实例化的y进行模型的预测

pred_y = predictor.test(test_x)

# 打印输出的结果

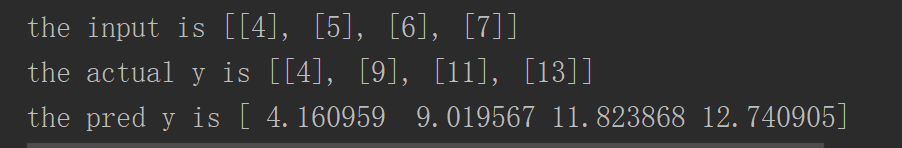

for i, x in enumerate(test_x):

print('the input is {}'.format(x))

print('the actual y is {}'.format(actual_y[i]))

print('the pred y is {}'.format(pred_y[i]))

深度学习原理与框架-递归神经网络-RNN_exmaple(代码) 1.rnn.BasicLSTMCell(构造基本网络) 2.tf.nn.dynamic_rnn(执行rnn网络) 3.tf.expand_dim(增加输入数据的维度) 4.tf.tile(在某个维度上按照倍数进行平铺迭代) 5.tf.squeeze(去除维度上为1的维度)的更多相关文章

- 深度学习原理与框架-递归神经网络-时间序列预测(代码) 1.csv.reader(进行csv文件的读取) 2.X.tolist(将数据转换为列表类型)

1. csv.reader(csvfile) # 进行csv文件的读取操作 参数说明:csvfile表示已经有with oepn 打开的文件 2. X.tolist() 将数据转换为列表类型 参数说明 ...

- 深度学习原理与框架-递归神经网络-RNN网络基本框架(代码?) 1.rnn.LSTMCell(生成单层LSTM) 2.rnn.DropoutWrapper(对rnn进行dropout操作) 3.tf.contrib.rnn.MultiRNNCell(堆叠多层LSTM) 4.mlstm_cell.zero_state(state初始化) 5.mlstm_cell(进行LSTM求解)

问题:LSTM的输出值output和state是否是一样的 1. rnn.LSTMCell(num_hidden, reuse=tf.get_variable_scope().reuse) # 构建 ...

- 深度学习原理与框架-Tensorboard可视化展示(代码) 1.tf.reuse_default_graph(进行结构图的重置) 2.tf.summary.FileWriter(writer实例化) 3. write.add_graph(graph的写入) 4. tf.summary.merge_all(将summary进行合并) 5.write.add_summary(将所有summary)

1. tf.reuse_default_graph() # 对graph结构图进行清除和重置操作 2.tf.summary.FileWriter(path)构造writer实例化,以便进行后续的gra ...

- 深度学习原理与框架-卷积神经网络-cifar10分类(图片分类代码) 1.数据读入 2.模型构建 3.模型参数训练

卷积神经网络:下面要说的这个网络,由下面三层所组成 卷积网络:卷积层 + 激活层relu+ 池化层max_pool组成 神经网络:线性变化 + 激活层relu 神经网络: 线性变化(获得得分值) 代码 ...

- 深度学习原理与框架-卷积神经网络基本原理 1.卷积层的前向传播 2.卷积参数共享 3. 卷积后的维度计算 4. max池化操作 5.卷积流程图 6.卷积层的反向传播 7.池化层的反向传播

卷积神经网络的应用:卷积神经网络使用卷积提取图像的特征来进行图像的分类和识别 分类 相似图像搜索 ...

- 深度学习原理与框架-Tensorflow卷积神经网络-卷积神经网络mnist分类 1.tf.nn.conv2d(卷积操作) 2.tf.nn.max_pool(最大池化操作) 3.tf.nn.dropout(执行dropout操作) 4.tf.nn.softmax_cross_entropy_with_logits(交叉熵损失) 5.tf.truncated_normal(两个标准差内的正态分布)

1. tf.nn.conv2d(x, w, strides=[1, 1, 1, 1], padding='SAME') # 对数据进行卷积操作 参数说明:x表示输入数据,w表示卷积核, stride ...

- 深度学习原理与框架-Tensorflow卷积神经网络-神经网络mnist分类

使用tensorflow构造神经网络用来进行mnist数据集的分类 相比与上一节讲到的逻辑回归,神经网络比逻辑回归多了隐藏层,同时在每一个线性变化后添加了relu作为激活函数, 神经网络使用的损失值为 ...

- 深度学习原理与框架-神经网络-cifar10分类(代码) 1.np.concatenate(进行数据串接) 2.np.hstack(将数据横着排列) 3.hasattr(判断.py文件的函数是否存在) 4.reshape(维度重构) 5.tanspose(维度位置变化) 6.pickle.load(f文件读入) 7.np.argmax(获得最大值索引) 8.np.maximum(阈值比较)

横1. np.concatenate(list, axis=0) 将数据进行串接,这里主要是可以将列表进行x轴获得y轴的串接 参数说明:list表示需要串接的列表,axis=0,表示从上到下进行串接 ...

- 深度学习原理与框架-猫狗图像识别-卷积神经网络(代码) 1.cv2.resize(图片压缩) 2..get_shape()[1:4].num_elements(获得最后三维度之和) 3.saver.save(训练参数的保存) 4.tf.train.import_meta_graph(加载模型结构) 5.saver.restore(训练参数载入)

1.cv2.resize(image, (image_size, image_size), 0, 0, cv2.INTER_LINEAR) 参数说明:image表示输入图片,image_size表示变 ...

随机推荐

- Spring 源码学习(1)—— 容器的基本实现

最近在读Spring的源码,参考的是郝佳的<Spring源码深度解析>,这里把一些学习心得分享一下,总结的地方可能还有一些不完善,希望大家指教 IoC(控制反转)是Spring的特性之一, ...

- 二,编程语言类别,和python变量基础

编程语言类别 机器语言:由二进制组成,直接控制操作硬件,执行效率高,开发效率低. 汇编语言:用英文代替二进制,直接操作控制硬件,执行效率高,开发效率低. 高级语言: 编译型,如C语言,类似谷歌翻译,先 ...

- HTML和CSS标签常用命名规则

1.Images 存放一些网站常用的图片: 2.Css 存放一些CSS文件: 3.Flash 存放一些Flash文件: 4.PSD 存放一些PSD源文件: 5.Temp 存放所有临时图片和其它文件: ...

- Python全栈之路----函数进阶----闭包

关于闭包,即函数定义和函数表达式位于另一个函数的函数体内(嵌套函数).而且,这些内部函数可以访问它们所在的外部函数中声明的所有局部变量.参数.当其中一个这样的内部函数在包含它们之外被调用时,就会形成闭 ...

- XML二

XML的语法要求: 1,XML文档必须有一个顶层元素,即文档元素,所有其他元素必须嵌入在文档元素中. 2,元素嵌套要正确,即如果一个元素在另一个元素中开始,那么必须在同一个元素中结束. 3,每个元素必 ...

- vim粘贴缩进问题

vim不支持直接从其他应用复制内容粘贴过来,而是模拟用户键盘输入来实现的,一般设置vim在换行时自动以上一行的的缩进为初始位置,这样就会导致复制过来的内容出现缩进错乱. set paste 解决粘贴乱 ...

- 【BZOJ2555】SubString

算是学会sam了吧…… 原题: 懒得写背景了,给你一个字符串init,要求你支持两个操作 (1):在当前字符串的后面插入一个字符串 (2):询问字符串s在当前字符串中出现了 ...

- 谈谈 ServerFul 架构

我写了一篇文章 <自己实现一个线程池> https://www.cnblogs.com/KSongKing/p/9803935.html , 其实 不仅仅 是 线程池, 中间件 层 的 ...

- win10 hyper-v 外网设置

1. hyper-v管理器中添加 [虚拟交换机] 2. 为虚拟机添加网络适配器 在[虚拟交换机]中选择新创建的交换机 3. 在本本的[网络连接]中,按下 CTRL 键,然后选择[WLAN]和[vEt ...

- Intellij中部署Tomcat(详细版本-介绍了部署完之后的详细路径)

https://blog.csdn.net/HughGilbert/article/details/56424137 要点如下: 1. CATALINA_HOME即Tomcat的安装目录 2. CAT ...