scrapy实战

采用scrapy实现对股票网站的爬取

功能描述:

技术路线:scrapy

目标:获取上交所和深交所所有股票名称和交易信息并存储

实例编写:

步骤1:建立工程和spider爬虫模板

步骤2:编写spider

步骤3:编写item pipeline

新建工程:

生成名为stocks的爬虫

打开IDE,将项目导入,首先我们要编辑spider文件夹下的stocks.py文件,使其能处理返回的url

import scrapy

import re class StocksSpider(scrapy.Spider):

name = 'stocks'

start_urls = ['http://quote.eastmoney.com/stocklist.html'] def parse(self, response):

for href in response.css('a::attr(href)').extract(): #将a标签中的链接进行提取

try:

stock = re.findall(r"[s][hz]\d{6}", href)[0] #通过正则表达式库来获取股票代码

url = 'https://gupiao.baidu.com/stock/' + stock + '.html'

yield scrapy.Request(url, callback=self.parse_stock) #给出了处理url的响应函数,定义出一个新的函数parse_stock

except:

continue def parse_stock(self, response):

infoDict = {}

stockInfo = response.css('.stock-bets') #找到一个属性为stock-bets的区域

name = stockInfo.css('.bets-name').extract()[0] #提取股票名字

keyList = stockInfo.css('dt').extract() #提取每个dt标签

valueList = stockInfo.css('dd').extract() #提取每个dd标签

for i in range(len(keyList)): #遍历每对标签,提取标签的键和值,并存入列表

key = re.findall(r'>.*</dt>', keyList[i])[0][1:-5]

try:

val =re.findall(r'\d+\.?.*</dd>', valueList[i])[0][1:-5]

except:

val = '--'

infoDict[key] = val infoDict.update(

{'股票名称': re.findall('\s.*\(', name)[0].split()[0] + re.findall('\>.*\<', name)[0][1:-1]}

) #将页面内股票名称和代码存入列表

yield infoDict #以备将列表内的信息传递给ITEM pipeline

接下来要配置pipelines.py文件,定义对爬取项的处理类

class BaidustockPipeline(object):

def process_item(self, item, spider):

return item class BaidustocksInfoPipeline(object):

def open_spider(self, spider): #爬虫被调用时,pipeline所启用的方法

self.f = open('BaiduStockInfo.txt', 'w') def close_spider(self, spider): #爬虫关闭时,pipeline所启用的方法

self.f.close() def process_item(self, item, spider): #将每个股票的信息写入文件中

try:

line = str(dict(item)) + '\n'

self.f.write(line)

except:

pass

return item

在pipelines.py中定义了一个类,为了让程序能找到这个类,需要配置ITEM_PIPELINES选项

打开settings.py,找到ITEM_PIPELINES参数,删除注释号

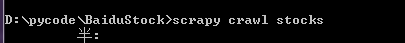

执行命令:

scrapy实战的更多相关文章

- 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息

简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 系统环境:Fedora22(昨天已安装scrapy环境) 爬取的开始URL:ht ...

- Python分布式爬虫开发搜索引擎 Scrapy实战视频教程

点击了解更多Python课程>>> Python分布式爬虫开发搜索引擎 Scrapy实战视频教程 课程目录 |--第01集 教程推介 98.23MB |--第02集 windows下 ...

- Scrapy实战篇(六)之Scrapy配合Selenium爬取京东信息(上)

在之前的一篇实战之中,我们已经爬取过京东商城的文胸数据,但是前面的那一篇其实是有一个缺陷的,不知道你看出来没有,下面就来详细的说明和解决这个缺陷. 我们在京东搜索页面输入关键字进行搜索的时候,页面的返 ...

- Scrapy实战-新浪网分类资讯爬虫

项目要求: 爬取新浪网导航页所有下所有大类.小类.小类里的子链接,以及子链接页面的新闻内容. 什么是Scrapy框架: Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应 ...

- Scrapy实战篇(八)之爬取教育部高校名单抓取和分析

本节我们以网址https://daxue.eol.cn/mingdan.shtml为初始链接,爬取教育部公布的正规高校名单. 思路: 1.首先以上面的地址开始链接,抓取到下面省份对应的链接. 2.在解 ...

- Scrapy实战篇(七)之爬取爱基金网站基金业绩数据

本篇我们以scrapy+selelum的方式来爬取爱基金网站(http://fund.10jqka.com.cn/datacenter/jz/)的基金业绩数据. 思路:我们以http://fund.1 ...

- scrapy实战之scrapyrt的使用

scrapyrt为scrapy提供了一个http接口,有了它,我们不用再执行命令,而是直接请求一个http接口来启动项目,如果项目是部署在远程的,会比较方便. 1.安装: pip install sc ...

- Scrapy实战篇(六)之爬取360图片数据和图片

本篇文章我们以360图片为例,介绍scrapy框架的使用以及图片数据的下载. 目标网站:http://images.so.com/z?ch=photography 思路:分析目标网站为ajax加载方式 ...

- Scrapy实战篇(五)之爬取历史天气数据

本篇文章我们以抓取历史天气数据为例,简单说明数据抓取的两种方式: 1.一般简单或者较小量的数据需求,我们以requests(selenum)+beautiful的方式抓取数据 2.当我们需要的数据量较 ...

- Scrapy实战篇(四)爬取京东商城文胸信息

创建scrapy项目 scrapy startproject jingdong 填充 item.py文件 在这里定义想要存储的字段信息 import scrapy class JingdongItem ...

随机推荐

- 基于flash-marker.js 的地图标注闪烁代码调试

修改网上流传的flash-marker.js (function (global, factory) { typeof exports === 'object' && typeof m ...

- 【转】JSP提交表单

设计表单页面,它是静态页面,使用HTML编写,而且使用了JavaScript脚本语言来验证填写表单数据,表单页面为form.htm,代码如下: <html><head>< ...

- relu函数为分段线性函数,为什么会增加非线性元素

relu函数为分段线性函数,为什么会增加非线性元素 我们知道激活函数的作用就是为了为神经网络增加非线性因素,使其可以拟合任意的函数.那么relu在大于的时候就是线性函数,如果我们的输出值一直是在大于0 ...

- Python中列表的深浅拷贝

copy_lst = [ ('py对象三要素',), ('== 比较运算符',), ('is 身份运算符',), ('小数据池',), ('列表的浅拷贝',), ('列表的深拷贝',), ] py对象 ...

- CMD终端关于pip报错,scrapy报错的一种处理方法

CMD终端关于pip报错,scrapy报错的一种处理方法 如果在终端输入pip,或scrapy,报如下错误: Fatal error in launcher: Unable to create pro ...

- 华为liteos了解(一)

我来补充一下,从@華仔答案的提供的wiki中看,随便翻了一下,内核部分和协议栈的接口部分代码风格完全不一致.协议栈和相关的代码应该是直接使用或者修改了uIP (micro IP)的实现,所以整体感觉应 ...

- 笔记-python-standard library-8.5.heapq

笔记-python-standard library-8.5.heapq 1. heapq-heap queue algorithm源码:Lib/heapq.pythis module provide ...

- SSRS 报表管理器 http://localhost/Reports HTTP500 内部错误处理过程

原文地址:http://www.cnblogs.com/zzry/p/5716056.html 安装了很多机器的sqlserverBI 组件 初始安装配置下 浏览报表管理器 http://localh ...

- Wordpress 作者模板页中的自定义帖子类型分页问题

<?php // 获取当前页面的页数,函数的参数为 paged $paged = (get_query_var('paged')) ? get_query_var('paged') : 1; $ ...

- TOJ5272: 逆矩阵

5272: 逆矩阵 Time Limit(Common/Java):1000MS/3000MS Memory Limit:65536KByteTotal Submit: 11 ...