virtio,macvtap,sriov

本文转自http://xiaoli110.blog.51cto.com/1724/1558984

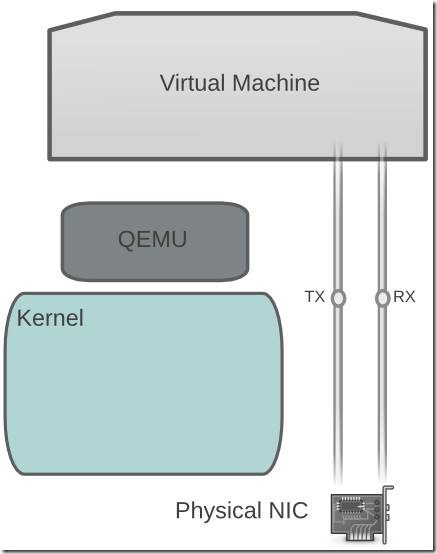

一个完整的数据包从虚拟机到物理机的路径是:

虚拟机--QEMU虚拟网卡--虚拟化层--内核网桥--物理网卡

KVM的网络优化方案,总的来说,就是让虚拟机访问物理网卡的层数更少,直至对物理网卡的单独占领,和物理机一样的使用物理网卡,达到和物理机一样的网络性能。

方案一 全虚拟化网卡和virtio

Virtio与全虚拟化网卡区别

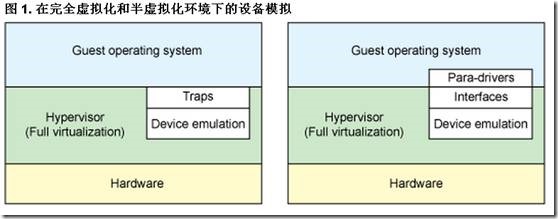

全虚拟化网卡是虚拟化层完全模拟出来的网卡,半虚拟化网卡通过驱动对操作系统做了改造;

viritio简单的说,就是告诉虚拟机,hi 你就是在一个虚拟化平台上跑,咱们一起做一些改动,让你在虚拟化平台上获得更好的性能;

关于virtio的使用场景

因 为windows虚拟机使用viritio有网络闪断的情况发生,windows 虚拟机如果网络压力不高,建议使用e1000这样的全虚拟化网卡,如果网络压力比较高,建议使用SRIVO或者PCI Device Assignment这样的技术;viritio也在不断的演进,希望windows的闪断的问题越来越少。

KVM天生就是为linux系统设计的,linux系统请放心大胆的使用viritio驱动;

方案二 vhost_net macvtap技术

vhost_net使虚拟机的网络通讯直接绕过用户空间的虚拟化层,直接可以和内核通讯,从而提供虚拟机的网络性能;

macvtap则是跳过内核的网桥;

使用vhost_net,必须使用virtio半虚拟化网卡;

vhost_net虚拟机xml文件配置,

- <interface type='bridge'>

- <mac address=''/>

- <source bridge='br0'/>

- <model type='virtio'/>

- <driver name="vhost"/>

- <address type='pci' domain='0x0000' bus='0x00' slot='0x03' function='0x0'/>

- </interface>

如果不使用vhost_net,则为

- <driver name="qemu"/>

macvtap 虚拟机xml配置

- <interface type='direct'>

- <mac address='00:16:3e:d5:d6:77'/>

- <source dev='lo' mode='bridge'/>

- <model type='e1000'/>

- <address type='pci' domain='0x0000' bus='0x00' slot='0x03' function='0x0'/>

- </interface>

注意:macvtap在windows虚拟机上性能很差,不建议使用

vhost_net macvtap比较

macvlan的功能是给同一个物理网卡配置多个MAC地址,这样可以在软件商配置多个以太网口,属于物理层的功能。

macvtap是用来替代TUN/TAP和Bridge内核模块,macvtap是基于macvlan这个模块,提供TUN/TAP中tap设备使用的接口,

使用macvtap以太网口的虚拟机能够通过tap设备接口,直接将数据传递到内核中对应的macvtap以太网口。

vhost-net是对于virtio的优化,virtio本来是设计用于进行客户系统的前端与VMM的后端通信,减少硬件虚拟化方式下根模式个非根模式的切换。

而是用vhost-net后,可以进一步进入CPU的根模式后,需要进入用户态将数据发送到tap设备后再次切入内核态的开销,而是进入内核态后不需要在进行内核态用户态的切换,进一步减少这种特权级的切换,说vhost-net属于哪个层不准确,而是属于进行二层网络数据传递的优化。

方案三 虚拟机网卡独占

网卡passthrough在虚拟机的配置方法

1 使用lcpci 设备查看pci设备信息

- 04:00.0 Ethernet controller: Intel Corporation 82571EB Gigabit Ethernet Controller (rev 06)

- 04:00.1 Ethernet controller: Intel Corporation 82571EB Gigabit Ethernet Controller (rev 06)

也可以使用virsh nodedev-list –tree得到信息

- +- pci_0000_00_07_0

- | |

- | +- pci_0000_04_00_0

- | | |

- | | +- net_p1p1_00_1b_21_88_69_dc

- | |

- | +- pci_0000_04_00_1

- | |

- | +- net_p1p2_00_1b_21_88_69_dd

2 使用virsh nodedev-dumxml pci_0000_04_00_0得到xml配置信息

- [root@]# virsh nodedev-dumpxml pci_0000_04_00_0

- <device>

- <name>pci_0000_04_00_0</name>

- <parent>pci_0000_00_07_0</parent>

- <driver>

- <name>e1000e</name>

- </driver>

- <capability type='pci'>

- <domain>0</domain>

- <bus>4</bus>

- <slot>0</slot>

- <function>0</function>

- <product id='0x105e'>82571EB Gigabit Ethernet Controller</product>

- <vendor id='0x8086'>Intel Corporation</vendor>

- </capability>

- </device>

3 编辑虚拟机xml文件,加入pci设备信息

- <hostdev mode='subsystem' type='pci' managed='yes'>

- <source>

- <address domain='0x0000' bus='0x04' slot='0x00' function='0x0'/>

- </source>

- </hostdev>

Domain bus slot function信息从dumpxml出的xml文件获取,define虚拟机,然后开启虚拟机就可以,注意以为附件上去的是物理设备,需要在系统里面安装相应的驱动。

方案四 SR-IVO技术

SRIOV的原理

SR-IVO 是the single root I/O virtualization 的简写,是一个将PCIe共享给虚拟机使用的标准,目前用在网络设备上比较多,理论上也可以支持其他的PCI设备,SRIOV需要硬件的支持。

以下内容来自oracle网站,链接为

http://docs.oracle.com/cd/E38902_01/html/E38873/glbzi.html

物理功能 (Physical Function, PF)

用 于支持 SR-IOV 功能的 PCI 功能,如 SR-IOV 规范中定义。PF 包含 SR-IOV 功能结构,用于管理 SR-IOV 功能。PF 是全功能的 PCIe 功能,可以像其他任何 PCIe 设备一样进行发现、管理和处理。PF 拥有完全配置资源,可以用于配置或控制 PCIe 设备。

虚拟功能 (Virtual Function, VF)

与物理功能关联的一种功能。VF 是一种轻量级 PCIe 功能,可以与物理功能以及与同一物理功能关联的其他 VF 共享一个或多个物理资源。VF 仅允许拥有用于其自身行为的配置资源。

每 个 SR-IOV 设备都可有一个物理功能 (Physical Function, PF),并且每个 PF 最多可有 64,000 个与其关联的虚拟功能 (Virtual Function, VF)。PF 可以通过寄存器创建 VF,这些寄存器设计有专用于此目的的属性。

一 旦在 PF 中启用了 SR-IOV,就可以通过 PF 的总线、设备和功能编号(路由 ID)访问各个 VF 的 PCI 配置空间。每个 VF 都具有一个 PCI 内存空间,用于映射其寄存器集。VF 设备驱动程序对寄存器集进行操作以启用其功能,并且显示为实际存在的 PCI 设备。创建 VF 后,可以直接将其指定给 IO 来宾域或各个应用程序(如裸机平台上的 Oracle Solaris Zones)。此功能使得虚拟功能可以共享物理设备,并在没有 CPU 和虚拟机管理程序软件开销的情况下执行 I/O。

SR-IOV 的优点

SR-IOV 标准允许在 IO 来宾域之间高效共享 PCIe 设备。SR-IOV 设备可以具有数百个与某个物理功能 (Physical Function, PF) 关联的虚拟功能 (Virtual Function, VF)。VF 的创建可由 PF 通过设计用来开启 SR-IOV 功能的寄存器以动态方式进行控制。缺省情况下,SR-IOV 功能处于禁用状态,PF 充当传统 PCIe 设备。

具有 SR-IOV 功能的设备可以利用以下优点:

1.性能-从虚拟机环境直接访问硬件。

2.成本降低-节省的资本和运营开销包括:

- 节能

- 减少了适配器数量

- 简化了布线

- 减少了交换机端口

SRIOV的使用

启动SRIVO内核模块

modprobe igb

激活虚拟功能VF

modprobe igb max_vfs=7

千兆网卡最多支持8个vf0-7,千兆网卡目前支持比较好的是INTEL I350, 82576S虽然也支持SRIOV但是只支持虚拟机是linux的情况,windows系统不支持;

万兆网卡最多支持64个vg0-63,intel的新新一代万兆网卡都支持SRIOV x520 x540等;

如果需要重新设置vf 可以删除模块在重新加载

modprobe -r igb

将配置永久写入配置文件

echo "options igb max_vfs=7" >>/etc/modprobe.d/igb.conf

通过lspci命令可以看多主网卡和子网卡

- # lspci | grep 82576

- 0b:00.0 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01)

- 0b:00.1 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01)

- 0b:10.0 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:10.1 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:10.2 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:10.3 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:10.4 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:10.5 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:10.6 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:10.7 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:11.0 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:11.1 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:11.2 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:11.3 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:11.4 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

- 0b:11.5 Ethernet controller: Intel Corporation 82576 Virtual Function (rev 01)

虚拟机可以听过pci网卡独占的方式使用子网卡;

- <interface type='hostdev' managed='yes'>

- <source>

- <address type='pci' domain='0' bus='11' slot='16' function='0'/>

- </source>

- </interface>

方案五 网卡多队列

centos 7开始支持virtio网卡多队列,可以大大提高虚拟机网络性能,配置方法如下:

虚拟机的xml网卡配置

- <interface type='network'>

- <source network='default'/> <model type='virtio'/> <driver name='vhost' queues='N'/> </interface>

N 1 - 8 最多支持8个队列

在虚拟机上执行以下命令开启多队列网卡

- #ethtool -L eth0 combined M

N 1 - 8 最多支持8个队列

在虚拟机上执行以下命令开启多队列网卡

- #ethtool -L eth0 combined M

KVM网络优化方案个人认为以硬件为主,硬件上万兆+SRIOV的方案会越来越普及,但是在线迁移的问题有待解决。

本文出自:http://xiaoli110.blog.51cto.com/1724/1558984

virtio,macvtap,sriov的更多相关文章

- [转] Firewall and network filtering in libvirt

Firewall and network filtering in libvirt There are three pieces of libvirt functionality which do n ...

- Neutron中的网络I/O虚拟化

为了提升网络I/O性能.虚拟化的网络I/O模型也在不断的演化: 1,全虚拟化网卡(emulation).如VMware中的E1000用来仿真intel 82545千兆网卡,它的功能更完备,如相比一些半 ...

- dpdk对虚拟化的支持调研

目录: 虚拟化 dpdk的实现研究 virtio vhost SR-IOV 热迁移相关 研究拓展 本文记录近期对dpdk在虚拟化和云计算领域应用的研究成果,内容梳理如下. 虚拟化 虚拟化,抽象来说,就 ...

- OpenStack 虚拟机热迁移流程图

目录 文章目录 目录 源计算节点与目的计算节点之间的交互流程 Nova 和 Neutron 之间的交互流程 源计算节点与目的计算节点之间的交互流程 热迁移主要包括三个阶段: pre_live_migr ...

- KVM 介绍(4):I/O 设备直接分配和 SR-IOV [KVM PCI/PCIe Pass-Through SR-IOV]

学习 KVM 的系列文章: (1)介绍和安装 (2)CPU 和 内存虚拟化 (3)I/O QEMU 全虚拟化和准虚拟化(Para-virtulizaiton) (4)I/O PCI/PCIe设备直接分 ...

- macvtap与vhost-net技术

MacVlan的功能是给同一个物理网卡配置多个MAC地址,可以在软件上配置多个以太网口,属于物理层的功能.MacVTap是用来替代TUN/TAP和Bridge内核模块的.MacTap是基于MacVla ...

- KVM(四) I/O 设备直接分配和 SR-IOV

(4):I/O 设备直接分配和 SR-IOV 本文将分析 PCI/PCIe 设备直接分配(Pass-through)和 SR-IOV, 以及三种 I/O 虚拟化方式的比较. 1. PCI/PCI-E ...

- macvtap使用教程

kubernetes一键安装 macvtap是虚拟机网络虚拟化常用的一种技术,当然容器也可以用. MACVTAP 的实现基于传统的 MACVLAN. 和 TAP 设备一样,每一个 MACVTAP 设备 ...

- SR-IOV

SR-IOV 来源 http://blog.csdn.net/liushen0916/article/details/52423507 摘要: 介绍SR-IOV 的概念.使用场景.VMware 和 K ...

随机推荐

- 在网站开发时,可以设置防盗,不被复制和F12

禁止小功能 //禁止右键 document.oncontextmenu = function () { return false } //禁止f12 document.onkeydown = func ...

- Shell脚本2

5 Shell传递参数 我们可以在执行 Shell 脚本时,向脚本传递参数, 脚本内获取参数的格式为:$n.n 代表一个数字,1 为执行脚本的第一个参数,2 为执行脚本的第二个参数,以此类推…… ...

- Java 数据库操作

目录 Java数据库组织架构 下载驱动包 连接数据库 连接数据库的三个步骤 连接数据库的高开销 Statement接口介绍 PreparedStatement类 使用PreparedStatement ...

- jenkins配置SSH远程服务器连接

之前用jenkins做了一个自动发布测试,配置任务的Post Steps时,选择的是执行shell命令.如下图: 这是在本192.168.26.233服务器上测试的,此服务器上运行jenkins,to ...

- Day 3-3 内置方法

常用内置函数方法: min,max li = [1, 2, 3, 6, 9, 5, 10, 26] print('li的最小值是:', min(li)) # 取最小值 print('li的最大值是:' ...

- docker遇到的问题以及docker 操作镜像的基本操作

root@localhost ~]# systemctl status docker.service ● docker.service - Docker Application Container E ...

- longquan

/** * 登录后将数据填写到主数据 */ public void login(String login_nr) { //File f = new File(android.os.Environmen ...

- WPF 如何创建自己的WPF自定义控件库

在我们平时的项目中,我们经常需要一套自己的自定义控件库,这个特别是在Prism这种框架下面进行开发的时候,每个人都使用一套统一的控件,这样才不会每个人由于界面不统一而造成的整个软件系统千差万别,所以我 ...

- Delphi 限制Edit输入 多个例子

procedure TForm1.Edit1KeyPress(Sender: TObject; var Key: Char); begin if not (key in [ '.',#8]) then ...

- Python 第三方库 cp27、cp35 等文件名的含义(转)

转自 https://blog.csdn.net/lanchunhui/article/details/62417519 转自 https://stackoverflow.com/questions/ ...