Computer Vision_33_SIFT:Speeded-Up Robust Features (SURF)——2006

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面。对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献。有一些刚刚出版的文章,个人非常喜欢,也列出来了。

33. SIFT

关于SIFT,实在不需要介绍太多,一万多次的引用已经说明问题了。SURF和PCA-SIFT也是属于这个系列。后面列出了几篇跟SIFT有关的问题。

[1999 ICCV] Object recognition from local scale-invariant features

[2000 IJCV] Evaluation of Interest Point Detectors

[2006 CVIU] Speeded-Up Robust Features (SURF)

[2004 CVPR] PCA-SIFT A More Distinctive Representation for Local Image Descriptors

[2004 IJCV] Distinctive Image Features from Scale-Invariant Keypoints

[2010 IJCV] Improving Bag-of-Features for Large Scale Image Search

[2011 PAMI] SIFTflow Dense Correspondence across Scenes and its Applications

翻译

加速的强大功能(SURF)——http://tongtianta.site/paper/26242

作者:Herbert Bay, Andreas Ess, Tinne Tuytelaars, Luc Van Gool

摘要 - 这篇文章提出了一种尺度和旋转不变的检测子和描述子,称为SURF(Speeded-Up Robust Features)。SURF在可重复性、鉴别性和鲁棒性方面都接近甚至超过了以往的方案,同时计算和比较的速度更快。

这依赖于使用了积分图进行图像卷积、使用现有的最好的检测子和描述子(特别是,基于Hessian矩阵方法的检测子,和基于分布的描述子)、以及简化这些算法到了极致。这些最终实现了新的检测、描述和匹配过程的结合。

本文包含对检测子和描述子的详细阐述,之后探究了一些关键参数的作用。作为结论,我们用两个目标相反的应用测试了SURF的性能:摄像头校准(图像配准的一个特列)和目标识别。我们的实验验证了SURF在计算机视觉广泛领域的实用性。

1.引言

在两个图片中找到相似场景或目标的像素点一致性,这是许多计算机视觉应用中的一项任务。图像配准,摄像头校准,目标识别,图像检索只是其中的一部分。

寻找离散像素点一致性的任务可以分为三步。第一,选出兴趣点并分别标注在图像上,例如拐角、斑块和T型连接处。兴趣点检测子最有价值的特性是可重复性。可重复性表明的是检测子在不同视觉条件下找到相同真实兴趣点的能力。然后,用特征向量描述兴趣点的邻域。这个描述子应该有鉴别性,同时对噪声、位移、几何和光照变换具有鲁棒性。最后,在不同的图片之间匹配特征向量。这种匹配基于向量间的马氏或者欧氏距离。描述子的维度对于计算时间有直接影响,对于快速兴趣点匹配,较小的维度是较好的。然而,较小的特征向量维度也使得鉴别度低于高维特征向量。

我们的目标是开发新的检测子和描述子,相对于现有方案来说,计算速度更快,同时又不牺牲性能。为了达成这一目标,我们必须在二者之间达到一个平衡,在保持精确性的前提下简化检测方案,在保持足够鉴别度的前提下减少描述子的大小。

相关文献(e.g[21,24,27,37,39,25])已经提出了大量的检测子和描述子。同时,基于基准数据库的详细的对于和评估也已经进行过[28,30,31]。我们的快速检测子和描述子在[4]中介绍过,被称为SURF(Speeded-Up Robust Features)。它建立在前人的成就上。在我们对基准数据库的实验上,SURF检测子和描述子不止更快,而且可重复性更好,同时鉴别力更高。

我们关注于尺度和平面内旋转不变的检测子和描述子。对于常见的光学畸变,这似乎在特征复杂性和鲁棒性之间达到了妥协。倾斜,各向异质性,缩放和透视效应被认为是次要影响,在一定程度上可以被描述子的鲁棒性修复。注意到使用椭圆放射正规化,描述子可以扩展到放射不变区域(cf.[31]),虽然这将会影响到计算时间。另一方面,检测子的扩展并不那么直观。我们假定一个简单的线性模型,带有偏置(偏移)和反向变化(尺度因子)。检测子和描述子都没有使用颜色信息。

这篇文章的结构如下。 在第2节中,我们对兴趣点检测和描述的先前工作进行了回顾。在第三部分描述了用于快速鲁棒兴趣点检测的策略。对输入图像在不同尺度上进行了分析,以确保尺度不变形。检测到的兴趣点在第四部分用旋转和尺度不变描述子进行了表述。此外,还提出了一种基于兴趣点和邻域对比的简单高效的首行索引技巧。

第五部分讨论了可用参数及其影响,包括垂直版本(非旋转不变)的优点。我们同样研究了SURF在两种重要应用场景中的表现。首先,我们考虑了一种特殊的图像配准场景,称为3D重建中的摄像头校准。然后,我们试验了SURF在目标识别中的应用。相对于其他方法,这两个应用都突出了SURF的速度和鲁棒性。第六部分是一个总结。

2.相关工作

2.1 兴趣点检测

最常用的检测子是1988年提出的基于二阶矩矩阵的Harris角点检测子[15]。然而,Harris角点不是尺度不变的。Lindeberg[21]介绍了自动尺度选择的概念,可以根据兴趣点的特征尺寸检测兴趣点。他用Hessian矩阵和Laplacian矩阵的秩(以及Hessian的迹)检测类似斑块的结构。Mikolajczyk and Schmid[26]提炼了这种方法,创造了鲁棒性好,尺度不变,高重复性的特征检测子,称为Harris-Laplace和Hessian-Laplace。他们使用(适应尺度的)Harris方法或者Hessian矩阵行列式来选择位置,使用Laplacian选择尺度。为了提高速度,Lowe[23]提出了用Difference of Gaussians (LoG)来近似Difference of Gaussians (DoG)的方法。

此外还有其他尺度不变检测子,例如Kadir and Brady[17]提出的显著区域检测子,这种检测子将一个区域内的熵最大化,另外还有Jurie and Schmid[16]的基于边缘的检测子。这些算法不易优化,尽管几个放射不变特征检测子已经被提出用来应对宽视角变化,然而这些超出了本文的范围。

通过公开资料对现有检测子的对比[29,30],我们能得出结论,基于Hessian矩阵的检测子比基于Harris的更稳定和可重复。另外,Hessian矩阵行列式也比迹有优势,因为它对于拖尾的,局部错误的结构误警更少。我们同样观察到,它的DoG近似能在损失精确度的情况下提高速度。

2.2 兴趣点描述

特征描述子有很多种,例如高斯导数[11]、不变矩[32]、符合特征[1,36]、可控滤波[12]、基于相位的局部特征[6]等。描述子代表兴趣点附近的小范围特征分布。Lowe发明的基于相位局部特征[24]已经被证明优于其他的[28]。这是因为其获取了大量空间强度信息,同时对小范围变形和局部错误有稳健性。文献[24]中的SIFT描述子计算兴趣点附近的方向梯度柱状图,存储为128D向量(八个方向数据,每个方向含4x4个分量)。

这种基本方法的优化版本有很多。Ke and Sukthankar[18]把PCA加入到兴趣点附近的梯度图。PCA-SIFT输出36D描述子,匹配更快,但是Mikolajczyk 在一篇对比论文中[30]指出,其鉴别度低于SIFT,并且PCA计算低于SIFT。在同篇论文中[30],作者提出了一种SIFT的变种,叫做GLOH,它的鉴别度比SIFT高,但是计算量更高,因为这种算法也使用PCA提取数据。

实际应用中,SIFT描述子描述子仍然是最吸引人,也是最常用的描述子。它的鉴别度和速度对于即时应用很关键。最近,Se et al.[37]在Field Programmable Gate Array(FPGA)上实现了SIFT算法,速度提高了一个数量级。同时,Grabner et al.[14]用积分图近似SIFT。他们的检测方法基于difference-of-mean(不需要插值),描述子基于积分柱状图。他们达到了和我们相同的速度(虽然特征描述的速度是固定的),但是是以降低SIFT的质量为代价的。概况的说,描述子的高维度是SIFT在匹配阶段的缺点。对于普通PC上的即时应用来说,这三个阶段(检测、描述、匹配)都要快。

提高匹配速度的方法有很多,全都是减少近似匹配的计算量。这些方法包括:Lowe的最优值优先[24]、balltrees[35]、词汇树[34]、位置敏感哈希[9]、冗余比特向量[13]等。此外,我们建议使用Hessian矩阵来大大提高匹配速度。同时减少描述子的维度,任何匹配算法都能提高速度。

3.兴趣点检测

我们的兴趣点检测方法使用了非常基本的Hessian矩阵近似,使用由Viola和Jones推广的积分图[41],这将大大减少计算量。Simard et al.[38]指出,积分图适用于大量箱式小波的一般框架。

3.1 积分图

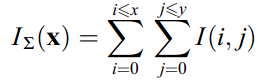

为了让这篇文章更完备,我们简要讨论一下积分图的概念。它使得箱型卷积滤波速度更快。积分图IΣ(X)在位置X = (x, y)处代表I在X之前的矩形区域像素值的和。

, (1)

, (1)

一旦积分图计算好了,计算任何垂直矩形区域的密度只需要三个加法(如图.1)。因此,计算时间将不依赖于大小。这在我们的方法中是很重要的,因为我们使用大尺寸滤波器。

图1.使用积分图像,只需要三个加法和四个内存访问即可计算任何大小的矩形区域内的强度总和。

3.2 基于Hessian矩阵的兴趣点检测

我们使用Hessian矩阵是因其良好的精确度。确切的说,我们检测行列式最大的类似斑块的结构。相对于Mikolajczyk和Schmid的Hessian-Laplace检测子[26],我们同样使用Hessian矩阵来选择尺度,这一点Lindeberg已经做过[21]。

对于一个图像中的点X = (x, y),尺度为σ的Hessian矩阵H(X, σ)定义为:

, (2)

, (2)

其中Lxx(X, σ)为点X处的高斯二阶倒数 的卷积。Lxy(X, σ)和Lyy(X, σ)与之类似。

的卷积。Lxy(X, σ)和Lyy(X, σ)与之类似。

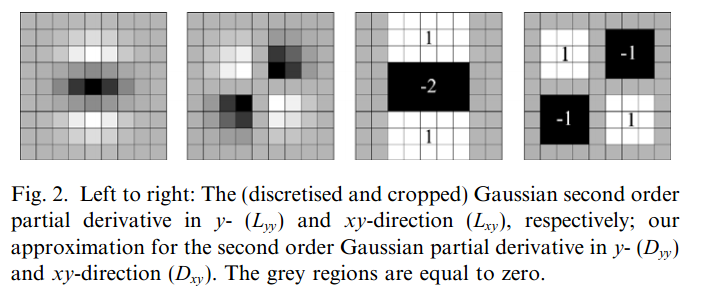

高斯对于尺度分析是最优的[19,20],但在实际应用中需要离散化和裁剪(图.2左半部分)。这使其在π/4的奇数倍旋转时的可重复性有损失。这是基于Hessian检测子的通病。图.3显示了两种基于Hessian的检测子对于单纯图像旋转的可重复性。可重复性在π/2的整数倍时达到最大,这是因为滤波器是方形的。然而,检测子的表现还是不错的,性能的微小减少并不比离散和裁剪带来的快速卷积的优点重要。实际的滤波器不可能是理想的,考虑到Lowe在LoG近似方法上的成功,我们进一步近似了Hessian矩阵(图.2的右半部分)。这种高斯二阶倒数近似可以利用积分图,大大减少计算复杂度。计算时间也不依赖于滤波器大小。第五部分和图.3显示,其性能与离散裁剪的高斯法相当或更好。

图2:从左到右:分别在y-( )和xy-方向(

)和xy-方向( )中的(离散和裁剪)高斯二阶偏导数;我们对y-(

)中的(离散和裁剪)高斯二阶偏导数;我们对y-( )和xy-方向(

)和xy-方向( )中的二阶高斯偏导数的近似。灰色区域等于零。

)中的二阶高斯偏导数的近似。灰色区域等于零。

图2中的9x9方形滤波器是σ=1.2的高斯滤波器的近似,这也是计算斑块响应图的最小的尺度(最大的空间分辨率)。我们将其标注为Dxx,Dyy和Dxy。为了计算简单,我们将方形区域的权重设为固定值。因此:

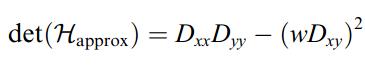

(3)

(3)

滤波器响应的相关权重w是为了平衡Hessian行列式的表达式。这是为了保持高斯核和近似高斯核的能量守恒。

(4)

(4)

其中|X|F是Frobenius范数。为了理论上的正确性,权重需要根据尺度变化。实际中,我们设为常数,因为它对实验结果并没有重要影响。

此外,滤波器响应根据尺度进行了归一化,这保证了对于不同尺寸有等量的Frobenius范数,这是上一节中讨论的,对于尺度分析很重要的一方面。

近似的Hessian行列式代表了图像在X点处的斑块响应。这些响应保存在不同尺度的斑块响应图中,3.4节中将会检测局部最大值。

3.3 尺度空间表示

兴趣点需要在不同的尺度进行检测,不只是因为一致性搜索的比较需要在不同尺度的图片中进行。尺度空间通常以图像金字塔的形式呈现。图像多次被高斯平滑,然后下采样,以得到金字塔高层的图像。Lowe[24]将金字塔不同层次的图像相减以得到DoG (Difference of Gaussi-ans)图像。

图4.代替迭代减小图像大小(左),使用积分图像可以使过滤器按恒定成本进行放大(右)。

因为用了积分图,我们不需要将同样的滤波器迭代应用在上次输出的图层上,而是使用任意尺度的方形滤波器,这样不同层可以有同样的速度,甚至可以并行执行(虽然还未在本文使用)。因此,尺度空间是使用放大的滤波器尺度,而不是迭代减小图像大小。图.4是上节介绍的9x9滤波器输出,这是初始尺度层,我们记为尺度s = 1.2(近似于σ=1.2的高斯导数)。接下来的图层通过使用逐渐增大的滤波器得到,也利用积分图的离散特性和我们滤波器的特殊结构。

我们这样采样的动机是为了减小计算量。此外,因为我们不需要下采样,因此也不需要对齐。在下层,方形滤波器保存放大后会消失的高频部分,这会限制尺度不变性。然而这在我们的实验中并不明显。

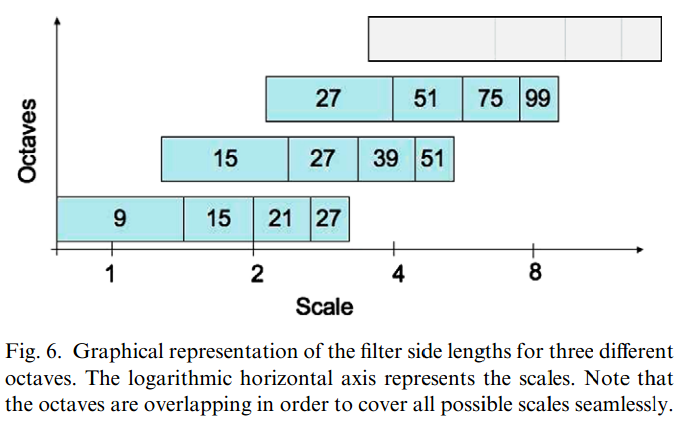

尺度空间被划分为组,一组代表一系列滤波器响应图,通过对同样的图像使用不断增大的滤波器卷积得到。总体上,一组包含尺度因子为2(这意味着滤波器大小需要至少增加一倍)。一个组又被分为固定数量的子尺度层。因为积分图的离散型,两个子层间的最小尺度差依赖于l0,二阶偏导在倒数方向(x或y)的突出块的长度,这个值被设置为滤波器大小的三分之一。对于9x9滤波器,这个值是3。对于两个连续层,尺度至少增加2像素(一边一个),以保持大小为偶数,确保中心点的存在。这使得总的覆盖面积增加了6像素(如图.5)。另外,由于l0对于面积的差异性(例如,垂直滤波器中间段的宽度),滤波器大小的调整带来了舍入误差。然后,由于这些误差通常小于l0,这是可以接受的近似。

图5.两个连续比例级别(9 * 9和15 * 15)的Dyy(顶部)和Dxy(底部)过滤器。 暗瓣的长度只能增加偶数个像素,以保证中央像素(顶部)的存在。

尺度空间的构建从9x9滤波器开始,计算图像的斑块响应,作为最小尺度层。然后,滤波器增至15x15,21x21,和27x27,尺度变化了两倍多。但这是必须的,因为3D非最大化抑制不仅要在本空间内,还要在临尺度内进行。因此,第一和最后一层Hessian响应图本身并不能包含最大值,他们只是用来同其他层做比较的。所以,如3.4节所述,插之后可能的最小尺度是σ=1.6=1.2*(12/9),对应的滤波器大小是12x12,最大到σ=3.2=1.2*(24/9)。更多细节我们参考了[2]

其他组也类似。对每个新组,滤波器大小增倍(从6-12到24-48)。同时,每个新组提取兴趣点的采样间隔加倍。相对于传统下采样方法,这将减少计算量和精确度损失。第二组的滤波器大小是15,27,39,51,第三组是27,51,75,99,如果原始图片还大于对应滤波器,尺度空间还需要第四组分析,滤波器大小为51,99,147,195。图6前三组滤波器大小的总图。之后的组可用同样的方法计算。然而在典型的尺度分析中,每组检测到的兴趣点会急速减少,见图.7。

图6.三个不同八度音阶的滤波器边长的图形表示。 对数水平轴表示比例。 请注意,八度是重叠的,以便无缝覆盖所有可能的音阶。

图7.检测到的鳞片的直方图。每个八度音阶检测到的兴趣点数量迅速衰减。

较大的尺度变化,特别是每组的第一个滤波器(从9到15,1.7倍),提供的尺度采样相当粗糙。因此,我们同样实现了一种较好的尺度采样的尺度空间。在放大两倍的图像的积分图上计算,第一组的第一个滤波器大小为15,之后的大小是21,27,33,39。第二组开始,滤波器大小按12递增。第三和第四组按同样方法。如此,第一个滤波器变化率就是1.4(21/15)。这种精确版本的,可用二次插值检测的最小尺度是s = (1.2*(18/9))/2 = 1.2。

因为任何尺度滤波器的F范数都是常数,因此本身就是尺度标准化的,不需要再对滤波响应加权,更多信息参见[22]。

3.4 兴趣点定位

为了在图像及不同尺度中定位兴趣点,我们用了3x3x3邻域非最大化抑制。具体的,我们用了Neubeck and Van Gool方法[33]的快速变种。Hessian矩阵行列式的最大值在尺度和图像空间被插值,依据Brown et al.[5]提出的方法。

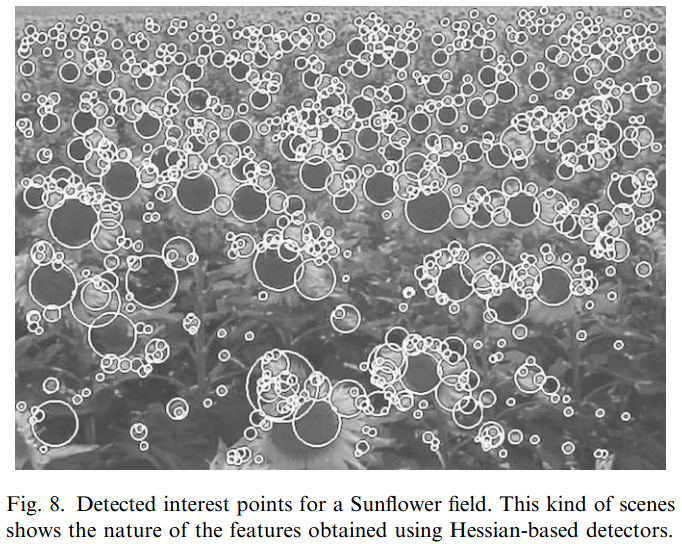

尺度空间在我们的方法中尤其重要,因为每组第一个滤波器的尺度差异比较大。图.8显示了用我们的快速Hessian检测子检测到的兴趣点。

图8.太阳能场的检测兴趣点。这种场景显示了使用基于Hessian的探测器获得的特征的性质。

4.兴趣点描述和匹配

我们的描述子描述了在兴趣点附近分布的强度内容,类似于SIFT及其变种的梯度信息[24]。我们基于x和y方向的一阶哈里斯小波响应的分布,而非梯度,分布数据为64维。这减少了特征计算和匹配的时间,同时也增强了鲁棒性。此外,基于Laplacian的符号,我们提出了新的索引步骤,这不仅提高了描述子的鲁棒性,还提高了匹配速度(最高2倍)。我们称之为SURF—Speeded-Up Robust Features。

第一步是基于兴趣点周围的圆形区域,确定一个可重现的方位。然后构建一个与其同向的方形区域,在其中提取SURF描述子。最后,在两个图片间匹配。这三步具体如下。

4.1 确定方向

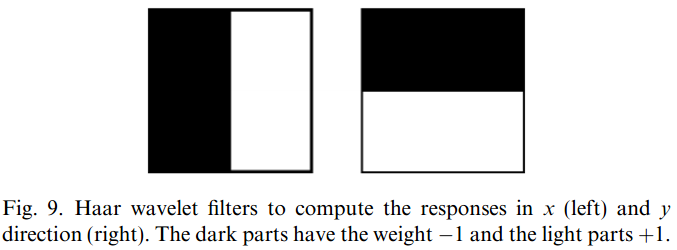

为了做到对图像旋转不变,需要对兴趣点确定一个可重现的方向。为此,我们在兴趣点半径6s的圆形邻域内计算x和y方向的Haar小波响应,s是兴趣点所在的尺度。采样步长也不依赖于尺度,选为s。为了与其他的保持一致,小波大小也不依赖于尺度,边长定位4s。因此,我们还可以用积分图做快速滤波。图.9显示了所用滤波器。任意尺度只需要六步计算就能得到x或者y方向的响应。

图9. Haar小波滤波器,计算x(左)和y方向(右)的响应。 深色部分的权重为1,浅色部分为+1。

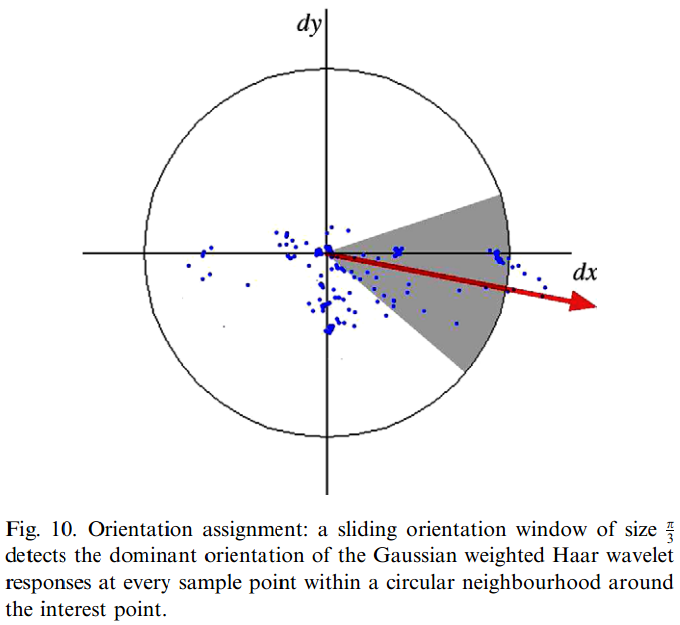

一旦小波响应计算好以后,用中心位于兴趣点的σ=2s的高斯滤波器加权,响应值用二维空间中的点表示,横坐标表示水平响应,纵坐标表示垂直响应。主方向通过在大小为π/3的滑动窗口内计算响应和来估计,如图.10。窗口内的水平和垂直响应被相加,两个和输出一个方向向量,所有窗口中的最长向量定义了兴趣点的方向。滑动窗口的大小需要小心选择,过小的窗口只能找到一个主导梯度,过大的窗口只能输出一个毫无意义的最大值。两种结果都是不正确的方向。

图10.方向分配:大小为Π/3的滑动方向窗口检测在兴趣点周围的圆形邻域内的每个采样点处的高斯加权Haar小波响应的主导方向。

在许多应用中,方位不变性并不是必须的。在参考文献[3,4]中的实验使用了垂直版本的SURF(简称U-SURF)来检测目标,U-SURF计算更快,也更有鉴别力,并且在±15°内有可靠性。

4.2 基于Haar小波响应和的描述子

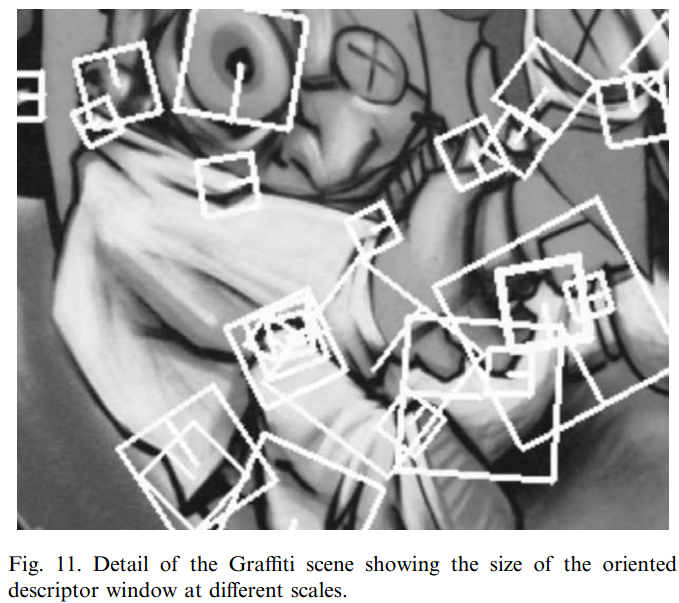

描述子提取的第一步,是构建一个方形区域,中心在兴趣点,方位沿着上节中选出的方向,窗的大小是20s。如图.11。

图11.涂鸦场景的细节,显示了不同比例的定向描述符窗口的大小。

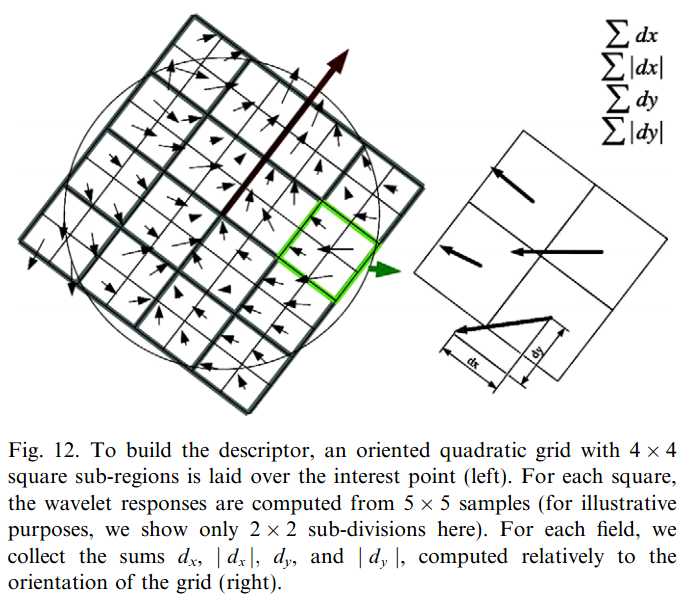

这个区域又被整齐的划分为4x4的子区域,其中包含了重要的空间信息。对每个子区域,我们计算5x5等间距采样点的小波响应。简单期间,我们称水平方向的Haar小波响应为dx,垂直方向的为dy(滤波器大小为2s),再次参见图9。这里的水平和垂直是相对于兴趣点的方向,见图.121。为了提高对几何畸变和定位误差的鲁棒性,响应值dx和dy首先经过了中心点在兴趣点的σ=3.3s的高斯加权。

1由于效率原因,在未旋转的图像中计算Haar小波,然后对响应进行插值,而不是实际旋转图像。

图12.为了建立描述符,将一个带有4 * 4正方形子区域的定向二次网格放在兴趣点上(左)。 对于每个平方,小波响应是从5 * 5个样本中计算出来的(出于说明目的,此处仅显示2 * 2个细分)。 对于每个字段,我们收集总和dx,| dx | ,dy和| dy |相对于网格的方向(右)进行计算。

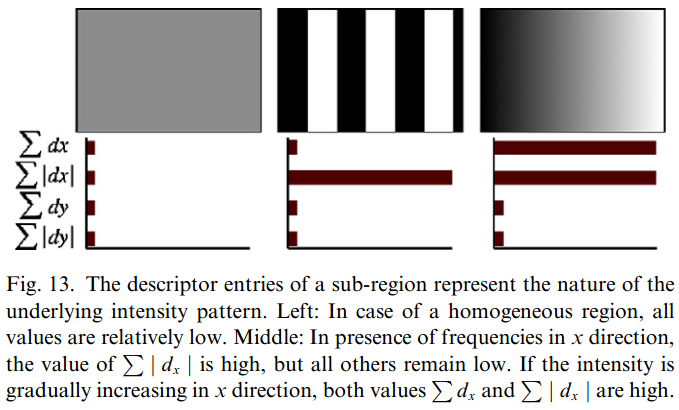

然后,每个子区域的小波响应dx和dy相加,构成了特征向量的第一组条目。为了引入强度变化的极性信息,我们同时提取出了响应绝对值|dx|和|dy|的和。由此,每个子区域有了4维的强度结构描述向量v = (Σdx, Σdy, Σ|dx|, Σ|dy|)。如此继续计算所有4x4子区域,结果就是64维的描述向量。这里的小波响应对亮度便宜不变。把描述子变成单位矢量,就也是对对比度不变(尺度不变的一种)。

图.13显示了三种图像强度明显不同的子区域的描述子属性。可以预想,这种局部强度模式的结合,可以产生有鉴别力的描述子。

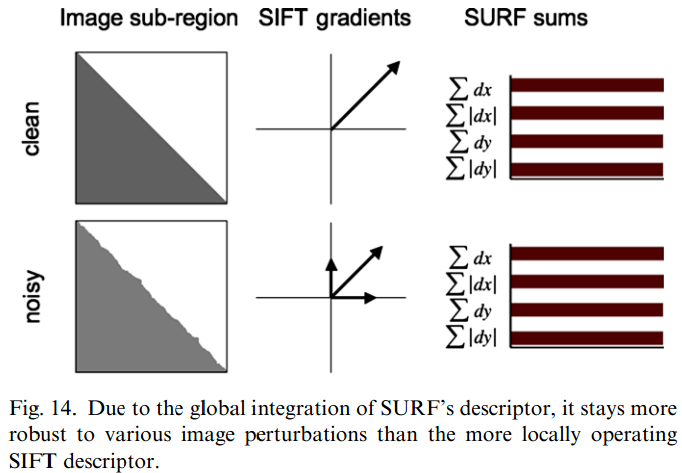

SURF在某些点上很接近SIFT,例如关注于场强信息的空间分布。然而第五节显示了,SURF全面超过了SIFT。我们相信这是因为SURF整合了子图像的梯度信息,而SIFT是依靠单独梯度的方向。这使得SURF对噪声较不敏感,如图.14中的例子所示。

图13:左:在均匀区域的情况下,所有值都相对较低。中:在x方向存在频率时,Σ  的值很高,但所有其他值都保持低。如果强度沿x方向逐渐增加,则值Σ dx和Σ |dx| 都很高。

的值很高,但所有其他值都保持低。如果强度沿x方向逐渐增加,则值Σ dx和Σ |dx| 都很高。

图14.由于SURF描述符的全局集成,它对于各种图像扰动比对更本地操作的SIFT描述符更加鲁棒。

为了得到现在的SURF描述子,我们实验了较多和较少的小波特征点,二阶导,高阶小波,PCA,中值,均值,等等。通过全面的评估,得到了效果最好的一组。之后我们改变了采样点和子区域数目,发现4x4的子区域分割方案是最好的,见第五节。不过到过细的子区域鲁棒性较差,并且匹配时间增加太多。另一方面,使用3x3子区域得到的短描述子(SURF-36)表现稍差,但是匹配很快,相对于文中其他描述子来说还是可以接受的。

我们还测试了另外一种版本的SURF描述子,将一对特征相加(SURF-128)。还是用之前的加法,但是数据划分的更细。对于dy<0和dy>0,分别计算dx和|dx|的和,dy和|dy|也一样根据dx的符号划分,因此特征的数量就增倍。这样的描述子鉴别力跟强,计算也并不特别慢,但是因为维度高,匹配会较慢。

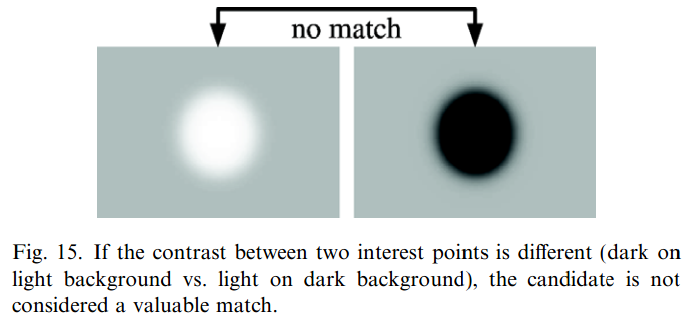

4.3 快速索引匹配

匹配阶段的快速索引使用了潜在兴趣点的Laplacian算子(即Hessian矩阵的迹)。典型的兴趣点是斑块状的,Laplacian算子的符号可以区分出黑背景亮斑块与其相反情形。因为Laplacian算子在检测阶段已经计算出来,这里使用并不增加额外计算量。在匹配阶段,我们只比较有相同黑白对比的特征点,如图.15。因此,这点小信息使得快速匹配称为可能,而且不减弱描述子性能。注意这对更高级的索引方法也是有利的。例如k-d树,相对于随机选取一个元素或者使用特征统计参数,这个额外的信息为数据分割定义了一个有意义的超平面。

图15:如果两个兴趣点之间的对比度不同(浅色背景上的暗对比暗背景上的亮度),则候选者不被认为是有价值的匹配。

5.结果

以下结果既包含仿真数据,也包含实际测试结果。首先我们评估了一些参数的影响,在标准测试集上展示了我们的描述子和检测子。然后我们描述了两个可能的应用。对于同其他检测子和描述子的详细对比,我们参考文献[4]。SURF已经在一些实际应用中测试过。文献[3]中已经展示了SURF在目标识别中的应用。Cattin et al.[7]用SURF做人类视网膜图像拼接,这一任务没有其他检测子或描述子能做。更进一步,对于图像配准,本文关注于稍难一些的摄像头校准和3D重建,还有款基线应用。SURF能在一些困难的应用中精确可靠的校准摄像头。最后,我们介绍了SURF在目标识别中的应用。

5.1 实验评估与参数设置

我们使用Mikolajczyk2提供的视频序列和测试软件,评估标准是可重复性得分。

2 http://www.robots.ox.ac.uk/vgg/research/affine/

测试序列包括图片,纹理和结构化场景。序列包含很多几何和光学变换,例如视点变换,缩放旋转,图像模糊,亮度变换和JPEG压缩。

本文所有实验的时间,是在奔腾四3.0GHz标准PC上运行测得的。

5.1.1 SURF检测子

我们测试了自己的快速Hessian检测子,根据初始高斯导数滤波器大小,FH-9代表我们的快速Hessian检测子初始滤波器大小为9x9,FH-15是15x15滤波器用于第二次的图片输入。除此之外,本节的所有实验使用相同的阈值和参数。

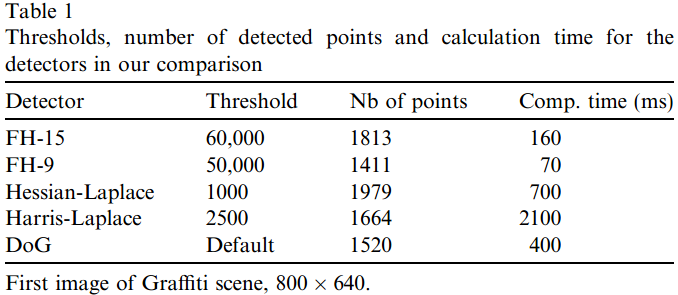

表格1

比较中的阈值,检测点数和检测器的计算时间

表.1

检测子与Lowe的DoG检测子[24]和Mikolajczyk的Harris-Laplace、Hessian-Laplace检测子[29]对比,检测到的兴趣点平均数目非常相似(见表1)。阈值根据DoG检测子检测到的兴趣点调整。

FH-9检测子比DoG快五倍以上,比Hessian-Laplace快十倍以上。FH-15检测子比DoG快三倍以上,比Hessian-Laplace快四倍以上(同见表1)。同时,我们的检测子的可重复性与其他相当甚至更好。

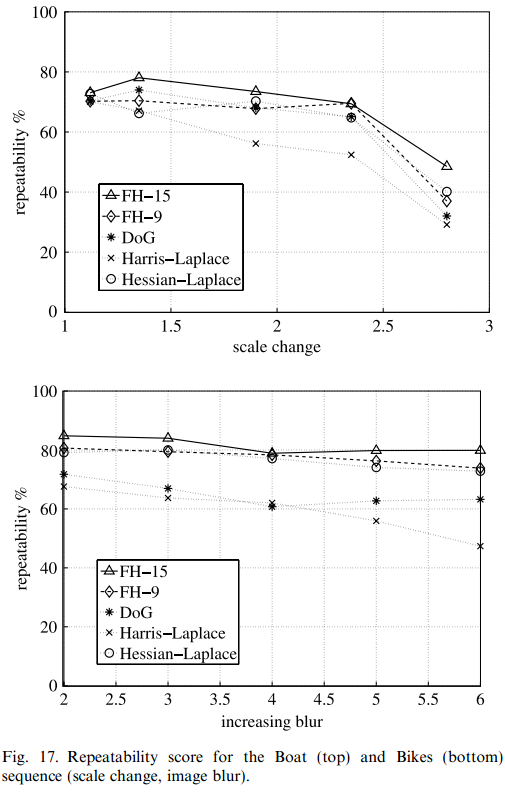

所有检测子在Graffiti序列上的可重复性得分(图.16上部)大致相当。FH-15在Wall序列上的可重复性得分(图.16下部)优于其他检测子。Graffiti和Wall序列都包含平面外旋转,这会导致放射畸变,然而所有检测子都只对图片旋转和尺度不变。因此,这种畸变应被视为总体稳健性的一个特征。在Boat序列中(图.17上部),FH- 15也显得比其他好。FH-9和FH- 15在Bikes序列中(图.17下部)都比其他好。我们的检测子的优势和精准度会在5.2和5.3节中继续阐述。

图16. Graffiti(上)和Wall(下)序列的重复性评分(视点变化)。 图17:船(顶部)和自行车(底部)序列的重复性得分(比例变化,图像模糊)。

5.1.2 SURF描述子

本节我们关注SURF中两个影响查全率和查准率的参数。

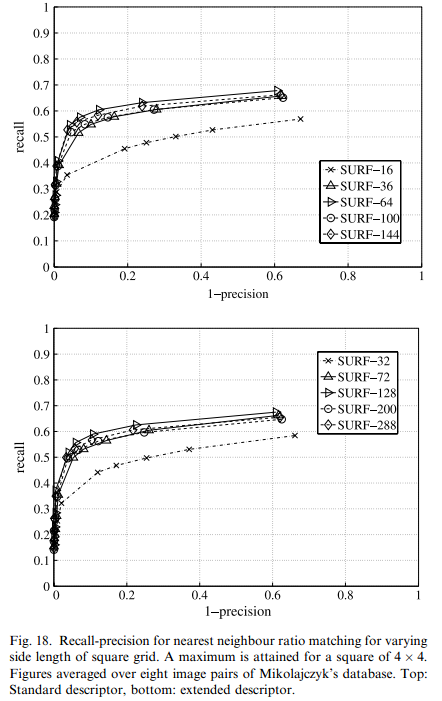

首先,图.12中方形网格的数量,以及描述子的大小,是影响匹配速度的两个主要因素。其次,我们将考虑之前提到过的扩展的描述子。图.18显示了不同尺度方形网格的查准率和查全率,其中包括标准描述子和扩展描述子。只有分割数目是变化的,总方向大小不变。SURF-36意味3x3网格,SURF-72是它对应的扩展。同样,SURF-100是5x5,SURF-144是6x6,SURF-200和SURF-288是他们的扩展。为了在不同图像上(我们在每个测试集取一对图像)得到均值,我们使用比例匹配方案[24]。

4x4方形在所有测试中的查准率和查全率都明显优于其他。然而,3x3也是不错的选择,特别当匹配速度比较重要时。进一步分析,我们发现扩展描述子查全率较差,但是查准率好。总之,扩展描述子作用有限。

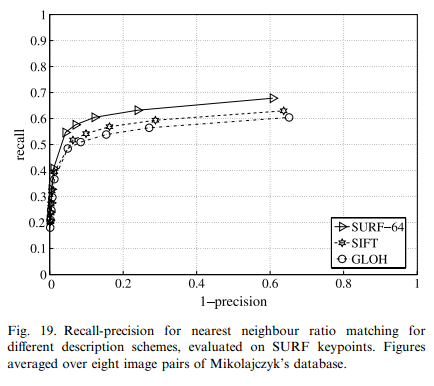

描述子的更多测试参见文献[4]。在这里,我们只比较两个优秀的描述方案(SIFT[24]和GLOH[30]),同样是使用平均值(图19)。SURF-64最终胜出。

SURF的另一个优势是计算快。1529个兴趣点的检测和描述只用了610ms,它的改进版本U-SURF只用了400ms。(第一个涂鸦图;奔腾4,3GHz)

图18:方格变化边长的最近邻比匹配的查全精度 最大值为4 * 4的平方。 数字平均超过Mikolajczyk数据库的八对图像。 顶部:标准描述符,底部:扩展描述符。

图19.在SURF关键点上评估的不同描述方案的最近邻比匹配的召回精度。数据平均超过了Mikolajczyk数据库的八个图像对。

5.2 3D中的应用

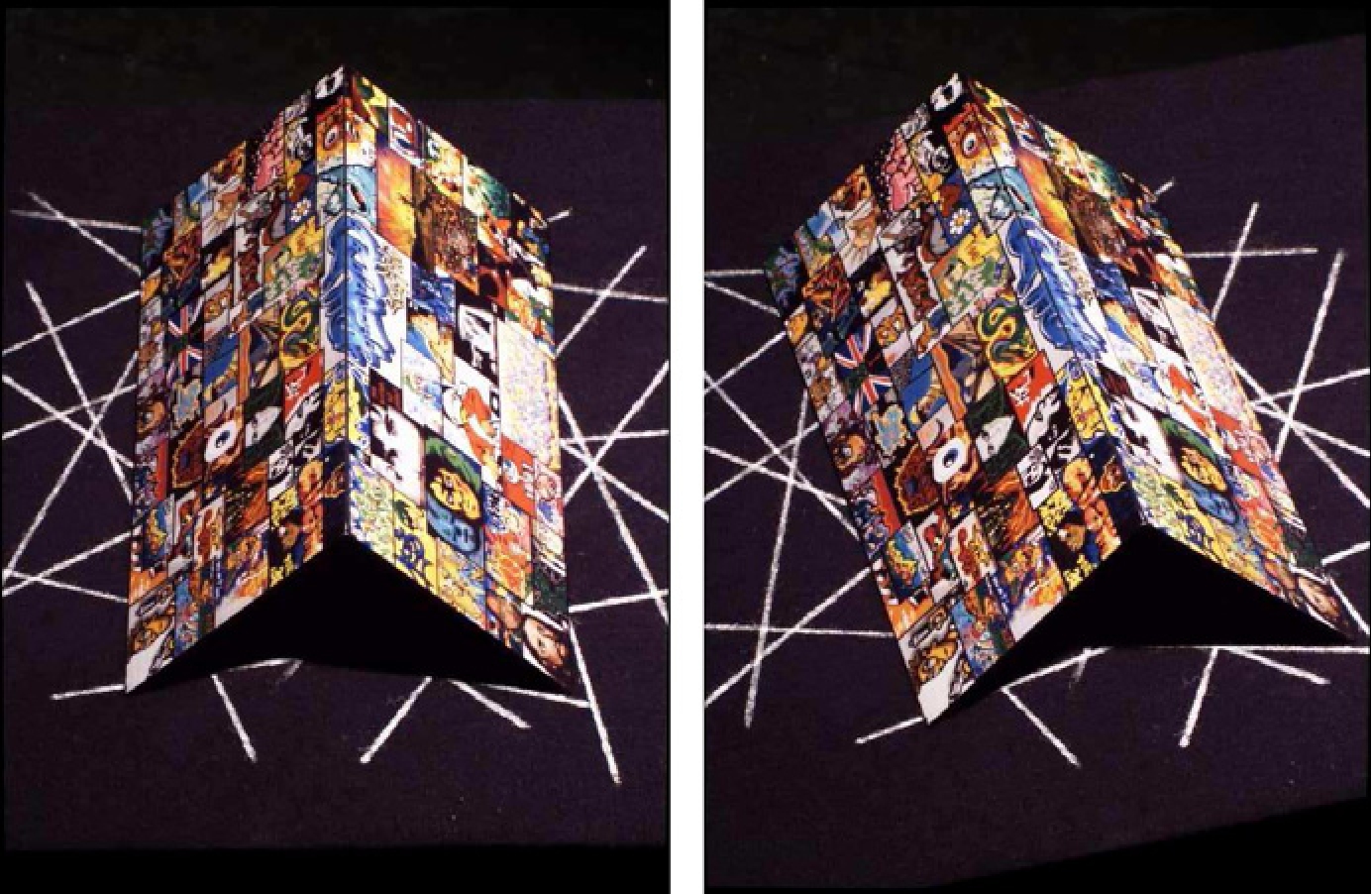

本节我们将评估Fast-Hessian检测子在摄像头自校准和3D重建中的精度。第一个评估在双视角中与两个最新的检测子分别对比。一个已知的场景被用来提供定量结果。第二次评估使用N维摄像头自校准和密集3D多视角重建,这需要在宽基线情况下进行。

5.2.1 双视角例子

为了评估不同兴趣点检测方案在摄像头校准和3D重建中的表现,我们创建了一个控制环境。这样一个测试场景包含两个高度纹理化的平面,组成一个合适的角度(本例测得为88.6°),见图.20。图片大小为800x600,主点和宽高比未知。因为正确匹配点的数目对于精度很重要,所以我们调整了兴趣点检测子参数,使得在匹配后,留下800个正确的匹配(匹配点不属于过滤掉的角度)。匹配阶段是用SURF-128,两个平面的定位使用RAN-SAC以及正交回归。评估标准是两个平面的角度,以及使用不同兴趣点描述子重建后的3D点与各自平面的平均距离和不一致性。

图20.定量检测器评估的输入图像。这对于不同类型的兴趣点检测器的比较来说是一个很好的场景选择,因为它的组件是简单的几何元素。

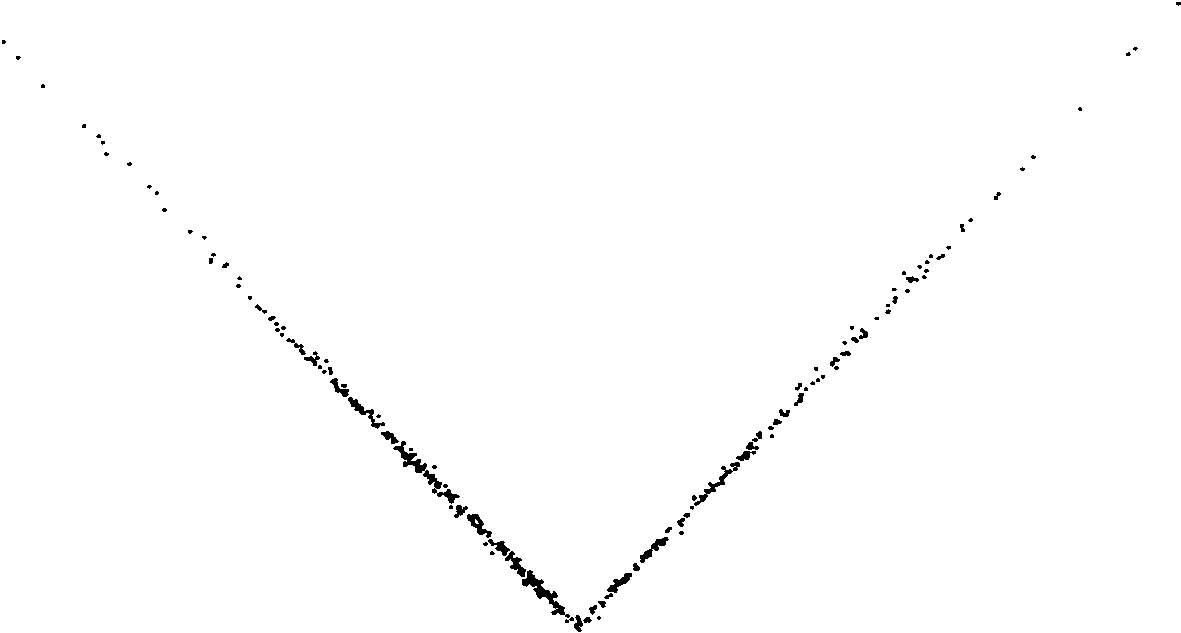

图21.图20中所示的重构角度的正交投影。

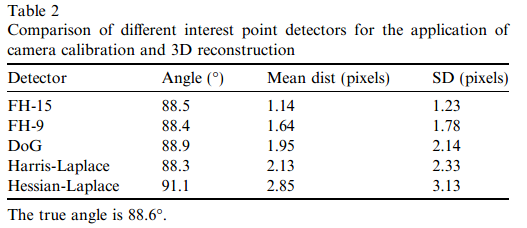

表2显示了我们两个版本的Fast-Hessian检测器(FH-9和FH-15),SIFT的DoG功能[24]以及Mikolajczyk和Schmid [[Hessian]和Harris-Laplace检测器[ 29]。 FH-15检测器明显优于竞争对手。

图21显示了重构角度的Fast-Hessian(FH-15)特征的正交投影。 有趣的是,像Harris和Hessian-Laplace探测器这样在理论上更完善的方法的性能要比近似值(DoG和SURF特征)差。

表2

相机校准和3D重建应用中不同兴趣点检测器的比较

表.2

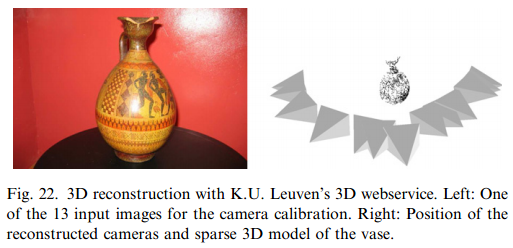

5.2.2 多视角例子

SURF检测和描述算法已经被在K.U. Leuven的VISICS研究组集成于Epoch 3D网络服务3。这个网络服务允许用户上传一系列静止图像,然后服务器仅根据这些图像就能自动校准摄像头,计算出密集深度图[40]。在摄像头校准阶段,每幅图像的特征点需要被计算和匹配。这一步中SURF算法的应用提高了多数图片集的结果,尤其是图片之间距离较远时。之前利用Harris交点和图像窗口归一化互相关的算法不能处理这类图像。另外,DoG检测子加上SIFT描述子的方法不能处理部分图像序列,然而SURF能精确处理所有序列。

3:http://home.esat.kuleuven.be/~visit3d/webservice/html.

对于图22中的示例,传统方法只能校准总共13个摄像机中的6个。 但是,使用SURF可以校准所有13台摄像机。 即使在稀疏的3D模型中,花瓶也很容易辨认。

图22.用K.U.进行3D重建 鲁汶的3D网络服务。 左:用于相机校准的13个输入图像之一。 右:重建摄像机的位置和花瓶的稀疏3D模型。

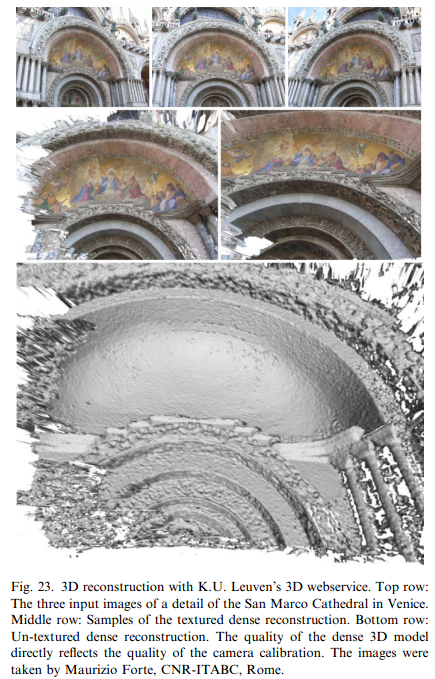

图.23展示了典型的宽基线问题:三幅图取自不同的,分布较远的视点。这是一个很有挑战性的例子,因为三幅图像代表了能精确密集3D重建需要的最小图片数量。得到的3D模型见图23下部。通常,在这种质量的密集重建模型下,图像校准的质量会很好。这些实验证明了SURF检测子和描述子在图像配准,摄像机标定,3D重建等对精度要求极高的应用中的作用。

图23.使用K.U.进行3D重建鲁汶的3D网络服务。顶行:威尼斯圣马可大教堂细节的三个输入图像。中间行:纹理密集重建的样本。底行:无纹理密集重建。密集3D模型的质量直接反映了相机校准的质量。这些照片是由罗马CNR-ITABC的Maurizio Forte拍摄的。

5.3 目标识别中的应用

Bay et al.[3]已经证明了SURF在单目标检测中的实用性。为了进一步展示SURF检测子在这种场景中的质量,我们进行了跟多实验。实验的基础是两个可公开获得的词袋分类器[10]4。给定一副图像,其任务是找出目标在图像中是否存在。在我们的比较中,根据Dance et al.[8]的建议,我们使用基于词袋表示的原始贝叶斯分类器。选择简单的分类器是因为复杂分类器例如pLSA可能会抹去描述子的作用。类似文献[10],我们分别在 加利福尼亚理工学院背景和飞机图像集5上测试400个图片。50%图像用作训练,另外50%用来测试。为了减小分组的影响,所有检测子使用同样的随机的训练和测试序列。这是一个相对简单的测试集,所以能明确的体现不同描述子之间对比的目的。

4:http://people.csail.mit.edu/fergus/iccv2005/bagwords.html.

5:http://www.vision.caltech.edu/html-files/archive.html.

测试框架已经提供了兴趣点检测、随机选择Canny角点用于密集采样,然后提供给各种描述子。此外,我们也考虑了使用SURF关键点,取自非常低的阈值,来确保高覆盖度。

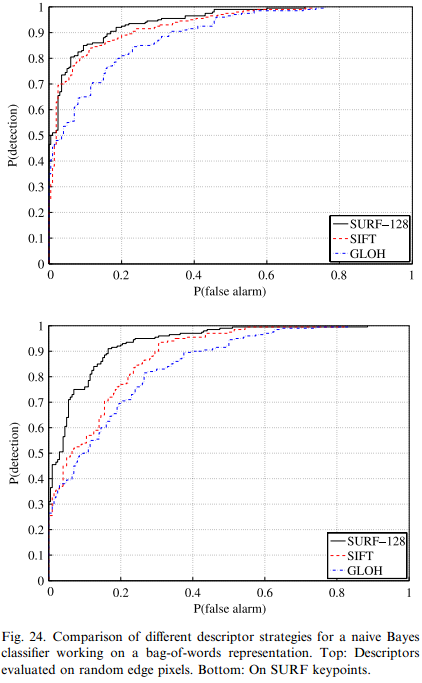

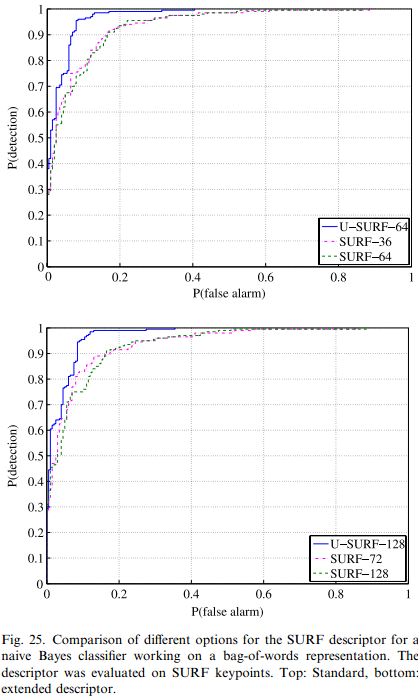

图.24显示了得到的SURF-128,SIFT和GLOH的ROC曲线。在计算SURF是,描述子中Laplacian算子的符号被去掉了。在两种兴趣点对比中,SURF-128的曲线明显的较好。图.25研究了指数大小的影响和扩展SURF描述子。SURF-64和SURF-128的垂直版本都要比原来的好。这是正常的,因为数据库中的图片都是用垂直视角拍摄的。其他算法稍微差些,但是可以对比出来。即时SURF-36也具有一些鉴别度,对于这种方案的描述子的质量,我们还进行了更多的实验。

同样的实验在Caltech摩托车(侧面)和人脸数据库中进行,输出了相似的结果。

总之,实验证明SURF在分类任务中工作良好,在测试集中比其他算法效果更好,同时速度快。这些积极的结果以为着SURF应该能适用于目标检测,目标识别和图像检索。

图24。比较一个朴素贝叶斯分类器的不同描述符策略,用于词袋表示。上:描述随机边缘像素的描述符。底部:关于SURF关键点。

图25.对于用于词袋表示的朴素贝叶斯分类器的SURF描述符的不同选项的比较。在SURF关键点上评估描述符。上:标准,底部:扩展描述符。

6 总结与展望

我们提出了一种快速并且表现良好的尺度和旋转不变兴趣点检测子和描述子。速度的提高主要是因为积分图的使用,极大的减少了简单矩形的计算步骤,并且与矩形大小无关。结果证明,我们的Hessian近似法与其他最新算法相当,很多时候还要比其他兴趣点检测法好。它的高可重复性用于摄像头自校准很有利,这种应用中,精确的兴趣点检测对摄像头自校准有直接影响,因而最后影响3D重建模型的质量。

然而最重要的改进还是在速度。即时不需要专门的优化,在不降低性能的前提下也几乎能做到实时计算,这对需要实时计算任务有重要意义。

我们的基于Haar小波响应和的描述子比最新的方法要好。对图像灰度的描述似乎比基于直方图的描述更有鉴别度。简化以及积分图的使用使得我们的描述子在速度方面更快。此外,基于Laplacian的索引阶段使得匹配阶段更快,并且性能。

在摄像头校准和目标识别中的实验突出了SURF在更广泛的计算机视觉领域的潜力。前一部分说明,兴趣点的精确度和描述子的鉴别度是得到较为精确的3D重建的主要因素,即时能够得到3D重建也是一件苦难的事。后一部分显示,这种描述子可以成功推广到单目标识别任务中,并且比其他方法更好。

最新的SURF算法已提供公共下载6:6:http://www.vision.ee.ethz.ch/~surf/

致谢

作者非常感谢丰田汽车欧洲公司和丰田汽车公司,瑞士SNF NCCR项目IM2以及佛兰德斯科学研究基金会的支持。Geert Willems用于识别描述符中使用的插值中的错误。 Stefan Saur将SURF移植到Windows。 Maarten Vergauwen为我们提供3D重建。 Bastian Leibe博士进行了许多鼓舞人心的讨论。 DoG探测器由David Lowe友情提供。

参考文献

[1] A. Baumberg, Reliable feature matching across widely separated views, in: CVPR, 2000, pp. 774–781.

[2] H. Bay, From Wide-baseline Point and Line Correspondences to 3D, Ph.D. Thesis, ETH Zurich, 2006.

[3] H. Bay, B. Fasel, L. van Gool, Interactive museum guide: fast and robust recognition of museum objects, in: Proceedings of the First International Workshop on Mobile Vision, May 2006.

[4] H. Bay, T. Tuytelaars, L. Van Gool, SURF: speeded up robust features, in: ECCV, 2006.

[5] M. Brown, D. Lowe, Invariant features from interest point groups, in: BMVC, 2002.

[6] G. Carneiro, A.D. Jepson, Multi-scale phase-based local features, in: CVPR, issue 1, 2003, pp. 736–743.

[7] P.C. Cattin, H. Bay, L.J. Van Gool, G. Sze´kely, Retina mosaicing using local features. MICCAI (2) October 2006, 185–192.

[8] C. Dance, J. Willamowski, L. Fan, C. Bray, G. Csurka, Visual categorization with bags of keypoints, in: ECCV International Workshop on Statistical Learning in Computer Vision, Prague, 2004.

[9] M. Datar, N. Immorlica, P. Indyk, V.S. Mirrokni, Locality-sensitive hashing scheme based on p-stable distributions, in: Symposium on Computational Geometry, 2004, pp. 253–262.

[10] R. Fergus, P. Perona, A. Zisserman, Object class recognition by unsupervised scale-invariant learning, in: CVPR, issue 2, 2003, pp. 264–271.

[11] L.M.J. Florack, B.M. ter Haar Romeny, J.J. Koenderink, M.A. Viergever, General intensity transformations and differential invariants, JMIV 4 (2) (1994) 171–187.

[12] W.T. Freeman, E.H. Adelson, The design and use of steerable filters, PAMI 13 (9) (1991) 891–906.

[13] J. Goldstein, J.C. Platt, C.J.C. Burges, Redundant bit vectors for quickly searching high-dimensional regions, in: Deterministic and Statistical Methods in Machine Learning, 2004, pp. 137–158.

[14] M. Grabner, H. Grabner, H. Bischof, Fast approximated SIFT, in: ACCV, issue 1, 2006, pp. 918–927.

[15] C. Harris, M. Stephens, A combined corner and edge detector, in: Proceedings of the Alvey Vision Conference, 1988, pp. 147–151.

[16] F. Jurie, C. Schmid, Scale-invariant shape features for recognition of object categories, in: CVPR, vol. II, 2004, pp. 90–96.

[17] T. Kadir, M. Brady, Scale, saliency and image description, IJCV 45 (2) (2001) 83–105.

[18] Y. Ke, R. Sukthankar, PCA-SIFT: a more distinctive representation for local image descriptors, in: CVPR, issue 2, 2004, pp. 506–513.

[19] J.J. Koenderink, The structure of images, Biological Cybernetics 50 (1984) 363–370.

[20] T. Lindeberg, Scale-space for discrete signals, PAMI 12 (3) (1990) 234–254.

[21] T. Lindeberg, Feature detection with automatic scale selection, IJCV 30 (2) (1998) 79–116.

[22] T. Lindeberg, L. Bretzner, Real-time scale selection in hybrid multiscale representations, in: Scale-Space, 2003, pp. 148–163.

[23] D. Lowe, Object recognition from local scale-invariant features, in: ICCV, 1999.

[24] D. Lowe, Distinctive image features from scale-invariant keypoints, IJCV 60 (2) (2004) 91–110.

[25] J. Matas, O. Chum, M. Urban, T. Pajdla, Robust wide baseline stereo from maximally stable extremal regions, in: BMVC, 2002, pp. 384–393.

[26] K. Mikolajczyk, C. Schmid, Indexing based on scale invariant interest points, in: ICCV, vol. 1, 2001, pp. 525–531.

[27] K. Mikolajczyk, C. Schmid, An affine invariant interest point detector, in: ECCV, 2002, pp. 128–142.

[28] K. Mikolajczyk, C. Schmid, A performance evaluation of local descriptors, in: CVPR, vol. 2, June 2003, pp. 257–263.

[29] K. Mikolajczyk, C. Schmid, Scale and affine invariant interest point detectors, IJCV 60 (1) (2004) 63–86.

[30] K. Mikolajczyk, C. Schmid, A performance evaluation of local descriptors, PAMI 27 (10) (2005) 1615–1630.

[31] K. Mikolajczyk, T. Tuytelaars, C. Schmid, A. Zisserman, J. Matas, F. Schaffalitzky, T. Kadir, L. Van Gool, A comparison of affine region detectors, IJCV 65 (1/2) (2005) 43–72.

[32] F. Mindru, T. Tuytelaars, L. Van Gool, T. Moons, Moment invariants for recognition under changing viewpoint and illumination, CVIU 94 (1–3) (2004) 3–27.

[33] A. Neubeck, L. Van Gool, Efficient non-maximum suppression, in: ICPR, 2006.

[34] D. Niste´r, H. Stewe´nius, Scalable recognition with a vocabulary tree, in: CVPR, issue 2, 2006, pp. 2161–2168.

[35] S.M. Omohundro, Five balltree construction algorithms, Technical Report, ICSI Technical Report TR-89-063, 1989.

[37] S. Se, H.K. Ng, P. Jasiobedzki, T.J. Moyung, Vision based modeling and localization for planetary exploration rovers, in: Proceedings of International Astronautical Congress, 2004.

[38] P. Simard, L. Bottou, P. Haffner, Y. LeCun, Boxlets: a fast convolution algorithm for signal processing and neural networks, in: NIPS, 1998.

[39] T. Tuytelaars, L. Van Gool, Wide baseline stereo based on local, affinely invariant regions, in: BMVC, 2000, pp. 412–422.

[40] M. Vergauwen, L. Van Gool, Web-based 3d reconstruction service, Mach. Vis. Appl. 17 (6) (2006) 411–426.

[41] P.A. Viola, M.J. Jones, Rapid object detection using a boosted cascade of simple features, in: CVPR, issue 1, 2001, pp. 511–518.

Computer Vision_33_SIFT:Speeded-Up Robust Features (SURF)——2006的更多相关文章

- Computer Vision_33_SIFT:Distinctive Image Features from Scale-Invariant Keypoints——2004

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

- Computer Vision_33_SIFT:Object recognition from local scale-invariant features——1999

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

- Computer Vision_33_SIFT:ORB_An efficient alternative to SIFT or SURF——2012

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

- Computer Vision_33_SIFT:Robust scale-invariant feature matching for remote sensing image registration——2009

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

- Computer Vision_33_SIFT:TILDE: A Temporally Invariant Learned DEtector——2014

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

- Computer Vision_33_SIFT:SAR-SIFT: A SIFT-LIKE ALGORITHM FOR SAR IMAGES——2015

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

- Computer Vision_33_SIFT:An efficient SIFT-based mode-seeking algorithm for sub-pixel registration of remotely sensed images——2015

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

- Computer Vision_33_SIFT:PCA-SIFT A More Distinctive Representation for Local Image Descriptors——2004

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

- Computer Vision_33_SIFT: A novel point-matching algorithm based on fast sample consensus for image registration——2015

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

随机推荐

- spring redistemplate中setHashValueSerializer的设置

笔者曾经对redis键值使用了不同类型的序列化方法 用过默认值.JdkSerializationRedisSerializer.StringRedisSerializer还用改以下自定类型的序列化工具 ...

- iOS-UITextField的使用

UITextField UITextField * accountField = [[UITextField alloc] initWithFrame:CGRectMake(85.0f, 60.0f ...

- 解决访问github等网站慢或下载失败的问题

最近老大push项目,正常的git clone每次都是下载一部分就断掉了.下面介绍网上找到的两种方法: 方法一: 1.打开网站https://www.ipaddress.com/: 2.分别在上面打开 ...

- Qt598x64vs2017.Kit(构建套件)(安装Qt598x86vs2015)

1.Qt598-->工具-->选项 1.1. 1.2. 2.20191120 想起 上面第一张图的配置编译器的地方,就想着 Qt598x64vs2017 配置成编译x86,于是将 上面图中 ...

- SQL语句 常用记录

1,求平均,保留2位小数: ,)) as avg from {$table}; // amount为数据库某个字段 2,条件累加 , p1, )) AS cnt1 ; // 如果符合 cnt > ...

- 前端入门系列之CSS

CSS (Cascading Style Sheets) 是用来样式化和排版你的网页的 —— 例如更改网页内容的字体.颜色.大小和间距,将内容分割成多列或者加入动画以及别的装饰型效果. CSS是什么 ...

- Eureka如何剔除已经宕机的节点

同一个服务部署了多个实例,在通过网关调用时会随机调用其中一个.但是,当某个服务挂掉之后,依然在注册中心中,依然会随机被调用到,调用时便会超时报错.(主要是开发测试或者演示时需要立即将失效的从注册中心剔 ...

- Jmeter进行接口流程测试

Jmeter进行简单的流程测试 此次完成的流程:添加文章-删除文章 总的如下: 一.测试计划 用户定义的变量中,我定义了3个变量: 二.HTTP cookie管理器 填写要添加的cookie 三.JD ...

- TypeScript 类型推导及类型兼容性

类型推导就是在没有明确指出类型的地方,TypeScript编译器会自己去推测出当前变量的类型. 例如下面的例子: let a = 1; 我们并没有明确指明a的类型,所以编译器通过结果反向推断变量a的类 ...

- S03_CH07_AXI_VDMA_OV5640摄像头采集系统

S03_CH07_AXI_VDMA_OV5640摄像头采集系统 7.1概述 本章内容和<S03_CH06_AXI_VDMA_OV7725摄像头采集系统>只是摄像头采用的分辨率不同,其他原理 ...