kafka Windows安装

1:安装JDK、

2:安装Zookeeper

下载地址:https://zookeeper.apache.org/releases.html

下载后,解压放在目录D:\bigdata(本文所用的目录)下,关于zookeeper以及kafka的目录,路径中最好不要出现空格,比如D:\Program Files,尽量别用,运行脚本时会有问题。

①进入zookeeper的相关设置所在的文件目录,例如本文的:D:\bigdata\zookeeper-3.4.10\conf

②将"zoo_sample.cfg"重命名为"zoo.cfg"

③打开zoo.cfg(至于使用什么编辑器,根据自己喜好选即可),找到并编辑:

dataDir=/tmp/zookeeper to D:/bigdata/zookeeper-3.4.10/data或 D:\\bigdata\\zookeeper-3.4.10\\data(路径仅为示例,具体可根据需要配置)

这里注意,路径要么是"/"分割,要么是转义字符"\\",这样会生成正确的路径(层级,子目录)。

④与配置jre类似,在系统环境变量中添加:

a.系统变量中添加ZOOKEEPER_HOME=D:\bigdata\zookeeper-3.4.10

b.编辑系统变量中的path变量,增加%ZOOKEEPER_HOME%\bin

⑤在zoo.cfg文件中修改默认的Zookeeper端口(默认端口2181)

这是本文最终的zoo.cfg文件的内容:

- # The number of milliseconds of each tick

- tickTime=2000

- # The number of ticks that the initial

- # synchronization phase can take

- initLimit=10

- # The number of ticks that can pass between

- # sending a request and getting an acknowledgement

- syncLimit=5

- # the directory where the snapshot is stored.

- # do not use /tmp for storage, /tmp here is just

- # example sakes.

- dataDir=D:/bigdata/zookeeper-3.4.10/data

- #dataDir=D:\\bigdata\\zookeeper-3.4.10\\data

- # the port at which the clients will connect

- clientPort=2181

- # the maximum number of client connections.

- # increase this if you need to handle more clients

- #maxClientCnxns=60

- #

- # Be sure to read the maintenance section of the

- # administrator guide before turning on autopurge.

- #

- # http://zookeeper.apache.org/doc/current/zookeeperAdmin.html#sc_maintenance

- #

- # The number of snapshots to retain in dataDir

- #autopurge.snapRetainCount=3

- # Purge task interval in hours

- # Set to "0" to disable auto purge feature

- #autopurge.purgeInterval=1

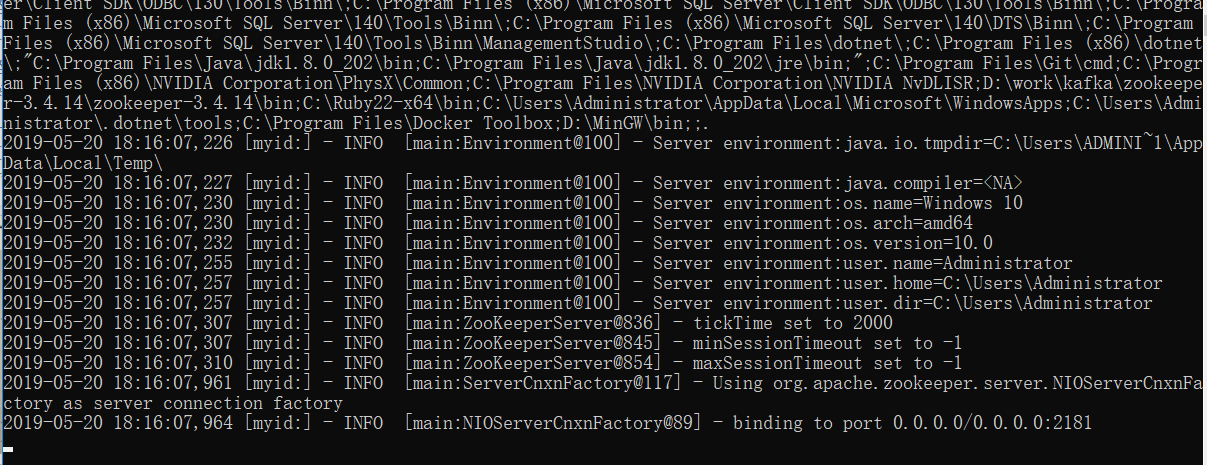

⑥打开cmd窗口,输入zkserver,运行Zookeeper,运行结果如下:

Zookeeper已经安装完成,已在2181端口运行。

3 安装kafka

下载地址:http://kafka.apache.org/downloads

要下载Binary downloads这个类型,不要下载源文件,这种方便使用。下载后,解压放在D:\bigdata目录下。

①进入kafka配置文件所在目录,D:\bigdata\kafka_2.11-0.9.0.1\config

②编辑文件"server.properties",找到并编辑:

log.dirs=/tmp/kafka-logs to log.dirs=D:/bigdata/kafka_2.11-0.9.0.1/kafka-logs 或者 D:\\bigdata\\kafka_2.11-0.9.0.1\\kafka-logs

同样注意:路径要么是"/"分割,要么是转义字符"\\",这样会生成正确的路径(层级,子目录)。错误路径情况可自行尝试,文件夹名为这种形式:bigdatakafka_2.11-0.9.0.1kafka-logs

③在server.properties文件中,zookeeper.connect=localhost:2181代表kafka所连接的zookeeper所在的服务器IP以及端口,可根据需要更改。本文在同一台机器上使用,故不用修改。

④启动kafka:

在命令行中输入:.\bin\windows\kafka-server-start.bat .\config\server.properties 回车。

kafka会按照默认配置,在9092端口上运行,并连接zookeeper的默认端口2181。

3 增加kafka用户

(1)

# 添加下面的配置 ip和端口改成自己需要

listeners=SASL_PLAINTEXT://xx.xx.xx.xx:8123

security.inter.broker.protocol=SASL_PLAINTEXT

sasl.enabled.mechanisms=PLAIN

sasl.mechanism.inter.broker.protocol=PLAIN

(2)

在config目录添加kafka_server_jaas.conf 文件 此文件是服务端 设置用户名 和密码

KafkaServer {

org.apache.kafka.common.security.plain.PlainLoginModule required

username="kafka"

password="kafkapswd"

user_kafka="kafkapswd"

user_mooc="moocpswd";

};

其中 Kafka 定义了关键字KafkaServer字段用于指定服务端登录配置。该配置通过org.apache.

org.apache.kafka.common.security.plain.PlainLoginModule由指定采用PLAIN 机制, 定义了两个用户, 用户通

过usemame 和password 指定该代理与集群其他代理初始化连接的用户名和密码, 通过“ user_ "

为前缀后接用户名方式创建连接代理的用户名和密码,例如, user_mooc = "moocpswd” 是指

用户名为mooc, 密码为moocpswd

(3)

在config目录添加kafka_client_jaas.conf

KafkaClient {

org.apache.kafka.common.security.plain.PlainLoginModule required

username="mooc"

password="moocpswd";

};

(4)

修改目录/usr/local/kafka_2.12-1.1.1/bin 下的 kafka-server-start.sh文件 。 我的做法也是复制出来一份 ,然后进行修改

kafka-server-start-saal.sh 添加以下文件

if [ "x$KAFKA_OPTS" ]; then

export KAFKA_OPTS="-Djava.security.auth.login.config=/usr/local/kafka_2.12-1.1.1/config/kafka_server_jaas.conf"

fi

(5)

修改目录/usr/local/kafka_2.12-1.1.1/bin 下的 kafka-console-producer.sh 和 kafka-console-consumer.sh 文件

也是 都各自复制一份 在复制上面进行修改

if [ "x$KAFKA_OPTS" ]; then

export KAFKA_OPTS="-Djava.security.auth.login.config=/usr/local/kafka_2.12-1.1.1/config/kafka_client_jaas.conf"

fi

kafka Windows安装的更多相关文章

- kafka windows安装 命令行下使用测试

1.zookeeper安装: (https://zookeeper.apache.org/releases.html) ①进入zookeeper的相关设置所在的文件目录,例如本文的:D:\bigd ...

- [转]Windows 安装Kafka

来源:https://www.cnblogs.com/liuyuhua/p/5329926.html https://www.cnblogs.com/xinlingyoulan/p/6054361.h ...

- 20190312 Windows安装Kafka

1. 下载 使用版本2.1.1 官网下载地址 2. 安装 2.1. 前提 已安装ZooKeeper,可参考 20190311 Windows安装ZooKeeper 进行安装ZooKeeper 2.2. ...

- Kafka在Windows安装运行

摘要:本文主要说明了如何在Windows安装运行Kafka 一.安装JDK 过程比较简单,这里不做说明. 最后打开cmd输入如下内容,表示安装成功 二.安装zooeleeper 下载安装包:http: ...

- Kafka的安装与使用(转)

9.1 Kafka 基础知识 9.1.1 消息系统 点对点消息系统:生产者发送一条消息到queue,一个queue可以有很多消费者,但是一个消息只能被一个消费者接受,当没有消费者可用时,这个消息会被保 ...

- windows安装ActiveMQ以及点对点以及发布订阅

一.MQ产品的分类 1.RabbitMQ 是使用Erlang编写的一个开源的消息队列,本身支持很多的协议:AMQP,XMPP, SMTP, STOMP,也正是如此,使的它变的非常重量级,更适合于企业级 ...

- Mysql(windows)安装

h3 { color: rgb(255, 255, 255); background-color: rgb(30,144,255); padding: 3px; margin: 10px 0px } ...

- Windows 安装JRuby 生成 war 到 tomcat 运行

Windows安装JRuby Rails 直接下载 JRuby,不装 Ruby. http://jruby.org/download 该安装包可以配好环境变量 %JRUBY_HOME% 等 安装 bu ...

- windows安装rabbitmq

官网下载windows安装版本:http://www.rabbitmq.com/install-windows.html ,安装文件rabbitmq-server-3.6.5.exe 前提:安装erl ...

随机推荐

- 笔记 前端的$dom操作

jqueryDOM操作 1. 页面加载 函数 $( function(){ 具体内容 } ); 表示页面加载函数 2 dom 类操作 text() - 设置或返回所选元素的文 ...

- BLE各版本新功能总结

文章转载自:http://www.sunyouqun.com/2017/04/ 协议发布时间 协议版本 2016/12 Bluetooth 5 2014/12 Bluetooth 4.2 2013/1 ...

- 【javascript】[].slice.call(arguments)的作用

var thisExtends = function () { var args = [].slice.call(arguments).filter(function (item) { return ...

- IO框架:asyncio 上篇

如何定义/创建协程 只要在一个函数前面加上 async 关键字,这个函数对象是一个协程,通过isinstance函数,它确实是Coroutine类型. from collections.abc imp ...

- php类知识---try catch

<?php try { echo "比赛开始"."\n"; ); } catch (Exception $e ) { echo "获取错误信息: ...

- beeline启动时,错误 User: root is not allowed to impersonate root

错误: beeline>!connect jdbc:hive2://192.168.33.01:10000 root rootConnecting to jdbc:hive2://192.168 ...

- POJ-2752-Seek the Name(KMP, 循环节)

链接: https://vjudge.net/problem/POJ-2752#author=0 题意: 给定若干只含小写字母的字符串(这些字符串总长≤400000),在每个字符串中求出所有既是前缀又 ...

- centos 6.5 解压 zip

只查看 zip 文件内容而不解压 unzip -l filename.zip 解压到指定目录(不指定则为当前目录) unzip filename.zip -d /usr/file 压缩文件或目录为 z ...

- 提示 ToolTip

<StackPanel> <Button Content="按钮1" ToolTip="这是个按钮1" HorizontalAlignment ...

- vue学习时遇到的问题(二)

1. this.$nextTick veu中进行数据改变后,并不会马上刷新视图:用nextTick可告诉执行下个函数后马上刷新视图: this.$nextTick(function(){ // ...