Spark(三)角色和搭建

Spark(三)角色和搭建

一、Spark集群角色介绍

详见JerryLead/SparkInternals,他的图解介绍能清晰的讲清楚Spark集群

二、集群的搭建

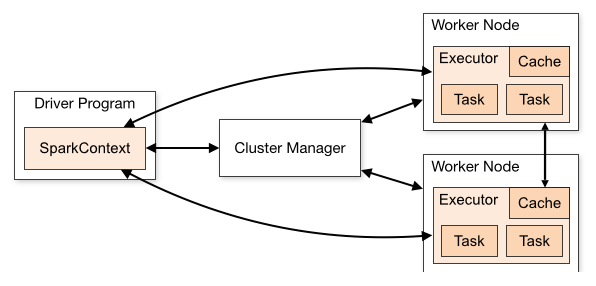

2.1.架构(图片来源,Spark官网)

一个Driver Program含有一个SparkContext,课由ClusterManager进行通讯到Worker节点,每个Application都有自己的Executor,与其他程序完全隔离

2.2.Spark-2.3.4 standlone搭建

1.获取

wget http://mirrors.tuna.tsinghua.edu.cn/apache/spark/spark-2.3.4/spark-2.3.4-bin-hadoop2.7.tgz

2.解压

tar -xf spark-2.3.4-bin-hadoop2.7.tgz

3.移动到/opt/bigdata中

mv spark-2.3.4-bin-hadoop2.7.tgz /opt/bigdata

4.修改环境变量SPARK_HOME

这步省略(如果不知道如何修改环境变量,参考我的Hadoop Ha搭建文章)

5.进入SPARK_HOME/bin/spark-shell,我们进入一个scala交互环境

这边可以测试wc代码,默认sparkContext自动为sc,所以wc代码如下

sc.textFile("/root/data.txt").flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).foreach(println);

2.3.Spark集群搭建

1.修改conf/spark-env.sh

export HADOOP_CONF_DIR=/opt/bigdata/hadoop-2.6.5

为了找到我们之前配置好的hadoop集群

export SPARK_MASTER_HOST=node01

export SPARK_MASTER_PORT=7077

export SPARK_MASTER_WEBUI_PORT=8080

export SPARK_WORKER_CORES=2

export SPARK_WORKER_MEMORY=1g

2.修改slaves

node02

node03

node04

拷贝这两个配置到其他三个节点

3.spark-shell集群式启动

start-all.sh

spark-shell --master spark://node01:7077

进入scala的交互环境,运行一下wc

sc.textFile("hdfs://mycluster/sparktest/data.txt").flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).foreach(println)

发现没有输入,因为在分区上输出了,所以我们需要一个回收算子

sc.textFile("hdfs://mycluster/sparktest/data.txt").flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).collect().foreach(println)

2.3.Spark高可用处理

1.spark-defaults.conf修改

这边的配置可以向zookeeper上面进行注册发现

spark.deploy.recoveryMode ZOOKEEPER

spark.deploy.zookeeper.url node02:2181,node03:2181,node04:2181

spark.deploy.zookeeper.dir /littlepagespark

2.启动流程

./spark-shell --master spark://node01:7077,node02:7077

提示:node02的master需要自行启动,所以我们需要更改node02的conf/env文件

三、history服务

1.配置spark-defaults.conf

spark.eventLog.enabled true

spark.eventLog.dir hdfs://mycluster/shared/spark-logs

spark.history.fs.logDirectory hdfs://mycluster/spark_log

手动开启历史服务./start-history-server.sh

之后访问node01:18080端口即可

四、使用spark-submit进行计算Pi

代码参照官网

/*

* Licensed to the Apache Software Foundation (ASF) under one or more

* contributor license agreements. See the NOTICE file distributed with

* this work for additional information regarding copyright ownership.

* The ASF licenses this file to You under the Apache License, Version 2.0

* (the "License"); you may not use this file except in compliance with

* the License. You may obtain a copy of the License at

*

* http://www.apache.org/licenses/LICENSE-2.0

*

* Unless required by applicable law or agreed to in writing, software

* distributed under the License is distributed on an "AS IS" BASIS,

* WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

* See the License for the specific language governing permissions and

* limitations under the License.

*/

// scalastyle:off println

package org.apache.spark.examples

import scala.math.random

import org.apache.spark.sql.SparkSession

/** Computes an approximation to pi */

object SparkPi {

def main(args: Array[String]): Unit = {

val spark = SparkSession

.builder

.appName("Spark Pi")

.getOrCreate()//创建一个spark pi

//如果参数大于0,则返回切片数量为args,否则返回2

val slices = if (args.length > 0) args(0).toInt else 2

//n为切片乘100000L和Int最大值的最大,转为Int,避免溢出

val n = math.min(100000L * slices, Int.MaxValue).toInt // avoid overflow

//计算随机数,是否落到圆上

val count = spark.sparkContext.parallelize(1 until n, slices).map { i =>

val x = random * 2 - 1

val y = random * 2 - 1

if (x*x + y*y <= 1) 1 else 0

}.reduce(_ + _)

//打印

println(s"Pi is roughly ${4.0 * count / (n - 1)}")

spark.stop()

}

}

// scalastyle:on println

使用Spark-submit运行

spark-submit --master spark://node01:7077,node02:7077 --class org.apache.spark.examples.SparkPi ./spark-examples_2.11-2.3.4.jar 1000

spark-submit --master url --class [package.class] [jar] [args]

spark-submit参数

--deploy-mode cluster #部署模式,默认cluster

--driver-memory 1024m #driver内存

--total-executor-cores 6 #总共6核心

--executor-cores 1 #每个executor1个核

--executor-memory 1024m #executor内存1024m

五、Spark On Yarn

在hadoop-env.sh仅需要配置export hadoop_conf_dir的目录即可,worker和master均不需要,slaves也不需要了,zk的配置也不需要了

1.hadoop-env.sh修改

export HADOOP_CONF_DIR=/opt/bigdata/hadoop-2.6.5/etc/hadoop

2.spark-defaults.conf修改

spark.eventLog.enabled true

spark.eventLog.dir hdfs://namenode/shared/spark-logs

spark.history.fs.logDirectory hdfs://mycluster/spark_log

3.yarn-site.xml

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>4096</value>

</property>

<property>

<name>yarn.nodemanager.resource.cpu-vcores</name>

<value>4</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

4.mapred-site.xml

mr-jobhistory-daemon.sh start historyserver

<property>

<name>mapred.job.history.server.embedded</name>

<value>true</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>node03:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node03:50060</value>

</property>

<property>

<name>mapreduce.jobhistory.intermediate-done-dir</name>

<value>/work/mr_history_tmp</value>

</property>

<property>

<name>mapreduce.jobhistory.done-dir</name>

<value>/work/mr-history_done</value>

</property>

启动历史服务

mr-jobhistory-daemon.sh start historyserver

启动spark-yarn

./spark-shell --master yarn

六、shell脚本

class=org.apache.spark.examples.SparkPi

jar=$SPARK_HOME/examples/jars/spark-examples_2.11-2.3.4.jar

master=yarn

$SPARK_HOME/bin/spark-submit \

--master $master \

--class $class \

--deploy-mode cluster \

$jar \

100

七、调优

spark-defaults.conf增加配置

spark.yarn.jars hdfs://mycluster/work/spark_lib/jars/*

把spark jars目录完全上传

hdfs dfs -put ./* /work/spark_lib/jars/

其余调优详见四的参数

Spark(三)角色和搭建的更多相关文章

- 大数据学习day18----第三阶段spark01--------0.前言(分布式运算框架的核心思想,MR与Spark的比较,spark可以怎么运行,spark提交到spark集群的方式)1. spark(standalone模式)的安装 2. Spark各个角色的功能 3.SparkShell的使用,spark编程入门(wordcount案例)

0.前言 0.1 分布式运算框架的核心思想(此处以MR运行在yarn上为例) 提交job时,resourcemanager(图中写成了master)会根据数据的量以及工作的复杂度,解析工作量,从而 ...

- 一文读懂spark yarn集群搭建

文是超简单的spark yarn配置教程: yarn是hadoop的一个子项目,目的是用于管理分布式计算资源,在yarn上面搭建spark集群需要配置好hadoop和spark.我在搭建集群的时候有3 ...

- Hadoop+Spark:集群环境搭建

环境准备: 在虚拟机下,大家三台Linux ubuntu 14.04 server x64 系统(下载地址:http://releases.ubuntu.com/14.04.2/ubuntu-14.0 ...

- spark JAVA 开发环境搭建及远程调试

spark JAVA 开发环境搭建及远程调试 以后要在项目中使用Spark 用户昵称文本做一下聚类分析,找出一些违规的昵称信息.以前折腾过Hadoop,于是看了下Spark官网的文档以及 github ...

- 【运维技术】redis(一主两从三哨兵模式搭建)记录

redis(一主两从三哨兵模式搭建)记录 目的: 让看看这篇文章的的人能够知道:软件架构.软件的安装.配置.基本运维的操作.高可用测试.也包含我自己,能够节省对应的时间. 软件架构: 生产环境使用三台 ...

- Spark+IDEA单机版环境搭建+IDEA快捷键

1. IDEA中配置Spark运行环境 请参考博文:http://www.cnblogs.com/jackchen-Net/p/6867838.html 3.1.Project Struct查看项目的 ...

- 04、Spark Standalone集群搭建

04.Spark Standalone集群搭建 4.1 集群概述 独立模式是Spark集群模式之一,需要在多台节点上安装spark软件包,并分别启动master节点和worker节点.master节点 ...

- Spark 集群环境搭建

思路: ①先在主机s0上安装Scala和Spark,然后复制到其它两台主机s1.s2 ②分别配置三台主机环境变量,并使用source命令使之立即生效 主机映射信息如下: 192.168.32.100 ...

- Spark—local模式环境搭建

Spark--local模式环境搭建 一.Spark运行模式介绍 1.本地模式(loca模式):spark单机运行,一般用户测试和开发使用 2.Standalone模式:构建一个主从结构(Master ...

随机推荐

- Navicat安装及使用

一.安装Navicat 1.下载安装文件:navicat11.0.17_premium_cs_x86.exe(32位) 2.Oracle 的 Instance Client:instantclient ...

- (一)MVC项目

一.整体架构: 注:取自其他文章,最后的NewFile.html纯用于测试错误,完全不用. 二.具体代码: 1.User.java package common; public class User ...

- 三节课MINI计划第三周

第一部分 微信读书的产品分析 一.任务背景 二.做什么 三.TASK8 业务流程图 四.TASK9 五.周会 六.周报

- 说一说Unsafe魔法类

这篇算是对 Unsafe 的一个总体概况,由于内容实在太多,后续会分开几篇文章对里面内容展开细讲 前言 Unsafe可以说是java的后门,类似西游记中的如来佛祖法力无边,Unsafe主要提供一些用于 ...

- hdoj3336(kmp算法next数组的应用)

题目链接:https://vjudge.net/problem/HDU-3336 题意:给定长为n(<=2e5)的字符串s,求s的每个前缀在s中出现的次数之和. 思路: 用dp[i]表示以s[i ...

- Selenium问题集锦

此文章用于记录使用Selenium遇见的问题~ 问题1:sendkeys直接报错如下: 解决方案:selenium 驱动和Chrome浏览器的版本必须对应,不然会报此错.驱动地址:点此跳转 下载前先看 ...

- Ubuntu16.04 换源(或者404 Not Found问题)

当执行sudo apt-get update或者sudo apt-get install命令时,出现以下两个问题: “apt-get 404 Not Found Package Repository ...

- (转)从0移植uboot(三) _编译最小可用uboot

ref: https://www.cnblogs.com/xiaojiang1025/p/6436752.html 前两篇介绍了uboot-2013.01的配置原理以及大体的运行流程,本文将讨论如何对 ...

- react中jsx文件是如何转换成js对象的

通过在线babel转换器,转换出jsx是如何变成js对象的 jsx文件 加入了正常的标签以及嵌套标签以及方法属性 function hello() { click=()=>{ console.l ...

- (六)springmvc之ModelAndView、Model、Map、ModelMap

<a href="<%=request.getContextPath()%>/responseData/response_1">使用原生的作用域</a ...