Solr7使用Oracle数据源导入+中文分词

安装目录假设为#solr_home,本文的#solr_home为apps/svr/solr

一、Oracle数据导入

1. 在#solr_home/server/solr下新建文件夹,假设为mjd;

2. 将#solr_home/server/solr/configsets/_default下的conf文件夹拷贝到#solr_home/server/solr/mjd;

3.打开mjd/conf下的solrconfig.xml添加节点;

<lib dir="${solr.install.dir:../../../..}/contrib/dataimporthandler/" regex=".*\.jar">

<lib dir="${solr.install.dir:../../../..}/dist/" regex="solr-dataimporthandler-.*\.jar">

4. 同样上面那个文件,增加节点;

<requestHandler name="/dataimport" class="org.apche.solr.handler.dataimport.DataImportHandler">

<lst name="defaults">

<str name="config">data-config.xml</str>

</list>

</requestHandler>

5. 下载ojdbc6.jar到#solr_home/contrib/dataimporthandler/中,我是在http://vdisk.weibo.com/s/z8ZZMoqsgpNFH中下载的;

6. 在#solr_home/server/solr/mjd/conf下新建文件data-config.xml,打开,将下列配置复制;

<dataConfig>

<dataSource driver="oracle.jdbc.driver.OracleDriver" url="jdbc:oracle:thin:@192.168.2.218:1521:product " user="数据库用户名" password="数据库密码" />

<document name=”product” pk=”主键”>

<entity name="bless" query="select * from bless"<--这里配查询语句-->

deltaImportQuery="SELECT * FROM userinfo where spuid='${dih.delta.spuid}'"

deltaQuery="select bless_id from bless where bless_time > '${dataimporter.last_index_time}'"><--这里配增量查询语句,${dataimporter.last_index_time}表示上次更新时间-->

</entity>

</document>

</dataConfig>

7. 进入web管理页面 localhost:8983/solr/#,点击Core Admin菜单,点击AddCore,将name和instanceDir设置为刚才我们第一步新建的文件夹名称;

8. 在菜Thread Dump下方有一个下拉框,选择刚新建的Core,点击Schema 里的Add field菜单,name输入刚才配置的查询语句中的某个字段(假设该字段为字符串类型),点击field type,选择text_gerneral,点击下面的添加按钮;

9. 回到左侧菜单,选择Dataimport,点击Execute菜单;

10. 回到左侧菜单,选择Query,点击Execute Query,如果右侧查询出数据,恭喜你,你已经配置好了;

可根据第八步继续添加自己想要的字段,重复9 10步骤;

二、中文分词

Solr7之前好像大部分使用的是IK中文分词器,但是我试了好几个方法,都没有成功,而且跟网上经验描述的目录结构也很多不一样,比如大部分说要修改Schema.xml文件,可是后来发现Solr7其实已经不使用Schema了,而是使用的Managed-Schema文件,

而且这里有个问题就是,当重启Solr服务器后,项目中的这个文件会被覆盖掉,目前还没有找到是从哪里拷贝过来的模板。进入正题:

1. 进入#solr_home/contrib/analysis-extras/lucene-libs,找到lucene-analyzers-smartcn-7.0.1.jar,复制到#solr_home/server/solr-webapp/webapp/WEB-INF/lib下;

2. 打开#solr_home/server/solr/configsets/_default/conf下的managed-schema,在文件后面加上如下节点

<!-- ChineseAnalyzer -->

<fieldType name="text_cn_splitting" class="solr.TextField" positionIncrementGap="100">

<analyzer type="index">

<tokenizer class="org.apache.lucene.analysis.cn.smart.HMMChineseTokenizerFactory"/>

</analyzer>

<analyzer type="query">

<tokenizer class="org.apache.lucene.analysis.cn.smart.HMMChineseTokenizerFactory"/>

</analyzer>

</fieldType>

3.重启solr服务;

4.在第一部分第8步的时候,Add Field的时候,看是否有text_cn_splitting类型可选,如果有的话,那在add field的时候将需要进行中文分词的字段选择该类型即可;

定时任务:

使用系统的定时任务执行 curl

http://your_ip/dataimport?command=full-import&clean=true&commit=true 全量导入

http://your_ip/dataimport?command=delta-import&clean=false&commit=true 差异导入

这里clean参数如果是true,会把之前的数据清空掉,然后导入差异的数据,在差异性导入时注意这个参数,不然会把solr里的数据清空,然后导入差异性的数据(这个差异是清空前的差异),导致数据缺失;

建议访问低频时重建全量索引,如每天凌晨4点做一次全量导入,每10分钟做一次差异导入

FQA:

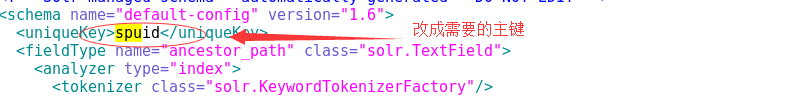

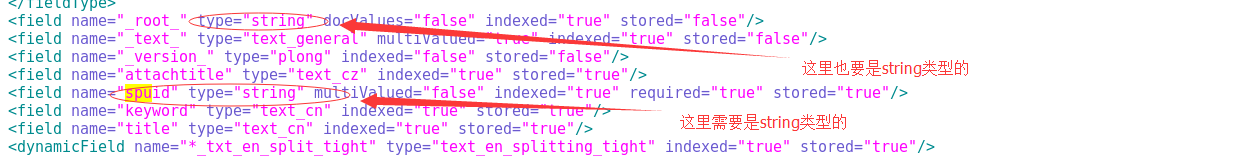

1.增量导入是以主键作为增量差异,默认这个主键是id,需要在managed-schema里修改uniqueKey节点成需要的主键,且在该文件里定义的主键必须是string类型的,如下图

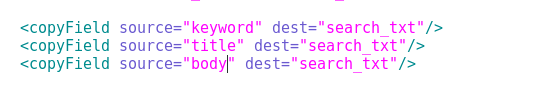

2. 如果需要设置单字段索引,而不每个字段都去检索,比如有数据字段author,title,keywords,body,搜索的时候想搜索这四个字段,可以使用copyField字段,具体方法,在managed-schema中添加如下节点

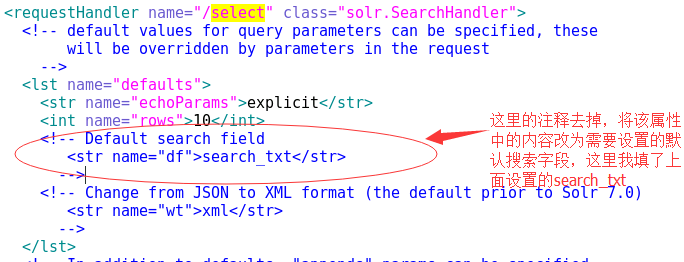

3. Solr7中已经不再支持defaultSearchField默认搜索字段了。需要设置默认搜索字段需要在solrconfig.xml中配置,

参考资料:

https://www.cnblogs.com/LUA123/p/7783102.html

http://archive.apache.org/dist/lucene/solr/ref-guide/apache-solr-ref-guide-7.0.pdf

https://wiki.apache.org/solr/DataImportHandler

本文原创,转载请注明出处。

Solr7使用Oracle数据源导入+中文分词的更多相关文章

- solr7.2安装实例,中文分词器

一.安装实例 1.创建实例目录 [root@node004]# mkdir -p /usr/local/solr/home/jonychen 2.复制实例相关配置文件 [root@node004]# ...

- Solr7.1---数据库导入并建立中文分词器

这里只是告诉你如何导入,生产环境不要这样部署你的solr服务. 首先修改solrConfig.xml文件 备份_default文件夹 修改solrconfig.xml 加入如下内容 官方示例:< ...

- solr7.4创建core,导入MySQL数据,中文分词

#solr版本:7.4.0 一.新建Core 进入安装目录下得server/solr/,创建一个文件夹,如:new_core 拷贝server/solr/configsets/_default/con ...

- solr7中文分词包

刚刚将solr4升级到了solr7.7,发现之前用的mmseg4j中文分词包用的时候会报错,插入新数据是创建索引会有异常 possible analysis error: startOffset mu ...

- Oracle导入中文乱码解决办法

Oracle导入中文乱码解决办法 一.确保各个客户端字符集的编码同服务器字符集编码一致 1- 确定sqlplus字符集编码,如果是windows设置环境变量. 2- 确保Sec ...

- Solr7.2.1环境搭建和配置ik中文分词器

solr7.2.1环境搭建和配置ik中文分词器 安装环境:Jdk 1.8. windows 10 安装包准备: solr 各种版本集合下载:http://archive.apache.org/dist ...

- Solr7.3.0入门教程,部署Solr到Tomcat,配置Solr中文分词器

solr 基本介绍 Apache Solr (读音: SOLer) 是一个开源的搜索服务器.Solr 使用 Java 语言开发,主要基于 HTTP 和 Apache Lucene 实现.Apache ...

- php+中文分词scws+sphinx+mysql打造千万级数据全文搜索

转载自:http://blog.csdn.net/nuli888/article/details/51892776 Sphinx是由俄罗斯人Andrew Aksyonoff开发的一个全文检索引擎.意图 ...

- Sphinx+MySQL5.1x+SphinxSE+mmseg中文分词

什么是Sphinx Sphinx 是一个全文检索引擎,一般而言,Sphinx是一个独立的搜索引擎,意图为其它应用提供快速.低空间占用.高结果相关度的全文搜索功能.Sphinx能够很easy的与SQL数 ...

随机推荐

- hbase建表

import java.util.ArrayList; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.hb ...

- Android 开发笔记___基本适配器的使用__BaseAdapter

之前用到过ArryAdapter适用于纯文本的列表数据,SimpleAdapter适用于带图标的列表数据,但在实际应用中常常有更复杂的列表,比如同一项中存在多个控件,这时候用前面的两个会比较复杂,而且 ...

- Android 开发笔记___SQLite__基本用法

SQLiteOpenHelper package com.example.alimjan.hello_world.dataBase; import android.content.ContentVal ...

- linux 安装 Elasticsearch5.6.x 详细步骤以及问题解决方案

在网上有很多那种ES步骤和问题的解决 方案的,不过没有一个详细的整合,和问题的梳理:我就想着闲暇之余,来记录一下自己安装的过程以及碰到的问题和心得:有什么不对的和问题希望及时拍砖. 第一步:环境 li ...

- python添加自定义cookies

import cookielib,urllib2 class AddCookieHandler(urllib2.BaseHandler): def __init__(self,cookieValue) ...

- 转:ef获取某个表中的部分字段值

我有个新闻表 id,title,body,createtime,author,click 使用ef4.1 仅仅读取 id,title,createtime 并显示在页面上. public static ...

- css-子div设置margin-top影响父div

父元素的第一个子元素的上边距margin-top如果碰不到有效的border或者padding.就会不断一层一层的找自己父元素,祖先元素,所有需要在父元素设置border,或者padding

- C#里调用 MysqlDB

最近在做项目,发现在使用Mysql提供给C#操作的类不是和好用,就想办法写了一个操作方便的Mysql数据层类. 比如以前在执 行一个查询 代码 ...

- .net core 开发短网址平台的思路

最近有个客户要求开发一套短网址网站,小编现在都使用.net core进行网站开发了,以是厘厘思路,想想使用.net core 的中间件应该很容易实现. 1. 构建一个中间件,监测网站的响应状态,代码如 ...

- [转载] TCP长连接与短连接的区别

转载自http://www.cnblogs.com/liuyong/archive/2011/07/01/2095487.html 1. TCP连接 当网络通信时采用TCP协议时,在真正的读写操作之前 ...