【自然语言处理篇】--以NLTK为基础讲解自然语⾔处理的原理和基础知识

一、前述

Python上著名的⾃然语⾔处理库⾃带语料库,词性分类库⾃带分类,分词,等等功能强⼤的社区⽀持,还有N多的简单版wrapper。

二、文本预处理

1、安装nltk

pip install -U nltk

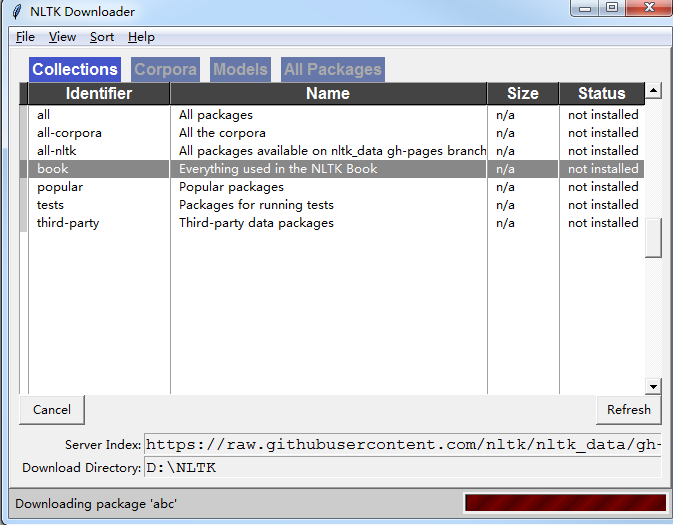

安装语料库 (一堆对话,一对模型)

import nltk

nltk.download()

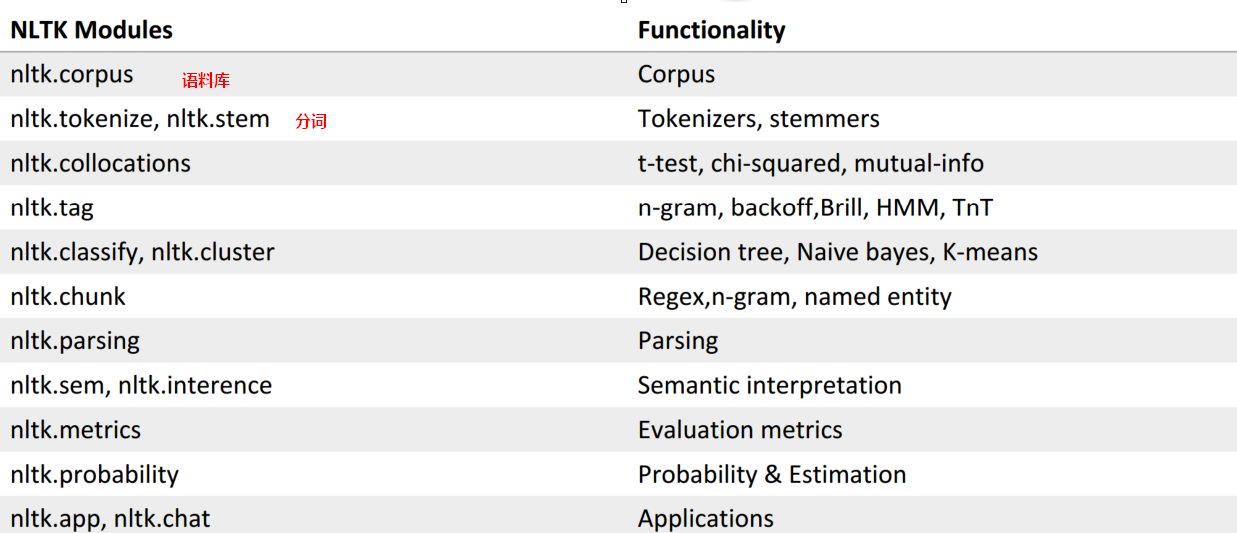

2、功能一览表:

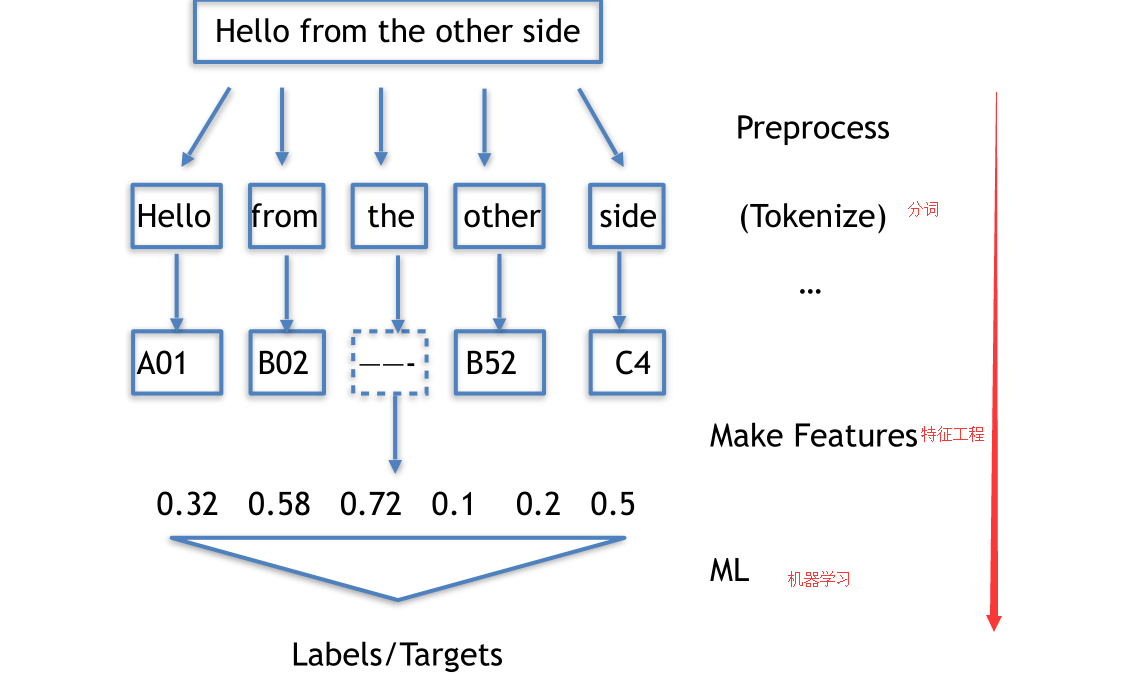

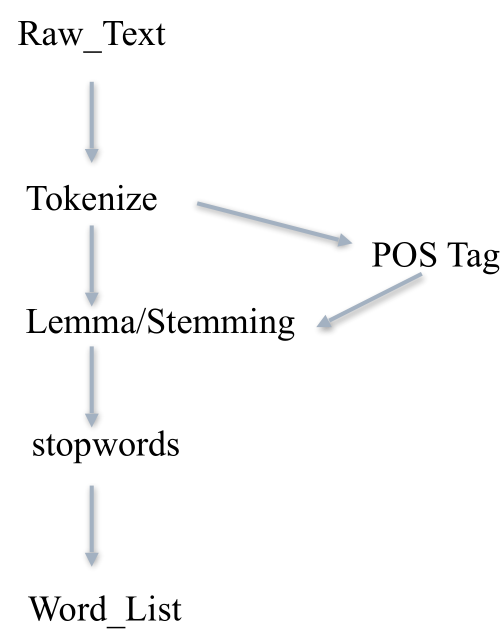

3、文本处理流程

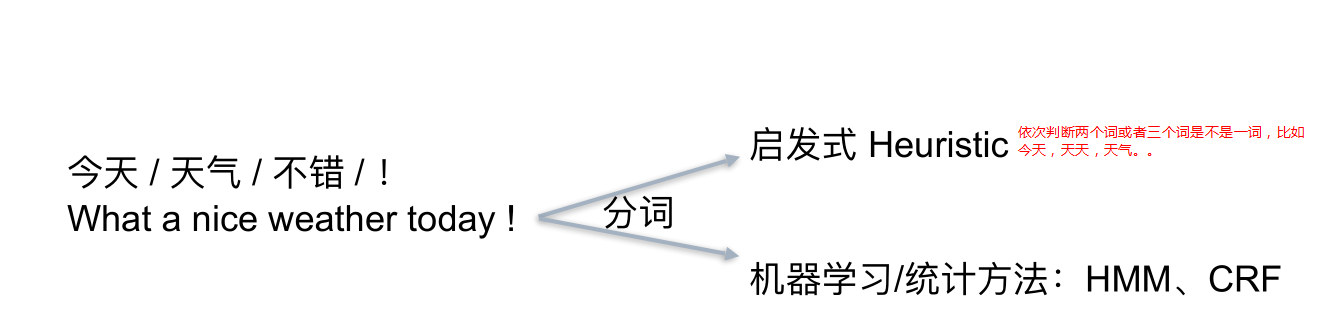

4、Tokenize 把长句⼦拆成有“意义”的⼩部件

import jieba

seg_list = jieba.cut("我来到北北京清华⼤大学", cut_all=True)

print "Full Mode:", "/ ".join(seg_list) # 全模式

seg_list = jieba.cut("我来到北北京清华⼤大学", cut_all=False)

print "Default Mode:", "/ ".join(seg_list) # 精确模式

seg_list = jieba.cut("他来到了了⽹网易易杭研⼤大厦") # 默认是精确模式

print ", ".join(seg_list)

seg_list = jieba.cut_for_search("⼩小明硕⼠士毕业于中国科学院计算所,后在⽇日本京都⼤大学深造")

# 搜索引擎模式

print ", ".join(seg_list)

结果:

【全模式】: 我/ 来到/ 北北京/ 清华/ 清华⼤大学/ 华⼤大/ ⼤大学

【精确模式】: 我/ 来到/ 北北京/ 清华⼤大学

【新词识别】:他, 来到, 了了, ⽹网易易, 杭研, ⼤大厦

(此处,“杭研”并没有在词典中,但是也被Viterbi算法识别出来了了)

【搜索引擎模式】: ⼩小明, 硕⼠士, 毕业, 于, 中国, 科学, 学院, 科学院, 中国科学院, 计算,

计算所, 后, 在, ⽇日本, 京都, ⼤大学, ⽇日本京都⼤大学, 深造

社交⽹络语⾔的tokenize:

import re

emoticons_str = r"""

(?:

[:=;] # 眼睛

[oO\-]? # ⿐鼻⼦子

[D\)\]\(\]/\\OpP] # 嘴

)"""

regex_str = [

emoticons_str,

r'<[^>]+>', # HTML tags

r'(?:@[\w_]+)', # @某⼈人

r"(?:\#+[\w_]+[\w\'_\-]*[\w_]+)", # 话题标签

r'http[s]?://(?:[a-z]|[0-9]|[$-_@.&+]|[!*\(\),]|(?:%[0-9a-f][0-9a-f]))+',

# URLs

r'(?:(?:\d+,?)+(?:\.?\d+)?)', # 数字

r"(?:[a-z][a-z'\-_]+[a-z])", # 含有 - 和 ‘ 的单词

r'(?:[\w_]+)', # 其他

r'(?:\S)' # 其他

]

正则表达式对照表

http://www.regexlab.com/zh/regref.htm

这样能处理社交语言中的表情等符号:

tokens_re = re.compile(r'('+'|'.join(regex_str)+')', re.VERBOSE | re.IGNORECASE)

emoticon_re = re.compile(r'^'+emoticons_str+'$', re.VERBOSE | re.IGNORECASE)

def tokenize(s):

return tokens_re.findall(s)

def preprocess(s, lowercase=False):

tokens = tokenize(s)

if lowercase:

tokens = [token if emoticon_re.search(token) else token.lower() for token in

tokens]

return tokens

tweet = 'RT @angelababy: love you baby! :D http://ah.love #168cm'

print(preprocess(tweet))

# ['RT', '@angelababy', ':', 'love', 'you', 'baby',

# ’!', ':D', 'http://ah.love', '#168cm']

5、词形归⼀化

Stemming 词⼲提取:⼀般来说,就是把不影响词性的inflection的⼩尾巴砍掉

walking 砍ing = walk

walked 砍ed = walk

Lemmatization 词形归⼀:把各种类型的词的变形,都归为⼀个形式

went 归⼀ = go

are 归⼀ = be

>>> from nltk.stem.porter import PorterStemmer

>>> porter_stemmer = PorterStemmer()

>>> porter_stemmer.stem(‘maximum’)

u’maximum’

>>> porter_stemmer.stem(‘presumably’)

u’presum’

>>> porter_stemmer.stem(‘multiply’)

u’multipli’

>>> porter_stemmer.stem(‘provision’)

u’provis’

>>> from nltk.stem import SnowballStemmer

>>> snowball_stemmer = SnowballStemmer(“english”)

>>> snowball_stemmer.stem(‘maximum’)

u’maximum’

>>> snowball_stemmer.stem(‘presumably’)

u’presum’

>>> from nltk.stem.lancaster import LancasterStemmer

>>> lancaster_stemmer = LancasterStemmer()

>>> lancaster_stemmer.stem(‘maximum’)

‘maxim’

>>> lancaster_stemmer.stem(‘presumably’)

‘presum’

>>> lancaster_stemmer.stem(‘presumably’)

‘presum’

>>> from nltk.stem.porter import PorterStemmer

>>> p = PorterStemmer()

>>> p.stem('went')

'went'

>>> p.stem('wenting')

'went'

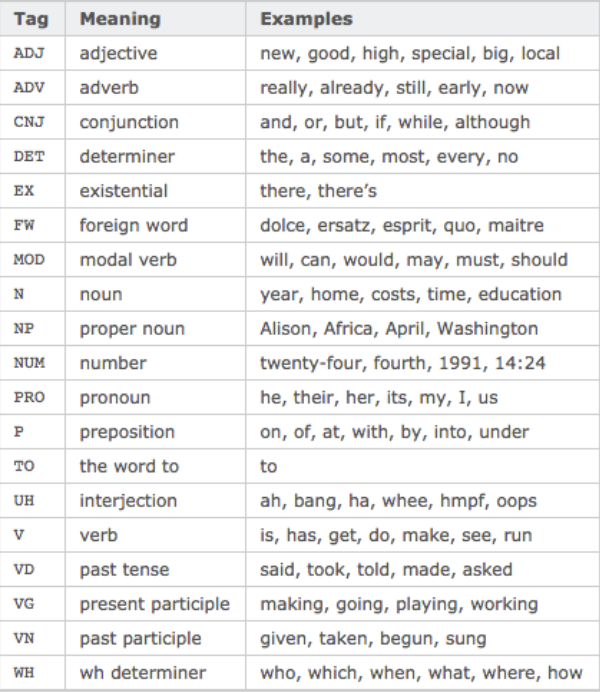

6、词性Part-Of-Speech

>>> import nltk

>>> text = nltk.word_tokenize('what does the fox say')

>>> text

['what', 'does', 'the', 'fox', 'say']

>>> nltk.pos_tag(text)

[('what', 'WDT'), ('does', 'VBZ'), ('the', 'DT'), ('fox', 'NNS'), ('say', 'VBP')]

7、Stopwords

⾸先记得在console⾥⾯下载⼀下词库

或者 nltk.download(‘stopwords’)

from nltk.corpus import stopwords

# 先token⼀一把,得到⼀一个word_list

# ...

# 然后filter⼀一把

filtered_words =

[word for word in word_list if word not in stopwords.words('english')]

8、⼀条⽂本预处理流⽔线

三、自然语言处理应用。

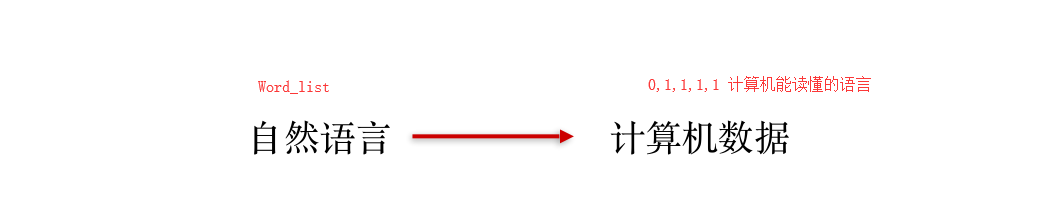

实际上预处理就是将文本转换为Word_List,自然语言处理再转变成计算机能识别的语言。

自然语言处理有以下几个应用:情感分析,⽂本相似度, ⽂本分类

1、情感分析

最简单的 sentiment dictionary,类似于关键词打分机制.

like 1

good 2

bad -2

terrible -3

sentiment_dictionary = {}

for line in open('data/AFINN-111.txt')

word, score = line.split('\t')

sentiment_dictionary[word] = int(score)

# 把这个打分表记录在⼀一个Dict上以后

# 跑⼀一遍整个句句⼦子,把对应的值相加

total_score = sum(sentiment_dictionary.get(word, 0) for word in words)

# 有值就是Dict中的值,没有就是0

# 于是你就得到了了⼀一个 sentiment score

显然这个⽅法太Naive,新词怎么办?特殊词汇怎么办?更深层次的玩意⼉怎么办?

加上ML情感分析

from nltk.classify import NaiveBayesClassifier

# 随⼿手造点训练集

s1 = 'this is a good book'

s2 = 'this is a awesome book'

s3 = 'this is a bad book'

s4 = 'this is a terrible book'

def preprocess(s):

# Func: 句句⼦子处理理

# 这⾥里里简单的⽤用了了split(), 把句句⼦子中每个单词分开

# 显然 还有更更多的processing method可以⽤用

return {word: True for word in s.lower().split()}

# return⻓长这样:

# {'this': True, 'is':True, 'a':True, 'good':True, 'book':True}

# 其中, 前⼀一个叫fname, 对应每个出现的⽂文本单词;

# 后⼀一个叫fval, 指的是每个⽂文本单词对应的值。

# 这⾥里里我们⽤用最简单的True,来表示,这个词『出现在当前的句句⼦子中』的意义。

# 当然啦, 我们以后可以升级这个⽅方程, 让它带有更更加⽜牛逼的fval, ⽐比如 word2vec

# 把训练集给做成标准形式

training_data = [[preprocess(s1), 'pos'],

[preprocess(s2), 'pos'],

[preprocess(s3), 'neg'],

[preprocess(s4), 'neg']]

# 喂给model吃

model = NaiveBayesClassifier.train(training_data)

# 打出结果

print(model.classify(preprocess('this is a good book')))

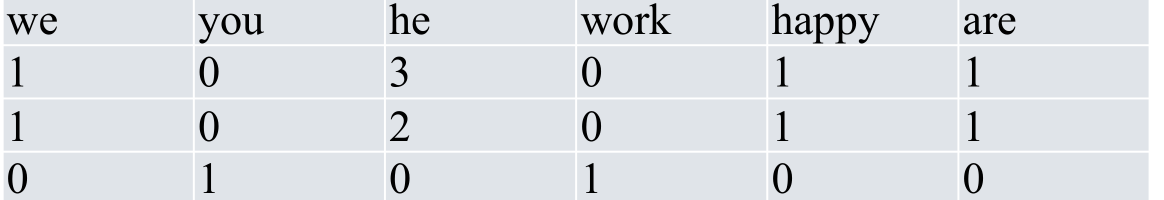

2、文本相似度

⽤元素频率表⽰⽂本特征,常见的做法

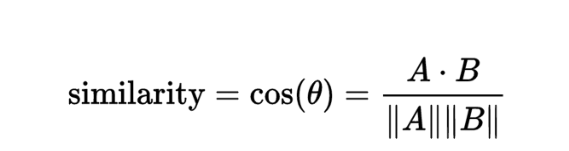

然后用余弦定理来计算文本相似度:

Frequency 频率统计:

import nltk

from nltk import FreqDist

# 做个词库先

corpus = 'this is my sentence ' \

'this is my life ' \

'this is the day'

# 随便便tokenize⼀一下

# 显然, 正如上⽂文提到,

# 这⾥里里可以根据需要做任何的preprocessing:

# stopwords, lemma, stemming, etc.

tokens = nltk.word_tokenize(corpus)

print(tokens)

# 得到token好的word list

# ['this', 'is', 'my', 'sentence',

# 'this', 'is', 'my', 'life', 'this',

# 'is', 'the', 'day']

# 借⽤用NLTK的FreqDist统计⼀一下⽂文字出现的频率

fdist = FreqDist(tokens)

# 它就类似于⼀一个Dict

# 带上某个单词, 可以看到它在整个⽂文章中出现的次数

print(fdist['is'])

# 3

# 好, 此刻, 我们可以把最常⽤用的50个单词拿出来

standard_freq_vector = fdist.most_common(50)

size = len(standard_freq_vector)

print(standard_freq_vector)

# [('is', 3), ('this', 3), ('my', 2),

# ('the', 1), ('d

3、文本分类

TF: Term Frequency, 衡量⼀个term在⽂档中出现得有多频繁。

TF(t) = (t出现在⽂档中的次数) / (⽂档中的term总数).

IDF: Inverse Document Frequency, 衡量⼀个term有多重要。

有些词出现的很多,但是明显不是很有卵⽤。⽐如’is',’the‘,’and‘之类

的。

为了平衡,我们把罕见的词的重要性(weight)搞⾼,

把常见词的重要性搞低。

IDF(t) = log_e(⽂档总数 / 含有t的⽂档总数).

TF-IDF = TF * IDF

举个栗⼦

【自然语言处理篇】--以NLTK为基础讲解自然语⾔处理的原理和基础知识的更多相关文章

- 自然语言处理(1)之NLTK与PYTHON

自然语言处理(1)之NLTK与PYTHON 题记: 由于现在的项目是搜索引擎,所以不由的对自然语言处理产生了好奇,再加上一直以来都想学Python,只是没有机会与时间.碰巧这几天在亚马逊上找书时发现了 ...

- Promise入门到精通(初级篇)-附代码详细讲解

Promise入门到精通(初级篇)-附代码详细讲解 Promise,中文翻译为承诺,约定,契约,从字面意思来看,这应该是类似某种协议,规定了什么事件发生的条件和触发方法. Pr ...

- 转载一篇比较详细的讲解html,css的一篇文章,很长

转载自这里,转载请注明出处. DIV+CSS系统学习笔记回顾 第一部分 HTML 第一章 职业规划和前景 职业方向规划定位: web前端开发工程师 web网站架构师 自己创业 转岗管理或其他 ...

- NLTK与NLP原理及基础

参考https://blog.csdn.net/zxm1306192988/article/details/78896319 以NLTK为基础配合讲解自然语言处理的原理 http://www.nlt ...

- C# 基础知识 (一).概念与思想篇

在C#中有一些我自己认为比较独特的知识点,这些知识点是我经常使用的知识,但对它们的了解还是比较少的,所以通过查找资料学习,总结了这些独特的知识点并简单叙述,第一篇主要是一些概念和思想方面的知识.(后面 ...

- CSS3 的box-shadow进阶之 - 基础知识篇

box-shadow被认为是CSS3最好的特性之一,发挥想象力,搭配其它属性,可以做出很多好看的效果(如下图,将会放在下一篇文章讲解),这篇文章主要讲一下box-shadow的基础知识. ...

- 【Java面试题系列】:Java基础知识常见面试题汇总 第一篇

文中面试题从茫茫网海中精心筛选,如有错误,欢迎指正! 1.前言 参加过社招的同学都了解,进入一家公司面试开发岗位时,填写完个人信息后,一般都会让先做一份笔试题,然后公司会根据笔试题的回答结果,确定 ...

- 大数据学习笔记——Java篇之基础知识

Java / 计算机基础知识整理 在进行知识梳理同时也是个人的第一篇技术博客之前,首先祝贺一下,经历了一年左右的学习,从完完全全的计算机小白,现在终于可以做一些产出了!可以说也是颇为感慨,个人认为,学 ...

- Java基础知识常见面试题汇总第一篇

[Java面试题系列]:Java基础知识常见面试题汇总 第一篇 文中面试题从茫茫网海中精心筛选,如有错误,欢迎指正! 1.前言 参加过社招的同学都了解,进入一家公司面试开发岗位时,填写完个人信息后 ...

随机推荐

- Python3的requests类抓取中文页面出现乱码的解决办法

这种乱码现象基本上都是编码造成的,我们要转到我们想要的编码,先po一个知识点,嵩天老师在Python网络爬虫与信息提取说到过的:response.encoding是指从HTTP的header中猜测 ...

- python中 __cmp__

对 int.str 等内置数据类型排序时,Python的 sorted() 按照默认的比较函数 cmp 排序,但是,如果对一组 Student 类的实例排序时,就必须提供我们自己的特殊方法__cmp_ ...

- 好代码是管出来的——Git的分支工作流与Pull Request

上一篇文章介绍了常用的版本控制工具以及git的基本用法,从基本用法来看git与其它的版本控制工具好像区别不大,都是对代码新增.提交进行管理,可以查看提交历史.代码差异等功能.但实际上git有一个重量级 ...

- disk.go

package disk import "syscall" //空间使用结构体 type DiskStatus struct { Size uint64 Used ...

- retry.go

package clientv3 import ( "github.com/coreos/etcd/etcdserver/api/v3rpc/rpctypes" p ...

- 【BZOJ 3697】采药人的路径

题目链接: TP 题解: 调了好久233. 大概想一想就是树分,然后考虑这样路径(u,v)的特征,以根节点(root)切开,u到root的阴阳差值,和v到root巧合互为相反数,然后考虑要有一个点可作 ...

- 【最小生成树+子集枚举】Uva1151 Buy or Build

Description 平面上有n个点(1<=N<=1000),你的任务是让所有n个点连通,为此,你可以新建一些边,费用等于两个端点的欧几里得距离的平方. 另外还有q(0<=q< ...

- Java线程与Linux内核线程的映射关系

Linux从内核2.6开始使用NPTL (Native POSIX Thread Library)支持,但这时线程本质上还轻量级进程. Java里的线程是由JVM来管理的,它如何对应到操作系统的线程是 ...

- 基于SpringBoot从零构建博客网站 - 确定需求和表结构

要确定一个系统的需求,首先需要明确该系统的用户有哪些,然后针对每一类用户,确定其需求.对于博客网站来说,用户有3大类,分别是: 作者,也即是注册用户 游客,也即非注册用户 管理员,网站维护人员 那么从 ...

- Android版数据结构与算法(一):基础简介

版权声明:本文出自汪磊的博客,未经作者允许禁止转载. 一.前言 项目进入收尾阶段,忙忙碌碌将近一个多月吧,还好,不算太难,就是麻烦点. 数据结构与算法这个系列早就想写了,一是梳理总结,顺便逼迫自己把一 ...