二、PyTorch 入门实战—Variable(转)

一、概念

1.Numpy里没有Variable这个概念,如果大家学过TensorFlow就会知道,Variable提供了自动求导的功能。

2.Variable需要放进一个计算图中,然后进行前后向传播和自动求导。

3.Variable的属性有三个:

- data:Variable里Tensor变量的数值

- grad:Variable反向传播的梯度

- grad_fn:得到Variable的操作

二、Variable的创建和使用

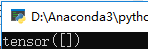

1.我们首先创建一个空的Variable:

import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

结果如下:

可以看到默认的类型为Tensor

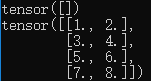

2.那么,我们如果需要给Variable变量赋值,那么就一定是Tensor类型,例如:

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

代码变为:

import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

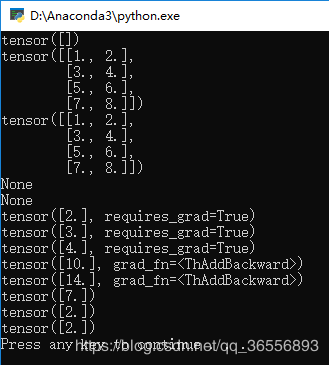

结果为:

3.第一章提到了Variable的三个属性,我们依次打印它们:

import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

print(b.data)

print(b.grad)

print(b.grad_fn)

结果为:

可以看到data就是Tensor的内容,剩下的两个属性为空

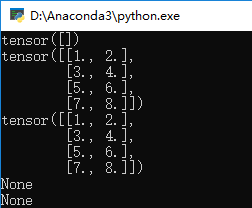

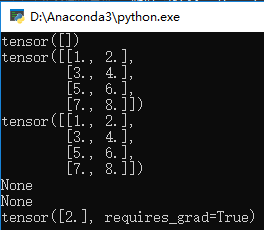

三、标量求导计算图

1.为了方便起见,我们可以将torch.autograd.Variable简写为Variable:

from torch.autograd import Variable

2.之后,我们先声明一个变量x,这里requires_grad=True意义是否对这个变量求梯度,默认的 Fa!se:

x = Variable(torch.Tensor([2]),requires_grad = True)

print(x)

代码变为:

import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

print(b.data)

print(b.grad)

print(b.grad_fn) #建立计算图

from torch.autograd import Variable

x = Variable(torch.Tensor([2]),requires_grad = True)

print(x)

结果为:

3.我们再声明两个变量w和b:

w = Variable(torch.Tensor([3]),requires_grad = True)

print(w)

b = Variable(torch.Tensor([4]),requires_grad = True)

print(b)

4.我们再写两个变量y1和y2:

y1 = w * x + b

print(y1)

y2 = w * x + b * x

print(y2)

5.我们来计算各个变量的梯度,首先是y1:

#计算梯度

y1.backward()

print(x.grad)

print(w.grad)

print(b.grad)

代码变为:

import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

print(b.data)

print(b.grad)

print(b.grad_fn) #建立计算图

from torch.autograd import Variable

x = Variable(torch.Tensor([2]),requires_grad = True)

print(x)

w = Variable(torch.Tensor([3]),requires_grad = True)

print(w)

b = Variable(torch.Tensor([4]),requires_grad = True)

print(b)

y1 = w * x + b

print(y1)

y2 = w * x + b * x

print(y2)

#计算梯度

y1.backward()

print(x.grad)

print(w.grad)

print(b.grad)

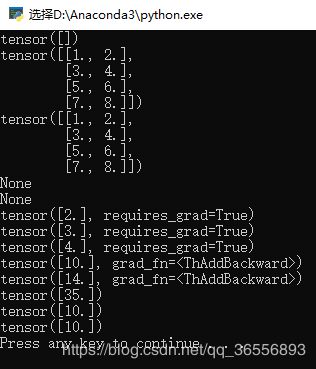

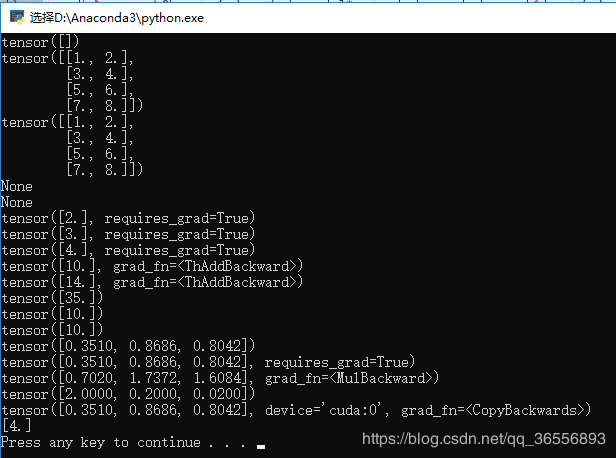

结果为:

其中:

y1 = 3 * 2 + 4 = 10,

y2 = 3 * 2 + 4 * 2 = 14,

x的梯度是3因为是3 * x,

w的梯度是2因为w * 2,

b的梯度是1因为b * 1(* 1被省略)

6.其次是y2,注销y1部分:

y2.backward(x)

print(x.grad)

print(w.grad)

print(b.grad)

代码为: import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

print(b.data)

print(b.grad)

print(b.grad_fn) #建立计算图

from torch.autograd import Variable

x = Variable(torch.Tensor([2]),requires_grad = True)

print(x)

w = Variable(torch.Tensor([3]),requires_grad = True)

print(w)

b = Variable(torch.Tensor([4]),requires_grad = True)

print(b)

y1 = w * x + b

print(y1)

y2 = w * x + b * x

print(y2)

#计算梯度

#y1.backward()

#print(x.grad)

#print(w.grad)

#print(b.grad)

y2.backward()

print(x.grad)

print(w.grad)

print(b.grad)

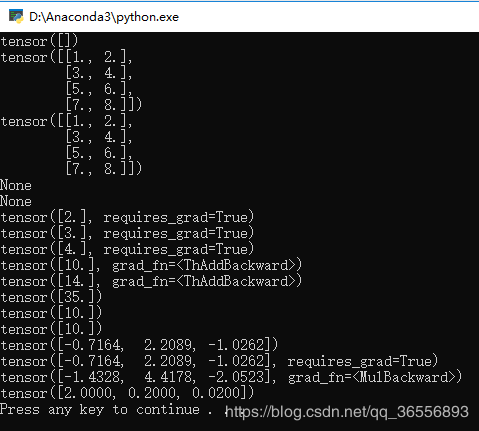

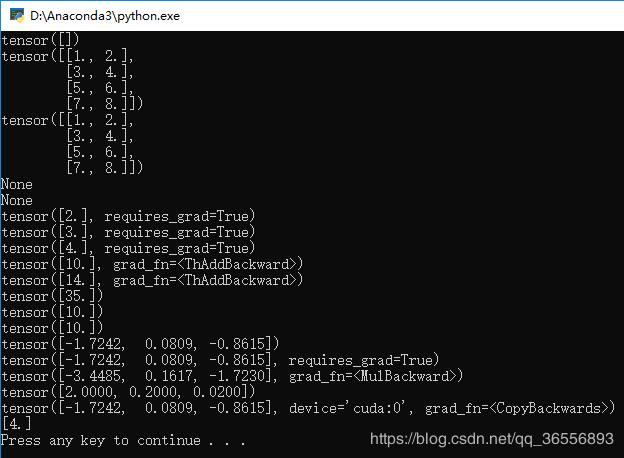

结果为:

其中:

x的梯度是7因为是3 * x + 4 * x,

w的梯度是2因为w * 2,

b的梯度是2因为b * 2

7.backward的函数可以填入参数,例如我们填入变量a:

a = Variable(torch.Tensor([5]),requires_grad = True)

y2.backward(a)

print(x.grad)

print(w.grad)

print(b.grad)

代码变为:

import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

print(b.data)

print(b.grad)

print(b.grad_fn) #建立计算图

from torch.autograd import Variable

x = Variable(torch.Tensor([2]),requires_grad = True)

print(x)

w = Variable(torch.Tensor([3]),requires_grad = True)

print(w)

b = Variable(torch.Tensor([4]),requires_grad = True)

print(b)

y1 = w * x + b

print(y1)

y2 = w * x + b * x

print(y2)

#计算梯度

#y1.backward()

#print(x.grad)

#print(w.grad)

#print(b.grad)

a = Variable(torch.Tensor([5]),requires_grad = True)

y2.backward(a)

print(x.grad)

print(w.grad)

print(b.grad)

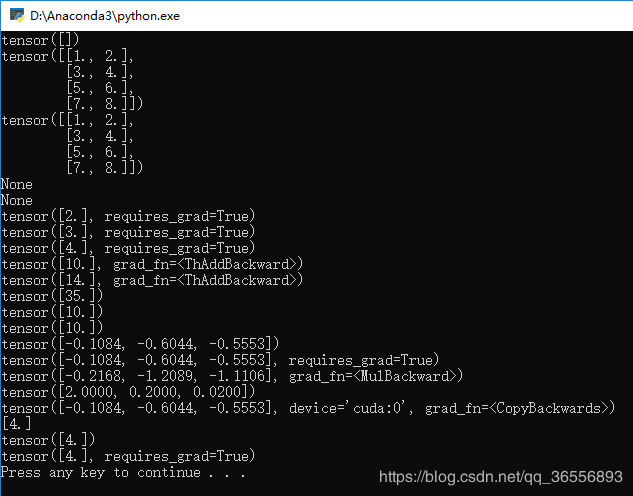

结果为:

可以看到x,w,b的梯度乘以了a的值5,说明这个填入参数是梯度的系数。

四、矩阵求导计算图

1.例如:

#矩阵求导

c = torch.randn(3)

print(c)

c = Variable(c,requires_grad = True)

print(c)

y3 = c * 2

print(y3)

y3.backward(torch.FloatTensor([1, 0.1, 0.01]))

print(c.grad)

代码变为:

import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

print(b.data)

print(b.grad)

print(b.grad_fn) #建立计算图

from torch.autograd import Variable

x = Variable(torch.Tensor([2]),requires_grad = True)

print(x)

w = Variable(torch.Tensor([3]),requires_grad = True)

print(w)

b = Variable(torch.Tensor([4]),requires_grad = True)

print(b)

y1 = w * x + b

print(y1)

y2 = w * x + b * x

print(y2)

#计算梯度

#y1.backward()

#print(x.grad)

#print(w.grad)

#print(b.grad)

a = Variable(torch.Tensor([5]),requires_grad = True)

y2.backward(a)

print(x.grad)

print(w.grad)

print(b.grad) #矩阵求导

c = torch.randn(3)

print(c)

c = Variable(c,requires_grad = True)

print(c)

y3 = c * 2

print(y3)

y3.backward(torch.FloatTensor([1, 0.1, 0.01]))

print(c.grad)

结果为:

可以看到,c是一个1行3列的矩阵,因为y3 = c * 2,因此如果backward()里的参数为:

torch.FloatTensor([1, 1, 1])

则就是每个分量的梯度,但是传入的是:

torch.FloatTensor([1, 0.1, 0.01])

则每个分量梯度要分别乘以1,0.1和0.01

五、Variable放到GPU上执行

1.和Tensor一样的道理,代码如下:

#Variable放在GPU上

if torch.cuda.is_available():

d = c.cuda()

print(d)

代码变为:

import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

print(b.data)

print(b.grad)

print(b.grad_fn) #建立计算图

from torch.autograd import Variable

x = Variable(torch.Tensor([2]),requires_grad = True)

print(x)

w = Variable(torch.Tensor([3]),requires_grad = True)

print(w)

b = Variable(torch.Tensor([4]),requires_grad = True)

print(b)

y1 = w * x + b

print(y1)

y2 = w * x + b * x

print(y2)

#计算梯度

#y1.backward()

#print(x.grad)

#print(w.grad)

#print(b.grad)

a = Variable(torch.Tensor([5]),requires_grad = True)

y2.backward(a)

print(x.grad)

print(w.grad)

print(b.grad) #矩阵求导

c = torch.randn(3)

print(c)

c = Variable(c,requires_grad = True)

print(c)

y3 = c * 2

print(y3)

y3.backward(torch.FloatTensor([1, 0.1, 0.01]))

print(c.grad)

#Variable放在GPU上

if torch.cuda.is_available():

d = c.cuda()

print(d)

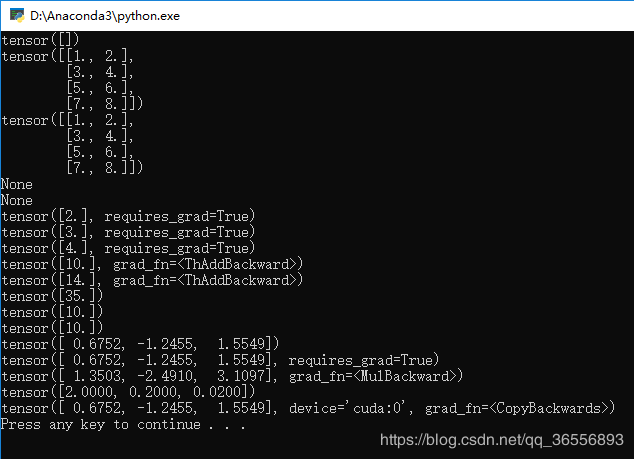

2.生成结果会慢一下,然后可以看到多了一个device=‘cuda:0’和grad_fn=<CopyBackwards>

六、Variable转Numpy与Numpy转Variable

1.值得注意的是,Variable里requires_grad 一般设置为 False,代码中为True则:

#变量转Numpy

e = Variable(torch.Tensor([4]),requires_grad = True)

f = e.numpy()

print(f)

会报如下错误:

Can't call numpy() on Variable that requires grad. Use var.detach().numpy() instead.

2.解决方法1:requires_grad改为False后,可以看到最后一行的Numpy类型的矩阵[4.]:

3.解决方法2::将numpy()改为detach().numpy(),可以看到最后一行的Numpy类型的矩阵[4.]

#变量转Numpy

e = Variable(torch.Tensor([4]),requires_grad = True)

f = e.detach().numpy()

print(f)

代码变为:

import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

print(b.data)

print(b.grad)

print(b.grad_fn) #建立计算图

from torch.autograd import Variable

x = Variable(torch.Tensor([2]),requires_grad = True)

print(x)

w = Variable(torch.Tensor([3]),requires_grad = True)

print(w)

b = Variable(torch.Tensor([4]),requires_grad = True)

print(b)

y1 = w * x + b

print(y1)

y2 = w * x + b * x

print(y2)

#计算梯度

#y1.backward()

#print(x.grad)

#print(w.grad)

#print(b.grad)

a = Variable(torch.Tensor([5]),requires_grad = True)

y2.backward(a)

print(x.grad)

print(w.grad)

print(b.grad) #矩阵求导

c = torch.randn(3)

print(c)

c = Variable(c,requires_grad = True)

print(c)

y3 = c * 2

print(y3)

y3.backward(torch.FloatTensor([1, 0.1, 0.01]))

print(c.grad)

#Variable放在GPU上

if torch.cuda.is_available():

d = c.cuda()

print(d)

#变量转Numpy

e = Variable(torch.Tensor([4]),requires_grad = True)

f = e.detach().numpy()

print(f)

结果为:

4.Numpy转Variable先是转为Tensor再转为Variable:

#转换为Tensor

g = torch.from_numpy(f)

print(g)

#转换为Variable

g = Variable(g,requires_grad = True)

print(g)

代码变为:

import torch

#创建Variable

a = torch.autograd.Variable()

print(a)

b = torch.autograd.Variable(torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]]))

print(b)

print(b.data)

print(b.grad)

print(b.grad_fn) #建立计算图

from torch.autograd import Variable

x = Variable(torch.Tensor([2]),requires_grad = True)

print(x)

w = Variable(torch.Tensor([3]),requires_grad = True)

print(w)

b = Variable(torch.Tensor([4]),requires_grad = True)

print(b)

y1 = w * x + b

print(y1)

y2 = w * x + b * x

print(y2)

#计算梯度

#y1.backward()

#print(x.grad)

#print(w.grad)

#print(b.grad)

a = Variable(torch.Tensor([5]),requires_grad = True)

y2.backward(a)

print(x.grad)

print(w.grad)

print(b.grad) #矩阵求导

c = torch.randn(3)

print(c)

c = Variable(c,requires_grad = True)

print(c)

y3 = c * 2

print(y3)

y3.backward(torch.FloatTensor([1, 0.1, 0.01]))

print(c.grad)

#Variable放在GPU上

if torch.cuda.is_available():

d = c.cuda()

print(d)

#变量转Numpy

e = Variable(torch.Tensor([4]),requires_grad = True)

f = e.detach().numpy()

print(f)

#转换为Tensor

g = torch.from_numpy(f)

print(g)

#转换为Variable

g = Variable(g,requires_grad = True)

print(g)

结果为:

七、Variable总结

1.Variable和Tensor本质上没有区别,不过Variable会被放入一个计算图中,然后进行前向传播,反向传播,自动求导。

2.Variable有三个属性,可以通过构造函数结构求取梯度得到grad值和grad_fn值

3.Variable,Tensor和Numpy互相转化很方便,类型也比较兼容

二、PyTorch 入门实战—Variable(转)的更多相关文章

- shiro实战系列(二)之入门实战续

下面讲解基于实战系列一,所以相关的java文件获取pom.xml及其log4j文件同样适用于本次讲解. 一.Using Shiro Using Shiro 现在我们的 SecurityManager ...

- 一、PyTorch 入门实战—Tensor(转)

目录 一.Tensor的创建和使用 二.Tensor放到GPU上执行 三.Tensor总结 一.Tensor的创建和使用 1.概念和TensorFlow的是基本一致的,只是代码编写格式的不同.我们声明 ...

- 深度学习入门实战(二)-用TensorFlow训练线性回归

欢迎大家关注腾讯云技术社区-博客园官方主页,我们将持续在博客园为大家推荐技术精品文章哦~ 作者 :董超 上一篇文章我们介绍了 MxNet 的安装,但 MxNet 有个缺点,那就是文档不太全,用起来可能 ...

- Pytorch入门——手把手教你MNIST手写数字识别

MNIST手写数字识别教程 要开始带组内的小朋友了,特意出一个Pytorch教程来指导一下 [!] 这里是实战教程,默认读者已经学会了部分深度学习原理,若有不懂的地方可以先停下来查查资料 目录 MNI ...

- Spark入门实战系列--2.Spark编译与部署(上)--基础环境搭建

[注] 1.该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取: 2.Spark编译与部署将以CentOS 64位操作系统为基础,主要是考虑到实际应用 ...

- Spark入门实战系列--6.SparkSQL(上)--SparkSQL简介

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .SparkSQL的发展历程 1.1 Hive and Shark SparkSQL的前身是 ...

- Spark入门实战系列--6.SparkSQL(下)--Spark实战应用

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .运行环境说明 1.1 硬软件环境 线程,主频2.2G,10G内存 l 虚拟软件:VMwa ...

- JMeter学习-004-WEB脚本入门实战

此文为 JMeter 入门实战实例.我是 JMeter 初学菜鸟一个,因而此文适合 JMeter 初学者参阅.同时,因本人知识有限,若文中存在不足的地方,敬请大神不吝指正,非常感谢! 闲话少述,话归正 ...

- webpack快速入门——实战技巧:优雅打包第三方类库

下面说两种方法: 一. 1.引入jQuery,首先安装: cnpm install --save jquery 2.安装好后,在我们的entry.js中引入: import $ from 'jquer ...

随机推荐

- MCtalk对话学吧课堂:真正的K12在线教育才刚刚开始

课堂之外的在线教育已经被大部分家庭所熟知,既涌现出了VIPKID等行业独角兽,也有大量致力于科技改变教育的新兴机构获得了快速成长.成立于2014年的学吧课堂就是专注在K12在线教育领域的创新机构,他们 ...

- HBase 学习之路(四)—— HBase集群环境配置

一.集群规划 这里搭建一个3节点的HBase集群,其中三台主机上均为Regin Server.同时为了保证高可用,除了在hadoop001上部署主Master服务外,还在hadoop002上部署备用的 ...

- Android之控件学习

文本域,类似于HTML里的textarea <EditText android:id="@+id/edit_text" android:layout_width=" ...

- js深入(三)作用域链与闭包

在之前我们根绝对象的原型说过了js的原型链,那么同样的js 万物皆对象,函数也同样存在这么一个链式的关系,就是函数的作用域链 作用域链 首先先来回顾一下之前讲到的原型链的寻找机制,就是实例会先从本身开 ...

- k8s对象类资源格式

k8s api仅接受及响应json格式的数据,同时,为了便于使用,它也允许用户提供yaml格式的post对象,但apiserver需要事先自行将其转换为json格式后方能提交.每个资源通常仅接受并返回 ...

- C++ 洛谷 2014 选课 from_树形DP

洛谷 2014 选课 没学树形DP的,看一下. 首先要学会多叉树转二叉树. 树有很多种,二叉树是一种人人喜欢的数据结构,简单而且规则.但一般来说,树形动规的题目很少出现二叉树,因此将多叉树转成二叉树就 ...

- SQL Server温故系列(5):SQL 查询之分组查询 GROUP BY

1.GROUP BY 与聚合函数 2.GROUP BY 与 HAVING 3.GROUP BY 扩展分组 3.1.GROUP BY ROLLUP 3.2.GROUP BY CUBE 3.3.GROUP ...

- java日期在今天的基础上加一个月。并计算时间相差天数

Calendar calendar = Calendar.getInstance(); calendar.setTime(date); calendar.add(Calendar.MONTH, 1); ...

- 基于C#的机器学习--我应该接受这份工作吗-使用决策树

决策树 要使决策树完整而有效,它必须包含所有的可能性.事件序列也必须提供,并且是互斥的,这意味着如果一个事件发生,另一个就不能发生. 决策树是监督机器学习的一种形式,因为我们必须解释输入和输出应该是什 ...

- 跟着大彬读源码 - Redis 3 - 服务器如何响应客户端请求?(下)

继续我们上一节的讨论.服务器启动了,客户端也发送命令了.接下来,就要到服务器"表演"的时刻了. 1 服务器处理 服务器读取到命令请求后,会进行一系列的处理. 1.1 读取命令请求 ...