Scrapy-下载中间件

下载中间件

下载器中间件是介于Scrapy的request/response处理的钩子框架。 是用于全局修改Scrapy request和response的一个轻量、底层的系统

编写您自己的下载器中间件

每个中间件组件是一个定义了以下一个或多个方法的Python类

使用中间件随机选择头部信息

1. 创建项目

scrapy startproject chinaarea

2. 创建爬虫文件

scrapy genspider airs "www.aqistudy.cn"

class AirsSpider(scrapy.Spider):

name = 'airs'

allowed_domains = ['aqistudy.cn']

baseUrl = 'https://www.aqistudy.cn/historydata/'

start_urls = [baseUrl] def parse(self, response):

yield scrapy.Request(url='https://www.baidu.com',callback=self.parse)

3.创建下载中间件

from chinaarea.settings import USER_AGENTS as ua_list

import random

class UserAgentMiddleware(object):

"""

给每个请求随机选取user_Agent

"""

def process_request(self,request, spider):

user_agent = random.choice(ua_list)

request.headers['USER_AGENTS'] = user_agent

# request.meta['proxy'] 设置代理

print('request: ', request.headers['USER_AGENTS'] )

print('*'*30)

4.设置setting

USER_AGENTS = [

"Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Win64; x64; Trident/5.0; .NET CLR 3.5.30729; .NET CLR 3.0.30729; .NET CLR 2.0.50727; Media Center PC 6.0)",

"Mozilla/5.0 (compatible; MSIE 8.0; Windows NT 6.0; Trident/4.0; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; .NET CLR 1.0.3705; .NET CLR 1.1.4322)",

"Mozilla/4.0 (compatible; MSIE 7.0b; Windows NT 5.2; .NET CLR 1.1.4322; .NET CLR 2.0.50727; InfoPath.2; .NET CLR 3.0.04506.30)",

"Mozilla/5.0 (Windows; U; Windows NT 5.1; zh-CN) AppleWebKit/523.15 (KHTML, like Gecko, Safari/419.3) Arora/0.3 (Change: 287 c9dfb30)",

"Mozilla/5.0 (X11; U; Linux; en-US) AppleWebKit/527+ (KHTML, like Gecko, Safari/419.3) Arora/0.6",

"Mozilla/5.0 (Windows; U; Windows NT 5.1; en-US; rv:1.8.1.2pre) Gecko/20070215 K-Ninja/2.1.1",

"Mozilla/5.0 (Windows; U; Windows NT 5.1; zh-CN; rv:1.9) Gecko/20080705 Firefox/3.0 Kapiko/3.0",

"Mozilla/5.0 (X11; Linux i686; U;) Gecko/20070322 Kazehakase/0.4.5",

"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3192.0 Safari/537.36Name"

] DOWNLOADER_MIDDLEWARES = {

'chinaarea.middlewares.UserAgentMiddleware': 543,

}

爬取天气网

编写item

import scrapy class ChinaareaItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

pass # 城市

city = scrapy.Field()

# 日期

date = scrapy.Field()

# 空气质量指数

aqi = scrapy.Field()

# 空气质量等级

level = scrapy.Field()

# pm2.5

pm2_5 = scrapy.Field()

# pm10

pm10 = scrapy.Field()

# 二氧化硫

so2 = scrapy.Field()

# 一氧化碳

co = scrapy.Field()

# 二氧化氮

no2 = scrapy.Field()

# 臭氧

o3 = scrapy.Field()

# 数据源

source = scrapy.Field()

# utctime

utc_time = scrapy.Field()

编写spider

from chinaarea.items import ChinaareaItem

class AirSpider(scrapy.Spider):

name = 'airs'

allowed_domains = ['aqistudy.cn']

base_url = "https://www.aqistudy.cn/historydata/"

start_urls = [base_url] def parse(self, response):

print("正在爬取城市信息...")

url_list = response.xpath('//div[@class="all"]/div[@class="bottom"]//a/@href').extract()[10:11]

city_list = response.xpath('//div[@class="all"]/div[@class="bottom"]//a/text()').extract()[10:11]

for city, url in zip(city_list, url_list):

link = self.base_url + url

yield scrapy.Request(url=link, callback=self.parse_month, meta={"city":city}) def parse_month(self, response):

print("正在爬取城市月份...")

url_list = response.xpath("//tr/td/a/@href").extract()[0:2]

for url in url_list:

url = self.base_url + url

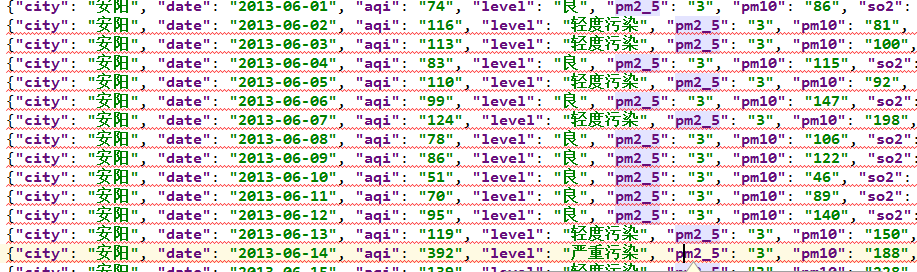

yield scrapy.Request(url=url, meta={"city":response.meta['city']}, callback=self.parse_day) def parse_day(self, response):

print("爬取最终数据...")

node_list = response.xpath('//tr')

node_list.pop(0) for node in node_list:

item = ChinaareaItem()

item['city'] = response.meta['city']

item['date'] = node.xpath('./td[1]/text()').extract_first()

item['aqi'] = node.xpath('./td[2]/text()').extract_first()

item['level'] = node.xpath('./td[3]//text()').extract_first()

item['pm2_5'] = node.xpath('./td[4]/text()').extract_first()

item['pm10'] = node.xpath('./td[5]/text()').extract_first()

item['so2'] = node.xpath('./td[6]/text()').extract_first()

item['co'] = node.xpath('./td[7]/text()').extract_first()

item['no2'] = node.xpath('./td[8]/text()').extract_first()

item['o3'] = node.xpath('./td[9 ]/text()').extract_first()

yield item

编写Middleware

from selenium import webdriver

import time

import scrapy class SeleniumMiddleware(object):

def process_request(self, request, spider):

self.driver = webdriver.Chrome()

if request.url != "https://www.aqistudy.cn/historydata/":

self.driver.get(request.url)

time.sleep(2)

html = self.driver.page_source

self.driver.quit()

return scrapy.http.HtmlResponse(url=request.url, body=html, encoding="utf-8", request=request)

编写pipeline

import json

from datetime import datetime class ChinaareaPipeline(object): def process_item(self, item, spider):

item['source'] = spider.name

item['utc_time'] = str(datetime.utcnow()) return item class AreaJsonPipeline(object):

def open_spider(self, spider):

self.file = open("area.json", "w") def process_item(self, item, spider):

content = json.dumps(dict(item), ensure_ascii=False) + "\n"

self.file.write(content)

return item def close_spider(self, spider):

self.file.close()

.设置setting

'chinaarea.middlewares.SeleiumMiddleware': 200,

ITEM_PIPELINES = {

'chinaarea.pipelines.ChinaareaPipeline':200,

'chinaarea.pipelines.AreaJsonPipeline': 300,

}

Scrapy-下载中间件的更多相关文章

- Scrapy下载中间件的优先级(神踏马值越小优先级越高)

自从之前看的一篇讲Scrapy下载中间件的文章后,一直认为设置里下载中间件的优先级数值越小,越优先,最近要抓的网站反爬增强了,所以需要使用代理ip,但是由于使用的是免费代理以至于经常失效,需要对失效的 ...

- scrapy下载中间件,UA池和代理池

一.下载中间件 框架图: 下载中间件(Downloader Middlewares) 位于scrapy引擎和下载器之间的一层组件. - 作用: (1)引擎将请求传递给下载器过程中, 下载中间件可以对请 ...

- scrapy下载中间件结合selenium抓取全国空气质量检测数据

1.所需知识补充 1.下载中间件常用函数 process_request(self, request, spider): 当每个request通过下载中间件是,该方法被调用 process_reque ...

- 爬虫(十四):scrapy下载中间件

下载器中间件是介于Scrapy的request/response处理的钩子框架,是用于全局修改Scrapy request和response的一个轻量.底层的系统. 激活Downloader Midd ...

- 爬虫系列---scrapy post请求、框架组件和下载中间件+boss直聘爬取

一 Post 请求 在爬虫文件中重写父类的start_requests(self)方法 父类方法源码(Request): def start_requests(self): for url in se ...

- python 全栈开发,Day138(scrapy框架的下载中间件,settings配置)

昨日内容拾遗 打开昨天写的DianShang项目,查看items.py class AmazonItem(scrapy.Item): name = scrapy.Field() # 商品名 price ...

- Python爬虫框架Scrapy实例(四)下载中间件设置

还是豆瓣top250爬虫的例子,添加下载中间件,主要是设置动态Uesr-Agent和代理IP Scrapy代理IP.Uesr-Agent的切换都是通过DOWNLOADER_MIDDLEWARES进行控 ...

- Scrapy——5 下载中间件常用函数、scrapy怎么对接selenium、常用的Setting内置设置有哪些

Scrapy——5 下载中间件常用的函数 Scrapy怎样对接selenium 常用的setting内置设置 对接selenium实战 (Downloader Middleware)下载中间件常用函数 ...

- scrapy基础知识之下载中间件使用案例:

1. 创建middlewares.py文件. Scrapy代理IP.Uesr-Agent的切换都是通过DOWNLOADER_MIDDLEWARES进行控制,我们在settings.py同级目录下创建m ...

- Scrapy的下载中间件

下载中间件 简介 下载器,无法执行js代码,本身不支持代理 下载中间件用来hooks进Scrapy的request/response处理过程的框架,一个轻量级的底层系统,用来全局修改scrapy的re ...

随机推荐

- KBMMW 的日志管理器

kbmmw 4.82 最大的新特性就是增加了 日志管理器. 新的日志管理器实现了不同类型的日志.断言.异常处理.计时等功能. 首先.引用kbmMWLog.pas 单元后,系统就默认生成一个IkbmMW ...

- 一张图让你学会Python

有编程基础的人一看就可以了解 Python 的用法了.真正的 30 分钟上手.国外一高手画的,现把它翻译成中文,入门超简单python入门神图 *单击放大

- Cisco ASA(8.4)端口映射设定(ASDM)

1.进入到Configuration→firewall→NAT Rules画面. 2.点“services”添加服务端口,此案例添加TCP 1443和UDP 1443端口映射 3.添加“Network ...

- K - Strange Country II 暴力dfs判断有向图是否连通//lxm

You want to visit a strange country. There are n cities in the country. Cities are numbered from 1 t ...

- asp.net mvc 快捷下拉列表

各种表单中可能经常会遇到使用各种下拉列表的地方, 有些数据是从数据库来的, 有些则是固定数值, 为了方便, 快速的构造一个可以保持状态的下拉列表, 就出现了下面的方法 2分钟构思的代码, 比较粗糙, ...

- I.MX6 HUAWEI MU609 3G porting

/*************************************************************************** * I.MX6 HUAWEI MU609 3G ...

- 怎样取消老毛桃软件赞助商---只需在输入框中输入老毛桃官网网址“laomaotao.org”

来源:www.laomaotao.org 时间:2015-01-29 在众多网友和赞助商的支持下,迄今为止,老毛桃u盘启动盘制作工具已经推出了多个版本.如果有用户希望取消显示老毛桃软件中的赞助商,那不 ...

- BZOJ4897: [Thu Summer Camp2016]成绩单【DP of DP】

Description 期末考试结束了,班主任L老师要将成绩单分发到每位同学手中.L老师共有n份成绩单,按照编号从1到n的顺序叠 放在桌子上,其中编号为i的成绩单分数为w_i.成绩单是按照批次发放的. ...

- The Alphabet Sticker

题目大意:给你一串字符串,其中有一部分未知,用'?'表示. 现在定义一种合法的Sticker,比如"aabcc","ccccab".即所有相同的字母要在一起才是 ...

- 状压dp终极篇(状态转移的思想)

状压dp是将每种状态都压缩成用一个二进制串,然后利用位运算进行操作的dp,而凡是dp都需要进行状态转移 对于简单的dp问题只需要一个二维数组dp[ i ][ j ]就能解决 具体操作为首先把状态压缩为 ...