saltstack实现自动化扩容

[root@node1 src]# tar xf etcd-v3.2.9-linux-amd64.tar.gz

cd etcd-v3.2.9-linux-amd64

cp etcd etcdctl /usr/local/bin/

然后开启etcd集群:

1、首先创建数据目录:mkdir /data/etcd -p

2、开启服务:

nohup etcd --name auto_scale --data-dir /data/etcd/ --listen-peer-urls http://192.168.44.134:2380,http://192.168.44.134:7001 --listen-client-urls http://192.168.44.134:2379,http://192.168.44.134:4001 --advertise-client-urls http://192.168.44.134:2379,http://192.168.44.134:4001 &

[root@node1 ~]# netstat -tunlp|grep etcd

tcp 0 0 192.168.44.134:2379 0.0.0.0:* LISTEN 52094/etcd

tcp 0 0 192.168.44.134:2380 0.0.0.0:* LISTEN 52094/etcd

tcp 0 0 192.168.44.134:7001 0.0.0.0:* LISTEN 52094/etcd

tcp 0 0 192.168.44.134:4001 0.0.0.0:* LISTEN 52094/etcd

1、创建一个key/value

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/key1 -XPUT -d value="Hello world"

2、获取创建的key/value

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www1

3、删除创建的key/value

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/key1 -XDELETE

或者将上面的输出结果以json格式输出:

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www1|python -m json.tool

{

"action": "get",

"node": {

"createdIndex": 9,

"key": "/salt/haproxy/backend_www/www1",

"modifiedIndex": 9,

"value": "192.168.44.134:8080"

}

}

将etcd配置在saltstack中,结合使用:

1、首先需要安装依赖包:

####config etcd

my_etcd_config:

etcd.host: 192.168.44.134

etcd.port: 4001 ext_pillar:

- etcd: my_etcd_config root=/salt/haproxy

3、重启master

[root@node1 ~]# /etc/init.d/salt-master restart

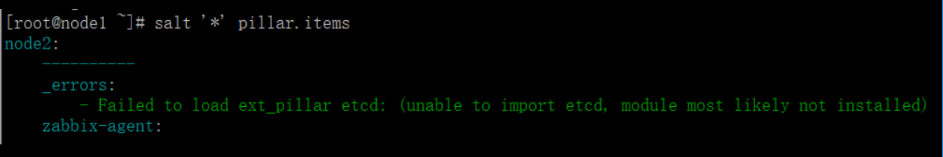

结尾一直报错:

查找原因发现salt是python2.7安装的,而etcd是python2.6安装的,所以一直调用出错:

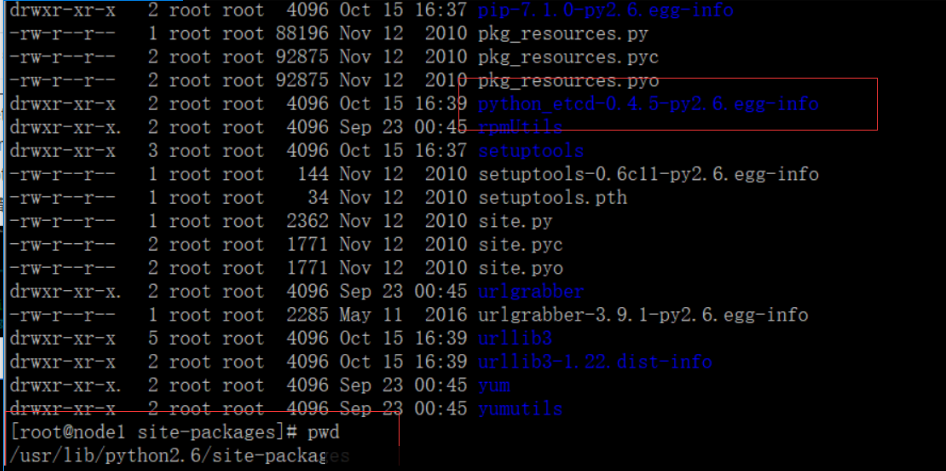

于是使用python2.7安装一遍etcd服务:

1、mv /usr/bin/python /usr/bin/python.bak

2、ln -s /usr/bin/python2.7 /usr/bin/python

3、修改/usr/bin/yum第一行为:#!/usr/bin/python2.6

4、wget https://pypi.python.org/packages/2.7/s/setuptools/setuptools-0.6c11-py2.7.egg --no-check-certificate

5、chmod +x setuptools-0.6c11-py2.7.egg

6、sh setuptools-0.6c11-py2.7.egg

7、wget https://pypi.python.org/packages/source/p/pip/pip-1.3.1.tar.gz --no-check-certificate

8、tar xf pip-1.3.1.tar.gz

9、cd pip-1.3.1

10、python setup.py install

11、/usr/bin/pip-2.7 install python-etcd

试着使用python2.7导入模块etcd,报错如下:

解决办法:

https://pypi.python.org/pypi/backports.ssl_match_hostname

tar xf backports.ssl_match_hostname-3.5.0.1.tar.gz

cd backports.ssl_match_hostname-3.5.0.1

python setup.py build

python setup.py install

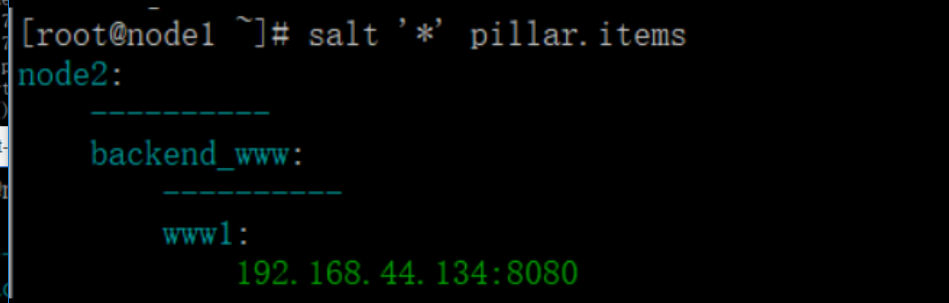

然后重启salt-master服务,查看设置的pillar:

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www1 -XDELETE

{"action":"delete","node":{"key":"/salt/haproxy/backend_www/www1","modifiedIndex":12,"createdIndex":11},"prevNode":{"key":"/salt/haproxy/backend_www/www1","value":"192.168.44.134:8080","modifiedIndex":11,"createdIndex":11}}

[root@node1 ~]# salt '*' pillar.items

node2:

----------

backend_www:

----------

zabbix-agent:

----------

Zabbix_Server:

192.168.44.134

zabbix-agent-host:

----------

zabbix_host:

node2

现在通过添加etcd的key来增加haproxy后端的节点服务器:

curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www1 -XPUT -d value="192.168.44.134:8081"|python -m json.tool

2、查看pillar

[root@node1 ~]# salt '*' pillar.items

node1:

----------

backend_www:

----------

www1:

192.168.44.134:8081

3、修改haproxy配置文件:vim /srv/salt/prod/cluster/files/haproxy-outside.cfg

{% for www,www_ip in pillar.backend_www.iteritems() %}

server {{ www }} {{ www_ip }} check inter 1000

{% endfor %}

4、修改haproxy状态配置文件:vim /srv/salt/prod/cluster/haproxy-outside.sls

haproxy-service:

file.managed:

- name: /etc/haproxy/haproxy.cfg

- source: salt://cluster/files/haproxy-outside.cfg

- user: root

- group: root

- mode: 644

- template: jinja 新增一行,使用jinja模板,使用变量

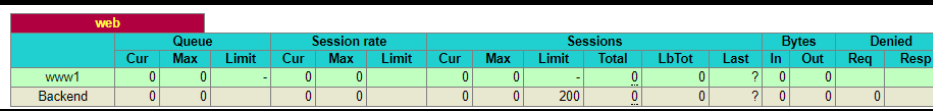

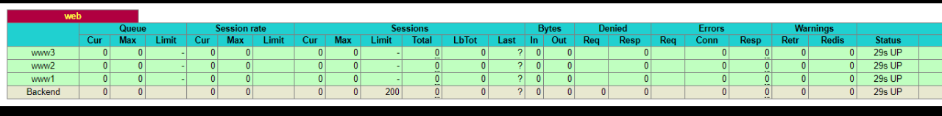

测试并验证:

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www2 -XPUT -d value="192.168.44.134:8080"|python -m json.tool

{

"action": "set",

"node": {

"createdIndex": 14,

"key": "/salt/haproxy/backend_www/www2",

"modifiedIndex": 14,

"value": "192.168.44.134:8080"

}

}

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www3 -XPUT -d value="192.168.44.135:8080"|python -m json.tool

{

"action": "set",

"node": {

"createdIndex": 15,

"key": "/salt/haproxy/backend_www/www3",

"modifiedIndex": 15,

"value": "192.168.44.135:8080"

}

}

查看设置的pillar:

[root@node1 ~]# salt '*' pillar.items

node2:

----------

backend_www:

----------

www1:

192.168.44.134:8081

www2:

192.168.44.134:8080

www3:

192.168.44.135:8080

执行salt状态配置文件:

saltstack实现自动化扩容的更多相关文章

- saltstack自动化运维系列11基于etcd的saltstack的自动化扩容

saltstack自动化运维系列11基于etcd的saltstack的自动化扩容 自动化运维-基于etcd加saltstack的自动化扩容# tar -xf etcd-v2.2.1-linux-amd ...

- Saltstack自动化扩容

一. etcd服务的安装和使用 1.安装etcd应用: wget https://github.com/coreos/etcd/releases/download/v2.2.5/etcd-v2.2.5 ...

- saltstack之自动化运维

引入 简介 saltstack是由thomas Hatch于2011年创建的一个开源项目,设计初衷是为了实现一个快速的远程执行系统. 早期运维人员会根据自己的生产环境来写特定脚本完成大量重复性工作,这 ...

- 学习saltstack (五)

Saltstack介绍 Salt三种运行方式 1.local本地运行2.Master/Minion3.Salt ssh Salt的三大功能 a.远程执行b.配置管理(状态管理)c.云管理:阿里云,aw ...

- Redis Cluster 自动化安装,扩容和缩容

Redis Cluster 自动化安装,扩容和缩容 之前写过一篇基于python的redis集群自动化安装的实现,基于纯命令的集群实现还是相当繁琐的,因此官方提供了redis-trib.rb这个工具虽 ...

- k8s Pod 扩容和缩容

在生产环境下,在面临服务需要扩容的场景时,可以使用Deployment/RC的Scale机制来实现.Kubernetes支持对Pod的手动扩容和自动扩容. 手动扩容缩容 通过执行扩容命令,对某个dep ...

- 基于Saltstack、Artifactory打造传统模式下持续部署平台

一.持续部署 1. 现状 由于没有建立标准的持续部署流程,导致了版本管理混乱,制品管理混乱,上线持续时间长,上线测试覆盖不全面,业务流量上升后故障较多,排查复杂.运维.测试.开发人员每次版本迭代的时候 ...

- 运维知识体系v0.5

http://www.90qj.com/?post=318http://ixdba.blog.51cto.com/2895551/1751377 运维知识体系v0.5-(运维社区-赵班长出品,欢迎 ...

- Docker系列一之基础快速入门企业实战

1.1什么是LXC LXC为Linux Container的简写.Linux Container容器是一种内核虚拟化技术,可以提供轻量级的虚拟化,以便隔离进程和资源,而且不需要提供指令解释机制以及全虚 ...

随机推荐

- 【BZOJ4883】[Lydsy2017年5月月赛]棋盘上的守卫 KM算法

[BZOJ4883][Lydsy2017年5月月赛]棋盘上的守卫 Description 在一个n*m的棋盘上要放置若干个守卫.对于n行来说,每行必须恰好放置一个横向守卫:同理对于m列来说,每列 必须 ...

- 04.Curator Leader选举

在分布式计算中,leader election是很重要的一个功能,这个选举过程是这样子的:指派一个进程作为组织者,将任务分发给各节点.在任务开始前,哪个节点都不知道谁是leader或者coor ...

- .net应用程序安装部署时异常 Error 1001. 在初始化安装时发生异常 System.BadImageFormatException:未能加载文件或程序集 的解决办法【成功解决】

采用.net 4.0框架开发的一个桌面应用程序在某学校的一体机(Windows7的32位操作系统)上做安装部署时抛出异常,安装程序回滚,多次尝试仍不成功. Error 1001. 在初始化安装时发生异 ...

- http请求及json发送与解析 post string

golang http请求及json流解析 - 长风v持成的博客 - CSDN博客 https://blog.csdn.net/u011677067/article/details/80852158 ...

- pandas.read_csv() 部分参数解释

read_csv()所有参数 pandas.read_csv( filepath_or_buffer, sep=',', delimiter=None, header='infer', names=N ...

- Ubuntu 常见错误--Could not get lock

问题产生的原因:另外一个程序正在运行,导致资源被锁不可用.而导致资源被锁的原因可能是上次运行安装或更新时没有正常完成,进而出现此状况 解决问题的办法:sudo rm /var/cache/apt/ar ...

- java 多线程 day07 多线程共享数据

/** * Created by chengtao on 17/12/3. * 多个线程 如何共享数据? * 常见实例:多个窗口同时售卖火车票 */public class Thread0701_Mu ...

- CCF 201312-4 有趣的数[dp][难]

问题描述 试题编号: 201312-4 试题名称: 有趣的数 时间限制: 1.0s 内存限制: 256.0MB 问题描述: 问题描述 我们把一个数称为有趣的,当且仅当: 1. 它的数字只包含0, 1, ...

- CentOS 7中使用iptables

1.关闭firewall systemctl stop firewalld.service #停止firewall systemctl disable firewalld.service #禁止fir ...

- 【MYSQL】主从常见问题运维

参见Mysql主从常见错误,http://hzcsky.blog.51cto.com/1560073/479476