kubernetes进阶(三)服务发现-coredns

服务发现,说白了就是服务(应用)之间相互定位的过程。

服务发现需要解决的问题:

1、服务动态性强--容器在k8s中ip变化或迁移

2、更新发布频繁--版本迭代快

3、支持自动伸缩--大促或流量高峰

我们为了解决pod地址变化的问题,我们之前部署了service资源,将pod地址通过service资源暴露的固定地址,来解决以上问题,

那么,如何解决service资源名称和service资源暴露出来的集群网络IP做自动的对应呢,从而达到服务的自动发现呢?

在k8s中,coredns就是为了解决以上问题。

从coredns开始,我们采用向k8s中交付容器的方式,来部署服务,并且使用声明式的方式,来部署服务。

首先在hdss7-200上创建一个nginx虚拟主机,用来获取资源配置清单:

vi /etc/nginx/conf.d/k8s-yaml.od.com.conf

server {

listen 80;

server_name k8s-yaml.od.com;

location / {

autoindex on;

default_type text/plain;

root /data/k8s-yaml;

}

}

# mkdir -p /data/k8s-yaml/coredns

# nginx -t

# nginx -s reload

添加域名解析:hdss-11上

# vi /var/named/od.com.zone

在最后添加一条解析记录 $ORIGIN od.com.

$TTL 600 ; 10 minutes

@ IN SOA dns.od.com. dnsadmin.od.com. (

2019061803 ; serial

10800 ; refresh (3 hours)

900 ; retry (15 minutes)

604800 ; expire (1 week)

86400 ; minimum (1 day)

)

NS dns.od.com.

$TTL 60 ; 1 minute

dns A 10.4.7.11

harbor A 10.4.7.200

k8s-yaml A 10.4.7.200

# systemctl restart named

coredns github地址:

# cd /data/k8s-yaml/coredns

# docker pull docker.io/coredns/coredns:1.6.1

# docker tag c0f6e815079e harbor.od.com/public/coredns:v1.6.1

# docker push harbor.od.com/public/coredns:v1.6.1

然后编辑资源配置清单:可以从官网上参考资源配置清单

1.rbac.yaml--拿到集群相关权限

# vi rbac.yaml

apiVersion: v1

kind: ServiceAccount

metadata:

name: coredns

namespace: kube-system

labels:

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

labels:

kubernetes.io/bootstrapping: rbac-defaults

addonmanager.kubernetes.io/mode: Reconcile

name: system:coredns

rules:

- apiGroups:

- ""

resources:

- endpoints

- services

- pods

- namespaces

verbs:

- list

- watch

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

annotations:

rbac.authorization.kubernetes.io/autoupdate: "true"

labels:

kubernetes.io/bootstrapping: rbac-defaults

addonmanager.kubernetes.io/mode: EnsureExists

name: system:coredns

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: system:coredns

subjects:

- kind: ServiceAccount

name: coredns

namespace: kube-system

2.cm.yaml--configmap 对集群的相关配置

# vi cm.yaml

apiVersion: v1

kind: ConfigMap

metadata:

name: coredns

namespace: kube-system

data:

Corefile: |

.:53 {

errors

log

health

ready

kubernetes cluster.local 192.168.0.0/16 #service资源cluster地址

forward . 10.4.7.11 #上级DNS地址

cache 30

loop

reload

loadbalance

}

3.dp.yaml---pod控制器

# vi dp.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: coredns

namespace: kube-system

labels:

k8s-app: coredns

kubernetes.io/name: "CoreDNS"

spec:

replicas: 1

selector:

matchLabels:

k8s-app: coredns

template:

metadata:

labels:

k8s-app: coredns

spec:

priorityClassName: system-cluster-critical

serviceAccountName: coredns

containers:

- name: coredns

image: harbor.od.com/public/coredns:v1.6.1

args:

- -conf

- /etc/coredns/Corefile

volumeMounts:

- name: config-volume

mountPath: /etc/coredns

ports:

- containerPort: 53

name: dns

protocol: UDP

- containerPort: 53

name: dns-tcp

protocol: TCP

- containerPort: 9153

name: metrics

protocol: TCP

livenessProbe:

httpGet:

path: /health

port: 8080

scheme: HTTP

initialDelaySeconds: 60

timeoutSeconds: 5

successThreshold: 1

failureThreshold: 5

dnsPolicy: Default

volumes:

- name: config-volume

configMap:

name: coredns

items:

- key: Corefile

path: Corefile

4.svc.yaml---service资源

# vi svc.yaml

apiVersion: v1

kind: Service

metadata:

name: coredns

namespace: kube-system

labels:

k8s-app: coredns

kubernetes.io/cluster-service: "true"

kubernetes.io/name: "CoreDNS"

spec:

selector:

k8s-app: coredns

clusterIP: 192.168.0.2

ports:

- name: dns

port: 53

protocol: UDP

- name: dns-tcp

port: 53

- name: metrics

port: 9153

protocol: TCP

然后使用http请求资源配置清单yaml的方式来创建资源:在任意node节点上创建

# kubectl create -f http://k8s-yaml.od.com/coredns/rbac.yaml

# kubectl create -f http://k8s-yaml.od.com/coredns/cm.yaml

# kubectl create -f http://k8s-yaml.od.com/coredns/dp.yaml

# kubectl create -f http://k8s-yaml.od.com/coredns/svc.yaml

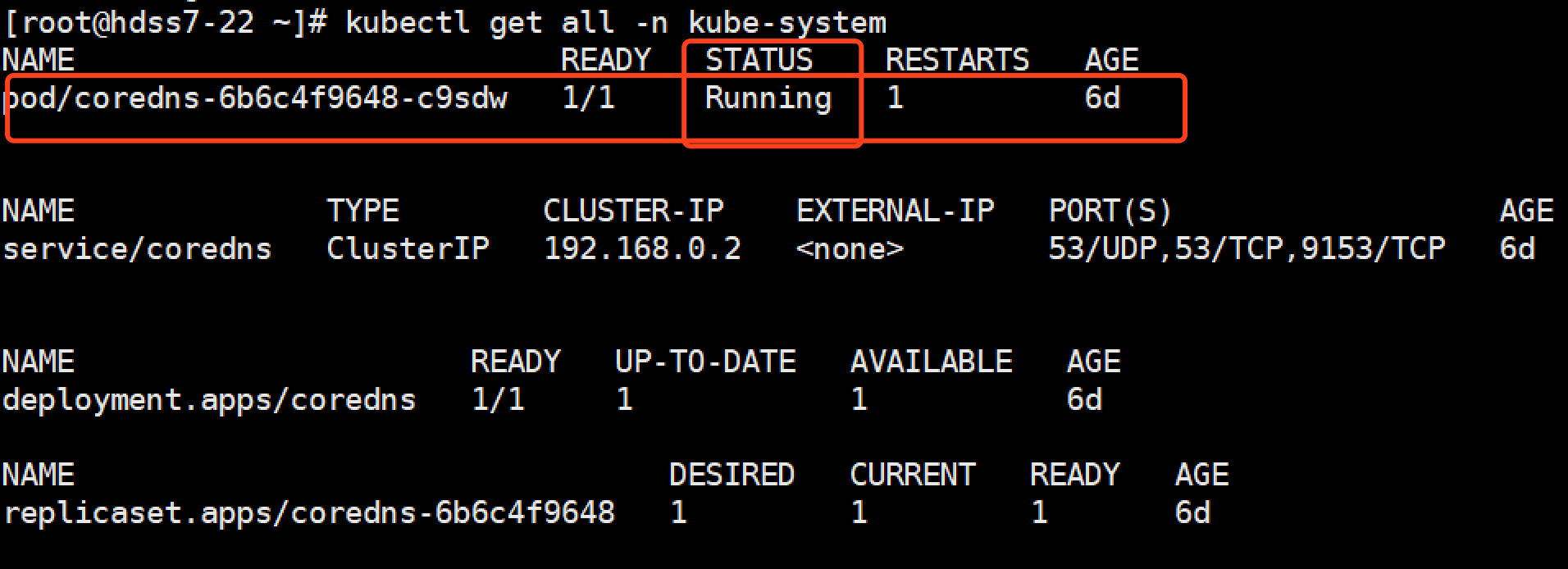

查看运行情况:

# kubectl get all -n kube-system

查看coredns的cluster ip:

# kubectl get svc -o wide -n kube-system

测试coredns:

# dig -t A www.baidu.com @192.168.0.2 +short

看到已经可以解析到百度。

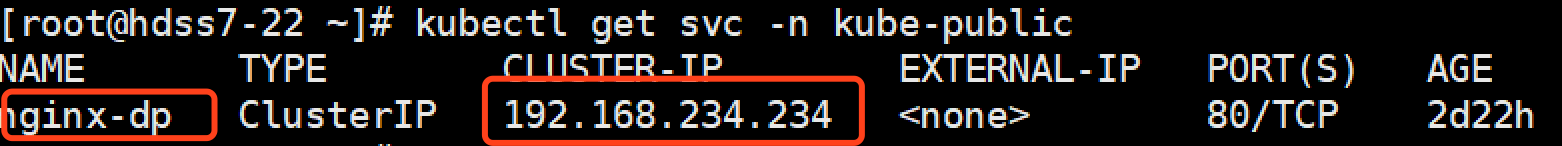

测试coredns解析service资源名称,首先查看kube-public下是否有service资源,如果没有,创建一个,使用kubectl expose nginx-dp --port=80 -n kube-public

# kubectl expose nginx-dp --port=80 -n kube-public

测试:使用coredns测试解析,需要使用SQDN规则

# dig -t A nginx-dp.kube-public.svc.cluster.local. @192.168.0.2 +short

可以看到我们没有手动添加任何解析记录,我们nginx-dp的service资源的IP,已经被解析了:

那么为什么呢?

推荐大家了解一下coredns都做了什么:Kubernetes内部域名解析原理、弊端及优化方式

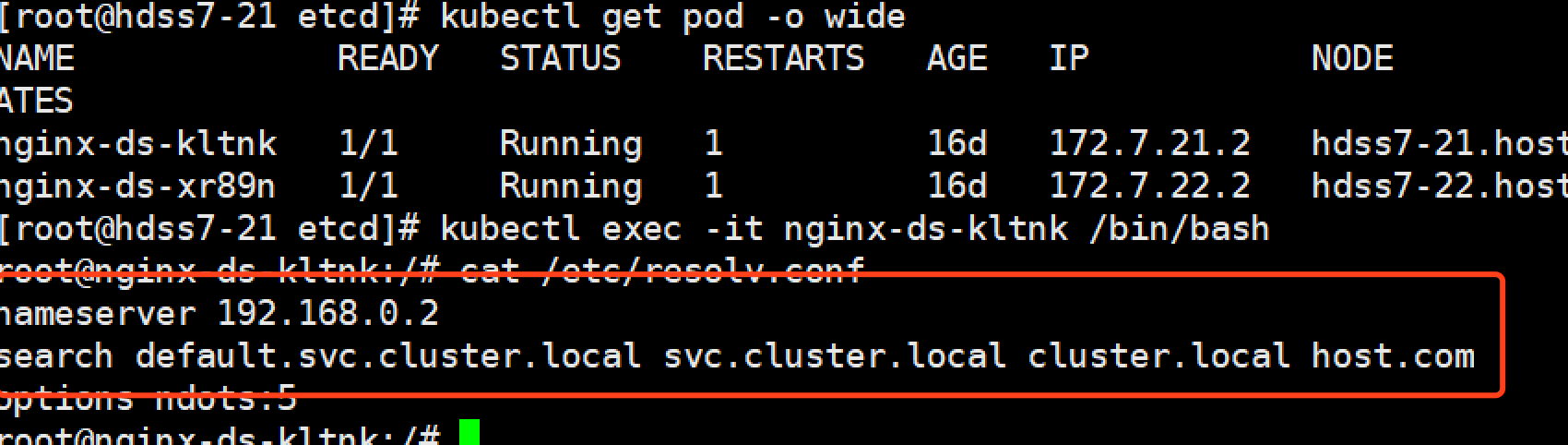

大家可以看到,当我进入到pod内部以后,我们会发现我们的dns地址是我们的coredns地址,以及搜索域:

kubernetes进阶(三)服务发现-coredns的更多相关文章

- 从零开始入门 | Kubernetes 中的服务发现与负载均衡

作者 | 阿里巴巴技术专家 溪恒 一.需求来源 为什么需要服务发现 在 K8s 集群里面会通过 pod 去部署应用,与传统的应用部署不同,传统应用部署在给定的机器上面去部署,我们知道怎么去调用别的机 ...

- Kubernetes 中的服务发现与负载均衡

原文:https://www.infoq.cn/article/rEzx9X598W60svbli9aK (本文转载自阿里巴巴云原生微信公众号(ID:Alicloudnative)) 一.需求来源 为 ...

- Prometheus在Kubernetes下的服务发现机制

Prometheus作为容器监控领域的事实标准,随着以Kubernetes为核心的云原生热潮的兴起,已经得到了广泛的应用部署.灵活的服务发现机制是Prometheus和Kubernetes两者得以连接 ...

- kubernetes 之dns 服务发现

1.在每个节点上面导入如下镜像 [root@node1 DNS]# lltotal 59816-rw-r--r--. 1 root root 8603136 Nov 25 18:13 execheal ...

- Istio技术与实践02:源码解析之Istio on Kubernetes 统一服务发现

前言 文章Istio技术与实践01: 源码解析之Pilot多云平台服务发现机制结合Pilot的代码实现介绍了Istio的抽象服务模型和基于该模型的数据结构定义,了解到Istio上只是定义的服务发现的接 ...

- Openstack+Kubernetes+Docker微服务实践之路--RPC

重点来了,本文全面阐述一下我们的RPC是怎么实现并如何使用的,跟Kubernetes和Openstack怎么结合. 在选型一文中说到我们选定的RPC框架是Apache Thrift,它的用法是在Ma ...

- 服务发现和注册和Eureka

一 Spring Cloud特点 # 约定优于配置 # 开箱即用,快速启动 # 适用于各种环境,可以部署在PC server或者 云环境 # 轻量级的组件 # 组件的支持很丰富,功能齐全 # 选型中立 ...

- Kubernetes 服务自动发现CoreDNS

前言 Service服务,是一个概念,逻辑通过selector标签代理指定后端pod.众所周知,pod生命周期短,状态不稳定,pod错误异常后新生成的Pod IP会发生变化,之前Pod的访问方式均不可 ...

- 十一章 Kubernetes的服务发现插件--coredns

1.前言 简单来说,服务发现就是服务(应用)之间相互定位的过程: 服务发现并非云计算时代独有的,传统的单体架构时代也会用到,以下应用场景更加需要服务发现: 服务(应用)的动态性强: 服务(应用)更新发 ...

随机推荐

- 大文件上传FTP

需求 将本地大文件通过浏览器上传到FTP服务器. 原有方法 将本地文件整个上传到浏览器,然后发送到node服务器,最后由node发送到FTP服务器. 存在问题 浏览器缓存有限且上传速率受网速影响,当文 ...

- LR参数

一.LR函数 : lr_start_transaction: 为性能分析标记事务的开始 lr_end_transaction: 为性能分析标记事务的结束:事务名称与事务开始时保持一致 lr_ren ...

- oracle常见进度查询脚本

1.查看索引创建进度 /* Formatted on 2019/8/20 下午 05:08:25 (QP5 v5.163.1008.3004) */ SELECT SID, DECODE (total ...

- 解决maven中某些依赖无法下载,手动安装Maven依赖

<!--先下载jar包,然后在仓库中手动安装,下面是遇到的两个例子--> <!--第一个--> mvn install:install-file -Dfile=D:\kaptc ...

- 我在华为OD的275天

目录 0 - 时间线 1 - 为什么会去华为 OD 2 - 华为 OD 的工作内容 3 - OD 与华为自有员工的对比 4 - 那,到底要不要去华为 OD? 5 - 网传的 OD 转华为正编,真的假的 ...

- STP 根桥、根端口、指定端口是如何选举的

学习HCIA过程中,对交换机的根桥.跟端口以及指定端口选举有些迷糊,也度娘了一番,总觉得一部分人解释的不够全面精细.通过仔细研究最终有了自己的理解,分享给大家,如果纰漏,欢迎指正. STP收敛过程: ...

- SpringMVC听课笔记(五:处理模型数据)

1. Spring MVC 提供了以下几种途径输出数据模型 -- ModelAndView: 处理方法返回值类型为ModelAndView 时,方法体即可通过该对象添加模型数据 -- Map及Mode ...

- 分布式缓存 — MongoDB

--- 数据库管理系统 数据库管理系统主要分为俩大类:RDBMS.NOSQL.在个人电脑.大型计算机和主机上应用最广泛的数据库管理系统是关系型DBMS.NoSQL是对不同于传统的关系数据库的数据库管理 ...

- REST以及RESTful

java作为一门后端语言,其厉害之处在于web,大家比较熟知的各种网络应用,java都能做,那么在这个移动优先的时代,如何继续发挥java的强大呢.通常是让java作为一个app的服务端,为app客户 ...

- (三)集成 JavaMail ,实现异步发送邮件

集成 JavaMail ,实现异步发送邮件 1.JavaMail的核心API 1.1 API功能图解 1.2 API说明 1.2.1 Message 类: 1.2.2 Transport 类 1.2. ...