Scrapy框架 之某网站产品采集案例

一、创建项目

第一步:scrapy startproject boyuan

第二步:cd boyuan

scrapy genspider product -t crawl boyuan.com

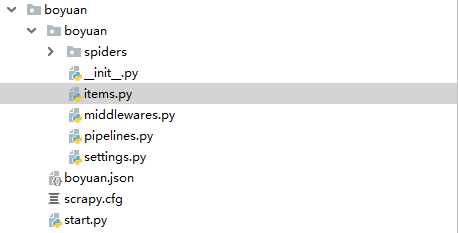

如图:

二、代码编写

1、item.py

# -*- coding: utf-8 -*- # Define here the models for your scraped items

#

# See documentation in:

# https://doc.scrapy.org/en/latest/topics/items.html import scrapy class BoyuanItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

name = scrapy.Field()

address = scrapy.Field()

company = scrapy.Field()

img = scrapy.Field()

time = scrapy.Field()

2、product.py爬虫文件

# -*- coding: utf-8 -*-

import scrapy

from scrapy.spiders import Rule, CrawlSpider

from scrapy.linkextractors import LinkExtractor

from ..items import BoyuanItem class ProductSpider(CrawlSpider):

name = 'product'

allowed_domains = ['boyuan.com']

offset = 1

url = "http://www.boyuan.com/sell/?page={0}"

start_urls = [url.format(str(offset))] page_link = LinkExtractor(allow=("\?page=\d+")) rules = [

Rule(page_link, callback="parse_content", follow=True)

] def parse_content(self, response):

for each in response.xpath("//div[@class='list']//tr"):

item = BoyuanItem()

item['name'] = each.xpath("./td[4]//strong/text()").extract()[0]

item['company'] = each.xpath("./td[4]//li[4]/a/text()").extract()[0]

address = each.xpath("./td[4]//li[3]/text()").extract()[0]

item['address'] = str(address).strip("[").strip("]")

time = each.xpath("./td[4]//li[3]/span/text()").extract()[0]

item['time'] = str(time).strip()

item['img'] = each.xpath("./td[2]//img/@original").extract()[0]

yield item

3、pipelines.py 管道文件

# -*- coding: utf-8 -*- # Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://doc.scrapy.org/en/latest/topics/item-pipeline.html

import json

import pymongo

from scrapy.conf import settings class BoyuanPipeline(object): def __init__(self):

host = settings.get("MONGO_HOST")

port = settings.get("MONGO_PORT")

db_name = settings.get("MONGO_DB")

collection = settings.get("MONGO_COLLECTION")

self.client = pymongo.MongoClient(host=host, port=int(port))

db = self.client.get_database(db_name)

if collection not in db.list_collection_names():

db.create_collection(collection)

self.col = db[collection] def process_item(self, item, spider):

# 保存到mongodb中

self.col.insert(dict(item))

return item def close_spider(self, spider):

self.client.close()

3、settings.py 配置文件

# mongodb数据库参数

MONGO_HOST = "localhost"

MONGO_PORT = ""

MONGO_DB = "boyuan"

MONGO_COLLECTION = "product"

4、start.py 启动文件

from scrapy import cmdline if __name__ == '__main__':

cmdline.execute("scrapy crawl product".split())

采集结果如图:

Scrapy框架 之某网站产品采集案例的更多相关文章

- Python 之scrapy框架58同城招聘爬取案例

一.项目目录结构: 代码如下: # -*- coding: utf-8 -*- # Define here the models for your scraped items # # See docu ...

- scrapy框架的解析

1,scrapy框架的官网:https://scrapy.org/ 什么是scrapy框架: scrapy 是一个为了爬取网站数据,提取结构性数据而编写的应用内框架,非常出名,所谓框架就是一个已经继承 ...

- Scrapy框架——CrawlSpider类爬虫案例

Scrapy--CrawlSpider Scrapy框架中分两类爬虫,Spider类和CrawlSpider类. 此案例采用的是CrawlSpider类实现爬虫. 它是Spider的派生类,Spide ...

- Scrapy框架——CrawlSpider爬取某招聘信息网站

CrawlSpider Scrapy框架中分两类爬虫,Spider类和CrawlSpider类. 它是Spider的派生类,Spider类的设计原则是只爬取start_url列表中的网页, 而Craw ...

- 爬虫(十四):Scrapy框架(一) 初识Scrapy、第一个案例

1. Scrapy框架 Scrapy功能非常强大,爬取效率高,相关扩展组件多,可配置和可扩展程度非常高,它几乎可以应对所有反爬网站,是目前Python中使用最广泛的爬虫框架. 1.1 Scrapy介绍 ...

- scrapy框架爬取糗妹妹网站妹子图分类的所有图片

爬取所有图片,一个页面的图片建一个文件夹.难点,图片中有不少.gif图片,需要重写下载规则, 创建scrapy项目 scrapy startproject qiumeimei 创建爬虫应用 cd qi ...

- Python爬虫开发【第1篇】【Scrapy框架】

Scrapy 框架介绍 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架. Srapy框架,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内容以 ...

- python爬虫scrapy框架

Scrapy 框架 关注公众号"轻松学编程"了解更多. 一.简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量 ...

- selenium模块使用详解、打码平台使用、xpath使用、使用selenium爬取京东商品信息、scrapy框架介绍与安装

今日内容概要 selenium的使用 打码平台使用 xpath使用 爬取京东商品信息 scrapy 介绍和安装 内容详细 1.selenium模块的使用 # 之前咱们学requests,可以发送htt ...

随机推荐

- KLT 光流

一 光流 光流的概念是Gibson在1950年首先提出来的.它是空间运动物体在观察成像平面上的像素运动的瞬时速度,是利用图像序列中像素在时间域上的变化以及相邻帧之间的相关性来找到上一帧跟当前帧之间存在 ...

- SpringMVC DispatcherServlet初始化过程

先来上一张类的结构图: 图里仅仅画了跟初始化相关的方法. 首先DispatcherServlet也是一个Servlet,初始化从init()方法開始. 以下就详细看看ini()是怎么实现的吧. 1.S ...

- PCCs系数

package ai; public class pccs { public static void main(String[] args) { double same[][]=new double[ ...

- go09---defer

package main /* defer 类似其它语言中的析构函数,在函数体执行结束后 按照调用顺序的相反顺序逐个执行,先进后出, 即使函数发生严重错误也会执行,资源清理文件关闭, 支持匿名函数的调 ...

- 【IOI2013】【Bzoj3246】Dreaming

http://www.lydsy.com/JudgeOnline/problem.php?id=3246 中文题面 天地之初,世界尚在遥远的梦想之中. Serpent(水蛇)生活的地方有N个水坑,编号 ...

- leetcode 784. Letter Case Permutation——所有BFS和DFS的题目本质上都可以抽象为tree,这样方便你写代码

Given a string S, we can transform every letter individually to be lowercase or uppercase to create ...

- hdoj--1872--稳定排序(水题)

稳定排序 Time Limit: 3000/1000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Others) Total Su ...

- nginx目录列表和目录访问权限设置

1.目录列表(directory listing) nginx让目录中的文件以列表的形式展现只需要一条指令 autoindex on; autoindex可以放在location中,只对当前locat ...

- EJB是什么?EJB的概念分析与理解(copy)

[说明:转载于http://blog.csdn.net/jojo52013145/article/details/5783677] 1. 我们不禁要问,什么是"服务集群"?什么是& ...

- hdu1213 并查集不压缩

题意:题意:一个人请人吃饭,相互认识的朋友在一张桌子,相互认识的朋友的意思是如果A认识B,B认识C,那么A.B.C是朋友,对于每组输入输出桌子的张数. Sample Input 2 5 3 1 2 2 ...