分布式缓存 — memcache

MemCache是一个自由、源码开放、高性能、分布式的分布式内存对象缓存系统,用于动态Web应用以减轻数据库的负载。它通过在内存中缓存数据和对象来减少读取数据库的次数,从而提高了网站访问的速度。MemCaChe是一个存储键值对的HashMap,在内存中对任意的数据(比如字符串、对象等)所使用的key-value存储,数据可以来自数据库调用、API调用,或者页面渲染的结果。MemCache设计理念就是小而强大,它简单的设计促进了快速部署、易于开发并解决面对大规模的数据缓存的许多难题,而所开放的API使得MemCache能用于Java、C/C++/C#、Perl、Python、PHP、Ruby等大部分流行的程序语言。

MemCache是一个高性能的分布式的内存对象缓存系统,用于各种动态应用以减轻数据库负担。它通过在内存中缓存数据和对象,来减少读取数据库的次数,从而提高动态、数据库驱动应用速度。MemCache会在内存中开辟一块空间,建立一个统一的巨大的hash表,hash表能够用来存储各种格式的数据,包括图像、视频、文件以及数据库检索的结果等。

MemCache和MemCached的区别:

MemCache是项目的名称,MemCached是MemCache服务器端可以执行文件的名称

MemCache的特性和限制

1、MemCache中可以保存的item数据量是没有限制的,只要内存足够

2、MemCache单进程在32位机中最大使用内存为2G,这个之前的文章提了多次了,64位机则没有限制

3、Key最大为250个字节,超过该长度无法存储

4、单个item最大数据是1MB,超过1MB的数据不予存储

5、MemCache服务端是不安全的,比如已知某个MemCache节点,可以直接telnet过去,并通过flush_all让已经存在的键值对立即失效

6、不能够遍历MemCache中所有的item,因为这个操作的速度相对缓慢且会阻塞其他的操作

7、MemCache的高性能源自于两阶段哈希结构:第一阶段在客户端,通过Hash算法根据Key值算出一个节点;第二阶段在服务端,通过一个内部的Hash算法,查找真正的item并返回给客户端。从实现的角度看,MemCache是一个非阻塞的、基于事件的服务器程序

8、MemCache设置添加某一个Key值的时候,传入expiry为0表示这个Key值永久有效,这个Key值也会在30天之后失效,见memcache.c的源代码:

#define REALTIME_MAXDELTA 60*60*24*30

static rel_time_t realtime(const time_t exptime) {

if (exptime == 0) return 0;

if (exptime > REALTIME_MAXDELTA) {

if (exptime <= process_started)

return (rel_time_t)1;

return (rel_time_t)(exptime - process_started);

} else {

return (rel_time_t)(exptime + current_time);

}

}

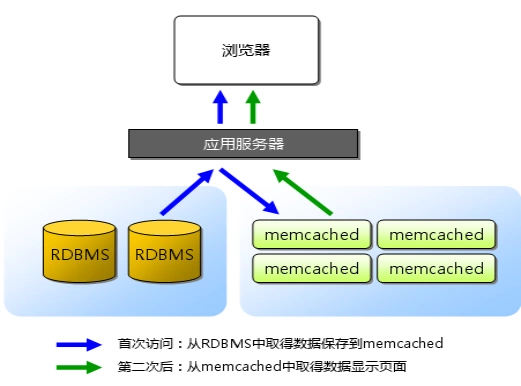

MemCache访问模型

特别注意,MemCache虽然被称为"分布式缓存",但是MemCache本身完全不具备分布式的功能,MemCache集群之间不会相互通信(与之形成对比的,比如JBoss Cache,某台服务器有缓存数据更新时,会通知集群中其他机器更新缓存或清除缓存数据),所谓的"分布式",完全依赖于客户端程序的实现,就像上面这张图的流程一样。

同时基于这张图,理一下MemCache一次写缓存的流程:

- 应用程序输入需要写缓存的数据

- API将Key输入路由算法模块,路由算法根据Key和MemCache集群服务器列表得到一台服务器编号

- 由服务器编号得到MemCache及其的ip地址和端口号

- API调用通信模块和指定编号的服务器通信,将数据写入该服务器,完成一次分布式缓存的写操作

读缓存和写缓存一样,只要使用相同的路由算法和服务器列表,只要应用程序查询的是相同的Key,MemCache客户端总是访问相同的客户端去读取数据,只要服务器中还缓存着该数据,就能保证缓存命中。

这种MemCache集群的方式也是从分区容错性的方面考虑的,假如Node2宕机了,那么Node2上面存储的数据都不可用了,此时由于集群中Node0和Node1还存在,下一次请求Node2中存储的Key值的时候,肯定是没有命中的,这时先从数据库中拿到要缓存的数据,然后路由算法模块根据Key值在Node0和Node1中选取一个节点,把对应的数据放进去,这样下一次就又可以走缓存了,这种集群的做法很好,但是缺点是成本比较大。

MemCached使用场景

通常,我们会在访问量高的Web网站和应用中使用MemCache,用来缓解数据库的压力,并且提升网站和应用的响应速度。

在应用程序中,我们通常在以下节点来使用MemCached:

- 访问频繁的数据库数据(身份token、首页动态)

- 访问频繁的查询条件和结果

- 作为Session的存储方式(提升Session存取性能)

- 页面缓存

- 更新频繁的非重要数据(访客量、点击次数)

- 大量的hot数据

常用工作流程(如下图):

- 客户端请求数据

- 检查MemCached中是否有对应数据

- 有的话直接返回,结束

- 没有的话,去数据库里请求数据

- 将数据写入MemCached,供下次请求时使用

- 返回数据,结束

(注意:缓存到MemCached中的数据库数据,在更新数据库时要注意同时更新MemCached)

MemCached采用了C/S架构,在Server端启动后,以守护程序的方式,监听客户端的请求。启动时可以指定监听的IP(服务器的内网ip/外网ip)、端口号(所以做分布式测试时,一台服务器上可以启动多个不同端口号的MemCached进程)、使用的内存大小等关键参数。一旦启动,服务就会一直处于可用状态。

为了提高性能,MemCached缓存的数据全部存储在MemCached管理的内存中,所以重启服务器之后缓存数据会清空,不支持持久化。

MemCache实现原理

首先要说明一点,MemCache的数据存放在内存中,存放在内存中个人认为意味着几点:

1、访问数据的速度比传统的关系型数据库要快,因为Oracle、MySQL这些传统的关系型数据库为了保持数据的持久性,数据存放在硬盘中,IO操作速度慢

2、MemCache的数据存放在内存中同时意味着只要MemCache重启了,数据就会消失

3、既然MemCache的数据存放在内存中,那么势必受到机器位数的限制,这个之前的文章写过很多次了,32位机器最多只能使用2GB的内存空间,64位机器可以认为没有上限

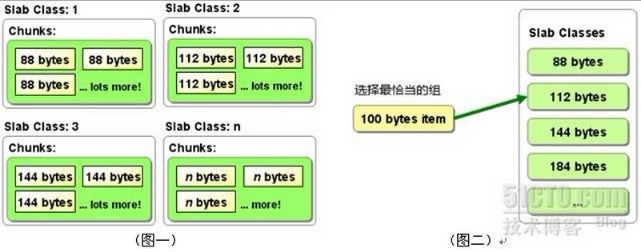

然后我们来看一下MemCache的原理,MemCache最重要的莫不是内存分配的内容了,MemCache采用的内存分配方式是固定空间分配,还是自己画一张图说明:

slab_class、slab、page、chunk之间的关系是:

MemCache将内存空间分为一组slab

每个slab下又有若干个page,page的默认大小是1M,如果slab大小100M,就包含100个page

每个page里面包含若干个chunk,chunk是数据的实际存放的地方,同一个slab里面的chunk大小相同

slab_class里,存放的是一组组chunk大小相同的slab

MemCache内存分配的方式称为allocator,slab的数量是有限的,几个、十几个或者几十个,这个和启动参数的配置相关。

MemCache中的value过来存放的地方是由value的大小决定的,value总是会被存放到与chunk大小最接近的一个slab中,比如slab[1]的chunk大小为80字节、slab[2]的chunk大小为100字节、slab[3]的chunk大小为128字节(相邻slab内的chunk基本以1.25为比例进行增长,MemCache启动时可以用-f指定这个比例),那么过来一个88字节的value,这个value将被放到2号slab中。放slab的时候,首先slab要申请内存,申请内存是以page为单位的,所以在放入第一个数据的时候,无论大小为多少,都会有1M大小的page被分配给该slab。申请到page后,slab会将这个page的内存按chunk的大小进行切分,这样就变成了一个chunk数组,最后从这个chunk数组中选择一个用于存储数据。

内存分配方式

- Memcached利用slab allocation机制来分配和管理内存,它按照预先规定的大小,将分配的内存分割成特定长度的内存块,再把尺寸相同的内存块分成组,数据在存放时,根据键值大小去匹配slab大小,找就近的slab存放,所以存在空间浪费现象。而传统的内存管理方式是,使用完通过malloc分配的内存后通过free来回收内存,这种方式容易产生内存碎片并降低操作系统对内存的管理效率。

- 存放数据时,首先slab要申请内存,申请内存是以page为单位的。所以在放入第一个数据的时候,无论大小为多少,都会有1M大小的page被分配给该slab。申请到page后,slab会将这个page的内存按chunk的大小进行切分,这样就变成了一个chunk数组,最后从这个chunk数组中选择一个用于存储数据。

MemCache中的value存放位置是由value的大小决定,value会被存放到与chunk大小最接近的一个slab中,比如slab[1]的chunk大小为88字节、slab[2]的chunk大小为112字节、slab[3]的chunk大小为144字节(默认相邻slab内的chunk基本以1.25为比例进行增长,MemCache启动时可以用-f指定这个比例),那么一个100字节的value,将被放到2号slab中。

内存回收方式

- 当数据容量用完MemCached分配的内存后,就会基于LRU(Least Recently

Used)算法清理失效的缓存数据(放入数据时可设置失效时间),或者清理最近最少使用的缓存数据,然后放入新的数据。 - 在LRU中,MemCached使用的是一种Lazy

Expiration策略,自己不会监控存入的key/vlue对是否过期,而是在获取key值时查看记录的时间戳,检查key/value对空间是否过期,这样可减轻服务器的负载。 - 需要注意的是,如果如果MemCache启动没有追加-M,则表示禁止LRU,这种情况下内存不够会报Out Of Memory错误。

针对MemCache的内存分配及回收算法,总结三点:

- MemCache的内存分配chunk里面会有内存浪费,88字节的value分配在128字节(紧接着大的用)的chunk中,就损失了30字节,但是这也避免了管理内存碎片的问题

- MemCache的LRU算法不是针对全局的,是针对slab的

- 应该可以理解为什么MemCache存放的value大小是限制的,因为一个新数据过来,slab会先以page为单位申请一块内存,申请的内存最多就只有1M,所以value大小自然不能大于1M了

MemCached分布式

为了提升MemCached的存储容量和性能,我们应用的客户端可能会对应多个MemCached服务器来提供服务,这就是MemCached的分布式。

MemCached的目前版本是通过C实现,采用了单进程、单线程、异步I/O,基于事件(event_based)的服务方式.使用libevent作为事件通知实现。多个Server可以协同工作,但这些 Server 之间保存的数据各不相同,而且并不通信(与之形成对比的,比如JBoss Cache,某台服务器有缓存数据更新时,会通知集群中其他机器更新缓存或清除缓存数据),每个Server只是对自己的数据进行管理。

Client端通过IP地址和端口号指定Server端,将需要缓存的数据是以key->value对的形式保存在Server端。key的值通过hash进行转换,根据hash值把value传递到对应的具体的某个Server上。当需要获取对象数据时,也根据key进行。首先对key进行hash,通过获得的值可以确定它被保存在了哪台Server上,然后再向该Server发出请求。Client端只需要知道保存hash(key)的值在哪台服务器上就可以了。

当向MemCached集群存入/取出key/value时,MemCached客户端程序根据一定的算法计算存入哪台服务器,然后再把key/value值存到此服务器中。也就是说,存取数据分二步走,第一步,选择服务器,第二步存取数据。

分布式算法解析

余数算法:

先求得键的整数散列值(也是就键string的HashCODE值 什么是HashCode),再除以服务器台数,根据余数确定存取服务器,这种方法计算简单,高效,但在memcached服务器增加或减少时,几乎所有的缓存都会失效。

- 散列算法:

先算出MemCached服务器的散列值,并将其分布到0到2的32次方的圆上,然后用同样的方法算出存储数据的键的散列值并映射至圆上,最后从数据映射到的位置开始顺时针查找,将数据保存到查找到的第一个服务器上,如果超过2的32次方,依然找不到服务器,就将数据保存到第一台MemCached服务器上。如果添加了一台MemCached服务器,只在圆上增加服务器的逆时针方向的第一台服务器上的键会受到影响。

MemCached线程管理

MemCached网络模型是典型的单进程多线程模型,采用libevent处理网络请求,主进程负责将新来的连接分配给work线程,work线程负责处理连接,有点类似与负载均衡,通过主进程分发到对应的工作线程。

MemCached默认有7个线程,4个主要的工作线程,3个辅助线程,线程可划分为以下4种:

主线程,负责MemCached服务器初始化,监听TCP、Unix Domain连接请求;

工作线程池,MemCached默认4个工作线程,可通过启动参数修改,负责处理TCP、UDP,Unix域套接口链路上的请求;

assoc维护线程,MemCached内存中维护一张巨大的hash表,该线程负责hash表动态增长;

slab维护线程,即内存管理模块维护线程,负责class中slab的平衡,MemCached启动选项中可关闭该线程。

MemCache指令汇总

上面说过,已知MemCache的某个节点,直接telnet过去,就可以使用各种命令操作MemCache了,下面看下MemCache有哪几种命令:

| 命 令 | 作 用 |

| get | 返回Key对应的Value值 |

| add | 添加一个Key值,没有则添加成功并提示STORED,有则失败并提示NOT_STORED |

| set | 无条件地设置一个Key值,没有就增加,有就覆盖,操作成功提示STORED |

| replace | 按照相应的Key值替换数据,如果Key值不存在则会操作失败 |

| stats | 返回MemCache通用统计信息(下面有详细解读) |

| stats items | 返回各个slab中item的数目和最老的item的年龄(最后一次访问距离现在的秒数) |

| stats slabs | 返回MemCache运行期间创建的每个slab的信息(下面有详细解读) |

| version | 返回当前MemCache版本号 |

| flush_all | 清空所有键值,但不会删除items,所以此时MemCache依旧占用内存 |

| quit | 关闭连接 |

stats指令解读

stats是一个比较重要的指令,用于列出当前MemCache服务器的状态

STAT pid 1023

STAT uptime 21069937

STAT time 1447235954

STAT version 1.4.5

STAT pointer_size 64

STAT rusage_user 1167.020934

STAT rusage_system 3346.933170

STAT curr_connections 29

STAT total_connections 21

STAT connection_structures 49

STAT cmd_get 49

STAT cmd_set 7458

STAT cmd_flush 0

STAT get_hits 7401

STAT get_misses 57

..(delete、incr、decr、cas的hits和misses数,cas还多一个badval)

STAT auth_cmds 0

STAT auth_errors 0

STAT bytes_read 22026555

STAT bytes_written 8930466

STAT limit_maxbytes 4134304000

STAT accepting_conns 1

STAT listen_disabled_num 0

STAT threads 4

STAT bytes 151255336

STAT current_items 57146

STAT total_items 580656STAT evicitions 0

这些参数反映着MemCache服务器的基本信息,它们的意思是:

| 参 数 名 | 作 用 |

| pid | MemCache服务器的进程id |

| uptime | 服务器已经运行的秒数 |

| time | 服务器当前的UNIX时间戳 |

| version | MemCache版本 |

| pointer_size | 当前操作系统指针大小,反映了操作系统的位数,64意味着MemCache服务器是64位的 |

| rusage_user | 进程的累计用户时间 |

| rusage_system | 进程的累计系统时间 |

| curr_connections | 当前打开着的连接数 |

| total_connections | 当服务器启动以后曾经打开过的连接数 |

| connection_structures | 服务器分配的连接构造数 |

| cmd_get | get命令总请求次数 |

| cmd_set | set命令总请求次数 |

| cmd_flush | flush_all命令总请求次数 |

| get_hits | 总命中次数,重要,缓存最重要的参数就是缓存命中率,以get_hits / (get_hits + get_misses)表示,比如这个缓存命中率就是99.2% |

| get_misses | 总未命中次数 |

| auth_cmds | 认证命令的处理次数 |

| auth_errors | 认证失败的处理次数 |

| bytes_read | 总读取的字节数 |

| bytes_written | 总发送的字节数 |

| limit_maxbytes | 分配给MemCache的内存大小(单位为字节) |

| accepting_conns | 是否已经达到连接的最大值,1表示达到,0表示未达到 |

| listen_disabled_num | 统计当前服务器连接数曾经达到最大连接的次数,这个次数应该为0或者接近于0,如果这个数字不断增长, 就要小心我们的服务了 |

| threads | 当前MemCache总线程数,由于MemCache的线程是基于事件驱动机制的,因此不会一个线程对应一个用户请求 |

| bytes | 当前服务器存储的items总字节数 |

| current_items | 当前服务器存储的items总数量 |

| total_items | 自服务器启动以后存储的items总数量 |

如果对上面的MemCache存储机制比较理解了,那么我们来看一下各个slab中的信息

stats slab指令解读

STAT1:chunk_size 96

...

STAT 2:chunk_size 144

STAT 2:chunks_per_page 7281

STAT 2:total_pages 7

STAT 2:total_chunks 50967

STAT 2:used_chunks 45197

STAT 2:free_chunks 1

STAT 2:free_chunks_end 5769

STAT 2:mem_requested 6084638

STAT 2:get_hits 48084

STAT 2:cmd_set 59588271

STAT 2:delete_hits 0

STAT 2:incr_hits 0

STAT 2:decr_hits 0

STAT 2:cas_hits 0

STAT 2:cas_badval 0

...

STAT 3:chunk_size 216

...

首先看到,第二个slab的chunk_size(144)/第一个slab的chunk_size(96)=1.5,第三个slab的chunk_size(216)/第二个slab的chunk_size(144)=1.5,可以确定这个MemCache的增长因子是1.5,chunk_size以1.5倍增长。然后解释下字段的含义:

| 参 数 名 | 作 用 |

| chunk_size | 当前slab每个chunk的大小,单位为字节 |

| chunks_per_page | 每个page可以存放的chunk数目,由于每个page固定为1M即1024*1024字节,所以这个值就是(1024*1024/chunk_size) |

| total_pages | 分配给当前slab的page总数 |

| total_chunks | 当前slab最多能够存放的chunk数,这个值是total_pages*chunks_per_page |

| used_chunks | 已经被分配给存储对象的chunks数目 |

| free_chunks | 曾经被使用过但是因为过期而被回收的chunk数 |

| free_chunks_end | 新分配但还没有被使用的chunk数,这个值不为0则说明当前slab从来没有出现过容量不够的时候 |

| mem_requested | 当前slab中被请求用来存储数据的内存空间字节总数,(total_chunks*chunk_size)-mem_requested表示有多少内存在当前slab中是被闲置的,这包括未用的slab+使用的slab中浪费的内存 |

| get_hits | 当前slab中命中的get请求数 |

| cmd_set | 当前slab中接收的所有set命令请求数 |

| delete_hits | 当前slab中命中的delete请求数 |

| incr_hits | 当前slab中命中的incr请求数 |

| decr_hits | 当前slab中命中的decr请求数 |

| cas_hits | 当前slab中命中的cas请求数 |

| cas_badval | 当前slab中命中但是更新失败的cas请求数 |

看到这个命令的输出量很大,所有信息都很有作用。举个例子吧,比如第一个slab中使用的chunks很少,第二个slab中使用的chunks很多,这时就可以考虑适当增大MemCache的增长因子了,让一部分数据落到第一个slab中去,适当平衡两个slab中的内存,避免空间浪费。

整理自:https://segmentfault.com/a/1190000012950110?utm_source=tag-newest、https://www.cnblogs.com/xrq730/p/4948707.html

分布式缓存 — memcache的更多相关文章

- 分布式缓存Memcache和Redis

引言 针对于如今计算机的CPU和网络设施,相应用程序来说,运行效率的瓶颈.已经不是代码的长度(实现同一个功能)和带宽了,而是,代码訪问资源的过程.即:让我们的程序慢下来的罪魁祸首就是IO操作. 程序从 ...

- 分布式缓存 memcache学习

1.使用分布式缓存是为了解决多台机器共享信息的问题,通过访问一个ip和端口来可以访问不同的IIS服务器 2.memcache基础原理 在Socket服务器端存储数据是以键值对的形式存储 内存处理的算法 ...

- 分布式缓存Memcache

Memcached是分布式的,也就是说它不是本地的.它基于网络连接(当然它也可以使用localhost)方式完成服务,本身它是一个独立于应用的程序或守护进程(Daemon方式). Memcached使 ...

- php5.4之分布式缓存memcache(windows7下安装配置)

版权声明:本文为博主原创文章,未经博主同意不得转载. https://blog.csdn.net/qq1355541448/article/details/36663203 使用理由:就是为了频繁查询 ...

- CYQ.Data V5 分布式缓存Redis应用开发及实现算法原理介绍

前言: 自从CYQ.Data框架出了数据库读写分离.分布式缓存MemCache.自动缓存等大功能之后,就进入了频繁的细节打磨优化阶段. 从以下的更新列表就可以看出来了,3个月更新了100条次功能: 3 ...

- 分布式缓存系统Memcached简介与以及在.net下的实践(转)

缘起: 在数据驱动的web开发中,经常要重复从数据库中取出相同的数据,这种重复极大的增加了数据库负载.缓存是解决这个问题的好办法.但是ASP.NET中的虽然已经可以实现对页面局部进行缓存,但还是不够灵 ...

- MemCache分布式缓存的一个bug

Memcached分布式缓存策略不是由服务器端至支持的,多台服务器之间并不知道彼此的存在.分布式的实现是由客户端代码(Memcached.ClientLibrary)通过缓存key-server映射来 ...

- 分布式缓存之 memcache 实现分布式缓存

最近想搞点分布式,但是不知道整点什么,来点简单的吧. 今天讲下memcache的分布式缓存 首先下载memcache的服务器端 百度下可以找到 然后执行安装和开启(关闭服务器)命令(还有其他的命令 可 ...

- 分布式缓存Memcached/memcached/memcache详解及区别

先来解释下标题中的三种写法:首字母大写的Memcached,指的是Memcached服务器,就是独立运行Memcached的后台服务器,用于存储缓存数据的“容器”.memcached和memcache ...

随机推荐

- java Swing组件随着窗口拖动等比移动或等比放大

实现原理很简单, 1清空布局(使用绝对布局) 2添加监听器(监听窗口是否被拖动) 3在监听器里面动态调整 组件的位置 效果如下: 拖动之后效果: 代码实现: import java.awt.Event ...

- 自动化单元测试(Karma + Mocha)

使用 Karma + Mocha做单元测试 Karma([ˈkɑrmə] 卡玛)是一个测试运行器,它可以呼起浏览器,加载测试脚本,然后运行测试用例 Mocha([ˈmoʊkə] 摩卡)是一个单元测试框 ...

- 单细胞分析实录(3): Cell Hashing数据拆分

在之前的文章里,我主要讲了如下两个内容:(1) 认识Cell Hashing:(2): 使用Cell Ranger得到表达矩阵.相信大家已经知道了cell hashing与普通10X转录组的差异,以及 ...

- 解决首页中Better-scroll可滚动区域的问题

在首页时候,使用BetterScroll插件的时候,滚动的时候经常会卡顿.Better-scroll在决定有多少区域可以滚动时,是根据ScrollerHeight属性决定的.ScrollerHeigh ...

- jdbc-创建statement-数量过多导致游标超限

在循环中重复创建 java.sql.Connection.prepareStatement(sql) , 导致游标超限

- CentOS8_在线安装_网络源_网络镜像源填写格式_以及其他笔记

CentOS8_在线安装_网络源_网络镜像源填写格式_以及其他笔记 转载注明来源: 本文链接 来自osnosn的博客,写于 2020-10-1. 参考: Centos8.0.1905 在线安装源选择 ...

- tf.lin_space

.lin_spae{ start, stop, num, name=None } start:张量(float32,或者float64类型) stop:张量(和start相同) num:张量(int3 ...

- C++把数字排序

C++把数字排序 描述 思路 代码 描述 如题,详细如下: 输入不超过1024个数字,以特殊数字结尾,如(-999),把数字从小到大排序. 思路 目前,我们有两种思路可以写: 1是 在输入的时候,排序 ...

- Python基础(下篇)

本篇文章主要内容:异常处理,函数,模块和包. 在开始正篇之前我们先来看看上一篇可乐留下的题目. 题目: 变量 a= {"name": "可乐", "a ...

- mysql 应用 持续更新

1.安装方法 贴出,my.ini # MySQL Server Instance Configuration File # -------------------------------------- ...