03 elasticsearch学习笔记-IK分词器?

1. 什么是IK分词器

2. 下载IK分词器

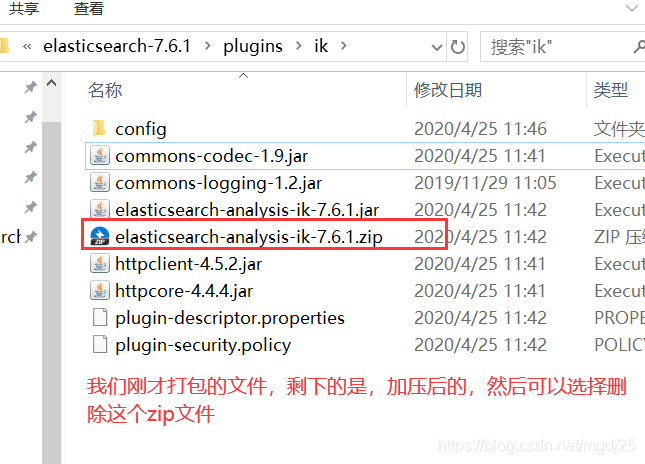

下载地址,版本要和ES的版本对应上

https://github.com/medcl/elasticsearch-analysis-ik/releases/tag/v7.3.1

注意下载zip版本

下载完毕后,放入到我们的elasticsearch/plugins/ik插件目录里即可

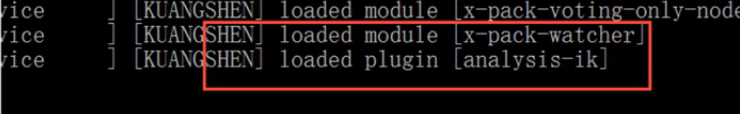

重启观察ES,可以看到IK分词器被加载了!

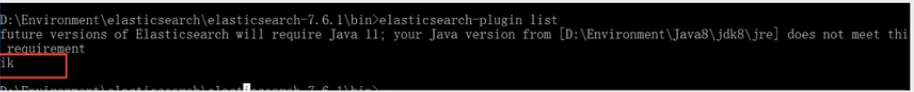

elasticsearch-plugin可以通过这个命令查看加载进来的插件

docker下载的安装的查看方法

root@haima-PC:/usr/local/docker/efk/docker_compose_efk# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

c43439e99ff0 docker_compose_efk_fluentd "/bin/entrypoint.sh …" 29 seconds ago Up 27 seconds 5140/tcp, 0.0.0.0:24224->24224/tcp, 0.0.0.0:24224->24224/udp docker_compose_efk_fluentd_1

00eda4c1585d docker_compose_efk_kibana "/usr/local/bin/dumb…" 29 seconds ago Up 26 seconds 0.0.0.0:5601->5601/tcp docker_compose_efk_kibana_1

6e2e42f9e3ca docker.elastic.co/elasticsearch/elasticsearch:7.3.1 "/usr/local/bin/dock…" 31 seconds ago Up 29 seconds 0.0.0.0:9200->9200/tcp, 9300/tcp docker_compose_efk_elasticsearch_1

root@haima-PC:/usr/local/docker/efk/docker_compose_efk# docker exec -it docker_compose_efk_elasticsearch_1 bash ./bin/elasticsearch-plugin list

ik

详细查看我github里的readme.md

https://github.com/haimait/docker_compose_efk

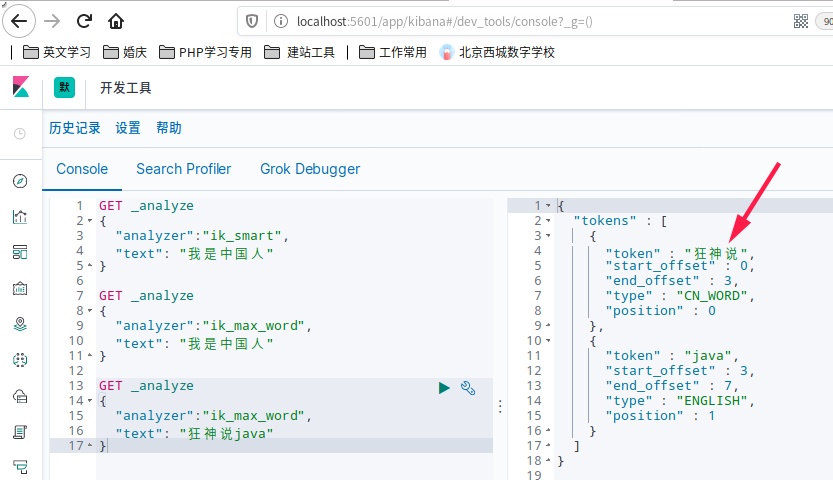

3. 使用kibana测试!

查看不同的分词效果

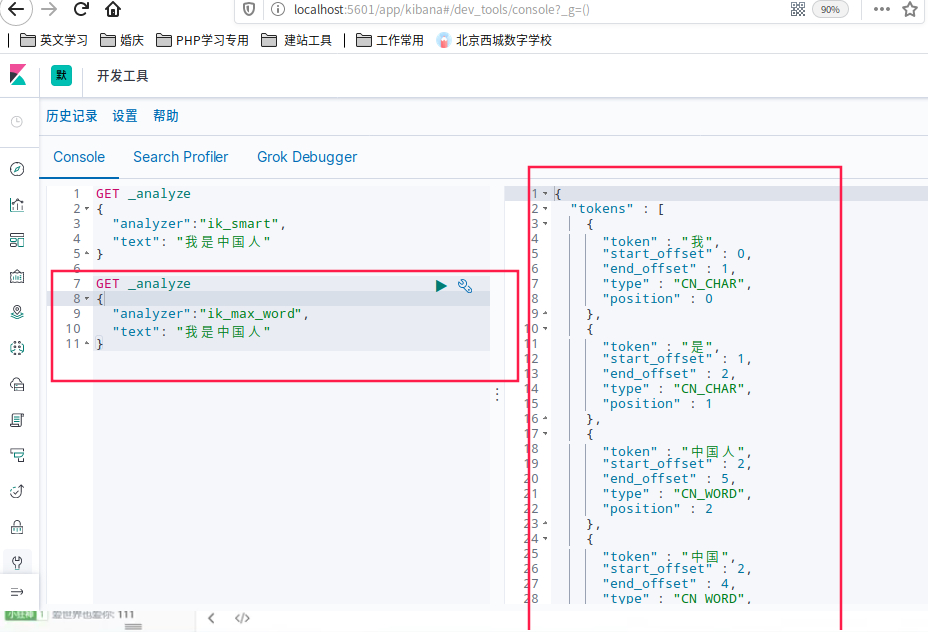

ik_smart和ik_max_word,其中ik_smart为最少切分

GET _analyze

{

"analyzer":"ik_smart",

"text": "我是中国人"

}

划出了3组

{

"tokens" : [

{

"token" : "我",

"start_offset" : 0,

"end_offset" : 1,

"type" : "CN_CHAR",

"position" : 0

},

{

"token" : "是",

"start_offset" : 1,

"end_offset" : 2,

"type" : "CN_CHAR",

"position" : 1

},

{

"token" : "中国人",

"start_offset" : 2,

"end_offset" : 5,

"type" : "CN_WORD",

"position" : 2

}

]

}

ik_max_word为最细粒度划分,穷尽词库的可能

GET _analyze

{

"analyzer":"ik_max_word",

"text": "我是中国人"

}

划出了5组

{

"tokens" : [

{

"token" : "我",

"start_offset" : 0,

"end_offset" : 1,

"type" : "CN_CHAR",

"position" : 0

},

{

"token" : "是",

"start_offset" : 1,

"end_offset" : 2,

"type" : "CN_CHAR",

"position" : 1

},

{

"token" : "中国人",

"start_offset" : 2,

"end_offset" : 5,

"type" : "CN_WORD",

"position" : 2

},

{

"token" : "中国",

"start_offset" : 2,

"end_offset" : 4,

"type" : "CN_WORD",

"position" : 3

},

{

"token" : "国人",

"start_offset" : 3,

"end_offset" : 5,

"type" : "CN_WORD",

"position" : 4

}

]

}

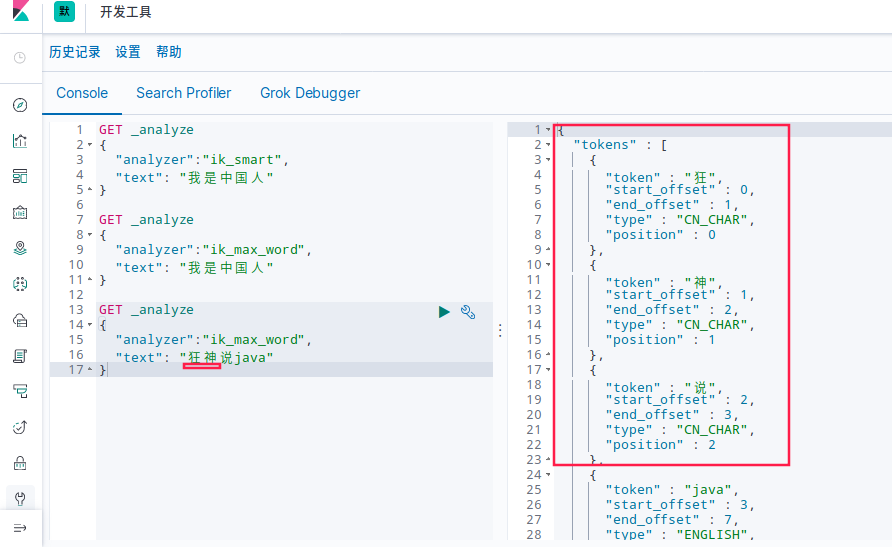

测试狂神说java

发现狂神说被分词器拆分开了,这里我们不想让它拆开,就需要在分词器中添加一个自己的词典,把自己的词放到自己的词典里

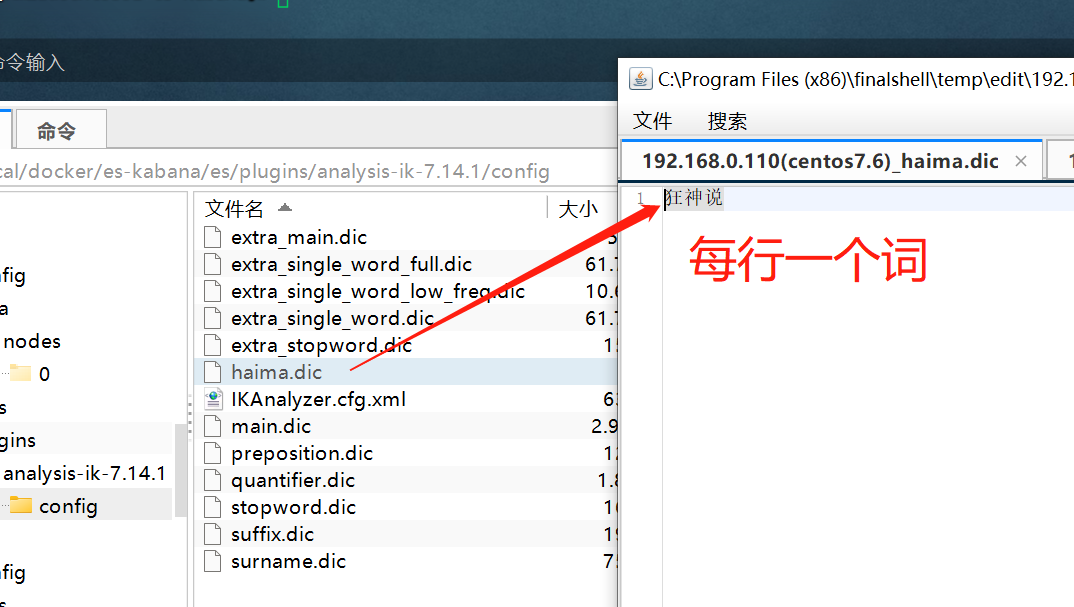

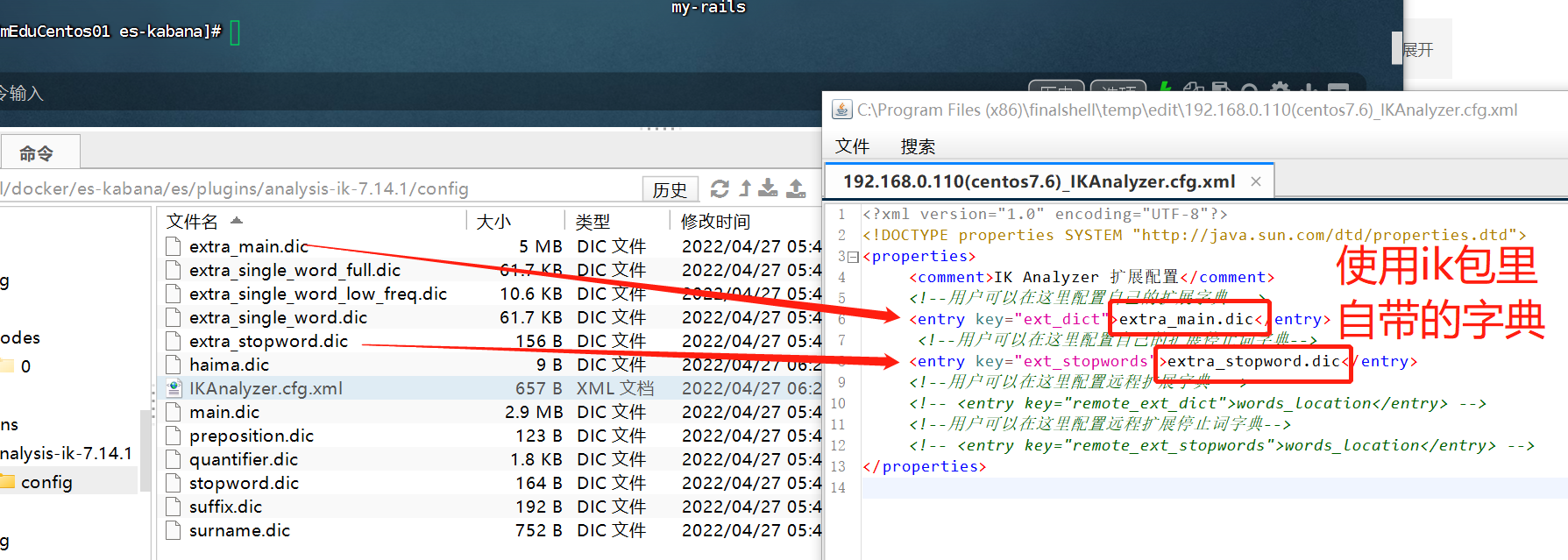

4. 创建自定义词典

- 创建

haima.dic

vim /elasticsearch/es/plugins/ik/config/haima.dic

写入 狂神说

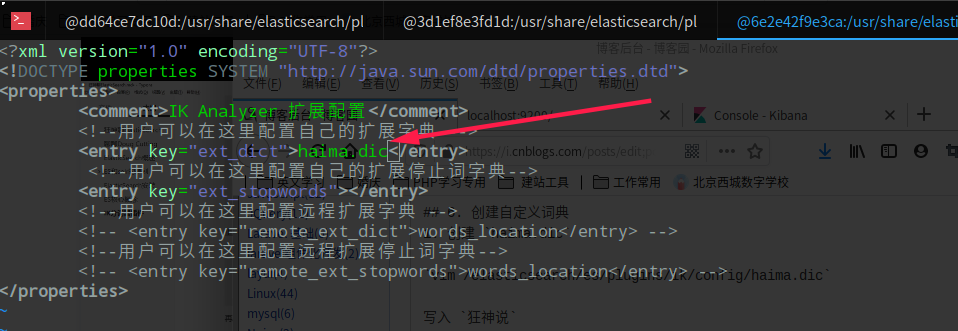

- 把自定义的

haima.dic字典,载入到配置文件里

vim /elasticsearch/es/plugins/ik/config/IKAnalyzer.cfg.xml

- 重启es服务

root@haima-PC:/usr/local/docker/efk/docker_compose_efk/elasticsearch/es/plugins/ik/config# docker restart docker_compose_efk_elasticsearch_1

docker_compose_efk_elasticsearch_1

- 再看一下分词器,

狂神说已经不会被分开了

- 使用ik分词包里自带的词典

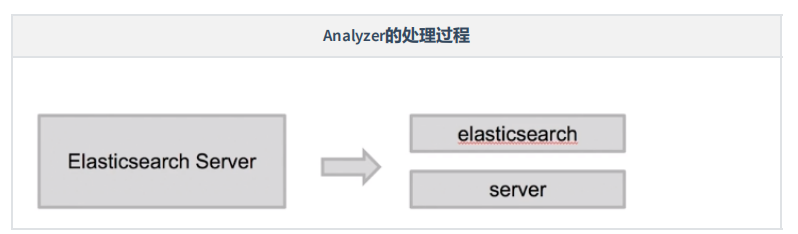

5. Analysis

analysis(只是一个概念),文本分析是将全文本转换为一系列单词的过程,也叫分词。analysis是通

过analyzer(分词器)来实现的,可以使用Elasticsearch内置的分词器,也可以自己去定制一些分词

器。 除了在数据写入的时候进行分词处理,那么在查询的时候也可以使用分析器对查询语句进行分词。

anaylzer是由三部分组成,例如有

Hello a World, the world is beautifu

Analyzer的处理过程

分词器名称 处理过程

Standard Analyzer 默认的分词器,按词切分,小写处理

Simple Analyzer 按照非字母切分(符号被过滤),小写处理

Stop Analyzer 小写处理,停用词过滤(the, a, this)

Whitespace Analyzer 按照空格切分,不转小写

Keyword Analyzer 不分词,直接将输入当做输出

Pattern Analyzer 正则表达式,默认是\W+(非字符串分隔)

1. Character Filter: 将文本中html标签剔除掉。

2. Tokenizer: 按照规则进行分词,在英文中按照空格分词。

3. Token Filter: 去掉stop world(停顿词,a, an, the, is, are等),然后转换小写

内置分词器

| 分词器名称 | 分词器名称 |

|---|---|

| 分词器名称 | 分词器名称 |

| Simple Analyzer | 按照非字母切分(符号被过滤),小写处理 |

| Stop Analyzer | 小写处理,停用词过滤(the, a, this) |

| Whitespace Analyzer | 按照空格切分,不转小写 |

| Keyword Analyzer | 不分词,直接将输入当做输出 |

| Pattern Analyzer | 正则表达式,默认是\W+(非字符串分隔) |

** 内置分词器示例**

5.2.1 Standard Analyzer

GET _analyze

{

"analyzer": "standard",

"text": "2 Running quick brown-foxes leap over lazy dog in the summer evening"

}

5.2.2 Simple Analyzer

GET _analyze

{

"analyzer": "simple",

"text": "2 Running quick brown-foxes leap over lazy dog in the summer evening"

}

5.2.3 Stop Analyzer

GET _analyze

{

"analyzer": "stop",

"text": "2 Running quick brown-foxes leap over lazy dog in the summer evening"

}

5.2.4 Whitespace Analyzer

GET _analyze

{

"analyzer": "whitespace",

"text": "2 Running quick brown-foxes leap over lazy dog in the summer evening"

}

5.2.5 Keyword Analyzer

GET _analyze

{

"analyzer": "keyword",

"text": "2 Running quick brown-foxes leap over lazy dog in the summer evening"

}

5.2.6 Pattern Analyzer

GET _analyze

{

"analyzer": "pattern",

"text": "2 Running quick brown-foxes leap over lazy dog in the summer evening"

}

03 elasticsearch学习笔记-IK分词器?的更多相关文章

- Elasticsearch下安装ik分词器

安装ik分词器(必须安装maven) 上传相应jar包 解压到相应目录 unzip elasticsearch-analysis-ik-master.zip(zip包) cp -r elasticse ...

- 【ELK】【docker】【elasticsearch】2.使用elasticSearch+kibana+logstash+ik分词器+pinyin分词器+繁简体转化分词器 6.5.4 启动 ELK+logstash概念描述

官网地址:https://www.elastic.co/guide/en/elasticsearch/reference/current/docker.html#docker-cli-run-prod ...

- Elasticsearch 7.x - IK分词器插件(ik_smart,ik_max_word)

一.安装IK分词器 Elasticsearch也需要安装IK分析器以实现对中文更好的分词支持. 去Github下载最新版elasticsearch-ik https://github.com/medc ...

- Elasticsearch拼音和ik分词器的结合应用

一.创建索引时,自定义拼音分词和ik分词 PUT /my_index { "index": { "analysis": { "analyzer&quo ...

- linux(centos 7)下安装elasticsearch 5 的 IK 分词器

(一)到IK 下载 对应的版本(直接下载release版本,避免mvn打包),下载后是一个zip压缩包 (二)将压缩包上传至elasticsearch 的安装目录下的plugins下,进行解压,运行如 ...

- 通过docker安装elasticsearch和安装ik分词器插件及安装kibana

前提: 已经安装好docker运行环境: 步骤: 1.安装elasticsearch 6.2.2版本,目前最新版是7.2.0,这里之所以选择6.2.2是因为最新的SpringBoot2.1.6默认支持 ...

- 【ELK】【docker】【elasticsearch】1. 使用Docker和Elasticsearch+ kibana 5.6.9 搭建全文本搜索引擎应用 集群,安装ik分词器

系列文章:[建议从第二章开始] [ELK][docker][elasticsearch]1. 使用Docker和Elasticsearch+ kibana 5.6.9 搭建全文本搜索引擎应用 集群,安 ...

- docker 部署 elasticsearch + elasticsearch-head + elasticsearch-head跨域问题 + IK分词器

0. docker pull 拉取elasticsearch + elasticsearch-head 镜像 1. 启动elasticsearch Docker镜像 docker run -di ...

- Docker 下Elasticsearch 的安装 和ik分词器

(1)docker镜像下载 docker pull elasticsearch:5.6.8 (2)安装es容器 docker run -di --name=changgou_elasticsearch ...

- Elasticsearch(ES)分词器的那些事儿

1. 概述 分词器是Elasticsearch中很重要的一个组件,用来将一段文本分析成一个一个的词,Elasticsearch再根据这些词去做倒排索引. 今天我们就来聊聊分词器的相关知识. 2. 内置 ...

随机推荐

- KingbaseES V8R6集群运维系列 -- 修改ssh通信为 sys_securecmdd 通信

一.适用于: 本文档使用于KingbaseES V008R006版本. 二.关于SYS_SECURECMDD: sys_securecmdd是KingbaseES集群自带的工具,集群监控.管理集群时通 ...

- 算法学习笔记【5】| ST表

ST表 Part 1:ST表解决的问题是什么 ST 表可以用来解决RMQ(区间最值问题)等可重复贡献的问题. ST表基于倍增的思想来实现. Part 2:ST表的实现 ST表通过 O(nlogn)& ...

- 正则表达式环视匹配(?=pattern)、(?!pattern)、(?<=pattern)、(?<!pattern)怎么用

今天在处理数据的时候遇到一个,需要用正则表达式匹配不包含某字符的字符串的问题,用到否定匹配,现总结如下: 一个正则小知识 ↓ []:表示范围,匹配其中任何一个 {}:表示重复匹配多次. ():表示分组 ...

- python结巴分词及词频统计

1 def get_words(txt): 2 seg_list = jieba.cut(txt) 3 c = Counter() 4 for x in seg_list: 5 if len(x) & ...

- 微服务集成Spring Cloud Alibaba Seata(一)Seata服务搭建

1.Seata介绍 Seata是阿里开源的一款分布式事务解决方案,致力于提供高性能和简单易用的分布式事务服务.数据库事务我们都知道,事务都是遵循ACID原则.而通过使用Seata可以实现在两个服务模块 ...

- #线段树,约数#洛谷 3889 [GDOI2014]吃

题目 有一个长度为\(n\)的数列,现在有\(m\)组询问每次给出区间\([l,r]\),查询 \[\max_{i,j=1}^n\{gcd(a_i,a_j)[(i<l或i>r)且l\leq ...

- 【中秋国庆不断更】OpenHarmony定义可动画属性:@AnimatableExtend装饰器

[中秋国庆不断更]OpenHarmony定义可动画属性:@AnimatableExtend装饰器 @AnimatableExtend装饰器用于自定义可动画的属性方法,在这个属性方法中修改组件不可动画的 ...

- 重磅官宣,OpenHarmony开发者大会来了!

开放原子开源基金会OpenHarmony开发者大会2023将于4月19日在北京召开. 春风送暖万物新,OpenHarmony正当时.诚邀您参加本届大会,聆听行业大咖分享操作系统和开源的最新前沿研究成 ...

- HarmonyOS账号服务,畅行鸿蒙生态所有应用与服务

账号对于用户来说并不陌生,在购买新设备或者使用新应用的时候,用户常常会被引导注册或者登录账号,账号就是用户在这些设备或应用内的通行证.根据华为上半年的一项统计,整体上中国网民人均下载App量在68个, ...

- 直播预告丨Hello HarmonyOS进阶课程第三课——游戏开发实践

为了帮助初识HarmonyOS的开发者快速入门,我们曾推出Hello HarmonyOS系列一共5期课程,从最基础的配置IDE和创建Hello World开始,详细介绍HarmonyOS基础.开发环境 ...