A RECURRENT NEURAL NETWORK WITHOUT CHAOS

本篇文章的介绍了一个非常简单的门限RNN(gated recurrent neural network),

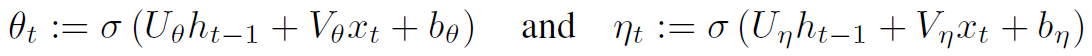

这里有两扇门horizontal/forget gate和vertical/input gate, 即

其中  (logistic sigmoid function)

(logistic sigmoid function)

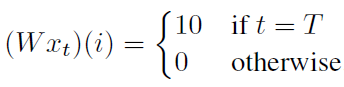

下面假设输入数据xt满足如下性质,

若隐层节点初始化为0, 即 ,则网络对脉冲xt的响应为,

,则网络对脉冲xt的响应为,

其中 衰减到0, forget gate

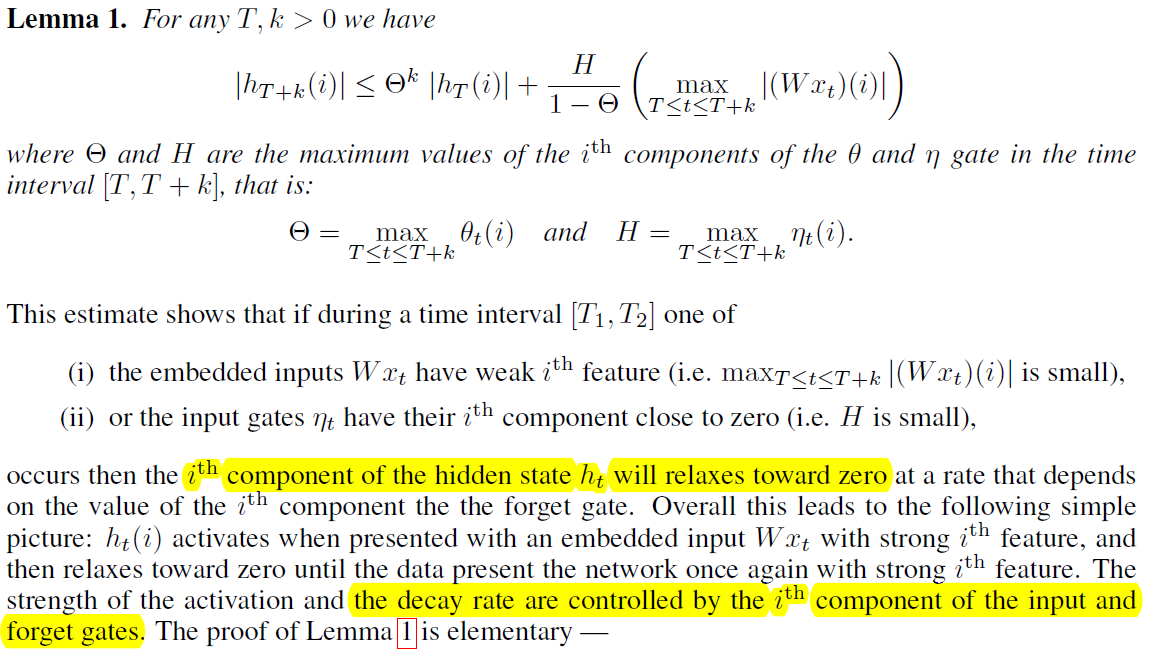

衰减到0, forget gate 控制了衰减速度,所以当隐层节点ht(i)遇到比较强的信号,ht(i)被激活,接着衰减到0,直到下一次再次被激活。

控制了衰减速度,所以当隐层节点ht(i)遇到比较强的信号,ht(i)被激活,接着衰减到0,直到下一次再次被激活。

zero input比较

本文的模型,只有一个吸引子, zero state, 但其它的模型,i.e., vanilla RNN, the LSTM and the GRU 具有混沌动力学行为。

接着文章想说明,这个没有混沌的RNN在word level language modeling task也能达到很好的效果,间接的说明混沌性质并不能解释这些模型在tasks上的成功。

CHAOS IN RECURRENT NEURAL NETWORKS

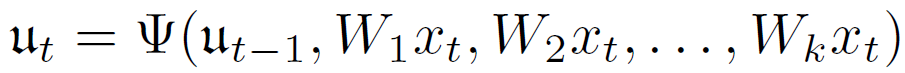

考虑下面的离散动力系统, 向量u属于Rd

形成的轨迹,会进入该系统的吸引子(不变集), 通常是分形的。

所有的RNN可以写成下面的形式

假设没有输入,则RNN可以诱导出相应的动力系统

从而刻画了产生复杂轨迹的能力。

如何才能出现上面的动力系统的行为呢?实际上是可以存在的,由于参数Wj是通过学习得到的,当遇到一个不怎么重要的数据点xt0,与隐层节点具有很弱的耦合性, 也就是说数据的影响不大, i.e., Wjxt0 ≈ 0,,就会在接下来的一段时间出现上述动力系统的行为,直到遇到一个非常重要的信号。

CHAOTIC BEHAVIOR OF LSTM AND GRU IN THE ABSENCE OF INPUT DATA

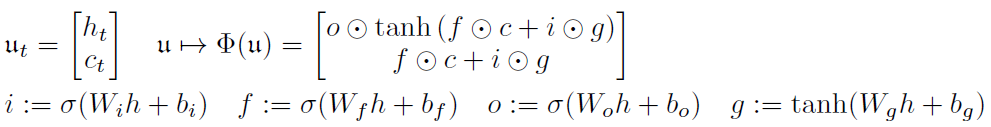

考虑下面LSTM诱导的动力系统,

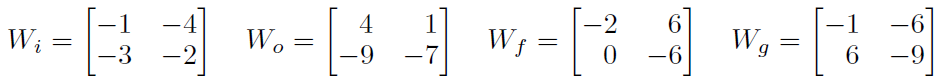

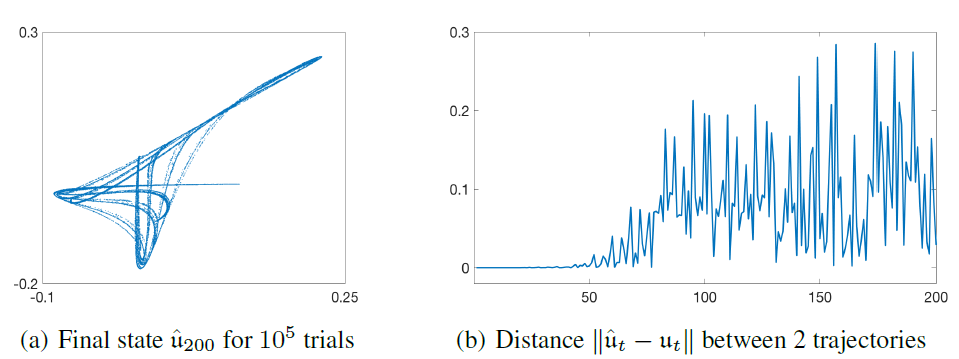

其中的参数具体为,

接着初始化隐层节点,

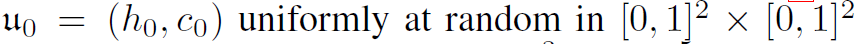

图1为具体的动力系统的展示, 图中的吸引子实质上是4维动力系统在2维上的投影。

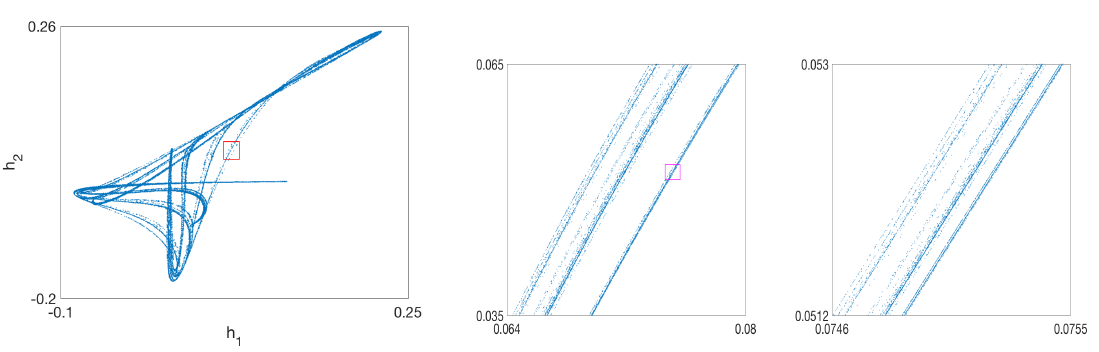

混沌动力系统具有初值敏感性,给定一个初始点,作者在[1e-7, 1e7]范围内进行扰动,跑200steps, 总共100,000次扰动。结果就是,第200步的点,几乎充满了整个吸引子。

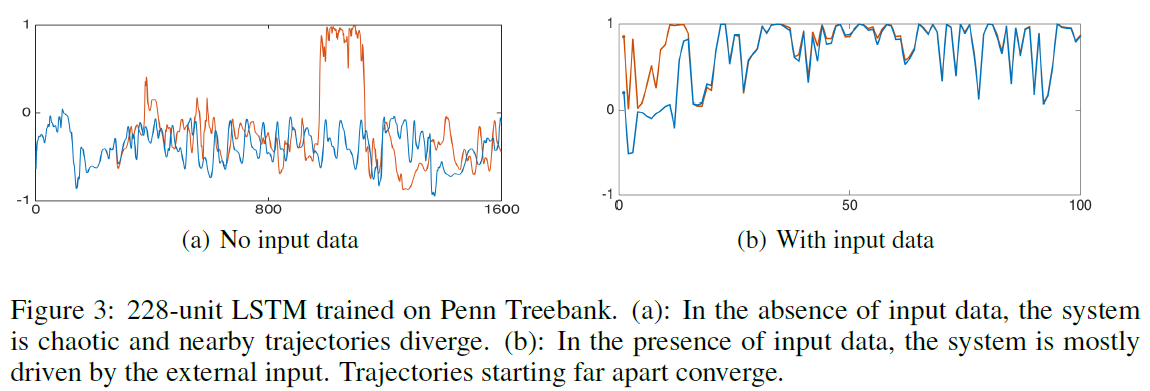

上面都是构造的例子,下面是作者在Penn Treebank corpus without dropout 训练好的LSTM,结果也出现混沌现象。当有初入的时候,就不再是一个自治的动力系统了,完全收到输入信号控制。

CHAOS-FREE BEHAVIOR OF THE CFN

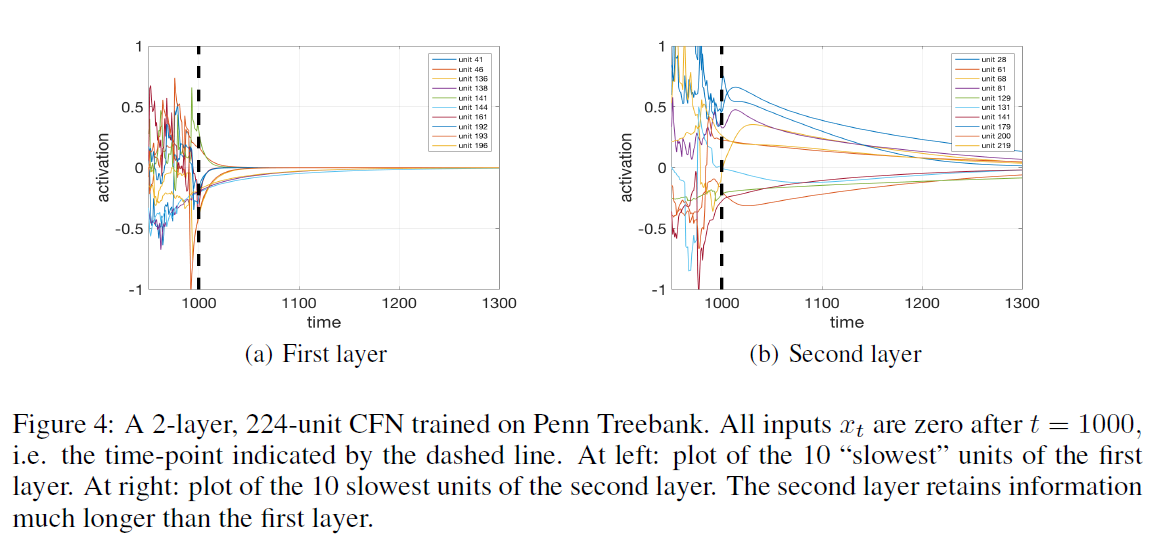

实验结果:高层的隐层节点的信号衰减慢

A RECURRENT NEURAL NETWORK WITHOUT CHAOS的更多相关文章

- Recurrent Neural Network系列1--RNN(循环神经网络)概述

作者:zhbzz2007 出处:http://www.cnblogs.com/zhbzz2007 欢迎转载,也请保留这段声明.谢谢! 本文翻译自 RECURRENT NEURAL NETWORKS T ...

- Recurrent Neural Network(循环神经网络)

Reference: Alex Graves的[Supervised Sequence Labelling with RecurrentNeural Networks] Alex是RNN最著名变种 ...

- Recurrent Neural Network系列2--利用Python,Theano实现RNN

作者:zhbzz2007 出处:http://www.cnblogs.com/zhbzz2007 欢迎转载,也请保留这段声明.谢谢! 本文翻译自 RECURRENT NEURAL NETWORKS T ...

- Recurrent Neural Network系列3--理解RNN的BPTT算法和梯度消失

作者:zhbzz2007 出处:http://www.cnblogs.com/zhbzz2007 欢迎转载,也请保留这段声明.谢谢! 这是RNN教程的第三部分. 在前面的教程中,我们从头实现了一个循环 ...

- Recurrent Neural Network系列4--利用Python,Theano实现GRU或LSTM

yi作者:zhbzz2007 出处:http://www.cnblogs.com/zhbzz2007 欢迎转载,也请保留这段声明.谢谢! 本文翻译自 RECURRENT NEURAL NETWORK ...

- 循环神经网络(Recurrent Neural Network,RNN)

为什么使用序列模型(sequence model)?标准的全连接神经网络(fully connected neural network)处理序列会有两个问题:1)全连接神经网络输入层和输出层长度固定, ...

- Recurrent Neural Network[Content]

下面的RNN,LSTM,GRU模型图来自这里 简单的综述 1. RNN 图1.1 标准RNN模型的结构 2. BiRNN 3. LSTM 图3.1 LSTM模型的结构 4. Clockwork RNN ...

- Recurrent Neural Network[survey]

0.引言 我们发现传统的(如前向网络等)非循环的NN都是假设样本之间无依赖关系(至少时间和顺序上是无依赖关系),而许多学习任务却都涉及到处理序列数据,如image captioning,speech ...

- 【NLP】Recurrent Neural Network and Language Models

0. Overview What is language models? A time series prediction problem. It assigns a probility to a s ...

随机推荐

- "美团"APP学习记录知识点

1.APP进入加载广告视图展示: -(void)initAdvView{ // 判断图片是否已经存在 NSArray *paths = NSSearchPathForDirectoriesInDoma ...

- Jmeter实现WebSocket协议的接口

1.下载websocket插件的jar包 网盘链接:https://pan.baidu.com/s/1FDcTHdQcDo6izgROMgB96w 密码:uags 该包下载完成后直接放在jmeter的 ...

- 【Web】[原创]ie6,7中td和img之间有间隙

情形描述 开发工具:VS2010: 浏览器版本:IE6以上,火狐,谷歌: 页面布局设计:Table+Img布局: 项目预览问题:火狐,谷歌,IE8以上未出现问题,IE6,IE7图片之间有间隙. 分析原 ...

- sql 死锁查看

--每秒死锁数量 SELECT * FROM sys.dm_os_performance_counters WHERE counter_name LIKE 'Number of Deadlocksc% ...

- Golang的一个CLI框架

因为机缘巧合,因为希望能在VPS中使用百度网盘,了解到了一个开源的项目BaiduPCS-Go,可以用来直接存取访问百度网盘,做的相当不错 而且看ISSUES,作者可能还是个学生,很强的样子.稍微看了下 ...

- 【神经网络与深度学习】【C/C++】使用blas做矩阵乘法

使用blas做矩阵乘法 #define min(x,y) (((x) < (y)) ? (x) : (y)) #include <stdio.h> #include <st ...

- 【OpenGL】初识OpenGL4.0

目录(?)[-] 什么是GLSL GLEW 安装GLEW 使用GLEW 其他库 使用GLM库进行数学运算 安装GLM 使用GLM 使用GLM作为OpenGL的输入 使用GLFW进行窗口管理 这篇文章主 ...

- C# 重写WndProc

重写WndProc方法来处理 Windows 消息 处理 Windows 消息. 在开发winForm时,常常要处理Windows消息,可以重写WndProc来实现.常见代码如下: using Sys ...

- 再谈mysql锁机制及原理—锁的诠释

加锁是实现数据库并发控制的一个非常重要的技术.当事务在对某个数据对象进行操作前,先向系统发出请求,对其加锁.加锁后事务就对该数据对象有了一定的控制,在该事务释放锁之前,其他的事务不能对此数据对象进行更 ...

- (转)Linux中显示空闲内存空间的free命令的基本用法

这篇文章主要介绍了Linux系统中free命令的基本用法,用free命令查看内存空余信息是Linux系统入门学习中的基础知识,需要的朋友可以参考下 free 命令显示系统使用和空闲的内存情况,包括 ...