WebMagic简介和使用

概览

WebMagic是一款简单灵活的爬虫框架。基于它你可以很容易的编写一个爬虫。

WebMagic项目代码分为核心和扩展两部分。

- 核心部分(webmagic-core)是一个精简的、模块化的爬虫实现,而扩展部分则包括一些便利的、实用性的功能。WebMagic的架构设计参照了Scrapy,目标是尽量的模块化,并体现爬虫的功能特点。这部分提供非常简单、灵活的API,在基本不改变开发模式的情况下,编写一个爬虫。

- 扩展部分(webmagic-extension)提供一些便捷的功能,例如注解模式编写爬虫等。同时内置了一些常用的组件,便于爬虫开发。

总体架构

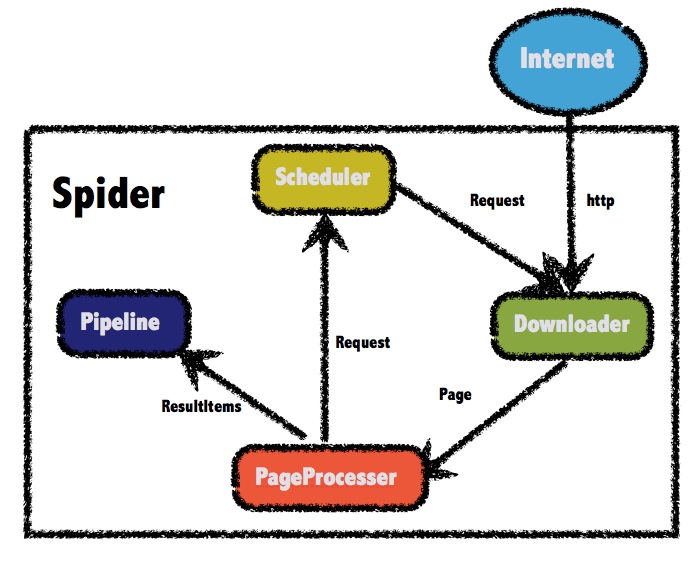

WebMagic的结构分为Downloader、PageProcessor、Scheduler、Pipeline四大组件,并由Spider将它们彼此组织起来。

WebMagic总体架构图如下:

WebMagic的四个组件

- Downloader:Downloader负责从互联网上下载页面,以便后续处理。WebMagic默认使用了Apache HttpClient作为下载工具。

- PageProcessor:PageProcessor负责解析页面,抽取有用信息,以及发现新的链接。WebMagic使用Jsoup作为HTML解析工具,并基于其开发了解析XPath的工具Xsoup。在这四个组件中,

PageProcessor对于每个站点每个页面都不一样,是需要使用者定制的部分。 - Scheduler:Scheduler负责管理待抓取的URL,以及一些去重的工作。WebMagic默认提供了JDK的内存队列来管理URL,并用集合来进行去重。也支持使用Redis进行分布式管理。除非项目有一些特殊的分布式需求,否则无需自己定制Scheduler。

- Pipeline:Pipeline负责抽取结果的处理,包括计算、持久化到文件、数据库等。WebMagic默认提供了“输出到控制台”和“保存到文件”两种结果处理方案。

Pipeline定义了结果保存的方式,如果你要保存到指定数据库,则需要编写对应的Pipeline。对于一类需求一般只需编写一个Pipeline。

用于数据流转的对象

- Request:

Request是对URL地址的一层封装,一个Request对应一个URL地址。它是PageProcessor与Downloader交互的载体,也是PageProcessor控制Downloader唯一方式。除了URL本身外,它还包含一个Key-Value结构的字段extra。你可以在extra中保存一些特殊的属性,然后在其他地方读取,以完成不同的功能。例如附加上一个页面的一些信息等。 - Page:

Page代表了从Downloader下载到的一个页面——可能是HTML,也可能是JSON或者其他文本格式的内容。Page是WebMagic抽取过程的核心对象,它提供一些方法可供抽取、结果保存等。 - ResultItems:

ResultItems相当于一个Map,它保存PageProcessor处理的结果,供Pipeline使用。它的API与Map很类似,值得注意的是它有一个字段skip,若设置为true,则不应被Pipeline处理。

实例

Maven坐标

<dependency>

<groupId>us.codecraft</groupId>

<artifactId>webmagic-core</artifactId>

<version>0.7.3</version>

</dependency>

<dependency>

<groupId>us.codecraft</groupId>

<artifactId>webmagic-extension</artifactId>

<version>0.7.3</version>

</dependency>

爬取安居客房价信息实例

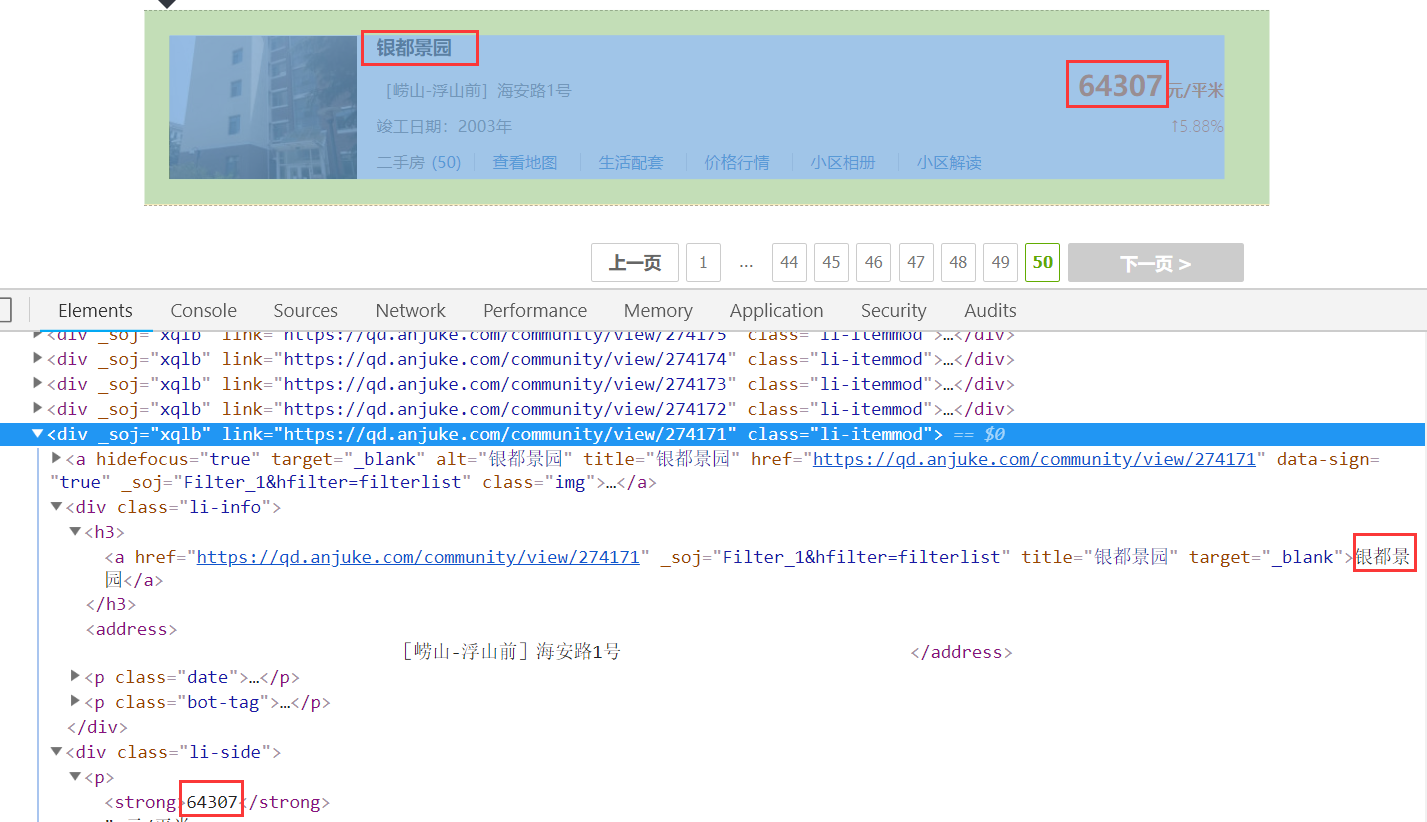

需求是获取所有小区的房价,先看一下页面截图:

代码:

public class AnjukeProcessor implements PageProcessor {

//抓取网站的相关配置,包括编码、抓取间隔、重试次数等

private Site site = Site.me().setRetryTimes(3).setSleepTime(100);

private static int count = 0;

private static List<String> urlList = new ArrayList<>();

@Override

public void process(Page page) {

//从页面发现后续的url地址来抓取

page.addTargetRequests(

page.getHtml().xpath("//div[@class='page-content']/div[@class='multi-page']/a/@href").all());

//判断链接是否符合"https://qd.anjuke.com/community/p任意个数字"格式

if (page.getUrl().regex("https://qd.anjuke.com/community/p[0-9]+").match()) {

//定义如何抽取页面信息,并保存下来

List<Selectable> selectableList = page.getHtml().xpath("//div[@class='list-content']/div[@class='li-itemmod']").nodes();

List<HousePrice> list = new ArrayList<>();

for(Selectable selectable : selectableList){

String name = selectable.xpath("//div[@class='li-info']/h3/a/text()").toString();

String price = selectable.xpath("//div[@class='li-side']/p[1]/strong/text()").toString();

HousePrice housePrice = new HousePrice();

housePrice.setName(name.trim());

housePrice.setPriceStr(price.trim());

list.add(housePrice);

}

page.putField("housePriceList",list);

urlList.add(page.getUrl().toString());

count++;

}

}

@Override

public Site getSite() {

return site;

}

public static void main(String[] args) {

Spider.create(new AnjukeProcessor())

.addUrl("https://qd.anjuke.com/community/") //从https://qd.anjuke.com/community/开始爬取

.addPipeline(new HousePricePipeline()) //使用自定义的Pipeline

.thread(5)

.run();

System.out.println("----------抓取了"+count+"条记录");

}

}

public class HousePricePipeline implements Pipeline {

@Override

public void process(ResultItems resultItems, Task task) {

System.out.println("----------get page: " + resultItems.getRequest().getUrl());

List<HousePrice> list = resultItems.get("housePriceList");

System.out.println("----------list size:" + list.size());

}

}

注意事项

在0.7.3版本中,爬取只支持TLS1.2的https站点的时候会报错:

javax.net.ssl.SSLException: Received fatal alert: protocol_version

解决办法:https://github.com/code4craft/webmagic/issues/701

相关文档

WebMagic简介和使用的更多相关文章

- java 之webmagic 网络爬虫

webmagic简介: WebMagic是一个简单灵活的Java爬虫框架.你可以快速开发出一个高效.易维护的爬虫. http://webmagic.io/ 准备工作: Maven依赖(我这里用的Mav ...

- webmagic源码浅析

webmagic简介 webmagic可以说是中国传播度最广的Java爬虫框架,https://github.com/code4craft/webmagic,阅读相关源码,获益良多.阅读作者博客[代码 ...

- 爬虫框架--webmagic

官方有详细的使用文档:http://webmagic.io/docs/zh/ 简介:这只是个java爬虫框架,具体使用需要个人去定制,没有图片验证,不能获取js渲染的网页,但简单易用,可以通过xpat ...

- 基于webmagic的爬虫小应用--爬取知乎用户信息

听到“爬虫”,是不是第一时间想到Python/php ? 多少想玩爬虫的Java学习者就因为语言不通而止步.Java是真的不能做爬虫吗? 当然不是. 只不过python的3行代码能解决的问题,而Jav ...

- Java爬虫框架WebMagic——入门(爬取列表类网站文章)

初学爬虫,WebMagic作为一个Java开发的爬虫框架很容易上手,下面就通过一个简单的小例子来看一下. WebMagic框架简介 WebMagic框架包含四个组件,PageProcessor.Sch ...

- 简单搭建webMagic爬虫步骤

1.简介 WebMagic是一个简单灵活的Java爬虫框架.基于WebMagic,你可以快速开发出一个高效.易维护的爬虫. 官网:http://webmagic.io/ 中文官网:http://web ...

- Java爬虫框架WebMagic入门——爬取列表类网站文章

初学爬虫,WebMagic作为一个Java开发的爬虫框架很容易上手,下面就通过一个简单的小例子来看一下. WebMagic框架简介 WebMagic框架包含四个组件,PageProcessor.Sch ...

- 学校实训作业:Java爬虫(WebMagic框架)的简单操作

项目名称:java爬虫 项目技术选型:Java.Maven.Mysql.WebMagic.Jsp.Servlet 项目实施方式:以认知java爬虫框架WebMagic开发为主,用所学java知识完成指 ...

- ASP.NET Core 1.1 简介

ASP.NET Core 1.1 于2016年11月16日发布.这个版本包括许多伟大的新功能以及许多错误修复和一般的增强.这个版本包含了多个新的中间件组件.针对Windows的WebListener服 ...

随机推荐

- storm深入研究

著作权归作者所有.商业转载请联系作者获得授权,非商业转载请注明出处.作者:He Ransom链接:http://www.zhihu.com/question/23441639/answer/28075 ...

- Page与Loaded

When navigate to page, loaded event will be triggered. Back to page, loaded event will be triggered ...

- 对于jsp中编码的理解

1.会话都是从客户端也就是浏览器开始发起的,首先用户将地址输入到地址栏中, 当用户输入enter或者点击转到的按钮时,浏览器会根据当前页面的charset对地址栏中的地址进行encode一次,当服务器 ...

- 制作SD卡启动自己编译的uboot.bin

README for FriendlyARM Tiny4412 -----------------------------------------------------1. Build uboot ...

- C#导出Excel按照指定格式设置单元格属性值

最近项目中一直在写XML.Table.Excel之间的转化.之前一直都是不考虑格式的导出,今天给出一个格式,让按照格式导出,还真把我这新手为难了一翻,网上给出的资料基本一样.为了一个单元格文字变色纠结 ...

- Linux 内核中 likely 与 unlikely 的宏定义解析

在 2.6 内核中,随处能够见到 likely() 和 unlikely() 的身影,那么为什么要用它们?它们之间有什么差别? 首先要明白: if(likely(value)) 等价于 if(valu ...

- POJ 1160 Post Office(区间DP)

Description There is a straight highway with villages alongside the highway. The highway is represen ...

- 【RF库Collections测试】Insert Into List

Name:Insert Into ListSource:Collections <test library>Arguments:[ list_ | index | value ]Inser ...

- XMPP HTTP

1.TCP连接 要想明白Socket连接,先要明白TCP连接.手机能够使用联网功能是因为手机底层实现了TCP/IP协议,可以使手机终端通过无线网络建立TCP连接.TCP协议可以对上层网络提供接口,使上 ...

- BNU4207:台风

东方非想天则(TH12.3)是一款优秀的格斗游戏,其以华丽的弹幕,连贯的技能衔接及优美的音乐吸引了众多玩家(宅男更多-_-),而且各平台上也为其提供了联机的机会. 好了,言归正传,天气系统是本游戏的一 ...